AutonomousStructuralVisualInspectionUsingRegionBase DeepLearningforDetectingMultipleDamageTypes-阅读笔记

Posted wyy_persist

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了AutonomousStructuralVisualInspectionUsingRegionBase DeepLearningforDetectingMultipleDamageTypes-阅读笔记相关的知识,希望对你有一定的参考价值。

Autonomous Structural Visual Inspection Using Region-Based Deep Learning for Detecting Multiple Damage Types

论文阅读笔记

//2022.3.4上午11:50开始阅读

论文创新点

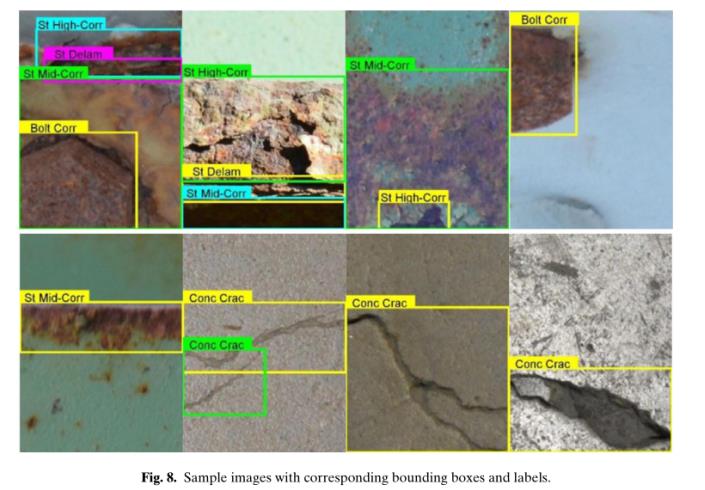

文章提出了一种改进的FasterRCNN架构,并在自主创建的图片数据集(包含:混凝土裂缝、两级腐蚀(中、高)、螺栓腐蚀和钢分层5种类型缺陷)上进行训练、测试和验证。同时还实现了较快的检测速度。

论文内容

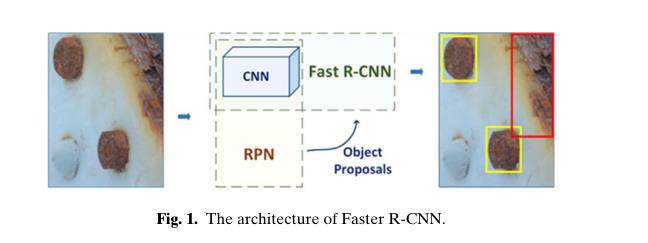

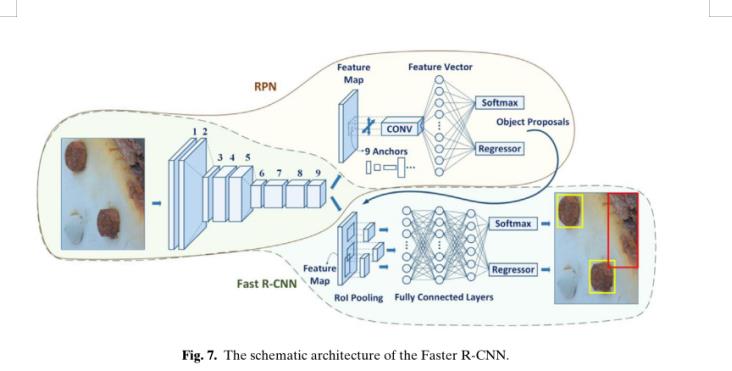

- 首先介绍了RPN生成对象区域建议、所使用的CNN架构、改进后的FastRCNN网络架构、已经改进后的Faster RCNN网络架构;(基本的网络架构介绍和改进后的网络架构介绍)

- 然后作者介绍了生成数据库和实验的实现细节;(数据集和训练实现)

- 接着作者讨论了训练和验证过程以及测试的结果,并将其与Cha等人(2017)基于CNN的方法进行了比较;(方法对比)

- 作者又提出了一个框架,其可以使Faster R-CNN兼容准实时损伤检测任;(改进后的架构用来扩展)

- 最后,作者综合讨论了实验结果;

内容提要

方法介绍

Faster RCNN网络架构:

作者首先介绍了CNN中CONV层(卷积层)、最大池化层(Max Pooling层)、全连接层(FC层)以及最后的分类层(softmax层);

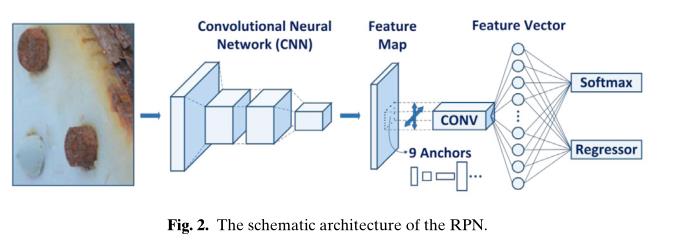

接着作者介绍了区域建议网络-RPN网络结构;

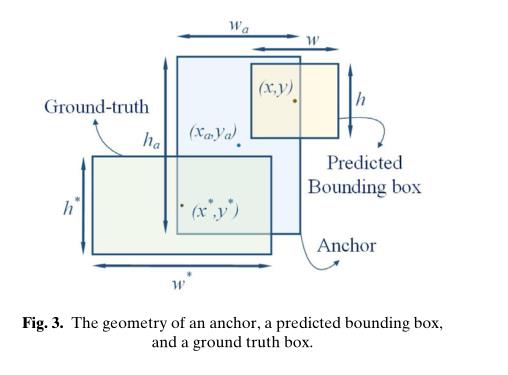

作者又介绍了RPN网络中锚的定义和概念、锚点被标记为正负的参考IoU定义和标准、锚框和ground-truth之间重合的更新过程(标准为IoU)、Fast RCNN框架和ZF-net CNN框架。

作者又介绍了修改ZF-net网络作为RPN区域建议生成网络主网络的过程:

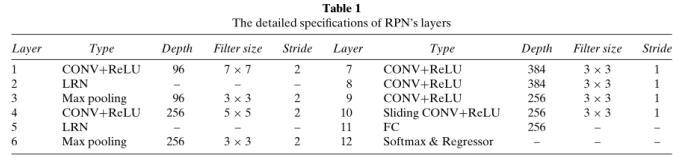

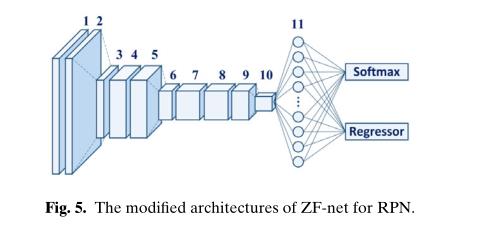

为了开发一种基于Faster R-CNN的方法来检测多种类型的结构损伤,文章针对RPN和Fast R-CNN对原有的ZF-net架构进行了修改。为了开发RPN,对原来的ZF-net进行了修改。ZF-net最后的max-pooling和FC层被滑动CONV代替,接着是深度为256的FC层(特征向量),其softmax层被softmax和回归层代替,如图5所示。基于zf网络的RPN的细节如表1所示。

基于ZF-net的RPN网络结构详细介绍表:

基于ZF-net的RPN网络结构:

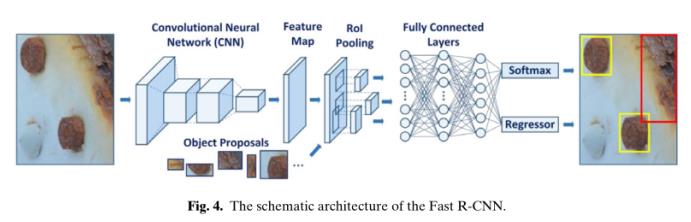

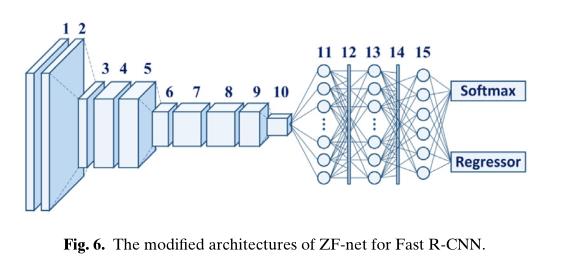

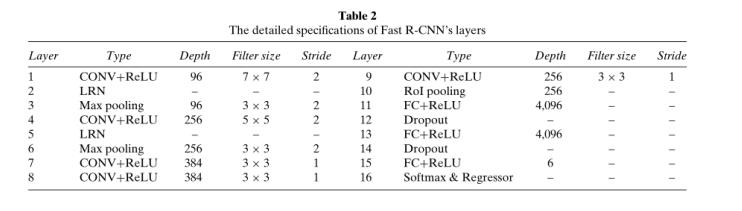

作者使用ZF-net作为Fast RCNN的主网络的过程如下:

为了对Fast R-CNN进行修改,将ZF-net的最后一个max-pooling层替换为RoI pooling层。为了防止训练过程中的过拟合,在ZF-net的第一和第二层FC层之间以及第二和第三层FC层之间增加了阈值为0.5的dropout层。最后一个FC层的深度被修改为6,用于5种损伤类型和背景,以确保与问题的兼容性。softmax层被替换为softmax和回归层,如图6所示。基于zf网络的RPN的细节如表2所示。

展示RPN和Fast RCNN网络结构共享CNN:

然后作者又详细介绍了四步训练对RPN和Fast RCNN进行参数微调的过程;

数据集和实验细节

作者将使用单反相机拍摄的图像裁剪到500 × 375像素,并一共得到了2366张图像。

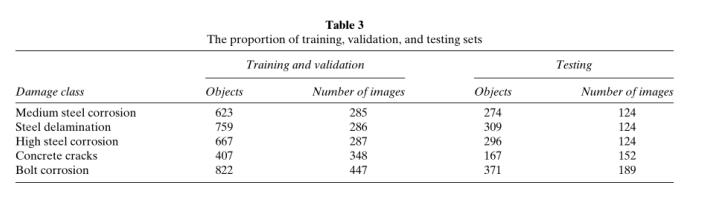

下表展示了数据集的划分等详细信息:

本文实验的硬件配置:所有的实验都是使用开源的Faster R-CNN库(Ren等人,2016),MATLAB 2016a, CUDA 8.0和CUDNN 5.1在一台装有Core i7-6700k @ 4ghz CPU, 32gb DDR4内存,8gb内存华硕Turbo GeForce GTX 1080图形处理单元(GPU)的计算机上进行的。

文中作者研究了9中不同比例的27种锚组合和6种不同锚尺寸的两种尺寸组合。同时作者还增加了softmax分类概率为正类的阈值,从原始文献中的0.6增加到了0.9,这将帮助提高精确度。作者并没有使用缩放。

实验情况

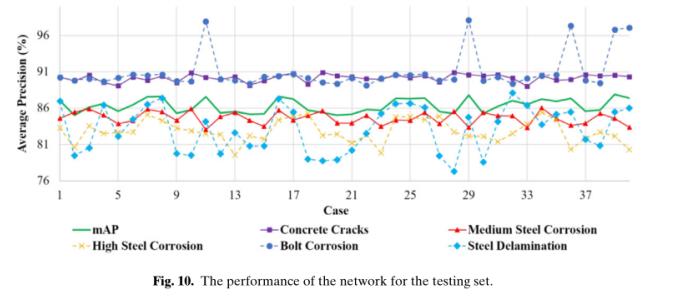

训练、验证和测试集结果

测试集表现:

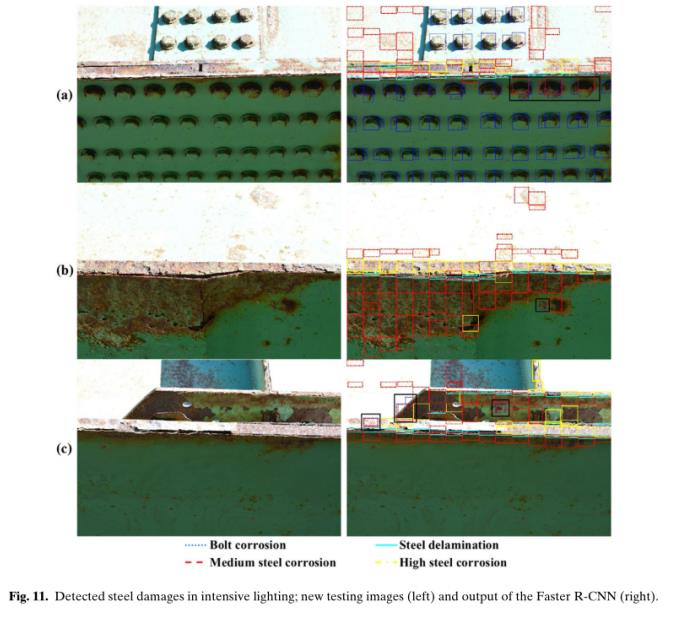

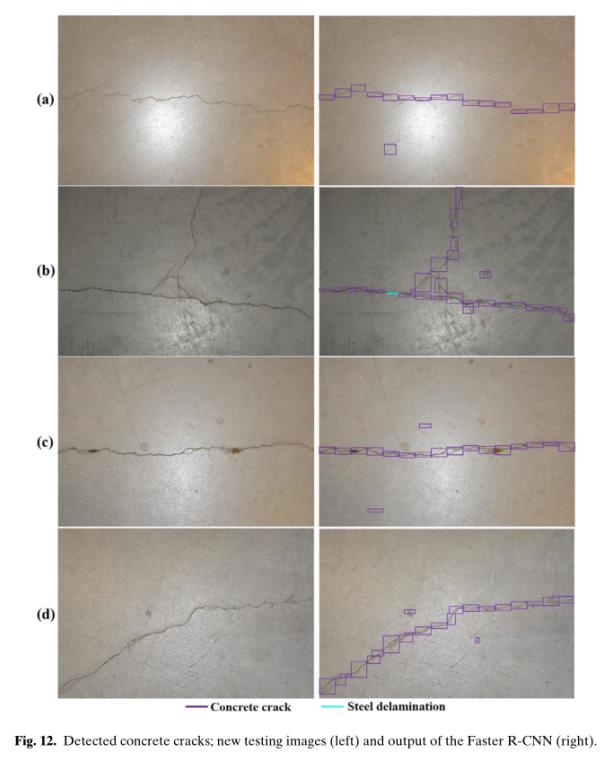

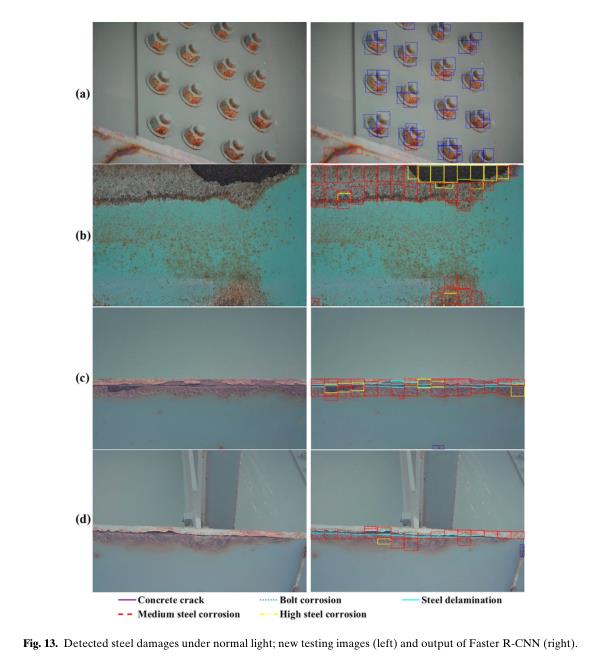

接着作者又测试了11张新图片。得到了如下结果。

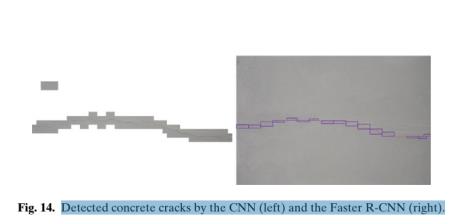

此外,作者又进行了对比实验,将文中改进后的网络架构和传统的CNN架构在测试数据集上进行对比,并得到了如下结果:

- 改进后的Faster RCNN网路架构具有更好的柔性包围框,提供了更好的定位结果;

- Faster RCNN的检测速度更快;

- 传统的基于滑动窗口的CNN由于输入测试图片尺寸的不确定,而导致滑动窗口的尺寸也不能固定;

下图为上述实验对比的结果展示

改进Faster RCNN网络结构在VIDEO视频帧处理中的实验

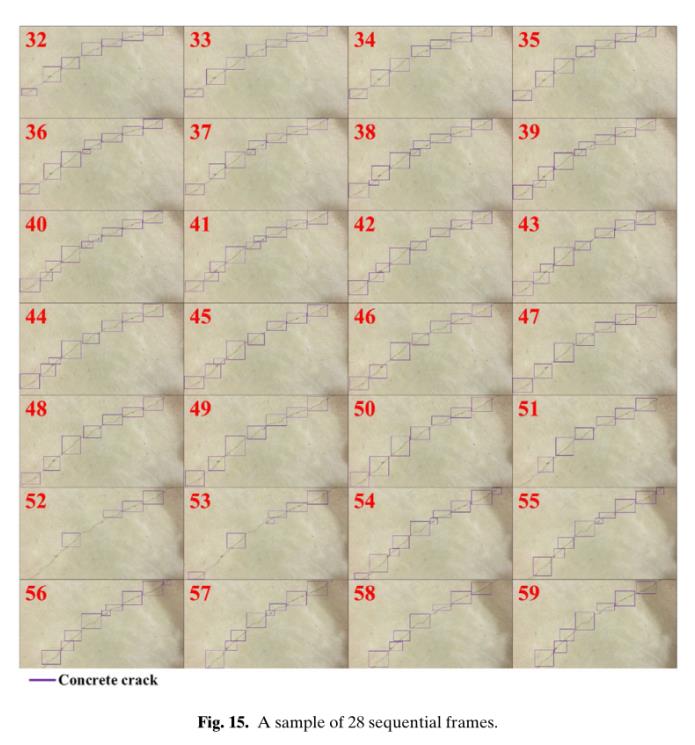

作者使用的视频帧率为30.00,尺寸为1920 × 1080。

下图为作者使用Faster R-CNN在视频帧上进行的测试结果展示。

总结

Faster R-CNN基于优化的网络结构具有更好的计算效率,它提供了更灵活的包围盒大小,以适应输入图像的不同大小和尺度。此外,利用Faster R-CNN开发了一种基于视频的损伤检测框架,可以提供基于视觉的准实时、自主的结构损伤检测。

未来方向

未来,将提供更多的损伤与相机距离范围更广的样本,并将其添加到数据库中,以提高所提方法的准确性和鲁棒性,并进行广泛的对比研究,Faster R-CNN将与无人机一起使用,以自动视觉检查取代以人为本的检查。

//截止到2022.3.4 下午14:09止

以上是关于AutonomousStructuralVisualInspectionUsingRegionBase DeepLearningforDetectingMultipleDamageTypes-阅读笔记的主要内容,如果未能解决你的问题,请参考以下文章