吴恩达机器学习丨思维导图丨坚持打卡23天——构建知识脉络,回顾总结复盘

Posted AXYZdong

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了吴恩达机器学习丨思维导图丨坚持打卡23天——构建知识脉络,回顾总结复盘相关的知识,希望对你有一定的参考价值。

Author:AXYZdong 自动化专业 工科男

有一点思考,有一点想法,有一点理性!

定个小小目标,努力成为习惯!在最美的年华遇见更好的自己!

CSDN@AXYZdong,CSDN首发,AXYZdong原创

唯一博客更新的地址为: 👉 AXYZdong的博客 👈

B站主页为:AXYZdong的个人主页

文章目录

- 0. 前言

- 1. 思维导图使用说明

- 2. 思维导图主要内容

- 3. 思维导图正文

- 0. 引言(Introduction)

- 1. 单变量线性回归(Linear Regression with One Variable)

- 2. 多变量线性回归(Linear Regression with Multiple Variables)

- 3. 逻辑回归(Logistic Regression)

- 4. 正则化(Regularization)

- 5. 神经网络:表述(Neural Networks:Representation)

- 6. 神经网络:学习(Neural Networks:Learning)

- 7. 应用机器学习的建议(Advice for Applying Machine Learning)

- 8. 机器学习系统的设计(Machine Learning System Design)

- 9. 支持向量机(Support Vector Machines)

- 10. 聚类(Clustering)

- 11. 降维(Dimensionality)

- 12. 异常检测(Anomaly Detection)

- 13. 推荐系统(Recommender Systems)

- 14. 大规模机器学习(Large Scale Machine Learning)

- 15. 应用实例:图片文字识别(Application Example: Photo OCR)

- 16. 总结(Conclusion)

- 4. 关于标题中“坚持打卡23天”

- 5. 参考文献

0. 前言

机器学习是目前信息技术中最激动人心的方向之一。本文以吴恩达老师的机器学习课程为主线,使用 Process On 在线绘图构建机器学习的思维导图。

1. 思维导图使用说明

配合吴恩达老师的机器学习视频使用,构建知识脉络,回顾总结复盘。

全部思维导图在线浏览:吴恩达机器学习丨思维导图丨ProcessOn

需要浏览全图的同学关注 AXYZdong 公众号,回复 机器学习 获取密码哦!

2. 思维导图主要内容

引言(Introduction)

监督学习部分:

- 单变量线性回归(Linear Regression with One Variable)

- 多变量线性回归(Linear Regression with Multiple Variables)

- 逻辑回归(Logistic Regression)

- 正则化(Regularization)

- 神经网络:表述(Neural Networks:Representation)

- 神经网络:学习(Neural Networks:Learning)

- 支持向量机(Support Vector Machines)

无监督学习部分:

- 聚类(Clustering)

- 降维(Dimensionality)

- 异常检测(Anomaly Detection)

特殊应用:

- 推荐系统(Recommender Systems)

- 大规模机器学习(Large Scale Machine Learning)

关于建立机器学习系统的建议:

- 应用机器学习的建议(Advice for Applying Machine Learning)

- 机器学习系统的设计(Machine Learning System Design)

- 应用实例:图片文字识别(Application Example: Photo OCR)

3. 思维导图正文

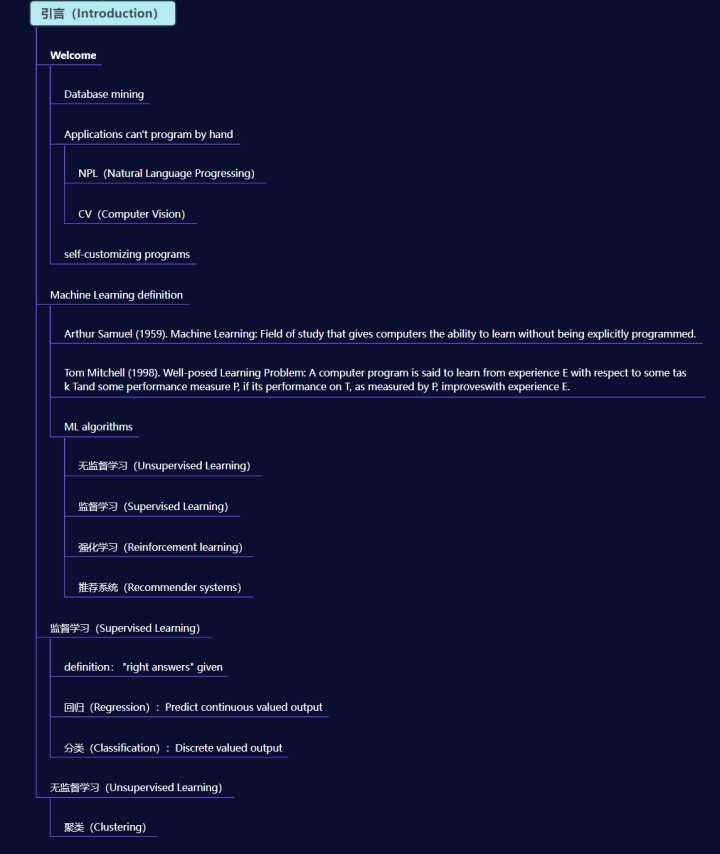

0. 引言(Introduction)

引言部分主要介绍了机器学习的定义、机器学习的相关算法、监督学习和无监督学习。

关于机器学习没有一个统一的定义,下面两条是视频中提到两位学者对机器学习的理解。

- Arthur Samuel (1959). Machine Learning: Field of study that gives computers the ability to learn without being explicitly programmed.

- Tom Mitchell (1998). Well-posed Learning Problem: A computer program is said to learn from experience E with respect to some task Tand some performance measure P, if its performance on T, as measured by P, improveswith experience E.

▲ Part0 Introduction

1. 单变量线性回归(Linear Regression with One Variable)

这部分主要内容包括单变量线性回归的模型表示、代价函数、梯度下降法和使用梯度下降法求解代价函数的最小值。

▲ Part1 Linear Regression with One Variable

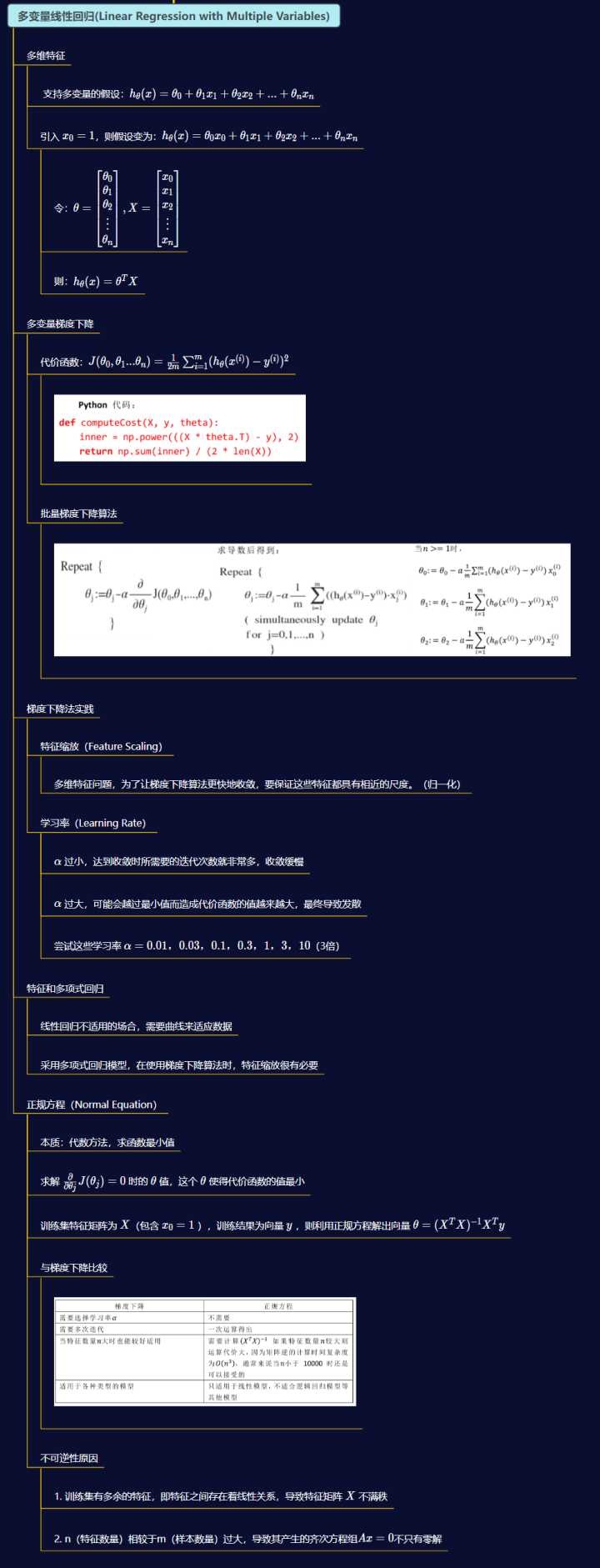

2. 多变量线性回归(Linear Regression with Multiple Variables)

多变量线性回归相当于是单变量的扩展,主要还是按照模型假设、构造代价函数和研究代价函数的最小值这样的思路展开。

与单变量线性回归不同的是,多变量线性回归还可能涉及到特征缩放的问题,主要原因是存在着不同尺度的特征变量,为了使得梯度下降能够快速地收敛,需要将这些特征变量统一尺度(类似于归一化的思想)

相比于单变量线性回归,多变量线性回归在求解代价函数的特征方程时,除了可以使用梯度下降法,还可以使用正则方程。根据特征变量的多少,灵活地选择这两种方法。

▲ Part2 Linear Regression with Multiple Variables

3. 逻辑回归(Logistic Regression)

这里的“回归”不同于线性回归,是一种习惯的叫法。它实质是分类,要预测的变量是离散的值。

▲ Part3 Logistic Regression

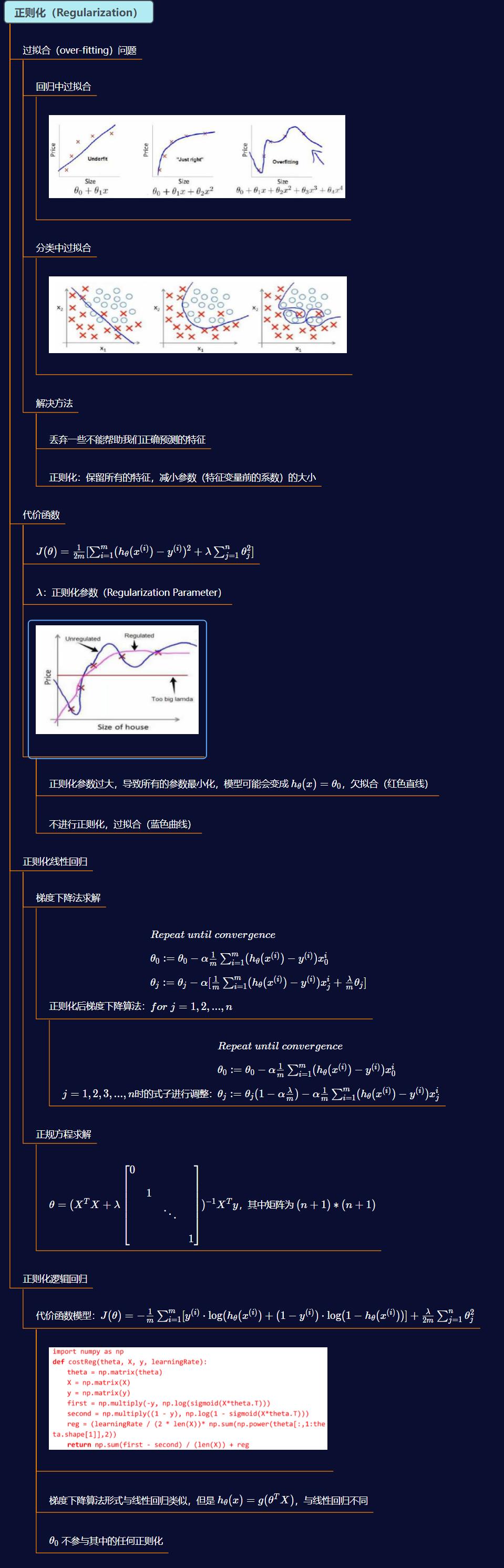

4. 正则化(Regularization)

正则化(Regularization)的提出,主要是解决过拟合(over-fitting)的问题。包括线性回归的正则化和逻辑回归的正则化,其本质是通过加入正则化项来保留所有的特征,同时减小参数(特征变量前的系数)的大小。

一个假设在训练数据上能够获得比其他假设更好的拟合, 但是在训练数据外的数据集上却不能很好地拟合数据,此时认为这个假设出现了过拟合的现象。出现这种现象的主要原因是训练数据中存在噪音或者训练数据太少。

▲ Part4 Regularization

5. 神经网络:表述(Neural Networks:Representation)

神经网络(Neural Networks)的简要表述,涉及非线性假设、神经网络的模型表示、神经网络的直观理解以及多元分类等内容。

当特征太多时,普通的逻辑回归模型,不能有效地处理这么多的特征,这时候我们需要神经网络。

▲ Part5 Neural Networks:Representation

6. 神经网络:学习(Neural Networks:Learning)

神经网络(Neural Networks)的代价函数,梯度下降寻求代价函数的最小值,利用反向传播算法(Backpropagation Algorithm)算出梯度下降的方向。

采用梯度的数值检验(Numerical Gradient Checking) 方法,防止代价看上去在不断减小,但最终的结果可能并不是最优解的问题。

如果让初始参数都为0,那么第二层的激活单元将具有相同的值。因此需要初始化参数,采用随机初始化的方法,Python代码如下:

Theta1 = rand(10,11) * (2*eps) - eps

▲ Part6 Neural Networks:Learning Learning

7. 应用机器学习的建议(Advice for Applying Machine Learning)

-

运用训练好了的模型来预测未知数据的时候发现有较大的误差,下一步应该做什么?运用诊断法判断哪些方法对我们的算法是有效的。

-

利用训练集和测试集评估假设函数是否过拟合,训练集代价函数最小化得到的参数代入测试集代价函数。

-

交叉验证集来帮助选择模型。诊断偏差和方差,算法表现不理想, 要么是偏差比较大,要么是方差比较大。换句话说,出现的情况要么是欠拟合,要么是过拟合问题。

-

学习曲线将训练集误差和交叉验证集误差作为训练集实例数量(m)的函数绘制的图表。

▲ Part7 Advice for Applying Machine Learning

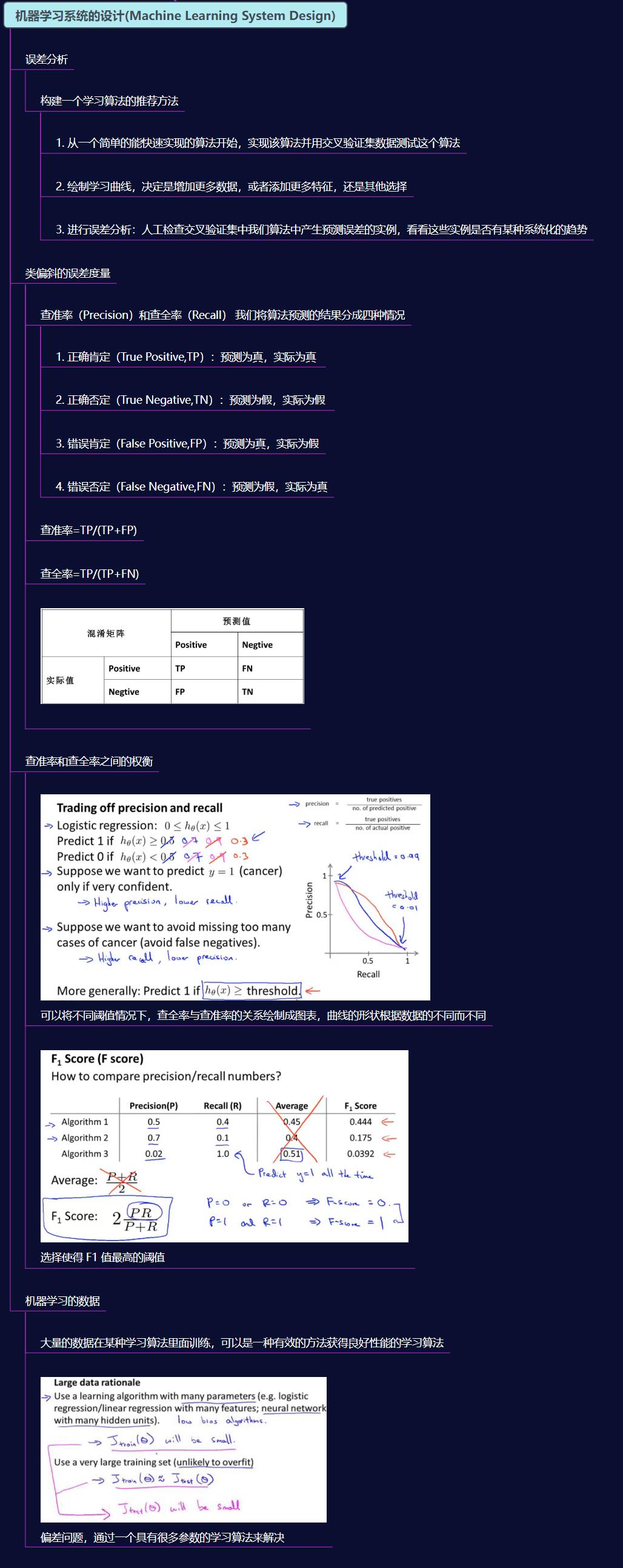

8. 机器学习系统的设计(Machine Learning System Design)

这部分主要内容是误差分析、类偏斜的误差度量 、查准率和查全率之间的权衡和机器学习的数据 。

▲ Part8 Machine Learning System Design

9. 支持向量机(Support Vector Machines)

支持向量机(Support Vector Machines)实质上是优化逻辑回归中的目标函数,将含有的log项用cost函数代替。

支持向量机用一个最大间距来分离样本,具有鲁棒性,有时被称为大间距分类器。

将核函数(Kernel) 引入支持向量机SVM中,从而代替了对应的高维向量内积。

▲ Part9 Support Vector Machines

10. 聚类(Clustering)

聚类(Clustering)无监督学习的一种。

重点算法:K-均值算法。K-Means 是最普及的聚类算法,算法接受一个未标记的数据集,然后将数据聚类成不同的组。

▲ Part10 Clustering

11. 降维(Dimensionality)

降维(Dimensionality)主要用于数据压缩和数据可视化,也是无监督学习的一种。

重要算法:主成分分析 PAC(Principal Component Analysis)算法。

▲ Part11 Dimensionality

12. 异常检测(Anomaly Detection)

这部分主要包括高斯分布(Gaussian Distribution),使用高斯算法进行异常检测,特征转换将原始数据转换成高斯分布。

重要算法:高斯(Gaussian )算法。

▲ Part12 Anomaly Detection

13. 推荐系统(Recommender Systems)

这部分内容包括:基于内容的推荐系统、协同过滤 (Collaborative Filtering)、矢量化:低秩矩阵分解 、实施细节:均值归一化 。

重要算法:协同过滤 (Collaborative Filtering)算法。

▲ Part13 Recommender Systems

14. 大规模机器学习(Large Scale Machine Learning)

主要内容:随机梯度下降法(Stochastic Gradient Descent)、小批量梯度下降(Mini-Batch Gradient Descent) 、随机梯度下降算法的收敛 、在线学习(Online Learning)和 映射简化和数据并行(Map Reduce and Data Parallelism)。

▲ Part14 Large Scale Machine Learning

15. 应用实例:图片文字识别(Application Example: Photo OCR)

关注图片文字识别的步骤 和 滑动窗口(Sliding Windows)的使用。

▲ Part15 Application Example: Photo OCR

16. 总结(Conclusion)

▲ Part16 Conclusion

4. 关于标题中“坚持打卡23天”

Blink 坚持打卡23天

▲ Blink 打卡23天

5. 参考文献

[1]:[中英字幕]吴恩达机器学习系列课程

[2]:fengdu78, Coursera-ML-AndrewNg-Notes, (2018), GitHub repository, https://github.com/fengdu78/Coursera-ML-AndrewNg-Notes

本次的分享就到这里

如果我的博客对你有帮助、如果你喜欢我的博客内容,请 “点赞” “收藏” “关注” 一键三连哦!

更多精彩内容请前往 AXYZdong的博客

如果以上内容有任何错误或者不准确的地方,欢迎在下面 👇 留个言。或者你有更好的想法,欢迎一起交流学习~~~

以上是关于吴恩达机器学习丨思维导图丨坚持打卡23天——构建知识脉络,回顾总结复盘的主要内容,如果未能解决你的问题,请参考以下文章