如何使用nodejs做爬虫程序

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了如何使用nodejs做爬虫程序相关的知识,希望对你有一定的参考价值。

目标

抓取网站上的妹子照片。

第三方模块

superagent : 第三方Nodejs 模块,用于处理服务器和客户端的Http请求。

cheerio : 为服务器端定制的Jquery实现。

思路

通过superagent 获取目标网站的dom

通过cheerio对dom进行解析,获得通用布局。

如果只是爬取一个页面,则可以直接将目标页面的目标元素获取

如果是分页或者多个页面,可以通过循环获得目标链接,进行多次抓取。

实现

这里我们实现一个抓取网站妹子的照片。

目标网址:http://jandan.net/ooxx/ (对于该网站,并没有恶意攻击的意思.)

代码如下:

var fs = require('fs');//为了将抓取的图片存到本地,使用fs

var superagent = require('superagent');//引入superagent

var cheerio = require('cheerio');//引入jquery实现

var filePath = '/node/学习/sis/img/';//定义抓取妹子文件存放路径

var count = 0;//记录抓取数量

var test = [];

//抓取一个页面的实现。

var getOnePage = function(url)

//因为煎蛋对请求做了限制,所以将cookie加上了。如果你要访问该网站的话,可以通过浏览器查找cookie 并进行替换

superagent.get(url)

.set(

'user-agent':'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (Khtml, like Gecko) Chrome/47.0.2526.111 Safari/537.36'

)

.set('cookie','500322148=53; Hm_lvt_fd93b7fb546adcfbcf80c4fc2b54da2c=1454117846; Hm_lpvt_fd93b7fb546adcfbcf80c4fc2b54da2c=1454119909')

.set(

'accept' : 'text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,*/*;q=0.8',

'connection' : 'keep-alive',

'host' : 'jandan.net'

)

.end(function(err,sres)//这里是对获取的dom进行处理

if(err)throw err;

var $ = cheerio.load(sres.text);

var nextUrl = $('.previous-comment-page').attr('href');//获得下一页的链接,为了开始下一次请求

$('img').each(function(index,ele)//循环该页面的所有图片并得到对应的链接,放进数组。

var u = '';

if($(ele).attr('org_src'))

u = $(ele).attr('org_src');

else

u = $(ele).attr('src');

test.push(u);

//通过superagent 获取图片数据,并保存到本地。

superagent.get(u).end(function(err,sres)

if(err)throw err;

//根据访问路径获得文件名称

var ttt = u.split('/');

var name = ttt[ttt.length-1];

var path = filePath+name

fs.writeFile(path,sres.body,function()

count++;

console.log(u);

console.log('已成功抓取..'+count+'张');

);

);

);

if(null != nextUrl && '' != nextUrl) //何时开始下一次请求

getOnePage(nextUrl);

);

;

getOnePage('http://jandan.net/ooxx/');//触发第一次请求开始

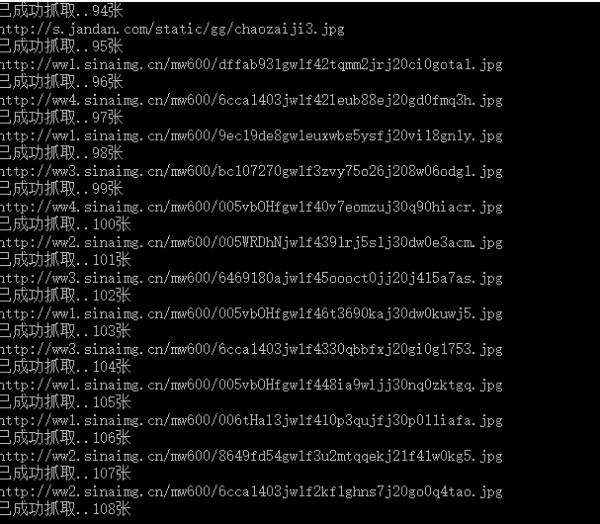

5. 结果

nodejs爬虫selenium

6、元素操作

查找元素 使用操作如何找到页面元素Webdriver的findElement方法可以用来找到页面的某个元素,最常用的方法是用id和name查找。下面介绍几种比较常用的方法。 By ID假设页面写成这样: <input type=”text” name=”userName” id=”user” /> 那么可以这样找到页面的元素: 通过id查找: WebElement element = driver.findElement(By.id(“user”)); By Name或通过name查找: WebElement element = driver.findElement(By.name(“userName”)); By XPATH或通过xpath查找: WebElement element =driver.findElement(By.xpath(“//input[@id=‘user‘]“)); By Class Name假设页面写成这样: <div class=”top”><span>Head</span></div><divclass=”top”><span>HeadName</span></div> 可以通过这样查找页面元素: List<WebElement>top= driver.findElements(By.className(“top”)); By Link Text假设页面元素写成这样: <a href=”http://www.baidu.com”>baidu</a>> 那么可以通过这样查找: WebElement baidu=driver.findElement(By.linkText(“baidu”));

输入框传值 输入框(text field or textarea) 找到输入框元素: WebElement element = driver.findElement(By.id(“passwd-id”)); 在输入框中输入内容: element.sendKeys(“test”); 将输入框清空: element.clear(); 获取输入框的文本内容: element.getText();

下拉菜单 下拉选择框(Select)找到下拉选择框的元素: Select select = new Select(driver.findElement(By.id(“select”))); 选择对应的选择项:select.selectByVisibleText(“testName”); 或 select.selectByValue(“name”); 不选择对应的选择项: select.deselectAll(); select.deselectByValue(“name”); select.deselectByVisibleText(“姓名”); 或者获取选择项的值: select.getAllSelectedOptions(); select.getFirstSelectedOption();

单选框 单选项(Radio Button)找到单选框元素: WebElement sex=driver.findElement(By.id(“sex”)); 选择某个单选项: sex.click(); 清空某个单选项: sex.clear(); 判断某个单选项是否已经被选择: sex.isSelected();

复选框 多选项(checkbox)多选项的操作和单选的差不多: WebElement area =driver.findElement(By.id(“area .”)); area .click(); area .clear(); area .isSelected(); area .isEnabled();

弹出框 弹出对话框(Popup dialogs)Alert alert = driver.switchTo().alert(); alert.accept(); alert.dismiss(); alert.getText();

表单提交 表单(Form)Form中的元素的操作和其它的元素操作一样,对元素操作完成后对表单的提交可以: WebElement sub= driver.findElement(By.id(“sub”)); sub.click(); 或 sub.submit();//只适合于表单的提交

多窗口切换 Windows 或 Frames之间的切换 首先切换到默认的frame driver.switchTo().defaultContent(); 切换到某个frame: driver.switchTo().frame(“leftFrame”); 从一个frame切换到另一个frame: driver.switchTo().frame(“mainFrame”); 切换到某个window: driver.switchTo().window(“windowName”);

以上是关于如何使用nodejs做爬虫程序的主要内容,如果未能解决你的问题,请参考以下文章