实时立体匹配网络StereoNet

Posted AI 菌

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了实时立体匹配网络StereoNet相关的知识,希望对你有一定的参考价值。

概要

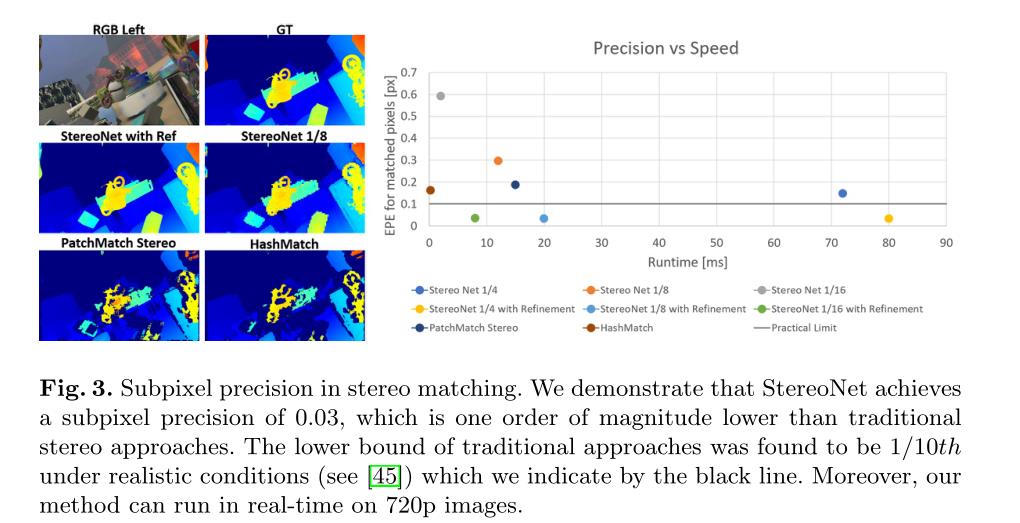

本文介绍了首个用于实时立体匹配的端到端深度架构StereoNet,该架构可在NVidia Titan X上以60fps运行,生成高质量、边缘保持、无量化的视差图。本文的一个关键观点是,该网络的亚像素匹配精度比传统的立体匹配方法高出一个量级。这允许我们通过使用非常低的分辨率成本来实现实时性能,编码所需的所有信息,以实现高视差精度。

项目开源连接:https://github.com/meteorshowers/X-StereoLab

一、引入

立体匹配是一个经典的计算机视觉问题,它涉及到从两幅轻微位移的图像中估计深度。随着人们对虚拟现实和增强现实的兴趣日益浓厚,深度估计技术最近被推向了研究的中心。它是很多任务的核心,从3D重建到定位和跟踪。它的应用涵盖了不同的研究和产品领域,包括室内测绘和建筑、自动驾驶汽车以及人体和面部跟踪。

在提出了一种新颖的深度网络架构StereoNet,可以在NVidia Titan X上以60Hz的频率生成最先进的720p深度图。总而言之,本文的主要贡献如下:

- StereoNet 的亚像素匹配精度比“传统”立体方法高一个数量级。

- 该网络的亚像素精度高,可以在非常低的分辨率Cost Volume下实现传统立体匹配的深度精度。

- 本文展示了之前在深度体系结构中引入成本-量的工作是对任务的过度参数化,以及这如何显著地帮助减少系统的运行时和内存占用,而在精度方面的成本很小。

- 一个新的层次深度细化层,能够执行高质量的上采样,保持边缘。

- 最后,证明了所提出的系统在几个基准上达到了令人信服的结果,同时在高端GPU架构上是实时的。

二、StereoNet 网络架构

2.1 整体结构

我们的立体匹配方法结合了一种利用问题结构和经典方法来解决问题的设计。网络的整体框架如下:

2.2 粗略预测:Cost Volume Filtering

立体系统一般是解决一个对应问题。这个问题通常可以归结为,通过在两幅经过校正的图像沿着扫描线找到像素对像素的匹配来形成视差图。

对平滑和边缘保持解决方案的渴望导致了像 Cost Volume Filtering 这样的方法,它通过形成和处理一个三维体积,在每个像素上共同解决所有候选差异,显式地建模匹配问题。当直接使用颜色值进行匹配时,我们计算每个用于匹配的像素的特征表示。

特征网络。该流水线的第一步是找到一个有意义的图像补丁的表示,该图像补丁可以在后面的阶段中精确匹配。我们记得立体声受无纹理区域的困扰,传统的方法通过使用大窗口聚合成本来解决这个问题。

我们通过确保从一个大的感受域中提取特征,来复制网络中相同的行为。特别是,我们使用了一个特征网络,在两个输入图像之间共享权重。我们首先使用 5 × 5 卷积以 2 的步幅对输入图像进行下采样,在下采样过程中保持32个通道。

然后应用6个residual blocks,它们采用3 × 3卷积、批量归一化和 leaky ReLu(α = 0.2)。最后,使用3 × 3卷积的最后一层处理,该卷积不使用批量归一化或激活。输出为下采样图像中每个像素处的32维特征向量。这种低分辨率的表示方式之所以重要有两个原因:

- 它有一个很大的感受域,对于无纹理区域很有用。

- 保持特征向量紧凑。

代价体。此时,我们利用像素的特征向量与匹配候选像素的特征向量之间的差值,形成粗分辨率下的代价体。我们注意到,非对称表示一般表现良好,并连接两个矢量在我们的实验中取得了类似的结果。

在这个阶段,传统的立体方法将使用一种赢者通吃的方法 ,在两个特征矢量之间选择欧几里得度量最小的差距。相反,这里我们让网络通过运行多重卷积和非线性来学习正确的度量。

2.3 层次细化: 边缘感知上采样

依赖粗匹配的缺点是得到的近视输出缺乏精细的细节。为了保持我们紧凑的设计,我们通过学习一个边缘保护求精网络来处理这个问题。我们注意到,网络在这个阶段的工作是扩大或削弱的差异值,以融入高频细节使用颜色输入作为指导,所以一个紧凑的网络,学习像素到像素的映射,类似于网络在最近的计算摄影工作 ,是一个适当的方法。具体来说,我们的任务精化网络只找到残差(或增量差异) ,以增加或减去粗预测。

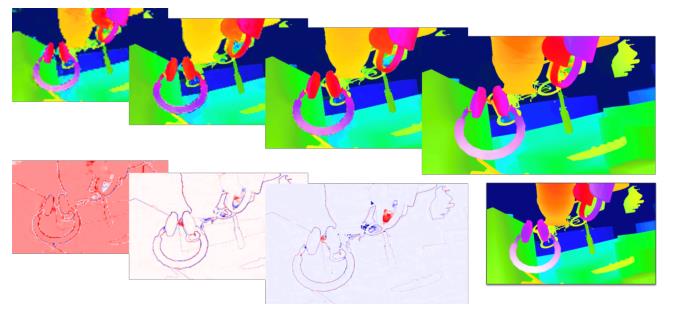

图2显示了层次结构的每个级别的精化层的输出,以及每个级别上为恢复高频细节而添加的残差。这个网络的行为让人想起联合双边上采样,而且我们确实相信这个网络是一个学习的边缘感知上采样功能,利用一个引导图像。

2.4 损失函数

我们使用基于真值标记的立体数据,在完全监督的情况下训练立体声网络。我们最小化层次损失函数:

三、实验

在这里,本文在几个数据集上评估我们的系统,并证明我们以最先进技术所需的计算成本的一小部分来获得高质量的结果。

四、结论

本文提出了立体网络,第一个实时的,高质量的端到端结构被动立体匹配。我们开始的洞察,低分辨率的成本容量包含大部分的信息,以生成高精度的视差图和恢复薄结构给予足够的训练数据。我们演示了1/30像素的亚像素精度,超过了文献中发表的极限。我们的改进方法分层复原高频细节使用颜色输入作为指导,绘制一个数据驱动的联合双边上采样算子的平行。

我们的方法的主要局限性是由于缺乏有监督的训练数据: 事实上,我们展示了当有足够的例子时,我们的方法达到了最先进的结果。为了减轻这种影响,我们未来的工作包括监督和自我监督学习的结合,以增加训练集。

以上是关于实时立体匹配网络StereoNet的主要内容,如果未能解决你的问题,请参考以下文章

立体匹配算法(局部立体匹配 全局立体匹配 深度学习立体匹配 )