每天一道大厂SQL题Day19华泰证券真题实战

Posted Maynor996

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了每天一道大厂SQL题Day19华泰证券真题实战相关的知识,希望对你有一定的参考价值。

每天一道大厂SQL题【Day19】华泰证券真题实战(一)

大家好,我是Maynor。相信大家和我一样,都有一个大厂梦,作为一名资深大数据选手,深知SQL重要性,接下来我准备用100天时间,基于大数据岗面试中的经典SQL题,以每日1题的形式,带你过一遍热门SQL题并给出恰如其分的解答。

一路走来,随着问题加深,发现不会的也愈来愈多。但底气着实足了不少,相信不少朋友和我一样,日积月累才是最有效的学习方式!

每日语录

头等舱可以优先登机,银行VIP可以不用排队,演唱会最贵的票位置最好,世界从不平等,你有多努力,就有多特殊!

第19题:

需求列表

需求1:用一条SOL语句查询出每门课都大于80分的学生姓名

| name | kecheng | fenshu |

|---|---|---|

| 张三 | 语文 | 81 |

| 张三 | 数学 | 75 |

| 李四 | 语文 | 76 |

| 李四 | 数学 | 90 |

| 王五 | 语文 | 81 |

| 王五 | 数学 | 100 |

| 王五 | 英语 | 90 |

思路分析

思路一:

如果你想查询出每门课都大于80分的学生姓名,你可以使用聚合函数和HAVING子句。首先,你可以按照学生姓名对数据进行分组,然后使用MIN函数来计算每个学生的最低分数。接着,你可以使用HAVING子句来筛选出最低分数大于80的学生。

思路二:

如果你想使用窗口函数来查询出每门课都大于80分的学生姓名,你可以使用MIN函数作为窗口函数。首先,你可以使用PARTITION BY子句来按照学生姓名对数据进行分组,然后使用MIN函数来计算每个学生的最低分数。接着,你可以使用子查询来筛选出最低分数大于80的学生。

答案获取

建议你先动脑思考,动手写一写再对照看下答案,如果实在不懂可以点击下方卡片,回复:大厂sql 即可。

参考答案适用HQL,SparkSQL,FlinkSQL,即大数据组件,其他SQL需自行修改。

加技术群讨论

点击下方卡片关注 联系我进群

或者直接私信我进群

文末SQL小技巧

提高SQL功底的思路。

1、造数据。因为有数据支撑,会方便我们根据数据结果去不断调整SQL的写法。

造数据语法既可以create table再insert into,也可以用下面的create temporary view xx as values语句,更简单。

其中create temporary view xx as values语句,SparkSQL语法支持,hive不支持。

2、先将结果表画出来,包括结果字段名有哪些,数据量也画几条。这是分析他要什么。

从源表到结果表,一路可能要走多个步骤,其实就是可能需要多个子查询,过程多就用with as来重构提高可读性。

3、要由简单过度到复杂,不要一下子就写一个很复杂的。

先写简单的select from table…,每个中间步骤都执行打印结果,看是否符合预期, 根据中间结果,进一步调整修饰SQL语句,再执行,直到接近结果表。

4、数据量要小,工具要快,如果用hive,就设置set hive.exec.mode.local.auto=true;如果是SparkSQL,就设置合适的shuffle并行度,set spark.sql.shuffle.partitions=4;

后记

📢博客主页:https://manor.blog.csdn.net

📢欢迎点赞 👍 收藏 ⭐留言 📝 如有错误敬请指正!

📢本文由 Maynor 原创,首发于 CSDN博客🙉

📢不能老盯着手机屏幕,要不时地抬起头,看看老板的位置⭐

📢专栏持续更新,欢迎订阅:https://blog.csdn.net/xianyu120/category_12182595.html

每天一道大厂SQL题Day12微众银行真题实战

每天一道大厂SQL题【Day12】微众银行真题实战(二)

大家好,我是Maynor。相信大家和我一样,都有一个大厂梦,作为一名资深大数据选手,深知SQL重要性,接下来我准备用100天时间,基于大数据岗面试中的经典SQL题,以每日1题的形式,带你过一遍热门SQL题并给出恰如其分的解答。

一路走来,随着问题加深,发现不会的也愈来愈多。但底气着实足了不少,相信不少朋友和我一样,日积月累才是最有效的学习方式!

每日语录

人还是要有梦想的,即使是咸鱼, 也要做最咸的那一条。

第12题:贷款产品不良统计

需求列表

笔试题目

说明:SQL语法请使用HiveSQL/SparkSQL

基于附录2《借据表》统计下述指标,请提供计SOL

| 产品类型 | 在贷客户数 | 在贷余额 | 不良余额 | 余额不良率 | 不良客户数 | 客户不良率 |

|---|---|---|---|---|---|---|

| XX贷 | ||||||

| YY贷 | ||||||

| ZZ贷 | ||||||

| 汇总 |

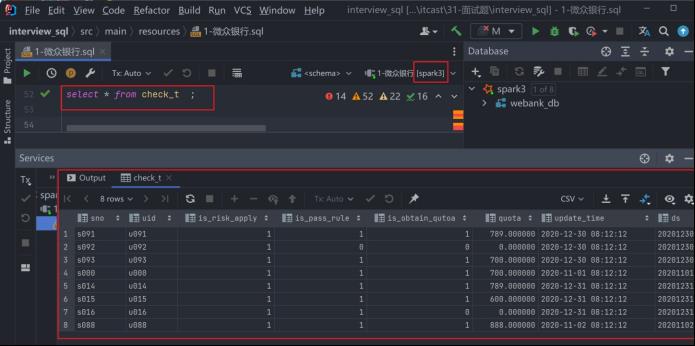

数据准备

链接:https://pan.baidu.com/s/1Wiv-LVYziVxm8f0Lbt38Gw?pwd=s4qc

提取码:s4qc

debt.txt文件

set spark.sql.shuffle.partitions=4;

create database webank_db;

use webank_db;

create or replace temporary view check_view (ds comment '日期分区',

sno comment '流水号', uid comment '用户id',

is_risk_apply comment '是否核额申请',

is_pass_rule comment '是否通过规则',

is_obtain_qutoa comment '是否授信成功', quota comment '授信金额',

update_time comment '更新时间')

as

values ('20201101', 's000', 'u000', 1, 1, 1, 700, '2020-11-01 08:12:12'),

('20201102', 's088', 'u088', 1, 1, 1, 888, '2020-11-02 08:12:12'),

('20201230', 's091', 'u091', 1, 1, 1, 789, '2020-12-30 08:12:12'),

('20201230', 's092', 'u092', 1, 0, 0, 0, '2020-12-30 08:12:12'),

('20201230', 's093', 'u093', 1, 1, 1, 700, '2020-12-30 08:12:12'),

('20201231', 's094', 'u094', 1, 1, 1, 789, '2020-12-31 08:12:12'),

('20201231', 's095', 'u095', 1, 1, 1, 600, '2020-12-31 08:12:12'),

('20201231', 's096', 'u096', 1, 1, 0, 0, '2020-12-31 08:12:12')

;

--创建核额流水表

drop table if exists check_t;

create table check_t (

sno string comment '流水号',

uid string,

is_risk_apply bigint,

is_pass_rule bigint,

is_obtain_qutoa bigint,

quota decimal(30,6), update_time string

) partitioned by (ds string comment '日期分区');

--动态分区需要设置

set hive.exec.dynamic.partition=true;

set hive.exec.dynamic.partition.mode=nonstrict;

insert overwrite table check_t partition (ds) select sno,

uid, is_risk_apply, is_pass_rule, is_obtain_qutoa, quota,

update_time,

ds

from check_view;

-- 创 建 借 据 表

create table debt(

duebill_id string comment '借据号',

uid string, prod_type string,

putout_date string,

putout_amt decimal(30, 6),

balance decimal(30, 6),

is_buliang int,

overduedays int

)partitioned by (ds string comment '日期分区');

--资料提供了一个34899条借据数据的文件

--下面补充如何将文件的数据导入到分区表中。需要一个中间普通表过度。

drop table if exists webank_db.debt_temp;

create table webank_db.debt_temp(

duebill_id string comment '借据号', uid string,

prod_type string,

putout_date string, putout_amt decimal(30, 6),

balance decimal(30,6),

is_buliang int, overduedays int,

ds string comment '日期分区'

) row format delimited fields terminated by '\\t';

load data local inpath '/root/debt.txt' overwrite into table webank_db.debt_temp;

--动态分区需要设置

set hive.exec.dynamic.partition=true;

set hive.exec.dynamic.partition.mode=nonstrict;

insert overwrite table webank_db.debt partition (ds)

select * from webank_db.debt_temp;

--技巧:如果查询debt表,由于分区数太多,导致查询很慢。

-- 开发阶段,我们可以事先将表缓存起来,并且降低分区数比如为6,那么查缓存表大大提升了开发效率。

-- 上线阶段,再用实际表替换缓存表。

--首次缓存会耗时慢

cache table cache_debt as select /+ coalesce(6) / from

debt;

--第二次使用缓存会很快

select count(*) from cache_debt;

select ds,count(1) from cache_debt group by ds;

思路分析

--第二问 假设是今天(2021-10-29)的统计,并考虑对用户去重select * from debt where ds='2021-10-29' ;

drop table if exists prod_type_agg;

create table prod_type_agg(

prod_type string comment '产品',

cnt int,

sum_balance decimal(30, 6),

bad_balance decimal(30, 6),

bad_balance_rate decimal(7, 6),

bad_cnt int,

bad_cnt_rate decimal(7, 6)

) partitioned by (ds string comment '结果分区');

- 在贷客户数:指在某一时点,有未偿还贷款余额的客户数。

- 在贷余额:指在某一时点,所有未偿还贷款的总金额。

- 不良余额:指在某一时点,所有不良贷款(即次级、可疑和损失类贷款)的总金额。

- 余额不良率:指在某一时点,不良余额占在贷余额的比例。公式为:余额不良率 = 不良余额 / 在贷余额

- 不良客户数:指在某一时点,有不良贷款(即次级、可疑和损失类贷款)的客户数。

- 客户不良率:指在某一时点,不良客户数占在贷客户数的比例。公式为:客户不良率 = 不良客户数 / 在贷客户数

方案1 使用union all

方案2 使用grouping sets

答案获取

建议你先动脑思考,动手写一写再对照看下答案,如果实在不懂可以点击下方卡片,回复:大厂sql 即可。

参考答案适用HQL,SparkSQL,FlinkSQL,即大数据组件,其他SQL需自行修改。

加技术群讨论

点击下方卡片关注 联系我进群

或者直接私信我进群

微众银行源数据表附录:

- 核额流水表

| 字段名 | 字段意义 | 字段类型 |

|---|---|---|

| ds | 日期分区,样例格式为20200101,每个分区有全量流水 | string |

| sno | 每个ds内主键,流水号 | string |

| uid | 户id | string |

| is_risk_apply | 是否核额申请(核额漏斗第一步)取值0和1 | bigint |

| is_pass_rule | 是否通过规则(核额漏斗第二步)取值0和1 | bigint |

| is_obtain_qutoa | 是否授信成功(核额漏斗第三步)取值0和1 | bigint |

| quota | 授信金额 | decimal(30,6) |

| update_time | 更新时间样例格式为2020-11-14 08:12:12 | string |

- 借据表

| 字段名 | 字段意义 | 字段类型 |

|---|---|---|

| ds | 日期分区,样例格式为20200101每个分区有全量借据 | string |

| duebilid | 借据号(每个日期分区内的主键) | string |

| uid | 用户id | string |

| prod_type | 产品名称仅3个枚举值XX贷YY贷ZZ贷 | string |

| putout_date | 发放日期样例格式为2020-10-10 00:10:30 | bigint |

| putout_amt | 发放金额 | decimal(30,6) |

| balance | 借据余额 | decimal(30,6) |

| is_buliang | 状态-是否不良取值0和1 | bigint |

| overduedays | 逾期天数 | bigint |

- 模型输出表

| 字段名 | 字段意义 | 字段类型 |

|---|---|---|

| ds | 日期分区,样例格式为20200101增量表部分流水记录可能有更新 | string |

| sno | 流水号,主键 | string |

| create time | 创建日期样例格式为2020-10-10 00:10:30与sno唯一绑定,不会变更 | string |

| uid | 用户id | string |

| content | son格式key值名称为V01~V06,value值取值为0和1 | string |

| create_time | 更新日期样例格式为2020-10-1000:10:30 | string |

文末SQL小技巧

提高SQL功底的思路。

1、造数据。因为有数据支撑,会方便我们根据数据结果去不断调整SQL的写法。

造数据语法既可以create table再insert into,也可以用下面的create temporary view xx as values语句,更简单。

其中create temporary view xx as values语句,SparkSQL语法支持,hive不支持。

2、先将结果表画出来,包括结果字段名有哪些,数据量也画几条。这是分析他要什么。

从源表到结果表,一路可能要走多个步骤,其实就是可能需要多个子查询,过程多就用with as来重构提高可读性。

3、要由简单过度到复杂,不要一下子就写一个很复杂的。

先写简单的select from table…,每个中间步骤都执行打印结果,看是否符合预期, 根据中间结果,进一步调整修饰SQL语句,再执行,直到接近结果表。

4、数据量要小,工具要快,如果用hive,就设置set hive.exec.mode.local.auto=true;如果是SparkSQL,就设置合适的shuffle并行度,set spark.sql.shuffle.partitions=4;

后记

📢博客主页:https://manor.blog.csdn.net

📢欢迎点赞 👍 收藏 ⭐留言 📝 如有错误敬请指正!

📢本文由 Maynor 原创,首发于 CSDN博客🙉

📢不能老盯着手机屏幕,要不时地抬起头,看看老板的位置⭐

📢专栏持续更新,欢迎订阅:https://blog.csdn.net/xianyu120/category_12182595.html

以上是关于每天一道大厂SQL题Day19华泰证券真题实战的主要内容,如果未能解决你的问题,请参考以下文章