Spark读取json数据出现混乱的情况

Posted ro0k1e

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Spark读取json数据出现混乱的情况相关的知识,希望对你有一定的参考价值。

今天晚上,我们老师给我们布置了一个任务,用spark读取一些json数据,然后做一些数据分析的任务

我以为重头戏是数据分析的部分,没想到自己被读取json数据拦了1个多小时,写篇博客记录下 orz

常规的读取数据:

val userInfo = spark.read.format("json").

json( "WebProjectTest/data/Users_Data.log")

val userLog = spark.read.format("json").

json( "WebProjectTest/data/Log_Data.log")

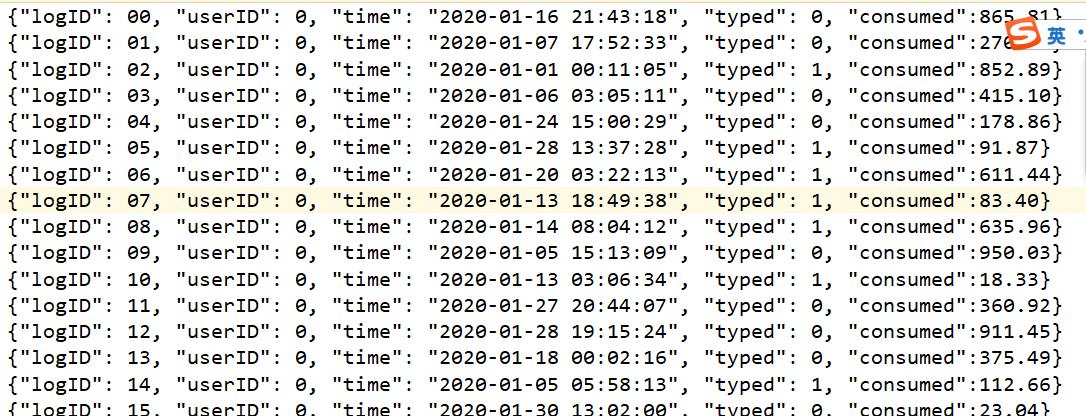

数据集1

数据集2

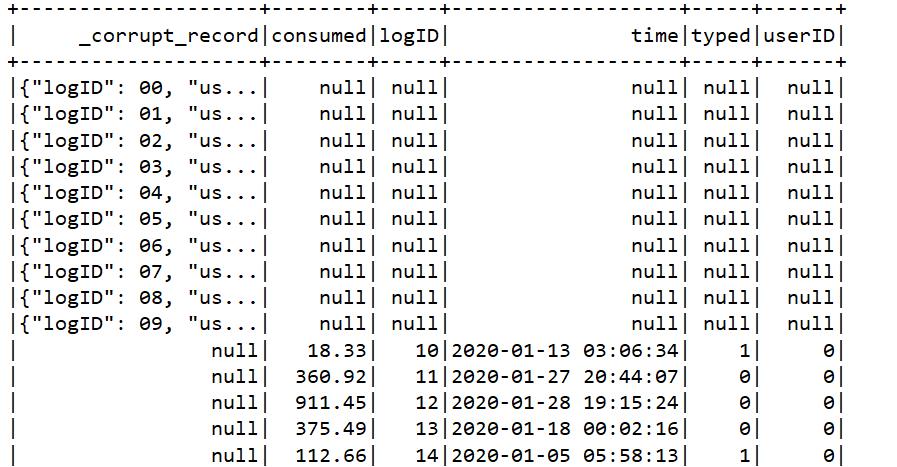

一开始我死抓数据集1,可是读取出来的数据并不是对应的,而是混乱的

想了半天没想明白,然后试了下数据集2,却发现没有毛病

这就奇了怪,难道是数据太大的原因,可是spark本来就是处理大数据的,没理由这100MB就给干趴了啊

我决定将数据集1中的数据截取一点出来,然后自己试验一下,终于让我发现原来是

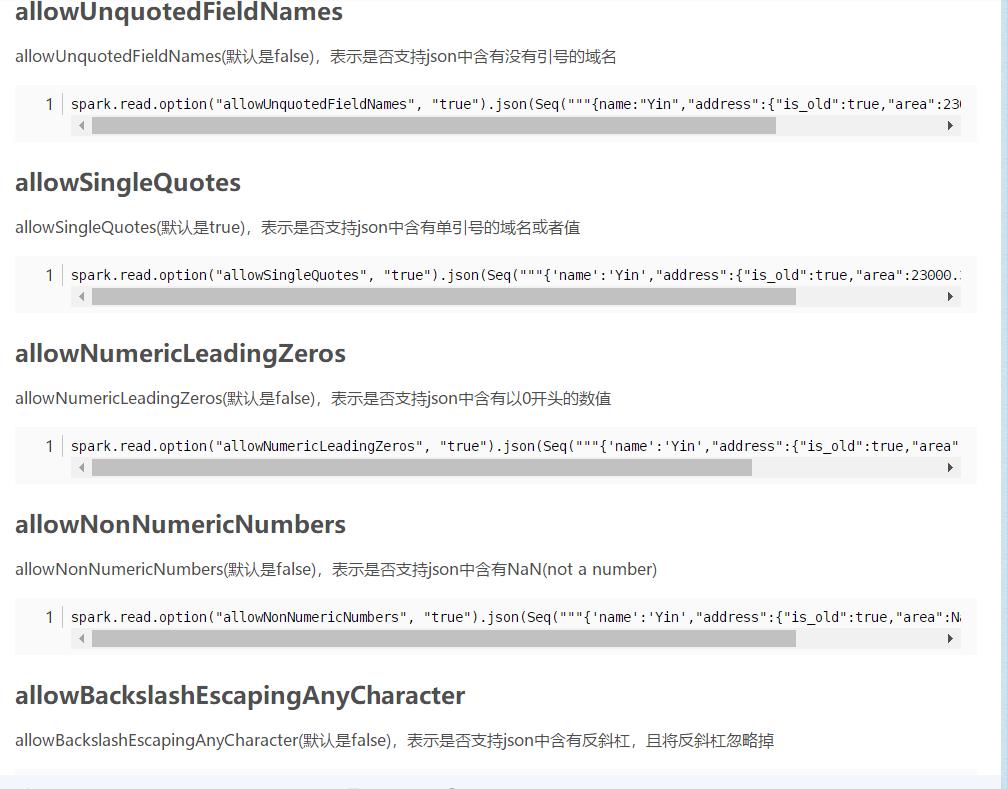

这个0开头的问题,然后去搜了一下0开头的数据怎么处理,果然在读取json的时候有专门对应的选项

附上我搜到的结果路径

<a href>https://blog.csdn.net/weixin_42411818/article/details/98734464</a>

以上是关于Spark读取json数据出现混乱的情况的主要内容,如果未能解决你的问题,请参考以下文章