STM32MP157-视频监控项目-FFmpeg-Nginx-RTMP-流媒体视频

Posted WayneSup

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了STM32MP157-视频监控项目-FFmpeg-Nginx-RTMP-流媒体视频相关的知识,希望对你有一定的参考价值。

韦东山老师的视频监控项目视频链接如下:

在教学视频中由于韦东山老师使用的是IMX6ULL开发板做的示例,我自己用的是STM32MP157Pro开发板,在学习过程中发现有一些地方不能直接照搬,否则开发板无法正常实现推流。所以打算把自己遇到的一些问题和解决方法记下来,方便大家参考!

一、FFmpeg介绍:

FFmpeg是一套开源软件 可以记录、转换音视频:可以从摄像头中记录视频,从声卡中记录音频,可以转换为各种格式,保存起来 还可以把各种格式的音视频,转换为流:供在线观看 其他功能:视频截图、加水印、裁剪等等 Mplayer,ffplay,射手播放器,暴风影音,KMPlayer,QQ影音等视频频播放器的内核就是 FFmpeg 格式工厂的内核也是FFmpeg.

二、Nginx介绍

nginx是一套开源软件,纯C语言编写,效率高 HTTP和反向代理web服务器,同时也是一个 IMAP、POP3、SMTP 代理服务器 稳定、高效,支持高并发 即使强如阿里巴巴,也是使用Nginx,它就是在Nginx的基础上,针对大访问量网站的需求,添加了很多高级功能和特性。 我们只关注:Nginx可以作为流体服务器,支持RTMP、HTTPFLV、HLS等协议

视频流在流媒体中编解码和推拉流情况:

推流端 FFmpeg

- 使用RTMP协议向Nginx推流

- 拉流端 VLC播放器使用RTMP或HTTPFLV协议从Nginx拉流,浏览器使用HTTPFLV协议从Nginx拉流(安装flv.js)

二、移植FFmpeg和Nginx

1.下载源码,手动编译,再移植到开发板

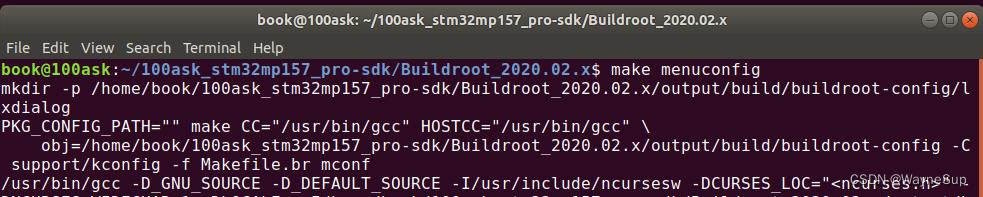

2.使用官方提供的BUildroot,在配置中选择ffmpeg和Nginx,编译生成镜像文件。(简单易行)

这一步正常跟着视频教程走就行。

进入Nginx按照视频里面的把选项都选上。

三、修改配置文件/etc/nginx/nginx.conf

代码如下:

rtmp

server

listen 1935; #listen on standard RTMP port

chunk_size 4096;

application live

allow publish 127.0.0.1;

allow play all;

live on; #Enable listening for live streampplication

record off; #Do not record the stream

meta copy; #Copy the incoming metadata for the outgoing metadata

location /test

flv_live on;

这两段代码不要粘贴错,不然会执行命令的时候会报错:RTMP_ReadPacket, failed to read RTMP packet header,rtmp://127.0.0.1/live/wei: Unknown error occurred

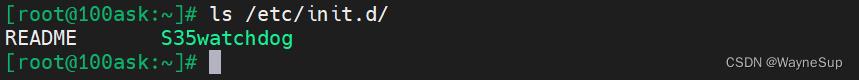

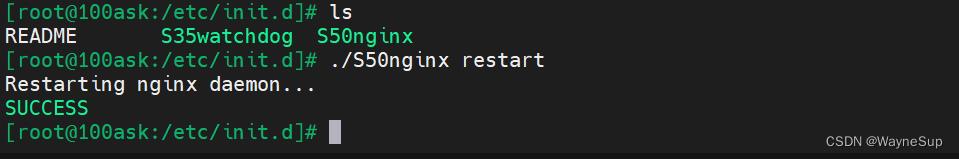

四、重启Nginx服务:

/etc/init.d/S50nginx restart

但是STM32MP157板子烧入系统后,没有这个文件。(重启开发板服务就会重启,如果你需要这么一个初始化文件的话自己也可以建立一个)

vim S50nginx

#粘贴下面的代码到S50nginx

#!/bin/bash

#chkconfig:35 85 15

DAEMON=/usr/sbin/nginx

PID=/var/run/nginx.pid

case "$1" in

start)

echo "Starting nginx daemon..."

$DAEMON && echo "SUCCESS" #开启nginx

;;

stop)

echo "Stopping nginx daemon..."

$DAEMON -s quit && echo "SUCCESS" #从容的停止nginx

;;

reload)

echo "Reloading nginx daemon..."

$DAEMON -s reload && echo "SUCCESS" #平滑重启nginx

;;

restart)

echo "Restarting nginx daemon..."

if [ ! -f "$PID" ]; then

ps -ef | grep nginx | awk 'NR<3print "kill -9 "$2' | sh

sleep 3

$DAEMON && echo "SUCCESS" #开启nginx

else

$DAEMON -s quit #从容的停止nginx

sleep 3

$DAEMON && echo "SUCCESS" #开启nginx

fi

;;

status)

if [ ! -f "$PID" ]; then #▒.▒为nginx启动后会生成▒.程文件nginx.pid,这里通过判断▒.程

echo "Nginx is not running..."

else

echo "Nginx is running..."

fi

;;

*)

echo "Usage:service nginx (start|stop|restart|reload|status)"

exit 2

;;

esac

给S50nginx赋予执行权限

chmod a+x S50nginx 问题解决,重启服务成功!

问题解决,重启服务成功!

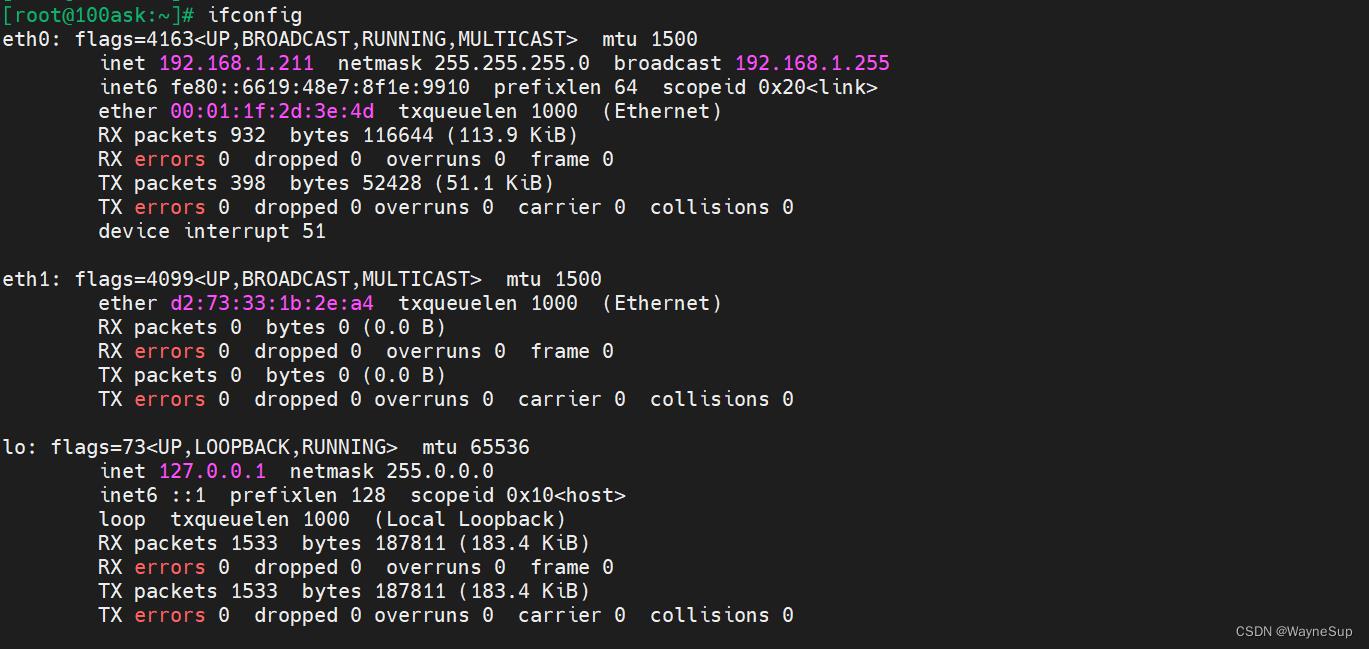

五、测试Nginx:

在浏览器中输入板子的IP

开发板上已经正在运行Nginx服务器了,测试成功!

六、MP4录制测试

- 推流

- 在开发板上执行:

- ffmpeg -f v4l2 -framerate 10 -i /dev/video1 -q 10 my.mp4

报错:

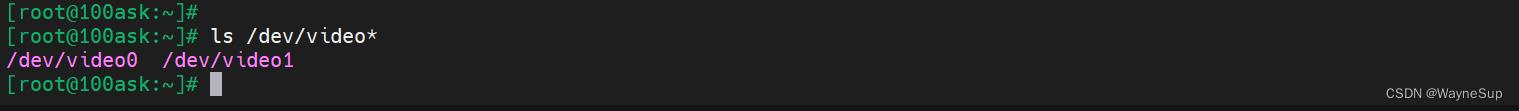

[video4linux2,v4l2 @ 0x72d30] ioctl(VIDIOC_G_INPUT): Inappropriate ioctl for device

/dev/video1: Inappropriate ioctl for device,

将命令中的video1改成video0,该问题解决。

ffmpeg -f v4l2 -framerate 10 -i /dev/video0 -q 10 my.mp4但是执行上述命令会报错:内存不足,ffmpeg进程被杀死

[ 49.199168] Out of memory: Killed process 786 (ffmpeg) total-vm:476024kB, anon-rss:142808kB, file-rss:129672kB, shmem-rss:0kB, UID:0 pgtables:372kB oom_score_adj:0

[ 49.294156] oom_reaper: reaped process 786 (ffmpeg), now anon-rss:0kB, file-rss:129664kB, shmem-rss:0kB

Killed

最开始以为自己电脑用的USB摄像头性能太好,板子的性能不够所以带不动,修改-framerate和-q的数值也不管用,于是我淘宝买了个200W像素的USB迷你摄像头,执行上面的命令结构一样显示内存不足,进程被killed。

自己瞎找了一段时间的资料,也去官方的社区去提问了,但是发现没人鸟我,找客服效率也低。然后想着是不是摄像头的分辨率太高了,自己查了一下使用ffmpeg 设置分辨率,发现果然是分辨率的问题,默认是1920*1080,我将它改成320*240测试了一下,执行命令发现不再报错(stm32mp157上不会像视频里面那样不停地在中断打印信息,ctl+c结束ffmpeg程序),生成的文件也可以在Ubuntu上正常播放,录制MP4问题解决!~

ffmpeg -f v4l2 -framerate 10 -i /dev/video0 -q 1 -s 320x240 my.mp4 -y七、推流测试:

ffmpeg -f v4l2 -framerate 10 -i /dev/video0 -q 10 -f flv rtmp://127.0.0.1/live/wei按照教程给的命令去测试发现,帧率会特别低,而且实时性特别差,虽然我设置的fps=10,但是实行运行时的帧率只有2.1,这就会导致传输到终端的视频特别卡顿。

尝试将帧率调低,效果会有所改善,但是最多就5帧。

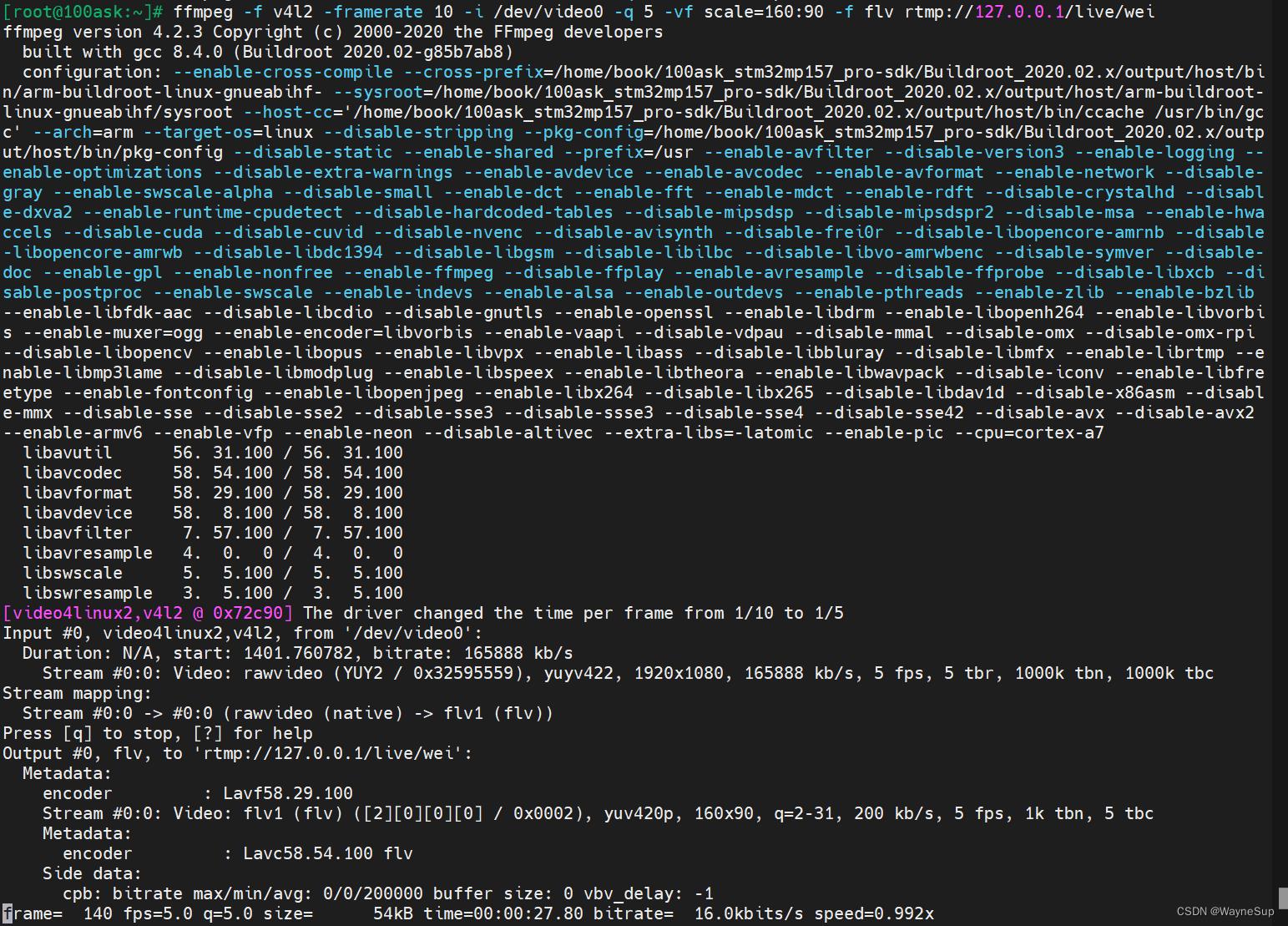

ffmpeg -f v4l2 -framerate 10 -i /dev/video0 -q 5 -vf scale=160:90 -f flv rtmp://127.0.0.1/live/wei

fps=5的视频效果体验非常差,想着自己将帧率设置到最低了为什么ffmpeg推流最多只有5帧,又查了一堆资料然后读了一下打印信息发现问题所在:

[video4linux2,v4l2 @ 0x72c90] The driver changed the time per frame from 1/10 to 1/5

Input #0, video4linux2,v4l2, from '/dev/video0':

Duration: N/A, start: 1401.760782, bitrate: 165888 kb/s

Stream #0:0: Video: rawvideo (YUY2 / 0x32595559), yuyv422, 1920x1080, 165888 kb/s, 5 fps, 5 tbr, 1000k tbn, 1000k tbc

Stream mapping:

Stream #0:0 -> #0:0 (rawvideo (native) -> flv1 (flv))

Press [q] to stop, [?] for help

Output #0, flv, to 'rtmp://127.0.0.1/live/wei':

Metadata:

encoder : Lavf58.29.100

Stream #0:0: Video: flv1 (flv) ([2][0][0][0] / 0x0002), yuv420p, 160x90, q=2-31, 200 kb/s, 5 fps, 1k tbn, 5 tbc

相当于我上面的命令只改了输出流的分辨率,帧数和画面质量。得想办法让摄像头驱动采集的数据也是低分辨率,推送的视频流帧数上不去。又是一通资料查询,使用下面的命令解决了USB摄像头跑在开发板上帧数不高的问题。

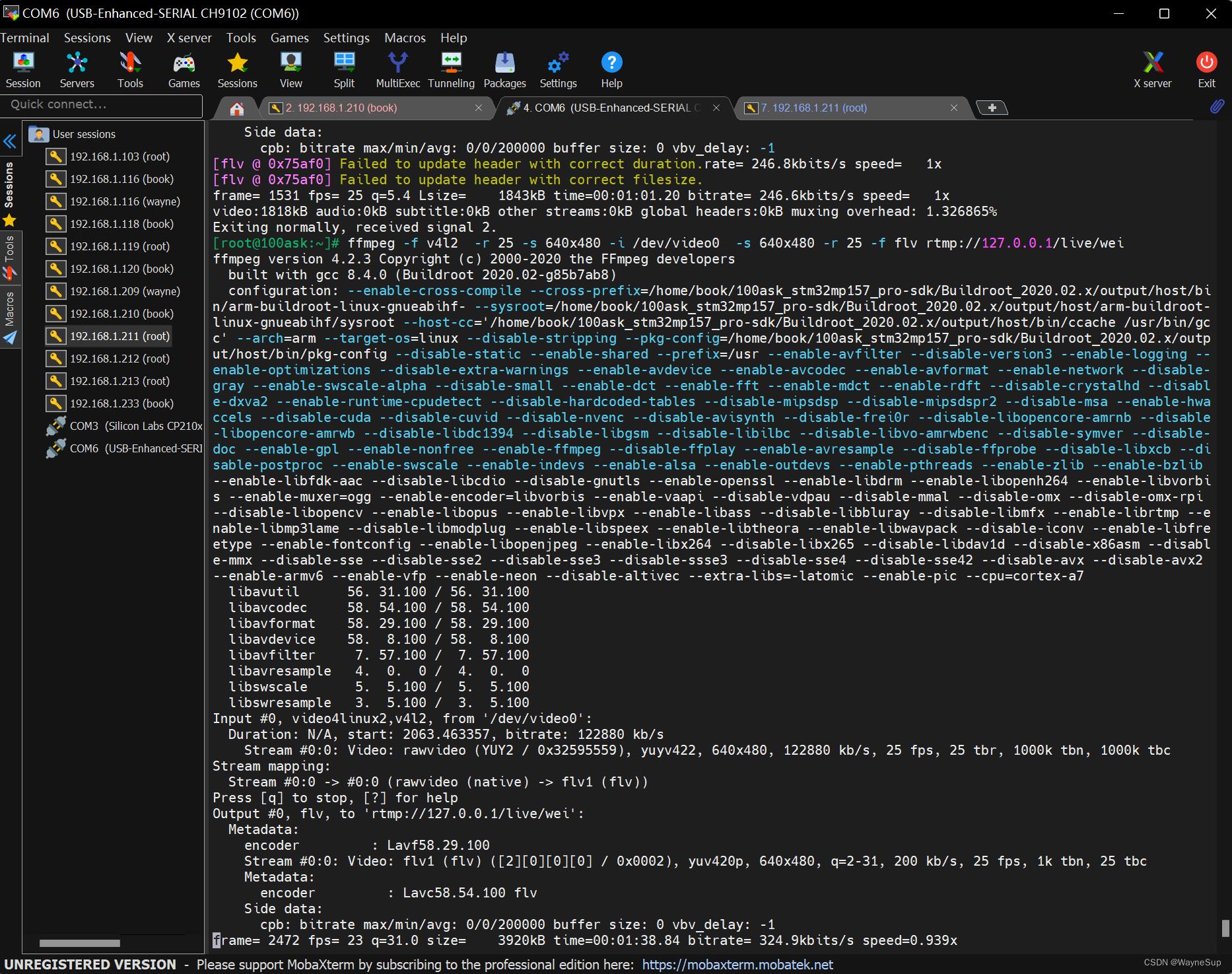

ffmpeg -f v4l2 -r 25 -s 320x240 -i /dev/video0 -s 320x240 -r 25 -f flv rtmp://127.0.0.1/live/wei在-i 前设置分辨率和帧数就是相当于设置的输入端

八、视频播放

我使用的是plotplay来播放视频,你也可以使用教程里面的VLC。

分辨率设成640x480板子的视频推流的帧率可以接近24帧,差不多是这个板子的极限分辨率了,尝试将分辨率调到更低,帧数可以高到30帧,这样视频看上去会更加流畅。

在STM3MP157上跑这个视频监控项目也花了我不少时间,如果你也有类似的需求,希望这篇博客能帮助你少走弯路。

跑这个视频监控是为后续在板子上做MPTCP视频流测试用的,后面我也会将测试结果和情况整理发出来,供大家参考。

如果这篇Blog有帮到你,请点个赞再走,Respect 所有帮到过我的博客作者!

实战小项目之ffmpeg推流yolo视频实时检测

之前实现了yolo图像的在线检测,这次主要完成远程视频的检测。主要包括推流--収流--检测显示三大部分

首先说一下推流,主要使用ffmpeg命令进行本地摄像头的推流,为了实现首屏秒开使用-g设置gop大小,同时使用-b降低网络负载,保证流畅度。

ffmpeg -r 30 -i /dev/video0 -vcodec h264 -max_delay 100 -f flv -g 5 -b 700000 rtmp://219.216.87.170/live/test1

其次是収流,収流最开始的时候,有很大的延迟,大约5秒,后来通过优化,现在延时保证在1s以内,还是可以接收的,直接上収流的程序

AVFormatContext *pFormatCtx; int i, videoindex; AVCodecContext *pCodecCtx; AVCodec *pCodec; AVFrame *pFrame, *pFrameRGB; uint8_t *out_buffer; AVPacket *packet; //int y_size; int ret, got_picture; struct SwsContext *img_convert_ctx; //输入文件路径 // char filepath[] = "rtmp://219.216.87.170/vod/test.flv"; char filepath[] = "rtmp://219.216.87.170/live/test1"; int frame_cnt; printf("wait for playing %s\n", filepath); av_register_all(); avformat_network_init(); pFormatCtx = avformat_alloc_context(); printf("size %ld\tduration %ld\n", pFormatCtx->probesize, pFormatCtx->max_analyze_duration); pFormatCtx->probesize = 20000000; pFormatCtx->max_analyze_duration = 2000; // pFormatCtx->interrupt_callback.callback = timout_callback; // pFormatCtx->interrupt_callback.opaque = pFormatCtx; // pFormatCtx->flags |= AVFMT_FLAG_NONBLOCK; AVDictionary* options = NULL; av_dict_set(&options, "fflags", "nobuffer", 0); // av_dict_set(&options, "max_delay", "100000", 0); // av_dict_set(&options, "rtmp_transport", "tcp", 0); // av_dict_set(&options, "stimeout", "6", 0); printf("wating for opening file\n"); if (avformat_open_input(&pFormatCtx, filepath, NULL, &options) != 0) { printf("Couldn‘t open input stream.\n"); return -1; } av_dict_free(&options); printf("wating for finding stream\n"); if (avformat_find_stream_info(pFormatCtx, NULL) < 0) { printf("Couldn‘t find stream information.\n"); return -1; } videoindex = -1; for (i = 0; i < pFormatCtx->nb_streams; i++) if (pFormatCtx->streams[i]->codec->codec_type == AVMEDIA_TYPE_VIDEO) { videoindex = i; break; } if (videoindex == -1) { printf("Didn‘t find a video stream.\n"); return -1; } pCodecCtx = pFormatCtx->streams[videoindex]->codec; pCodec = avcodec_find_decoder(pCodecCtx->codec_id); if (pCodec == NULL) { printf("Codec not found.\n"); return -1; } if (avcodec_open2(pCodecCtx, pCodec, NULL) < 0) { printf("Could not open codec.\n"); return -1; } /* * 在此处添加输出视频信息的代码 * 取自于pFormatCtx,使用fprintf() */ pFrame = av_frame_alloc(); pFrameRGB = av_frame_alloc(); out_buffer = (uint8_t *) av_malloc( avpicture_get_size(AV_PIX_FMT_BGR24, pCodecCtx->width, pCodecCtx->height)); avpicture_fill((AVPicture *) pFrameRGB, out_buffer, AV_PIX_FMT_BGR24, pCodecCtx->width, pCodecCtx->height); packet = (AVPacket *) av_malloc(sizeof(AVPacket)); //Output Info----------------------------- printf("--------------- File Information ----------------\n"); av_dump_format(pFormatCtx, 0, filepath, 0); printf("-------------------------------------------------\n"); img_convert_ctx = sws_getContext(pCodecCtx->width, pCodecCtx->height, pCodecCtx->pix_fmt, pCodecCtx->width, pCodecCtx->height, AV_PIX_FMT_BGR24, SWS_BICUBIC, NULL, NULL, NULL); CvSize imagesize; imagesize.width = pCodecCtx->width; imagesize.height = pCodecCtx->height; IplImage *image = cvCreateImageHeader(imagesize, IPL_DEPTH_8U, 3); cvSetData(image, out_buffer, imagesize.width * 3); cvNamedWindow(filepath, CV_WINDOW_AUTOSIZE); frame_cnt = 0; int num = 0; while (av_read_frame(pFormatCtx, packet) >= 0) { if (packet->stream_index == videoindex) { /* * 在此处添加输出H264码流的代码 * 取自于packet,使用fwrite() */ ret = avcodec_decode_video2(pCodecCtx, pFrame, &got_picture, packet); if (ret < 0) { printf("Decode Error.\n"); return -1; } if (got_picture) { sws_scale(img_convert_ctx, (const uint8_t* const *) pFrame->data, pFrame->linesize, 0, pCodecCtx->height, pFrameRGB->data, pFrameRGB->linesize); printf("Decoded frame index: %d\n", frame_cnt); /* * 在此处添加输出YUV的代码 * 取自于pFrameYUV,使用fwrite() */ frame_cnt++; cvShowImage(filepath, image); cvWaitKey(30); } } av_free_packet(packet); } sws_freeContext(img_convert_ctx); av_frame_free(&pFrameRGB); av_frame_free(&pFrame); avcodec_close(pCodecCtx); avformat_close_input(&pFormatCtx); return 0;

将解压后的数据区与opencv的IplImage的数据区映射,实现opencv显示。

检测部分,主要使用IplImage与yolo中的图像进行对接,在图像转换方面,进行了部分优化,缩减一些不必要的步骤。然后使用线程区接收ffmepg流,主循环里区做检测并显示。需要做线程同步处理,只有当收到新流时,才去检测。

以上是关于STM32MP157-视频监控项目-FFmpeg-Nginx-RTMP-流媒体视频的主要内容,如果未能解决你的问题,请参考以下文章

STM32MP157开发笔记 | 01 - STM32MP157C-DK2公板快速上手

STM32MP157开发笔记 | 01 - STM32MP157C-DK2公板快速上手

STM32MP157开发笔记 | 03 - STM32MP157启动程序ROM Code详解