人工智能AI服务器配置要求-首选驰网i9-13900k服务器

Posted 传奇百晓生-明杰

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了人工智能AI服务器配置要求-首选驰网i9-13900k服务器相关的知识,希望对你有一定的参考价值。

什么是人工智能AI?

具有执行感知功能(例如感知,学习,推理和解决问题)的能力的机器被认为拥有人工智能。当机器具有认知能力时,就会存在人工智能。 判断 AI 的基准是涉及推理、语音和视觉是否接近或达到人类水平。

一、入门人工智能

弱 AI(Narrow AI):当机器可以比人类更好地执行特定任务时。

通用 AI(General AI):人工智能可以以与人类相同的精度水平执行任何智力任务时达到通用状态。

强 AI(Strong AI):当 AI 在许多任务中都能击败人类时,它就是强 AI。

如今,人工智能已在几乎所有行业中使用,为所有大规模集成人工智能的公司提供了技术优势。麦肯锡认为,与其他分析技术相比,人工智能有潜力创造 6000 亿美元的零售价值,为银行业带来 50%的增量价值。在运输和物流领域,潜在收入增长了 89%以上。

具体来说,如果企业将 AI 用于其营销团队,则可以使平凡而又重复性的任务自动化,从而使销售代表可以专注于诸如建立关系,培养领导等任务。企业可以使用 AI 分析和推荐来制定制胜战略。

简而言之,人工智能提供了一种尖端技术来处理人类无法处理的复杂数据。 AI 将多余的工作自动化,使工人可以专注于高水平的增值任务。大规模实施 AI 可以降低成本并增加收入。

人工智能AI服务器该怎么去选择?

就目前的技术发展趋势来看,人工智能专业的发展前景还是非常可观的,因为现在不管是云计算、大数据技术,还是物联网相关技术,最终的发展诉求之一都要回到智能化,并且智能化又是大多数技术体系实现价值增量的重要环节,因此人工智能是当前科技研发的一个重点领域。

那么如果想从事人工智能这个行业的话、服务器改如何选择呢?

人工智能服务器在配置选择上与其它行业(游戏、APP开发...)是不同的,要想应用于人工智能,必须满足AI技术要求。

1、性能要稳定

为了保证网络能正常运转,选择的服务器首先要确保稳定,因为一个性能不稳定的服务器,即使配置再高、技术再先进,也不能保证网络能正常工作,严重的话可能给使用者造成难以估计的损失。另外一方面,性能稳定的服务器还意味着为公司节省维护费用。

2、应考虑扩展性

由于网络处于不断发展之中,驰网I9-13900K服务器租用,快速增长的应用不断对服务器的性能提出新的要求,为了减少更新服务器带来的额外开销和对工作的影响,驰网I9-13900K服务器租用,服务器应当具有较高的可扩展性,可以及时调整配置来适应发展。

3、配件搭配合理

为了能使服务器更高效地运转,我们要确保购买的服务器的内部配件的性能必须合理搭配。例如我们购买了高性能的服务器,但是服务器内部的某些配件使用了低价的兼容组件,就会出现有的配件处于瓶颈状态,有的配件处于闲置状态,最后的结果是整个服务器系统的性能下降。一台高性能的服务器不是一件或几件设备的性能优异,而是所有部件的合理搭配。要尽量避免小马拉大车,或者是大马拉小车的情况。低速、小容量的硬盘、小容量的内存,任何一个产生系统瓶颈的配件都有可能制约系统的整体性。

4、理性看待价格

无论购买什么产品,用户都会很看重产品的价格。当然一分价钱一分货,高档服务器的价格比低档服务器的价格高是无可非议的事情。但不一定非得购买那些价格昂贵的服务器,尽管高端服务器功能很多,但是这些功能对普通应用来说使用率不高,这样会白白浪费了资金。性能稳定、价格适中的服务器应该是一般公司的选择。

5、售后服务要好

由于服务器的使用和维护包含一定的技术含量,这就要求操作和管理服务器的人员必须掌握一定的使用知识。但对于普通公司来说,可能没有专职人员来维护服务器。因此选择售后服务好的销售场所来购买,应该成为普通用户明智的决定。

驰网最新推出的i9-13900k服务器就能完美满足人工智能行业所需要的配置

驰网科技拥有全国大量T3、T4机房及高防机房,带宽数量超过1000Gb,机架位超过000个,配套我司优质的7*24服务体系,提供优质的IDC租用托管服务。

下面跟着小编一起来看看这颗性能猛兽的配置参数你就知道了。

i9-13900K同样采用了高性能混合架构与Intel 7工艺,但是在核心频率、能效核心数量,以及缓存系统上都有进一步的提升,使得无论是单线程性能还是多线程能力都处于目前桌面级处理器的天花板,最高可达8个性能核+16个能效核,共计24核心/32线程,最高可达15%单核性能+41%多核性能迭代提升。

经过我们的实测,i9-13900K配上了高频DDR5内存后性能发挥相当的出色。在同样内存规格的情况下,i9-13900K在多个理论性能方面要比i9-12900K强出不少,整体性能带来约23%的提升。可谓是新一代的处理器之王!

高防护IP段(TCP_SYN,ACK,RST)展示:

103.219.39.1

103.219.39.2

103.219.39.3

103.219.39.4

103.219.39.5

103.219.39.6

103.219.39.7

103.219.39.8

103.219.39.9

103.219.39.10

103.219.39.11

103.219.39.12

103.219.39.13

103.219.39.14

103.219.39.15

103.219.39.16

103.219.39.17

103.219.39.18

103.219.39.19

103.219.39.20

103.219.39.21

103.219.39.22

103.219.39.23

103.219.39.24

103.219.39.25

103.219.39.26

103.219.39.27

103.219.39.28

103.219.39.29

103.219.39.30

103.219.39.31

103.219.39.32

103.219.39.33

103.219.39.34

103.219.39.35

103.219.39.36

103.219.39.37

103.219.39.38

103.219.39.39

103.219.39.40

103.219.39.41

103.219.39.42

103.219.39.43

103.219.39.44

103.219.39.45

103.219.39.46

103.219.39.47

103.219.39.48

103.219.39.49

103.219.39.50

103.219.39.51

103.219.39.52

103.219.39.53

103.219.39.54

103.219.39.55

103.219.39.56

103.219.39.57

103.219.39.58

103.219.39.59

103.219.39.60

103.219.39.61

103.219.39.62

103.219.39.63

103.219.39.64

103.219.39.65

103.219.39.66

103.219.39.67

103.219.39.68

103.219.39.69

103.219.39.70

103.219.39.71

103.219.39.72

103.219.39.73

103.219.39.74

103.219.39.75

103.219.39.76

103.219.39.77

103.219.39.78

103.219.39.79

103.219.39.80

103.219.39.81

103.219.39.82

103.219.39.83

103.219.39.84

103.219.39.85

103.219.39.86

103.219.39.87

103.219.39.88

103.219.39.89

103.219.39.90

103.219.39.91

103.219.39.92

103.219.39.93

103.219.39.94

103.219.39.95

103.219.39.96

103.219.39.97

103.219.39.98

103.219.39.99

103.219.39.100

103.219.39.101

103.219.39.102

103.219.39.103

103.219.39.104

103.219.39.105

103.219.39.106

103.219.39.107

103.219.39.108

103.219.39.109

103.219.39.110

103.219.39.111

103.219.39.112

103.219.39.113

103.219.39.114

103.219.39.115

103.219.39.116

103.219.39.117

103.219.39.118

103.219.39.119

103.219.39.120

103.219.39.121

103.219.39.122

103.219.39.123

103.219.39.124

103.219.39.125

103.219.39.126

103.219.39.127

103.219.39.128

103.219.39.129

103.219.39.130

103.219.39.131

103.219.39.132

103.219.39.133

103.219.39.134

103.219.39.135

103.219.39.136

103.219.39.137

103.219.39.138

103.219.39.139

103.219.39.140

103.219.39.141

103.219.39.142

103.219.39.143

103.219.39.144

103.219.39.145

103.219.39.146

103.219.39.147

103.219.39.148

103.219.39.149

103.219.39.150

103.219.39.151

103.219.39.152

103.219.39.153

103.219.39.154

103.219.39.155

103.219.39.156

103.219.39.157

103.219.39.158

103.219.39.159

103.219.39.160

103.219.39.161

103.219.39.162

103.219.39.163

103.219.39.164

103.219.39.165

103.219.39.166

103.219.39.167

103.219.39.168

103.219.39.169

103.219.39.170

103.219.39.171

103.219.39.172

103.219.39.173

103.219.39.174

103.219.39.175

103.219.39.176

103.219.39.177

103.219.39.178

103.219.39.179

103.219.39.180

103.219.39.181

103.219.39.182

103.219.39.183

103.219.39.184

103.219.39.185

103.219.39.186

103.219.39.187

103.219.39.188

103.219.39.189

103.219.39.190

103.219.39.191

103.219.39.192

103.219.39.193

103.219.39.194

103.219.39.195

103.219.39.196

103.219.39.197

103.219.39.198

103.219.39.199

103.219.39.200

103.219.39.201

103.219.39.202

103.219.39.203

103.219.39.204

103.219.39.205

103.219.39.206

103.219.39.207

103.219.39.208

103.219.39.209

103.219.39.210

103.219.39.211

103.219.39.212

103.219.39.213

103.219.39.214

103.219.39.215

103.219.39.216

103.219.39.217

103.219.39.218

103.219.39.219

103.219.39.220

103.219.39.221

103.219.39.222

103.219.39.223

103.219.39.224

103.219.39.225

103.219.39.226

103.219.39.227

103.219.39.228

103.219.39.229

103.219.39.230

103.219.39.231

103.219.39.232

103.219.39.233

103.219.39.234

103.219.39.235

103.219.39.236

103.219.39.237

103.219.39.238

103.219.39.239

103.219.39.240

103.219.39.241

103.219.39.242

103.219.39.243

103.219.39.244

103.219.39.245

103.219.39.246

103.219.39.247

103.219.39.248

103.219.39.249

103.219.39.250

103.219.39.251

103.219.39.252

103.219.39.253

103.219.39.254

103.219.39.255

干货|深度理解RNN:时间序列数据的首选神经网络!

随着科学技术的发展以及硬件计算能力的大幅提升,人工智能已经从几十年的幕后工作一下子跃入人们眼帘。人工智能的背后源自于大数据、高性能的硬件与优秀的算法的支持。

2016年,深度学习已成为Google搜索的热词,随着最近一两年的围棋人机大战中,阿法狗完胜世界冠军后,人们感觉到再也无法抵挡住AI的车轮的快速驶来。在2017年这一年中,AI已经突破天际,相关产品也出现在人们的生活中,比如智能机器人、无人驾驶以及语音搜索等。最近,世界智能大会在天津举办成功,大会上许多业内行家及企业家发表自己对未来的看法,可以了解到,大多数的科技公司及研究机构都非常看好人工智能的前景,比如百度公司将自己的全部身家压在人工智能上,不管破釜沉舟后是一举成名还是一败涂地,只要不是一无所获就行。

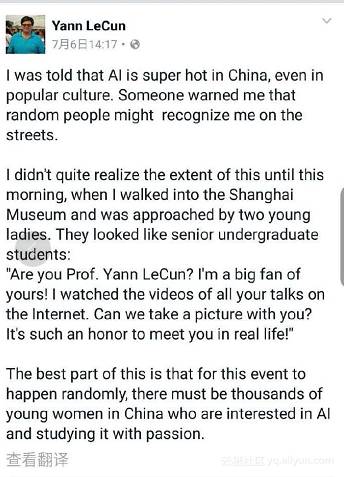

为什么突然之间深度学习会有这么大的效应与热潮呢?这是因为科技改变生活,很多的职业可能在今后的时间里慢慢被人工智能所取代。全民都在热议人工智能与深度学习,就连Yann LeCun大牛都感受到了人工智能在中国的火热!

言归正传,人工智能的背后是大数据、优秀的算法以及强大运算能力的硬件支持。比如,英伟达公司凭借自己的强大的硬件研发能力以及对深度学习框架的支持夺得世全球最聪明的五十家公司榜首。另外优秀的深度学习算法有很多,时不时就会出现一个新的算法,真是令人眼花缭乱。但大多都是基于经典的算法改进而来,比如卷积神经网络(CNN)、深度信念网络(DBN)、循环神经网络(RNN)等等。

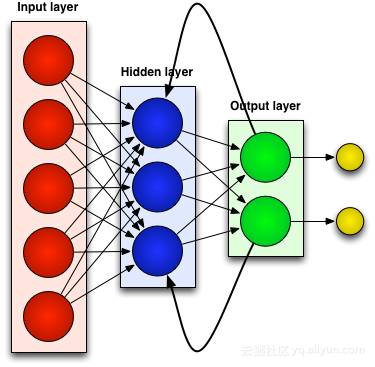

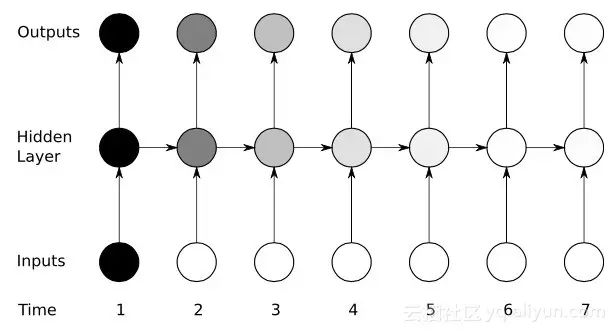

本文将介绍经典的网络之循环神经网络(RNN),这一网络也是时序数据的首选网络。当涉及某些顺序机器学习任务时,RNN可以达到很高的精度,没有其他算法可以与之一较高下。这是由于传统的神经网络只是具有一种短期记忆,而RNN具有有限的短期记忆的优势。然而,第一代RNNs网络并没有引起人们着重的注意,这是由于研究人员在利用反向传播和梯度下降算法过程中遭受到了严重的梯度消失问题,阻碍了RNN几十年的发展。

最后,于90年代后期出现了重大突破,导致更加准确的新一代RNN的问世。基于这一突破的近二十年,直到Google Voice Search和Apple Siri等应用程序开始抢夺其关键流程,开发人员完善和优化了新一代的RNN。现在,RNN网络遍布各个研究领域,并且正在帮助点燃人工智能的复兴之火。

与过去有关的神经网络(RNN)

大多数人造神经网络,如前馈神经网络,都没有记忆它们刚刚收到的输入。例如,如果提供前馈神经网络的字符“WISDOM”,当它到达字符“D”时,它已经忘记了它刚刚读过字符“S”,这是一个大问题。无论训练该网络是多么的辛苦,总是很难猜出下一个最有可能的字符“O”。这使得它成为某些任务的一个相当无用的候选人,例如在语音识别中,识别的好坏在很大程度上受益于预测下一个字符的能力。另一方面,RNN网络确实记住了之前的输入,但是处于一个非常复杂的水平。

我们再次输入“WISDOM”,并将其应用到一个复发性网络中。RNN网络中的单元或人造神经元在接收到“D”时也将其之前接收到的字符“S”作为其输入。换句话说,就是把刚刚过去的事情联合现在的事情作为输入,来预测接下来会发生的事情,这给了它有限的短期记忆的优势。当训练时,提供足够的背景下,可以猜测下一个字符最有可能是“O”。

调整和重新调整

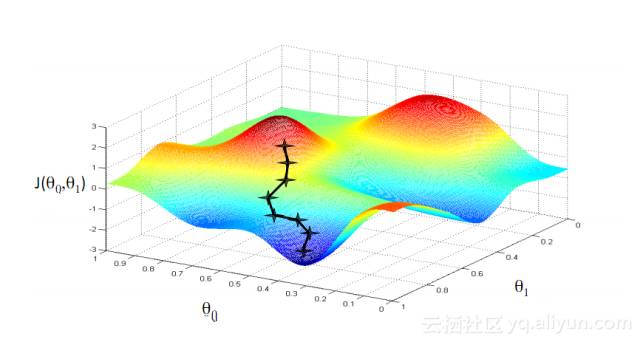

像所有人工神经网络一样,RNN的单元为其多个输入分配一个权重矩阵,这些权重代表各个输入在网络层中所占的比重;然后对这些权重应用一个函数来确定单个输出,这个函数一般被称为损失函数(代价函数),限定实际输出与目标输出之间的误差。然而,循环神经网络不仅对当前输入分配权重,而且还从对过去时刻输入分配权重。然后,通过使得损失函数最下来动态的调整分配给当前输入和过去输入的权重,这个过程涉及到两个关键概念:梯度下降和反向传播(BPTT)。

梯度下降

机器学习中最著名的算法之一就是梯度下降算法。它的主要优点在于它显着的回避了“维数灾难”。什么是“维数灾难”呢,就是说在涉及到向量的计算问题中,随着维数的增加,计算量会呈指数倍增长。这个问题困扰着诸多神经网络系统,因为太多的变量需要计算来达到最小的损失函数。然而,梯度下降算法通过放大多维误差或代价函数的局部最小值来打破维数灾难。这有助于系统调整分配给各个单元的权重值,以使网络变得更加精确。

通过时间的反向传播

RNN通过反向推理微调其权重来训练其单元。简单的说,就是根据单元计算出的总输出与目标输出之间的误差,从网络的最终输出端反向逐层回归,利用损失函数的偏导调整每个单元的权重。这就是著名的BP算法,关于BP算法可以看本博主之前的相关博客。而RNN网络使用的是类似的一个版本,称为通过时间的反向传播(BPTT)。该版本扩展了调整过程,包括负责前一时刻(T-1)输入值对应的每个单元的记忆的权重。

Yikes:梯度消失问题

尽管在梯度下降算法和BPTT的帮助下享有一些初步的成功,但是许多人造神经网络(包括第一代RNNs网络),最终都遭受了严重的挫折——梯度消失问题。什么是梯度消失问题呢,其基本思想其实很简单。首先,来看一个梯度的概念,将梯度视为斜率。在训练深层神经网络的背景中,梯度值越大代表坡度越陡峭,系统能够越快地下滑到终点线并完成训练。但这也是研究者陷入困境的地方——当斜坡太平坦时,无法进行快速的训练。这对于深层网络中的第一层而言特别关键,因为若第一层的梯度值为零,说明没有了调整方向,无法调整相关的权重值来最下化损失函数,这一现象就是“消梯度失”。随着梯度越来越小,训练时间也会越来越长,类似于物理学中的沿直线运动,光滑表面,小球会一直运动下去。

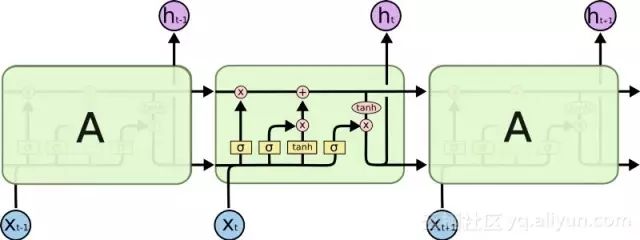

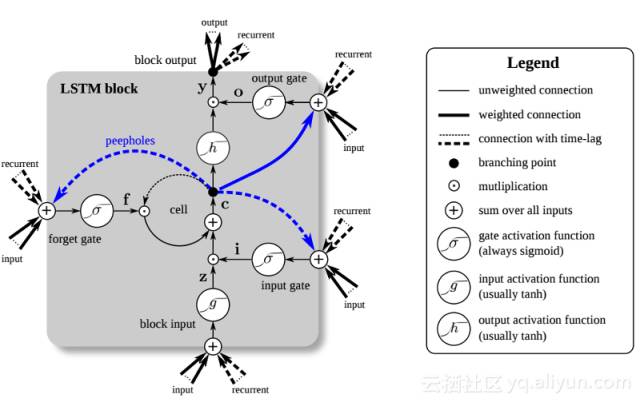

大的突破:长短期记忆(LSTM)

在九十年代后期,一个重大的突破解决了上述梯度消失问题,给RNN网络发展带来了第二次研究热潮。这种大突破的中心思想是引入了单元长短期记忆(LSTM)。

LSTM的引入给AI领域创造了一个不同的世界。这是由于这些新单元或人造神经元(如RNN的标准短期记忆单元)从一开始就记住了它们的输入。然而,与标准的RNN单元不同,LSTM可以挂载在它们的存储器上,这些存储器具有类似于常规计算机中的存储器寄存器的读/写属性。另外LSTM是模拟的,而不是数字,使得它们的特征可以区分。换句话说,它们的曲线是连续的,可以找到它们的斜坡的陡度。因此,LSTM特别适合于反向传播和梯度下降中所涉及的偏微积分。

总而言之,LSTM不仅可以调整其权重,还可以根据训练的梯度来保留、删除、转换和控制其存储数据的流入和流出。最重要的是,LSTM可以长时间保存重要的错误信息,以使梯度相对陡峭,从而网络的训练时间相对较短。这解决了梯度消失的问题,并大大提高了当今基于LSTM的RNN网络的准确性。由于RNN架构的显著改进,谷歌、苹果及许多其他先进的公司现在正在使用RNN为其业务中心的应用提供推动力。

总结

循环神经网络(RNN)可以记住其以前的输入,当涉及到连续的、与上下文相关的任务(如语音识别)时,它比其他人造神经网络具有更大的优势。

关于RNN网络的发展历程:第一代RNNs通过反向传播和梯度下降算法达到了纠正错误的能力。但梯度消失问题阻止了RNN的发展;直到1997年,引入了一个基于LSTM的架构后,取得了大的突破。新的方法有效地将RNN网络中的每个单元转变成一个模拟计算机,大大提高了网络精度。

!

以上是关于人工智能AI服务器配置要求-首选驰网i9-13900k服务器的主要内容,如果未能解决你的问题,请参考以下文章