综述基于Transformer的视频语言预训练

Posted 我爱计算机视觉

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了综述基于Transformer的视频语言预训练相关的知识,希望对你有一定的参考价值。

关注公众号,发现CV技术之美

▊ 1. 论文和代码地址

Survey: Transformer based Video-Language Pre-training

论文地址:https://arxiv.org/abs/2109.09920

▊ 2. Introduction

Transformer已经在性能上显示出巨大的优势,并在深度学习(DL)中流行起来。与多层感知器(MLP)、卷积神经网络(CNN)和递归神经网络(RNN)等传统深度学习网络相比,transformer更适合于预训练和网络化,因为其网络结构易于深化,且模型bias较小。

典型的pretraining和finetuning是,模型首先在大量(通常是自监督的)训练数据上进行训练吗,然后在较小(通常是任务特定的)下游任务数据集上进行微调。预训练阶段有助于模型学习通用表示法,这有助于完成下游任务。

基于Transformer的预训练方法首次被提出用于自然语言处理(NLP)任务,并取得了显著的性能提升。受NLP领域基于Transformer的预训练方法突破的启发,计算机视觉(CV)研究人员近年来也将Transformer应用于各种任务中。

视频分析和理解更具挑战性,因为视频自然携带多模态信息。对于具有代表性的视频语言任务,如视频字幕和视频检索,现有的方法主要侧重于基于视频帧序列和相应字幕学习视频的语义表示。

在本文中,我们重点对视频语言处理中基于Transformer的预训练方法的最新进展进行了全面概述,包括相应基准的常用度量、现有模型设计的分类,以及一些进一步的讨论。

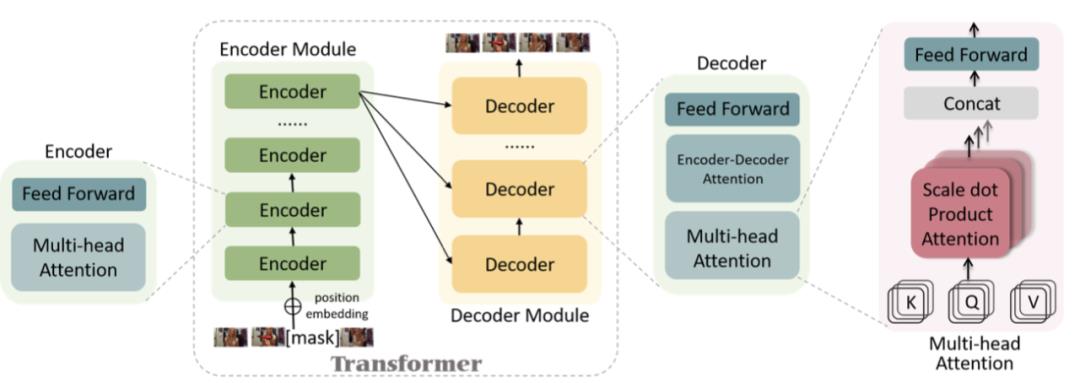

标准Transformer的结构如上图所示。

▊ 3. Proxy Tasks

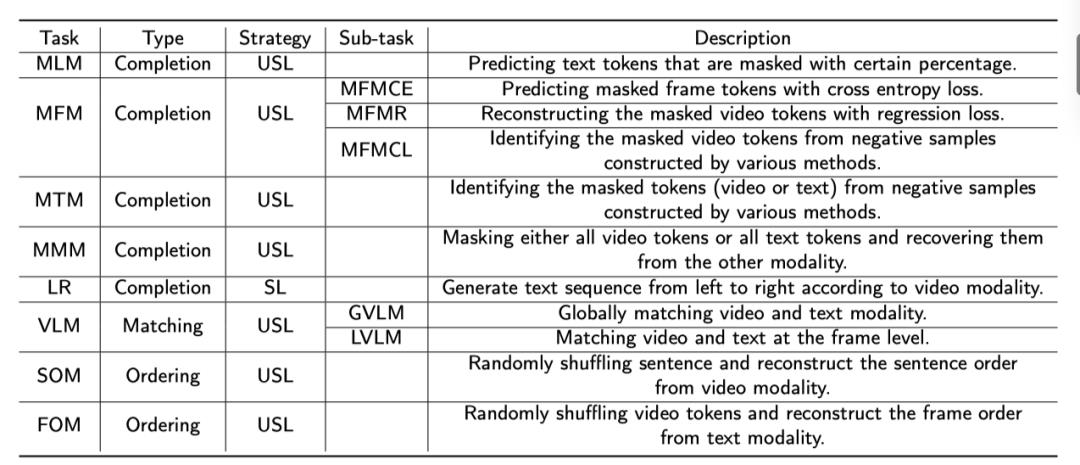

代理任务(Proxy Tasks)主要可以分为三类:

1)完成任务(Completion tasks)的目的是重建被mask的token。典型任务包括Masked Language Modeling (MLM), Masked Frame Modeling (MFM), Masked Token Modeling (MTM), Masked Modal Modeling (MMM) and Language Reconstruction (LR)。

2)匹配任务(Matching tasks)旨在学习不同模态之间的一致性,视频语言匹配(Video Language Matching,VLM)是经典的匹配任务,其目标是匹配视频和文本模态。

3)排序任务(Ordering tasks)是在输入端对序列进行排序,并迫使模型识别原始序列顺序。例如,帧顺序建模(FOM)专门用于利用视频序列的时间特性,而句子顺序建模(SOM)专门用于文本模态。

3.1. Masked Language Modeling (MLM)

MLM方法首先从输入句子中随机抽取一定比例的词,然后根据其他词的token对被mask的词进行预测。MLM用于视频语言预训练,不仅学习句子内在的关系,而且将视觉信息与句子结合起来。根据经验,掩蔽百分比始终设置为15%。MLM的损失函数可以定义为:

3.2. Masked Frame Modeling (MFM)

Masked Frame Modeling(MFM)类似于MLM,因为它只是把句子改成视频序列。然而,由于视频是连续的,没有固定的词汇作为文本,研究人员对MFM任务的输入端或目标端进行了不同的调整。

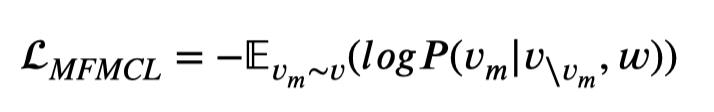

我们根据损失函数将MFM分为三个子任务:1)交叉熵MFM(MFMCL),2)回归MFM(MFMR),以及3)对比学习MFM(MFMCO)。

MFMCL的典型例子可以在VideoBERT中找到,VideoBERT将连续视频分割成片段token,并通过分层k均值将片段token聚类成固定大小的字典。这样,被mask的视频特征就可以被预测为具有类似然的视频word。ActBERT从视频中提取动作概念和局部对象特征,并强制模型分别预测mask视频token的动作类别和对象类别。MFMCL的损失函数可表示为:

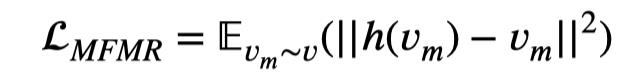

MFMR的典型例子可以在HERO中找到,它学习将每个mask帧上的输出回归到其视觉特征。HERO在输入视频特征和输出视频特征之间使用L2回归:

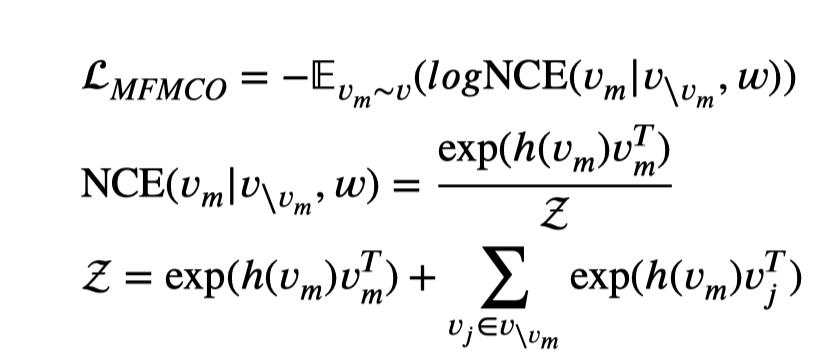

然而,由于视频包含丰富的信息量,用回归方法很难恢复出原始的视频特征。MFMCO采用对比学习来最大化mask视频token和原始视频token之间的互信息(MI):

3.3. Masked Token Modeling (MTM)

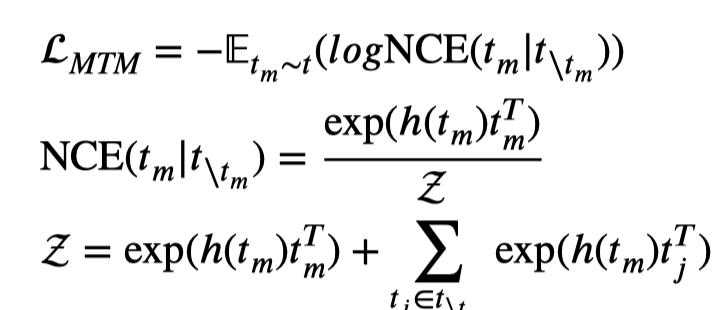

MTM将MLM和MFM用一个损失函数统一:

与MLM和MFM相比,MTM学习视频和文本token的联合token嵌入。此外,它还在MFM和MLM两个单独的损失中扩展了对比的负样本。

3.4. Masked Modal Modeling (MMM)

MMM屏蔽了所有视频token或所有文本token,这鼓励模型使用来自一个模态的token从另一个模态恢复token。

3.5. Language Reconstruction (LR)

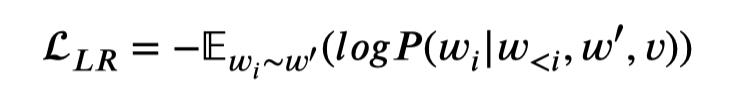

LR是一项生成性任务,其目的是使预训练的模型具有视频字幕生成的能力。LR和mask language modeling之间的区别在于,LR从左到右生成句子,这意味着模型在预测下一个文本标记时只关注前一个文本token和视频token,损失函数如下所示:

其中是单词序列的ground truth,是mask版本。

3.6. Video Language Matching (VLM)

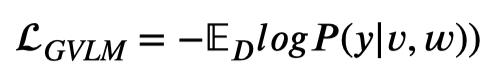

VLM的目标是学习视频和语言的对齐。VLM有不同的任务形式,我们将其分为1)全局视频语言匹配(GVLM)和2)局部视频语言匹配(LVLM)。

对于GVLM,一个目标函数来将特殊token [CLS]的隐藏状态带入FC层进行二分类。目标函数是:

其中,如果v和w匹配,y=1。另一种VLM是匹配两种模态的序列嵌入。具体地说,它将视频和语言的两个嵌入序列通过均值合并或线性转移转换为两个单一特征,然后通MIL-NCE迫使成对的样本接近,而推开不同样本的特征。这一目标通常用于多流结构的预训练模型,该模型不包含用于直接匹配预测的特殊token [CLS]。

另一种VLM的目标是在局部实现视频和语言的匹配,因此我们将其简称为LVLM(Local Video Language Match)。也就是说,通过点积计算查询视频匹配分数,其中q是从语言序列获得的查询。对匹配分数应用两个可训练的1D CNN,然后进行softmax操作,以获得两个概率向量,它们表示每个位置作为ground-truth跨度的起点和终点的概率。目标函数使用交叉熵损失,可以表示为:

3.7. Sentence Ordering Modeling (SOM)

SOM的目的是从顺序的角度学习文本token的关系。具体而言,选择15%的句子,随机分成3个片段,并随机打乱顺序。.因此,它可以建模为3!类的分类问题。具体来说,在多模态融合后,将特殊token[cls]嵌入FC层,然后进行softmax操作进行分类。总体目标函数是:

其中y是分段顺序的groundtruth,而是Shuffled的单词序列。

3.8. Frame Ordering Modeling (FOM)

FOM的核心思想是随机选择固定百分比的帧,并预测其原始顺序。VICTOR随机选择了15%的帧。每个压缩帧的嵌入通过FC层进行转换,然后对类进行softmax操作,其中是帧序列的最大长度。FOM可以概括为一个目标函数:

其中y是帧顺序的groundtruth,是帧顺序。

▊ 4.Video-Language Downstream Tasks

预训练的目标是通过迁移学习更好地将从大型语料库中学习到的知识应用于下游任务。视频语言的下游任务主要包括:Text-based Video Retrieval、Action Recognition、Action Segmentation、Action Step Localization、Video Question Answering、Video Captioning。

▊ 5. Video-Language Datasets

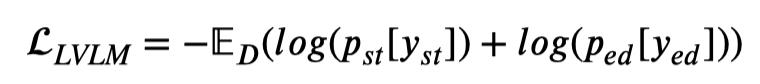

5.1. Label Based Datasets

基于标签的数据集是在视频级别带有标签的数据集。它们广泛用于分类任务,如动作识别。例如,HMDB51总共包含51个动作类别的6841个视频。UCF101、MPII Cooking、Kinetics系列和AVA是其他代表性数据集。

5.2. Caption Based Datasets

基于字幕的数据集要求对每个视频或视频片段进行描述。例如,Activitynet包括2万个YouTube未经剪辑的视频,其中有10万个手动字幕句子。每个标题描述了由开始和结束时间戳注释的相应视频片段的内容。

字幕是视频数据集的主要注释,有着广泛的应用。一方面,基于字幕的大规模数据集可用于视频语言预训练。例如,Howto100M是迄今为止最大的英语视频数据集,其中包含1.36亿个视频片段,并配有YouTube上的字幕。

5.3. Other Datasets

除了标题和标签注释外,其他类型的标注还用于其他下游任务。TVQA是一个基于6个热门电视节目的视频QA数据集,共有460小时的视频和152.5K对人类标注的QA。COIN设计用于综合教学视频分析,该分析采用三层结构,从领域、任务到步骤。

该数据集共包含11827个教学视频,包括12个领域、180项任务和778个预先定义的步骤。CrossTask包含从YouTube上抓取的4.7k教学视频,涉及83项任务。对于每个任务,都会提供一个带有简短描述的有序步骤列表。

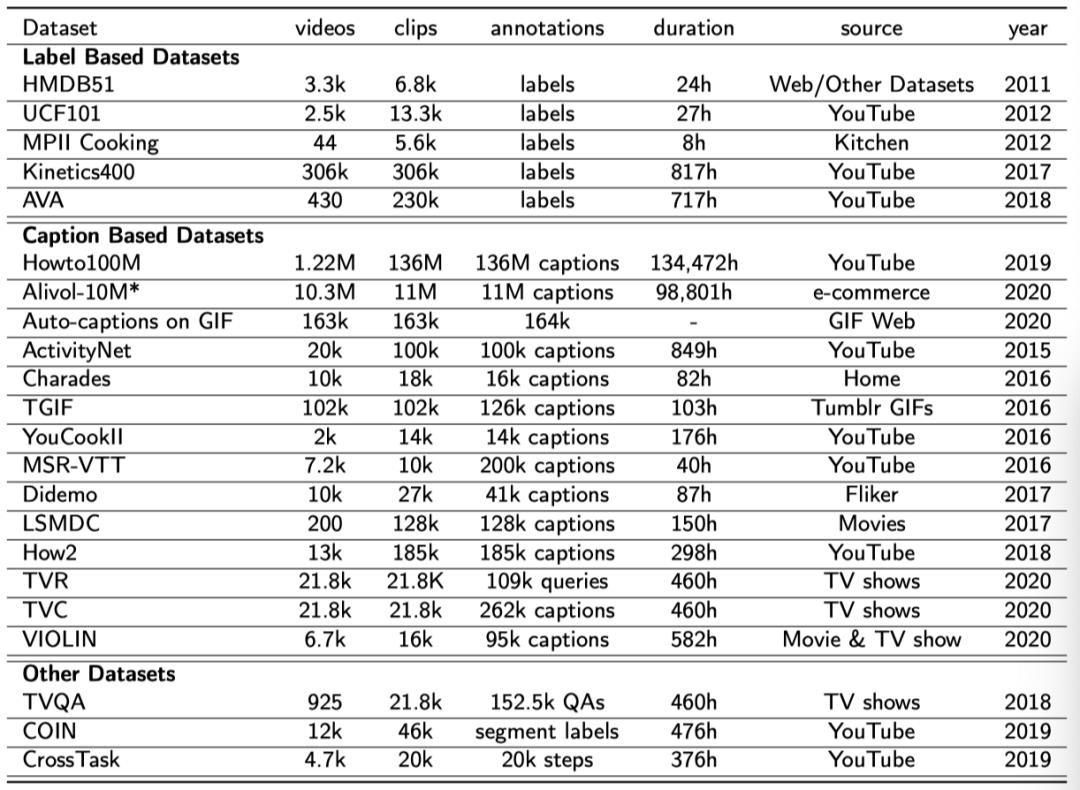

▊ 6. Video-Language Transformer Models

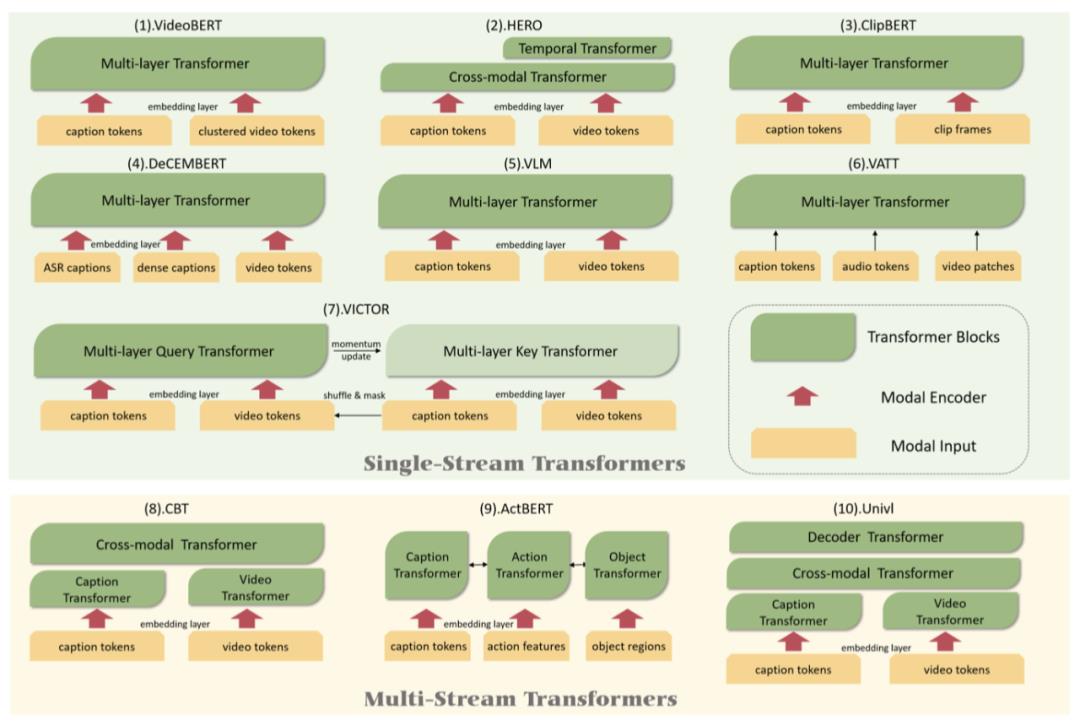

6.1. Single-Stream Structure

VideoBERT是第一个利用基于Transformer的预训练方法探索视频语言表达的人。它遵循单流结构,将原始的BERT结构移植到多模态域。具体地说,它将视频token和语言语句的组合输入到多层Transformer中,通过预测被mask的token来训练模型学习视频和文本之间的相关性。

为了将连续视频离散化为离散单词token,他们将视频切割成固定长度的小片段,并将标记聚类以构建视频词典。在预训练阶段,使用MLM、MFM和VLM代理任务对模型进行训练,对应于纯文本域、纯视频域和视频文本域的特征学习。

HERO包含一个来融合视频帧序列和相应句子的跨模态Transformer,以及从全局上下文学习上下文化视频嵌入的时间Transformer。HERO设计了LVLM(局部视频语言匹配)和FOM(帧顺序建模)的代理任务,考虑了视频的顺序性质。他们发现,基于文本的视频片段检索对domain gap更为敏感。

更具体地说,HERO分别使用ResNet和SlowFast提取2D和3D视频特征。跨模态转换以视频序列和文本序列的组合为输入,通过跨模态注意力学习语境化嵌入。视觉嵌入的输出被进一步输入到时间转换器中,以从全局视频上下文中学习语境化嵌入。

HERO在预训练阶段应用MLM、MFM、VLM和FOM的代理任务,并将其转移到视频检索、视频QA、视频和语言推理以及视频字幕的下游任务。消融研究表明,FOM可以有效地帮助完成依赖时间推理的下游任务(如QA任务),全局和局部对齐的VLM可以帮助完成检索任务。

ClipBERT是一个通用的视频文本表示学习框架,可以端到端的方式进行训练。ClipBERT的具体结构是单流,视频输入是单个片段的patch序列。2D主干为每个片段的T帧生成T视觉特征图后,时间融合层将帧级特征图聚合为单个片段级特征图。然后应用交叉Transformer将片段特征映射和文本序列结合起来,以捕获交叉模态关系。在推理过程中,当使用多个clip时,预测将融合在一起作为最终输出。

DeCEMBERT采用单流结构,使用类似于BERT的Transformer对视频特征、密集字幕和一组连续ASR字幕之间的关系进行编码。整个模型经过MLM、VLM任务的预训练,并在视频字幕、基于文本的视频检索和视频QA进行了微调。综合实验表明,DECEMBERT是一种改进的预训练方法,用于从噪声、未标记的数据集中学习。

VLM引入了两种新的mask任务方案:Masked Modality Modeling(MMM)和Masked Token Modeling(MTM)。VLM是在基于文本的视频检索、动作分割、动作step定位和videoQA等下游任务上进行评估的。

VATT(Video-Audio-Text Transformer)是一种端到端框架,用于从原始视频、音频和文本中学习多模态表示。VATT验证了大规模的自监督预训练是一个很有希望的方向,可以通过纯基于注意力的模型和端到端训练来学习多模态表征(视频、文本、音频)。

VICTOR是在中文视频语言数据集上训练的。VICTOR遵循单流模型结构,使用编码器Transformer获得交叉模态关系,使用解码器Transformer生成任务。此外,受MoCo的启发,VICTOR使用memory bank和动量更新扩展了负样本,以更好地进行对比学习,VICTOR还使用了记忆队列来保存负样本,以计算对比损失。

6.2. Multi-Stream Structure

CBT提出噪声对比估计(NCE)作为视频语言学习的损失目标,与视频中的vector quantization(VQ)和softmax损失相比,它保留了视频的细粒度信息。在预训练阶段,两个单模态Transformer通过对比学习分别学习视频和文本表示。第三个跨模态Transformer将两个模态序列组合在一起,计算它们的相似度,并通过NCE loss学习配对视频和句子的关系。

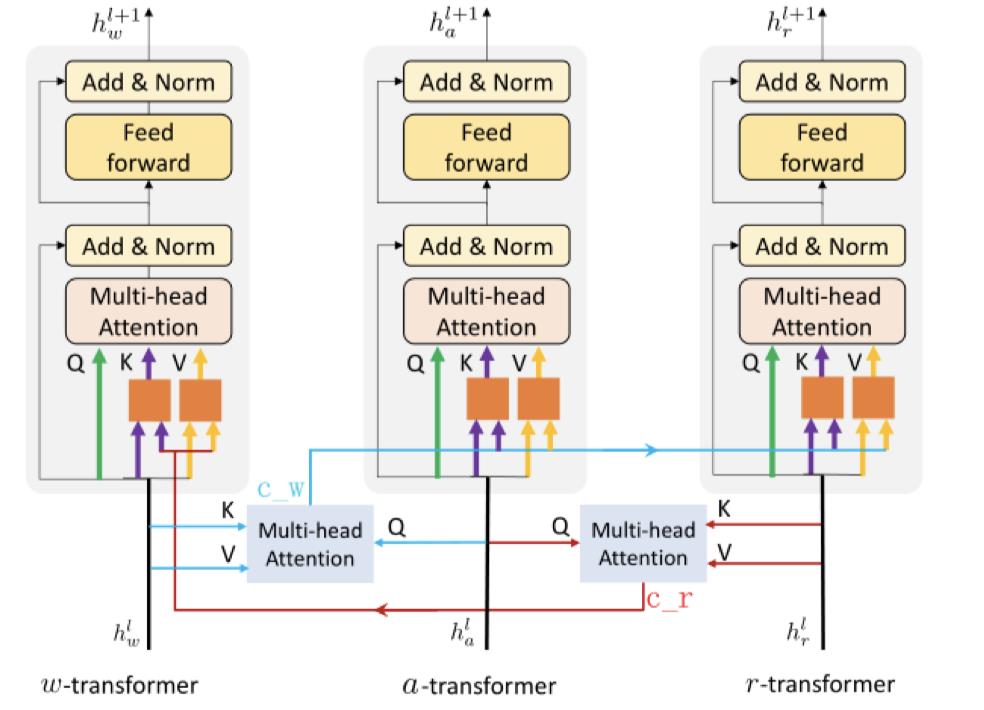

ActBERT是一种多流模型,带有Tangled Transformer块以增强通信,如上图所示。以前的多流结构总是使用一个额外的Transformer层来编码多模态信息的相互关系,而Tangled Transformer块使用共同注意Transformer层,即来自一个模态的key-value对可以通过到另一个模态。

Univl是第一个对理解和生成性代理任务进行预训练的模型。Univl遵循多数据流结构,其中包含两个分别嵌入视频和文本的单个Transformer编码器,一个用于完全交互文本和视频嵌入的跨模态Transformer,一个用于生成任务的解码器。

▊ 7. Conclusion

预训练已成为NLP中的一种流行方法,并在视觉任务中得到了进一步应用。与其他视觉语言预预训练工作相比,Video-Language的预训练作品较少。因此,本文对视频语言处理的预训练方法进行了全面概述。

尽管预训练在各种视频语言任务上都有明显的改善,但Transformer在视频语言上的潜力还没有得到充分的挖掘,还有几个亟待解决的问题:预训练数据集,Video-Language Transformer的设计和Transormer结构的运行效率。

▊ 作者简介

研究领域:FightingCV公众号运营者,研究方向为多模态内容理解,专注于解决视觉模态和语言模态相结合的任务,促进Vision-Language模型的实地应用。

知乎/公众号:FightingCV

END

欢迎加入「Transformer」交流群👇备注:TFM

一文读懂!最新Transformer预训练模型综述!

点击 机器学习算法与Python学习 ,选择加星标

精彩内容不迷路

机器之心报道

在如今的 NLP 领域,几乎每项任务中都能看见「基于 Transformer 的预训练语言模型(T-PTLM)」成功的身影。这些模型的起点是 GPT 和 BERT。而这些模型的技术基础包括 Transformer、自监督学习和迁移学习。T-PTLM 可使用自监督学习从大规模文本数据学习普适性的语言表征,然后将学到的知识迁移到下游任务。这些模型能为下游任务提供优质的背景知识,从而可避免从头开始训练下游任务。

这篇详尽调查 T-PTLM 的综述论文首先将简要介绍自监督学习。接下来将解释多个核心概念,包括预训练、预训练方法、预训练任务、嵌入和下游任务适应方法。接下来,文章将为 T-PTLM 给出一种新的分类方法,然后简要介绍多种不同的基准,包括内部基准和外部基准。研究者还归纳总结了一些适用于 T-PTLM 的软件库。最后讨论了一些可能有助于进一步改进这些模型的未来研究方向。

论文地址:https://arxiv.org/pdf/2108.05542.pdf

研究者相信,这篇全面详尽的综述论文能作为一份很好的参考资料,帮助读者了解 T-PTLM 的相关核心概念和近期研究进展。

引言

基于 Transformer 的预训练语言模型(T-PTLM)具备从大规模无标注文本数据学习通用语言表征并将所学知识迁移到下游任务的能力,因此已经在 NLP 领域取得了巨大的成功,这类模型包括 GPT-1、BERT、XLNet、RoBERTa、ELECTRA、T5、ALBERT、BART 和 PEGAUSUS。在更早期,NLP 系统大都采用了基于规则的方法,之后取而代之的是机器学习模型。机器学习模型需要特征工程,而特征工程又需要领域专业知识并且需要较长的时间。

随着 GPU 等更好的计算机硬件以及 Word2Vec 和 Glove 等词嵌入方法的出现,CNN 和 RNN 等深度学习模型在构建 NLP 系统方面得到了更广泛的应用。这些深度学习模型的主要缺点是除了词嵌入之外,需要从头开始训练模型。从头开始训练这类模型需要大量有标注实例,而生成这些实例的成本很高。但是,我们希望仅使用少量有标注实例来获得表现良好的模型。

迁移学习让我们可以将在源任务上学习到的知识很好地复用到目标任务上。在这其中,目标任务应该与源任务相似。基于迁移学习的思想,计算机视觉领域的研究者已在使用 ImageNet 等大规模有标注数据集来训练大型 CNN 模型。这些模型学习到的图像表征对所有任务来说都是普适的。然后,这些大型预训练 CNN 模型可以适应下游任务,具体做法是添加少数特定于任务的层,然后在目标数据集上进行微调。由于预训练 CNN 模型能为下游模型提供很好的背景知识,因此它们在许多计算机视觉任务上取得了巨大的成功。

CNN 和 RNN 等深度学习模型难以建模长期上下文以及学习具有局部性偏差(locality bias)的词表征。此外,由于 RNN 按顺序处理输入(逐词处理),因此只能有限度地使用并行计算硬件。为了克服现有深度学习模型的这些缺点,Vaswani et al. 提出了完全基于自注意力的深度学习模型:Transformer。相比于 RNN,自注意力支持更高度的并行化,并且还能轻松地建模长期上下文,因为输入序列中的每个 token 都会关注其它所有 token。

Transformer 包含一些堆叠的编码器和解码器层。在堆叠编码器和解码器层的帮助下,Transformer 可以学习到复杂的语言信息。在 NLP 领域,生成大量有标注数据的成本非常高,也非常耗时。但是,大量无标注文本数据却很容易获得。在计算机视觉社区使用基于 CNN 的预训练模型所取得的成功的感召下,NLP 研究社区将 Transformer 和自监督学习的能力组合到一起,开发出了 T-PTLM。自监督学习让 Transformer 可以使用由一个或多个预训练任务提供的伪监督进行学习。

GPT 和 BERT 是最早的 T-PTLM,它们分别是基于 Transformer 解码器和编码器层开发的。之后,又诞生了 XLNet、RoBERTa、ELECTRA、ALBERT、T5、BART 和 PEGAUSUS 等模型。其中,XLNet、RoBERTa、ELECTRA 和 ALBERT 是基于 BERT 的改进模型;T5、BART 和 PEGAUSUS 是基于编码器 - 解码器的模型。

Kaplan et al. 表明只需增加 T-PTLM 模型的规模就能带来性能的提升。这一发现推动了大规模 T-PTLM 的发展并催生了 GPT-3 (175B)、PANGU (200B)、GShard (600B) 等包含上千亿参数的模型,而 Switch-Transformers (1.6T) 的参数量更是达到了万亿级。

T-PTLM 在通用英语领域取得成功之后,又开始进军其它领域,包括金融、法律、新闻、编程、对话、网络、学术和生物医学。T-PTLM 还支持迁移学习,即通过在目标数据集上进行微调和即时调整,可让这些模型适用于下游任务。本文将全面回顾与 T-PTLM 有关的近期研究成果。这篇综述论文的看点总结如下:

第 2 节将简单介绍自监督学习,这是 T-PTLM 的核心技术。

第 3 节将介绍与 T-PTLM 相关的一些核心概念,包括预训练、预训练方法、预训练任务、嵌入和下游适应方法。

第 4 节将给出一种针对 T-PTLM 的新型分类法。这种分类法考虑了四大方面,即预训练语料库、架构、自监督学习类型和扩展方法。

第 5 节将给出一种针对不同下游适应方法的新型分类法并将详细解释每个类别。

第 6 节将简要介绍多种用于评估 T-PTLM 进展的基准,包括内部基准和外部基准。

第 7 节将给出一些适用于 T-PTLM 的软件库,从 Huggingface Transformers 到 Transformer-interpret。

第 8 节将简单讨论一些可能有助于进一步改进这些模型的未来研究方向。

自监督学习(SSL)

监督学习的缺点总结如下:

严重依赖人类标注的实例,而获取这些实例耗时费力。

缺乏泛化能力,容易出现虚假相关的问题。

医疗和法律等许多领域缺乏有标注数据,这会限制 AI 模型在这些领域的应用。

难以使用大量免费可用的无标注数据进行学习。

SSL 与监督学习和无监督学习等其它流行学习范式具有一些相似性。SSL 与无监督学习的相似之处是它们都不需要人类标注的实例。但是,它与无监督学习也有不同之处:a) SSL 需要监督,而无监督学习没有监督;b) 无监督学习的目标是识别隐藏模式,而 SSL 的目标是学习有意义的表征。SSL 与监督学习的相似之处是学习范式时都需要监督。但是,它与监督学习也有不同之处:a) SSL 会自动生成标签,而无需任何人类干预;b) 监督学习的目标是提供特定于任务的知识,而 SSL 的目标是向模型提供通用知识。

SSL 的目标总结如下:

学习通用语言表征,这能为下游模型提供优良的背景。

通过学习大量免费可用的无标注文本数据来获得更好的泛化能力。

自监督学习可大致分为生成式 SSL、对比式 SSL 和对抗式 SSL 三种。

T-PTLM 核心概念

预训练

预训练能带来以下一些优势:

通过利用大量无标注文本,预训练有助于模型学习通用语言表征。

只需增加一两个特定的层,预训练模型可以适应下游任务。因此这能提供很好的初始化,从而避免从头开始训练下游模型(只需训练特定于任务的层)。

让模型只需小型数据集就能获得更好的表现,因此可以降低对大量有标注实例的需求。

深度学习模型由于参数数量大,因此在使用小型数据集训练时,容易过拟合。而预训练可以提供很好的初始化,从而可避免在小型数据集上过拟合,因此可将预训练视为某种形式的正则化。

预训练的步骤

预训练一个模型涉及以下五个步骤:

准备预训练语料库

生成词汇库

设计预训练任务

选择预训练方法

选择预训练动态

预训练语料库

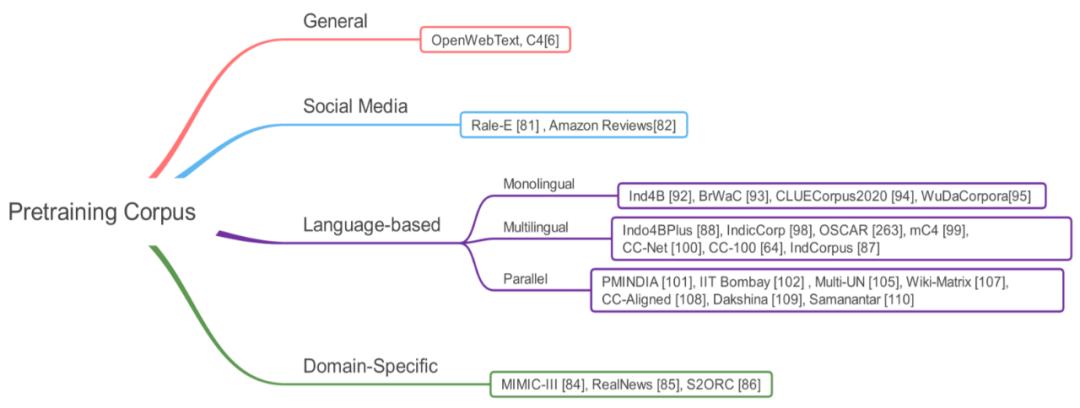

图 1:预训练语料库

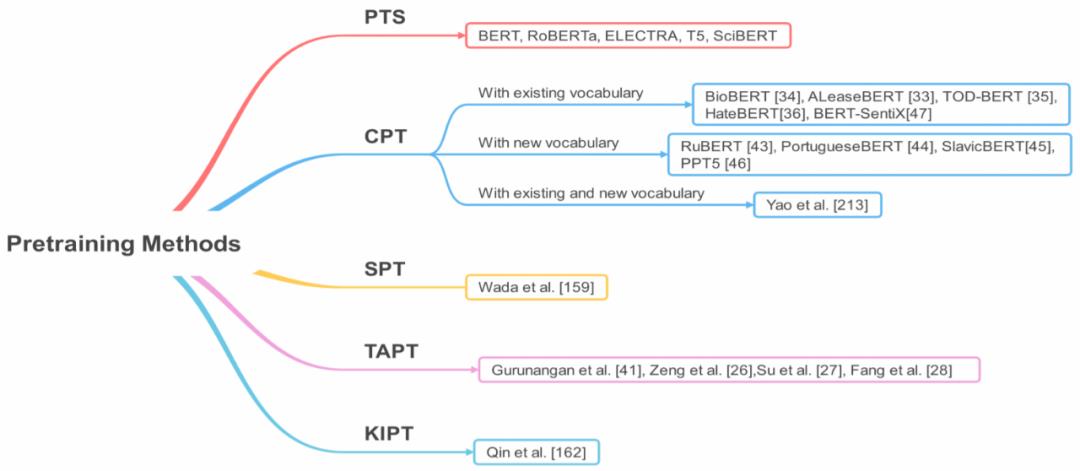

图 2:预训练方法,其中 PTS 是从头开始型预训练、CPT 是持续型预训练、SPT 是同时型预训练、TAPT 是任务自适应型预训练、KIPT 是知识继承型预训练

预训练任务

闲聊语言建模(CLM)

掩码语言建模(MLM)

替代 token 检测(RTD)

混洗 token 检测(STD)

随机 token 替换(RTS)

互换语言建模(SLM)

翻译语言建模(TLM)

替代语言建模(ALM)

句子边界目标(SBO)

下一句子预测(NSP)

句子顺序预测(SOP)

序列到序列语言模型(Seq2SeqLM)

去噪自动编码器(DAE)

嵌入

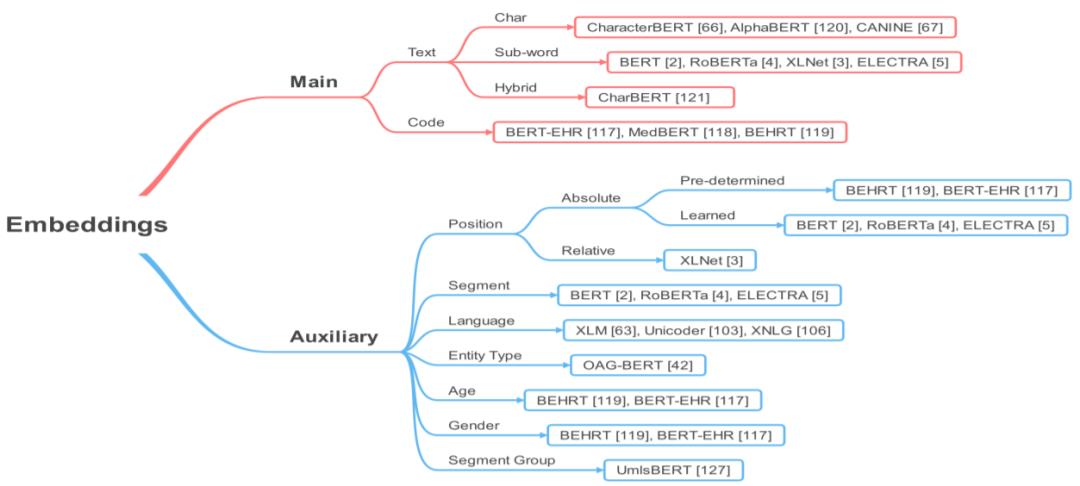

图 8:T-PTLM 中的嵌入

分类法

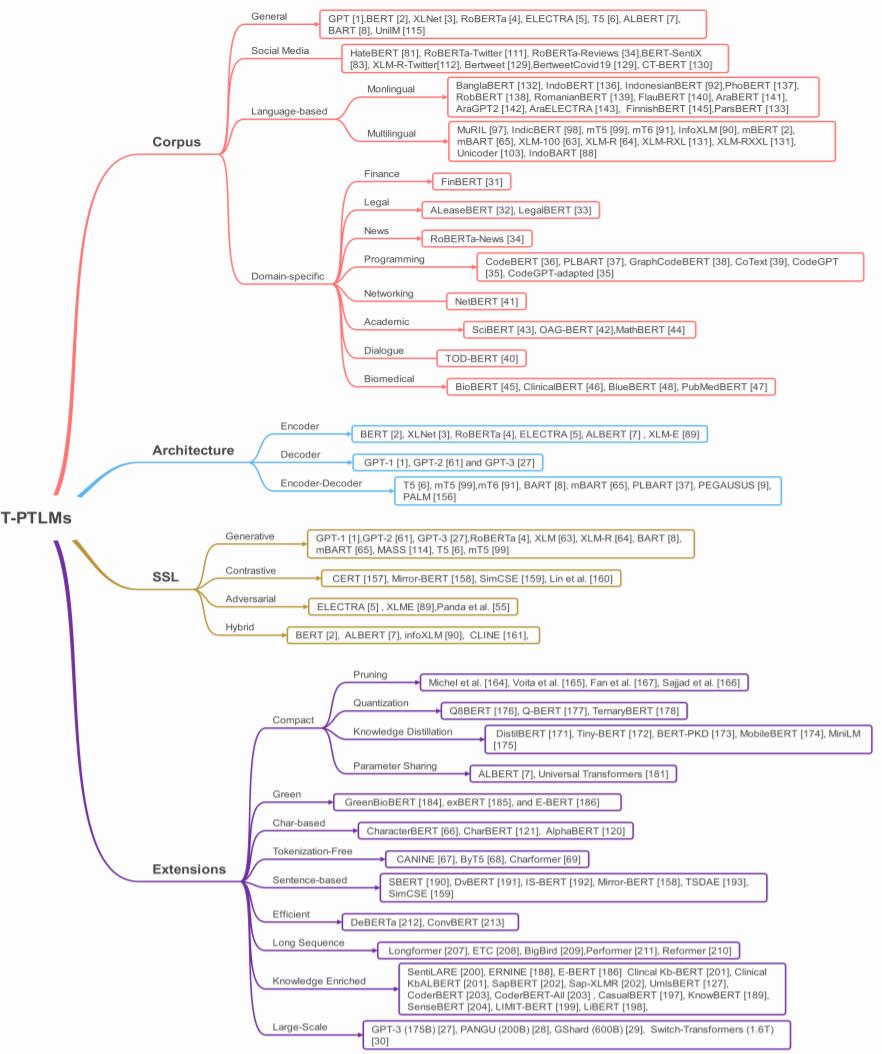

为了了解以及跟踪各种 T-PTLM 的发展,研究者从四个方面对 T-PTLM 进行了分类,即预训练语料库、模型架构、SSL 类型和扩展方法。如下图 9 所示:

图 9:T-PTLM 的分类法。

下游适应方法

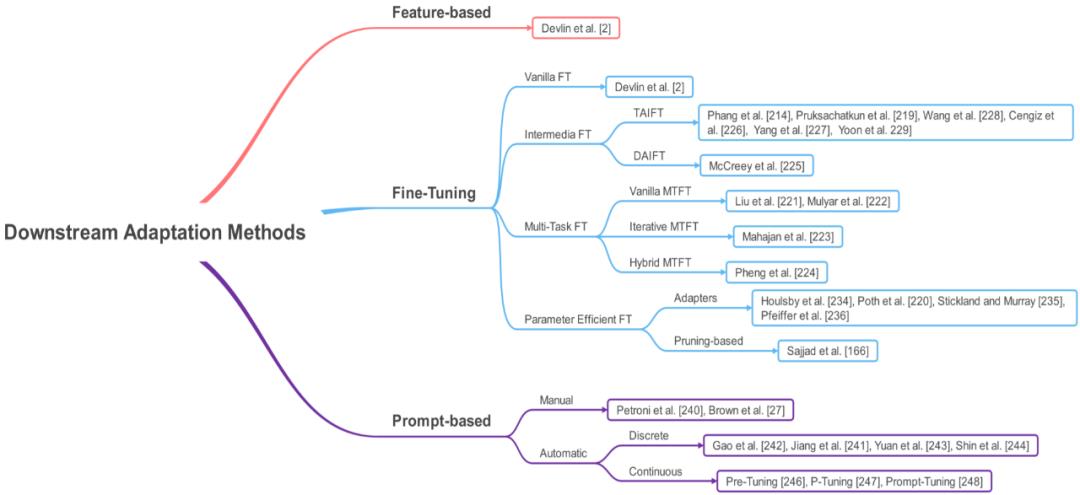

一旦完成语言模型的训练,就可将其用于下游任务了。将预训练后的语言模型用于下游任务的方式有三种:基于特征的方法、微调和基于提示的微调(prompt-based tuning)。

如下图 10 所示,基于特征的方法涉及到根据语言模型生成上下文的词嵌入,然后在针对特定下游任务的模型中将它们用作输入特征。微调涉及到根据下游任务,通过尽量降低针对特定任务的损失来调整模型权重。

图 10:下游适应方法。

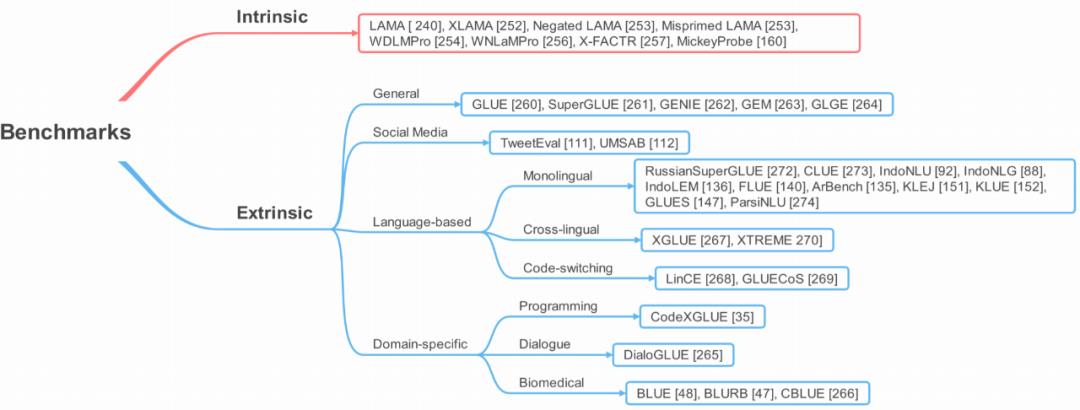

评估

在预训练阶段,T-PTLM 会获取预训练语料库中编码的知识。这里的知识包括句法、语义、事实和常识。对于 T-PTLM 的效果,评估方式有两种,即内在方式和外在方式。见下图 11。

内在评估方式是通过探测 T-PTLM 中编码的知识进行评估,而外在评估方式则是评估 T-PTLM 在真实世界下游任务中的效果如何。内在评估方式可让我们了解 T-PTLM 在预训练阶段获得的知识,这有助于我们设计更好的预训练任务,使得模型可以在预训练阶段学习到更多知识。

图 11:用于评估 T-PTLM 研究进展的基准。

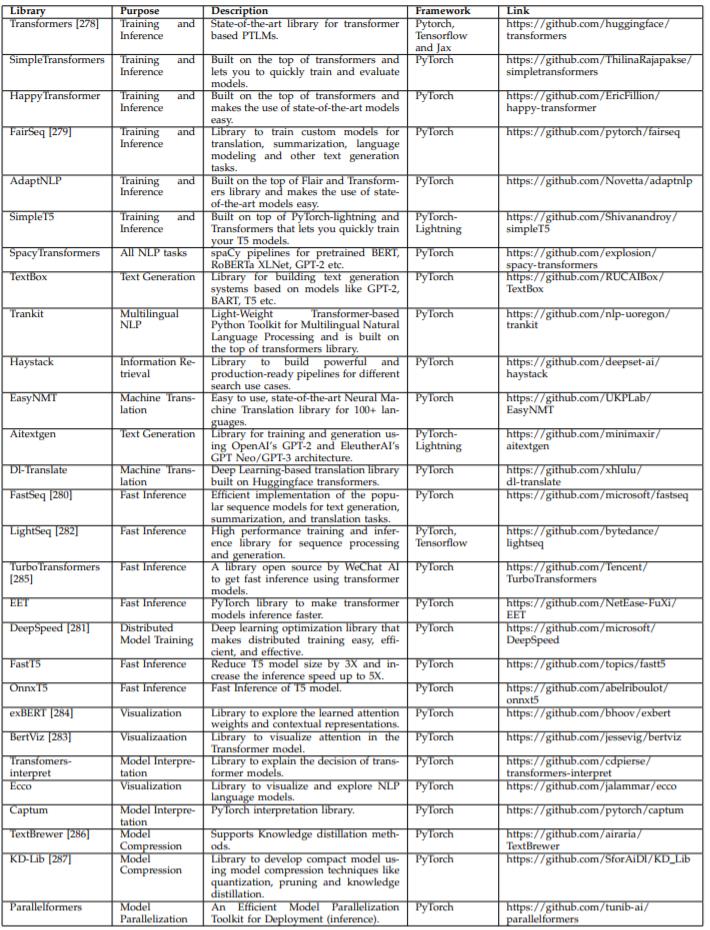

有用的软件库

研究者还归纳总结了一些适用于 T-PTLM 的常用软件库。其中,Transformers 和 Fairseq 等软件库适用于模型训练和评估。SimpleTransformers、HappyTransformer、AdaptNLP 等则构建于 Transformer 软件库之上,可让用户仅使用少量代码就实现更轻松的训练和评估。FastSeq、DeepSpeed、FastT5、OnnxT5 和 LightSeq 等则可用于提升模型的推理速度。Ecco、BertViz 和 exBERT 都是可视化分析工具,可用于探索 Transformer 模型的层。Transformers-interpret 和 Captum 则能用于解释模型决策。

表 11:适用于 T-PTLM 的软件库。

讨论和未来方向

更好的预训练方法

仅使用 SSL 来训练模型(尤其是带有成千上万亿参数的大模型)的成本非常高。知识继承型预训练(KIPT)等全新的预训练方法涉及到 SSL 和知识蒸馏。SSL 让模型可以学习预训练语料库中可用的知识,而知识蒸馏则让模型可以学习已经编码在已有预训练模型中的知识。由于在通过知识蒸馏的预训练阶段,模型可获得额外的知识,因此 a) 模型可以更快速地收敛并由此缩短预训练时间,b) 相比于仅使用 SSL 预训练的模型,在下游任务上的表现会更好。研究社区必须重点关注开发 KIPT 等更好的预训练方法,让模型获得更多知识以及降低预训练时间。

样本高效型预训练任务

如果一个预训练任务能最大化地利用每个训练实例,那么就可以说该预训练任务是样本高效的,即它应该能在训练实例中的所有 token 上获得定义。样本高效型预训练任务能使预训练的计算效率更高。最常用的预训练任务 MLM 的样本效率就不太高,因为其仅涉及到一个 token 子集,即掩码 token,其占总 token 数的 15%。RTD、RTS 和 STD 等预训练任务可被视为是开发样本高效型预训练任务的早期尝试。这三种预训练任务都定义在每个训练实例的所有 token 之上,即它们涉及到识别每个 token 是否被替代、随机替换或混洗。未来应该还将出现使计算效率更高的样本高效型预训练任务。

高效模型

由于模型尺寸较大并且需要大量无标注的文本数据,因此预训练 T-PTLM 的成本也很高。但是,较长的预训练时间对环境并不友好,因为这个过程会释放二氧化碳;而在生物医学等许多领域,也没有大规模的无标注文本数据。近期,在 BERT 模型基础上进行全新改进的 DeBERTa 等模型实现了比 RoBERTa 模型更好的性能,尽管其仅使用了 78 GB 数据进行预训练,这只是预训练 RoBERTa 模型所用的数据量的一半。类似地,ConvBERT 凭借全新的混合注意力模块,仅使用 ELECTRA 模型四分之一的预训练成本就取得了更优的表现。为了降低预训练的数据量和训练成本,人们需要 DeBERTa 和 ConvBERT 这样的高效模型。

更好的位置编码机制

自注意力机制是置换不变型的方法,不存在位置偏差。使用绝对或相对位置嵌入,可以提供位置偏差。此外,绝对位置嵌入可以预先确定或学习到。但是,这两种方法各有优缺点。绝对位置嵌入会有泛化问题,但却很容易实现。不同于绝对位置,相对位置嵌入能稳健地应对序列长度变化,但却难以实现,性能也更差。我们还需要全新的位置编码机制,比如 CAPE,其将绝对和相对位置嵌入的优势组合到了一起。

改进现有的 T-PTLM

BERT 和 RoBERTa 等 T-PTLM 已经在许多 NLP 任务上取得了优良的结果。近期的研究表明,通过基于对抗或对比预训练任务的持续预训练注入句子层级的语义,还可以进一步改进这些模型。举个例子,Panda et al. 表明使用混洗 token 检测目标的持续预训练可提升 RoBERTa 模型在 GLUE 任务上的性能,因为其允许模型学习更连贯的句子表征。类似地,使用对比预训练目标的持续性预训练可以提升 T-PTLM 在 GLUE 任务上的性能以及多语言 T-PTLM 在 Mickey Probe 上的表现。为了将其扩展到其它单语言和特定领域的 T-PTLM,还需要进一步的研究。

超越朴素的微调

为了将预训练模型用于下游任务,微调是最常用的方法。但是,朴素的微调的主要缺点是其会改变预训练模型中的所有层,因此我们需要为每个任务维持另一个副本,这会增加部署成本。为了以一种参数高效的方式将预训练模型用于下游任务,人们提出了 Adapters 和基于剪枝的微调等方法。

举个例子,adapter 是添加到每个 Transformer 层的针对特定任务的小层。而在下游任务适应期间,仅更新 adapter 层的参数,Transformer 层的参数保持不变。此外,Poth et al. 表明 adapter 也可用于中间微调。近期,基于提示的微调(prompt-based tuning)方法在参数效率方面取得了明显更优的表现,并得到了研究社区的关注。举个例子,Prefix-tuning 等基于提示的微调方法仅需要 0.1% 的针对特定任务的参数,而基于 adapter 的微调则需要 3% 的针对特定任务的参数。

基准评测

在最后四层中,人们引入了很多基准来评估通用型和领域特定型预训练模型的进展。除了英语之外,也出现了一些用于评估其它单语言和多语言模型进展的基准。但是,现有的基准不足以覆盖所有场景。举个例子,还没有基准用于评估 a) 紧凑预训练模型的进展,b) 预训练模型的稳健性,c) 针对社交媒体以及学术等专业领域开发的 PTLM。

近日,Explainboard 等排行榜不再只是使用已有基准等单一指标评估进展,也会深挖或分析模型的长项和短板。这类排行榜应该也能扩展到其它领域。此外,FewGLUE、FLEX 和 FewCLUE 等评估少量次学习技术的基准也应当扩展到其它语言和领域。

紧凑模型

T-PTLM 几乎在每种 NLP 任务上都获得了最佳表现。但是,这些模型都很大,需要更大的存储空间。因为这些模型的层数很多,因此输入需要一定时间才能完全通过模型,从而得到预测结果,因此延迟很高。而真实世界应用的资源有限,需要更低的延迟,因此剪枝、量化、知识蒸馏、参数共享和分解等模型压缩方法已经在英语通用领域应用方面得到了探索。研究这些模型压缩方法在其它语言和领域的应用具有很大的前景。

对噪声的稳健性

T-PTLM 容易受到噪声影响,其中包括对抗噪声和自然噪声。其主要原因是使用了子词嵌入。在使用子词嵌入时,一个词会被分解为多个子词 token,因此即使很小的拼写错误也可能改变该词的整体表征,进而阻碍模型学习并影响模型预测。为了提升模型对噪声的稳健性,CharacterBERT 等模型采用了只使用字符嵌入的方法,而 CharBERT 等模型则会将字符嵌入和子词嵌入一起使用。这两种方法都能提升对噪声的稳健性。

近期,研究者们还提出了 CANINE、ByT5 和 Charformer 等无 token 化模型来提升对噪声的稳健性。为了让这些模型能在真实世界中得到应用,尤其是在医学等敏感领域,我们需要提升它们的稳健性。

全新的适应方法

为了将通用模型适应到生物医学等专业领域或将多语言模型适应到特定语言,常用的策略是使用持续性预训练。尽管这种方法通过调整模型以适应特定的领域或语言能得到良好的结果,但如果缺少领域或语言特定的词汇库,下游模型的性能会受到影响。近期有研究者提出了扩展词汇表然后持续预训练的方法。这些方法能克服 OOV 词的问题,但由于会在词汇表中增加新词,因此会增大词汇表的规模。近日,Yao et al. 提出了 Adapt and Distill 方法,即使用词汇表扩展和知识蒸馏来使通用模型适应特定领域。不同于已有的适应方法,该方法不仅能让通用模型适应特定领域,而且还能减小模型的规模。这一注意值得进一步研究并有望产出全新的适应方法。

隐私问题

T-PTLM 已经在许多 NLP 任务上取得了优良的结果。但是,这些模型也存在一些超出预期且并无益处的风险。举个例子,数据泄露是人们担心的一个主要问题,尤其是当这些模型的预训练使用了隐私数据时。由于模型是在大量文本数据上预训练的,因此有可能从中恢复敏感信息,比如可识别出个人身份的信息。因此,需要防止人们公开发布使用隐私数据预训练的模型。

近日,Carlini et al. 研究表明,GPT-2 模型可生成一个人的完整邮政地址,这些地址包含在训练数据中,可使用该人的名字通过提示得到。近期出现在生物医学领域的 KART 框架可通过执行多种攻击来评估数据泄露情况。研究社区需要开发更复杂的攻击来评估数据泄露情况并开发防止预训练模型泄露敏感数据的方法。

降低偏见

基于深度学习的方法正在现实世界中得到越来越广泛的应用,其中包括在生物医学和法律等专业领域。但是,这些模型很容易学习并放大训练数据中已有的偏见。由此造成的结果是:这些模型会产生对特定种族、性别或年龄群体的偏见。我们完全不需要这样的模型。

近期出现了一些重点关注识别和降低偏见的研究。比如,Minot et al. 提出了一种用于减少性别偏见的数据增强方法,Liang et al. 提出的 A-INLP 方法可以动态地识别偏见敏感型 token。在这一领域进行进一步研究有助于降低预训练模型中的偏见并帮助它们做出公平的决定。

降低微调不稳定性

为了让预训练模型适应下游任务,最常用的方法是微调。尽管微调的表现不错,但它并不稳定,即使用不同随机种子来执行微调会令下游表现差距巨大。有人认为,微调不稳定的原因包括灾难性遗忘和数据集规模较小。但是,Mosbach et al. 表明这两个原因都不是微调不稳定的原因,并进一步表明微调不稳定的原因包括:a) 优化困难,导致梯度消失,b) 泛化问题。为了降低微调不稳定,可能的解决方案包括:a) 中间微调,b) 混合(mix-out),c) 在早期 epoch 采用更小的学习率并且增多微调 epoch 的次数,d) 同时使用监督式对比损失和交叉熵损失。让微调更稳定的方法值得进一步研究。

觉得不错,请点个在看呀以上是关于综述基于Transformer的视频语言预训练的主要内容,如果未能解决你的问题,请参考以下文章