论文笔记旋转图像验证码角度识别-深度学习

Posted ZSYL

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了论文笔记旋转图像验证码角度识别-深度学习相关的知识,希望对你有一定的参考价值。

论文题目:一种面向旋转图像验证码识别的改进网络模型研究与实现

深度学习

深度学习是计算机模拟了人们获取特定类别认知的方法。主要涉及统计分析和预测模型。

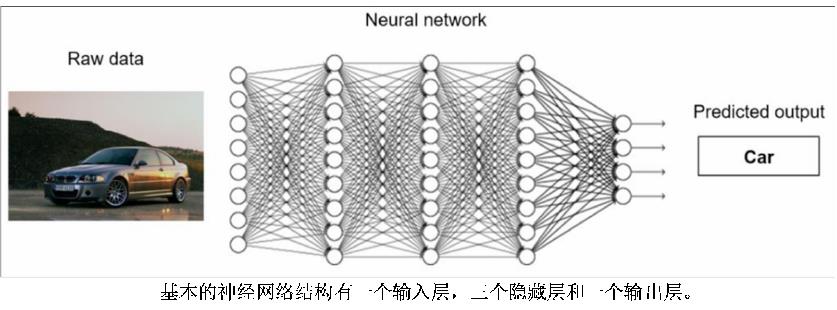

神经网络学习在学习过程中对输入数据特征进行非线性的处理,使用所学到的特征来创建一个参数模型预测输出,在学习过程中反复进行学习不断更新参数,直到准确率达到一个满意的水平。

神经网络被组织成相互连接的人工神经元层。简单地说,每一层都接受前一层的输出,应用一些转换,并将其输出发送到下一层。第一层的输入连接到神经网络想要处理的原始数据(图像、文本等),网络的最后一层的输出是任务需要预测的东西。

神经网络中的每个连接都有一个与之相关的数字权重。这些权重是神经网络的内部状态,负责在每一层计算的不同特征。为使神经网络(或任何机器学习算法)发挥作用,需要被不断训练。

在训练过程的开始,权重是随机初始化的,所以网络会做出随机预测。在训练过程中,网络被输入大量的标记数据,并使用预测误差(预测输出和真实输出之间的误差)来更新其权重。

随着训练的进行,权重被更新以产生更好的特征,帮助网络做出更好的预测。

计算预测误差的函数通常被称为损失函数,用于计算训练期间每个权重的更新的算法被称为反向传播。

在训练期间,网络的学习效果在未用于训练的数据子集上的性能是很重要的。这是因为机器学习算法往往在其训练过的数据上表现更好。通过定期对未见过的数据进行测试,可以确保网络对训练集以外的数据有良好的概括性。用于此的数据子集通常被称为验证集。

将有标签的数据集的神经网络任务称为有监督学习,将没有标签的数据集任务成为无监督学习,而没有标签的数据集自行创造标签的学习任务为自监督学习。

卷积层:这是卷积神经网络中执行大部分非线性计算的层的类型,通常用于提取图像特征。

卷积核是小的二维窗口,在图像的所有空间位置上滑动,以计算一个特定的特征。

池化层:这种类型的层对其输入进行降采样。与卷积层类似,池化层由小的滑动核组成,它只是对空间区域进行平均(平均池化)或取最大值(最大池化)。

下采样通常用于卷积神经网络,以减少连续层中的权重数量,这反过来又降低了其计算复杂性。

池化层是不可训练的,因为没有任何权重。一些层后面通常有激活函数,这些函数应用于层中的每个神经元,以决定是否活跃(如果一个神经元的输出大于零,它就是活跃的)。

激活函数负责为网络提供非线性行为。

Dropout 层:在神经网络里面也会出现过拟合的情况,过拟合指的是模型在训练数据上损失小,预测准确性高,但是在测试数据上损失很大,预测准确性低。即网络在训练集上表现很好时,但在测试集上却表现得很不好。Dropout 就是被用来防止过拟合。

Dropout 也可以认为是一种模型的平均,拥有以下三个优点:

- (1) 减少了神经元间的复杂的共适应性

- (2) 由于每一次都是随意地删掉节点,所以下一次节点的输出就不再那么依赖上一次节点,也是说在分派权重时,并没有向上面的某一种结点非配太多的权重,从而发挥了与 L2 正则化压缩权重一样的效果。

归一化层:归一化层也属于网络结构中的一层。归一化也是网络的一层,也可以叫它规范化。

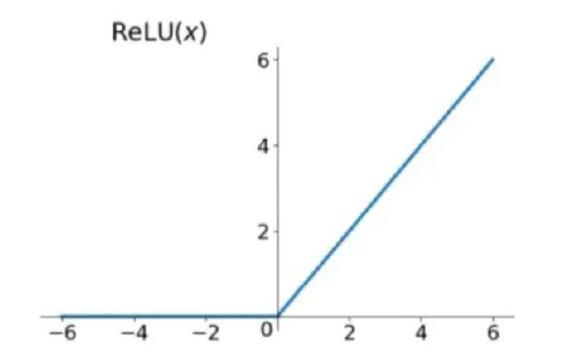

Relu 函数:Relu 是线性整流函数,又称修正线性单元,是一种人工神经网络中常用的非线性激活函数,其原理公式的表达形式如下:

Relu 其实就是个取最大值的函数。

Sigmoid 函数:Sigmoid 函数是一个种常用的 S 型函数,也称为 S 型曲线。将变量映射到 0,1 之间。

Softmax 函数:在数学尤其是概率论和相关领域中叫做归一化指数函数,

softmax 函数将输入的值映射成(0,1)的值,每个元素的大小即为其概率,最后选出输出结果的时候,可以选取概率最大的那个元素作为输出目标。

加油!

感谢!

努力!

以上是关于论文笔记旋转图像验证码角度识别-深度学习的主要内容,如果未能解决你的问题,请参考以下文章