公共大数据集群中如何配置 YARN 的公平调度器和容量调度器

Posted 明哥的IT随笔

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了公共大数据集群中如何配置 YARN 的公平调度器和容量调度器相关的知识,希望对你有一定的参考价值。

公共大数据集群中如何配置 YARN 的公平调度器和容量调度器

1 YARN 资源管理框架与公平/容量调度器

作为一款资源调度框架,Yarn 支持可插拔的调度器,常见的调度器有公平调度器 fair scheduler 和容量调度器 capacity scheduler。常见的大数据发行版中,CDH 集成的是公平调度器,CDP/HDP集成的是容量调度器。

在实际使用过程中,为充分利用资源,一般多个大数据应用会公用一个大数据集群,此时集群管理员会将YARN资源划分到若干个队列中并为不同队列配置不同的资源额度,然后不同的业务根据其业务特征和重要性,提交作业到集群管理员规定的 YARN 队列中。

笔者遇到过不少因为 YARN 集群队列资源配置不当,造成业务作业获取不到资源而执行失败的情况,所以在此跟大家分享下集群管理员配置YARN调度器时的常见注意事项。

2 公平/容量调度器配置原则概述

为保证各个业务的 SLA 并兼顾集群资源的高效使用,不管使用公平调度器还是容量调度器,管理员在配置YARN调度器时,都需要遵循以下原则:

- 管理员需要根据集群支撑的所有业务应用的重要性/资源需求量/运行时间等多种特征,将 YARN 集群整体资源按比例划分到不同的队列中,并要求业务应用提交到对应的YARN队列中;

- 为确保不同应用运行在对应的 YARN 队列中,管理员可以统一配置放置规则基于作业提交用户的身份映射到对应队列中,也可以由业务应用显示指定队列(结合事后的审计 audit 确保队列使用正确);

- 为不同队列指定资源配额时,公平调度器通过指定权重 weight 来指定资源配合(YARN会根据不同不同队列的 weight 自动计算出队列的资源配额);而容量调度器可以直接指定资源配额;

- 队列的资源配额是静态的软限制,是长期来看各个队列能够获得的资源比;

- 为了更高效地使用集群资源,管理员还可以指定队列的最小和最大资源,两者都是硬限制,其中最小资源数是为了确保本业务的 SLA,而最大资源数是为了不影响其它业务;

- 为防止同一个队列下同时提交大量作业时相互争抢资源都得不到足够的资源,可以通过参数控制队列中作业的最大并发数;

- 为防止同一个队列下所有 application master 占据大量资源而没有足够的资源分配给 executor 来执行任务,可以通过参数限制 am 的资源比;

- 还可以配置 preemption 抢占策略,以允许某个队列在其实际获得的资源没有达到其资源配额时,抢占其它队列的超过其资源配额的资源(可能会kill该队列下的 container容器);

有些大数据集群的某些YARN队列具有明显的潮汐特征,即这些队列每天大部分时候都是空闲的,但在特定的时间段内,YARN 客户端会在短时间内提交大量作业申请大量容器资源,此时考虑到YARN队列的冷启动问题和YARN高并发下的性能问题,对于公平调度器,集群管理员可以调整以下参数,确保YARN队列能及时获得足够的资源:

- 为提高YARN在高并发下响应客户端请求并分配资源容器的响应速度,可以调整以下参数,该调整需要重启 YARN 集群:

- yarn.scheduler.fair.assignmultiple (默认 false,可以调整为 true);

- yarn.scheduler.fair.dynamic.max.assign (默认 true,不用调整);

- yarn.scheduler.fair.max.assign (默认 -1,不用调整);

- yarn.scheduler.fair.update-interval-ms(默认 500ms,不用调整)

- 为应对队列冷启动问题,可以为相应的YARN队列配置较高的权重,较高的权重可以加快队列运行作业时从0到获得足够资源的时间(该调整是动态调整,不需要重启集群);

3 如何排查调度器资源配置引起的业务问题

当业务作业因为调度器资源配置不当而运行失败时,一般需要查看以下信息以分析问题:

- 检查作业报错信息,比如可以查看 rm web ui 中该作业的 Diagnostics 信息,Hive 作业的话需要查看 hs2 日志,还需要查看作业的日志(开启了日志聚合的话,可以使用命令 yarn logs -applicationId xxx);

- 检查 YARN 队列的静态配置信息,比如通过 CDH 的动态资源池页面或 CDP 的 Yarn Queue manager UI 页面;

- 检查作业执行期间 YARN 队列的动态状态,比如检查 yarn web ui 的调度器页面;

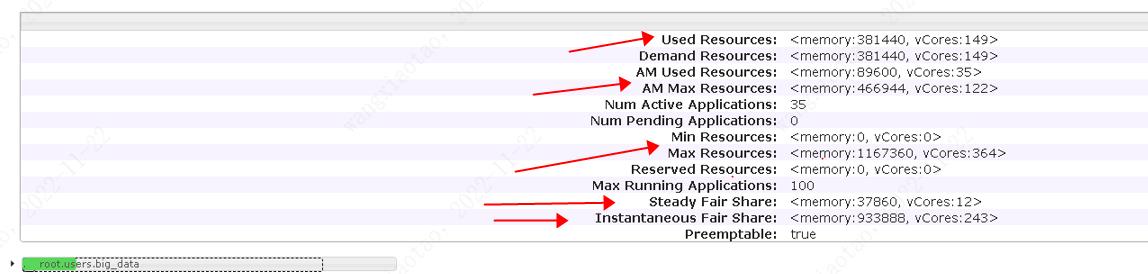

- 公平调度器下,某队列在 YARN WEBUI 的调度器页面截图如下:

- 页面中显示的 Steady Fair Share 是静态指标,其实质就是调度器根据用户配置的权重 weight计算出来的资源配额;

- 页面中显示的 Instantaneous Fair Share 是动态指标,是由调度器根据用户配置的权重和当前集群所有队列作业负载动态计算得出的动态指标;

- 页面中显示的AM Max Resources,其计算逻辑如下: AM Max Resources = Instantaneous Fair Share * maxAMShare;

- maxAMShare,默认值是50%;

- 一般而言,YARN 队列资源不足的问题比较容易发现,但是 AM 资源比例超限,最大任务数超限等问题,则需要细心观察;

- 某案例中,因为 AM 资源超限导致 hive on spark 任务无法申请到资源启动 spark driver 而运行失败,此时 hs2 中相关日志如下:

//作业失败相关日志:

failed to create spark client for spark session xxx xx:java.util.concurrent.TimeoutException: client xx timed out waiting for connection from the remote spark driver;

//资源超限相关日志:

org.apache.hive.spark.client.sparkClientImpl: [spark-submit-stderr-redir-HiveServer2-Backgroud-pool: Thread-xxxxx]: diagnostics: xxx application is added to the scheduler and is not yet activated. (Resource request: <memory:3584,vcores:1> exceeds maximum am resource allowed).

- 某案例中,因为 AM 资源超限导致新作业无法申请到资源启动 application master 而运行失败,此时容量调度器下,yarn web ui中该队列相关截图如下:

4 公平调度器相关重要参数

在容量调度器下,具体的资源管控参数,重要的有以下这些:

- Min Resources:队列最小资源数;

- Max Resources:队列最大资源数;

- maxRunningApps: 队列内最大可运行作业书;

- maxAMShare: am 资源比,默认50%;

- weigh: 队列权重,调度器会基于所有队列的权重计算每个队列的 fair share 资源配额;

- schedulingPolicy: 可选 fifo/fair/drf;

##更多细节,请参考官方文档

- https://hadoop.apache.org/docs/stable/hadoop-yarn/hadoop-yarn-site/FairScheduler.html

- CDH 中公平调度器相关参数的配置页面如下:

5 容量调度器相关重要参数

在容量调度器下,具体的资源管控参数,重要的有以下这些:

##队列资源相关参数

- yarn.scheduler.capacity.<queue-path>.capacity/yarn.scheduler.capacity.<queue-path>.maximum-capacity

- yarn.scheduler.capacity.<queue-path>.maximum-allocation-mb/yarn.scheduler.capacity.<queue-path>.maximum-allocation-vcores

- yarn.scheduler.capacity.<queue-path>.user-limit-factor

## am 资源限制相关参数

- yarn.scheduler.capacity.maximum-am-resource-percent/yarn.scheduler.capacity.<queue-path>.maximum-am-resource-percent

##作业并行度相关参数

- yarn.scheduler.capacity.maximum-applications/yarn.scheduler.capacity.<queue-path>.maximum-applications

- yarn.scheduler.capacity.max-parallel-apps/yarn.scheduler.capacity.<queue-path>.max-parallel-apps

- yarn.scheduler.capacity.user.max-parallel-apps/yarn.scheduler.capacity.user.<username>.max-parallel-apps

##更多细节,请参考官方文档

- https://hadoop.apache.org/docs/stable/hadoop-yarn/hadoop-yarn-site/CapacityScheduler.html

以上是关于公共大数据集群中如何配置 YARN 的公平调度器和容量调度器的主要内容,如果未能解决你的问题,请参考以下文章