什么是二阶收敛和二次收敛

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了什么是二阶收敛和二次收敛相关的知识,希望对你有一定的参考价值。

二阶收敛就是说某函数的二阶导数收敛 。

二次收敛性是若一算法对Q正定的二次目标函数(f(x)=0.5xQx+bx+c)能在有限步内找出极小点来。

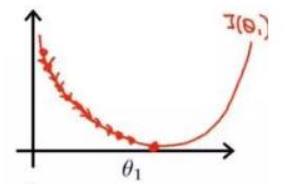

在原函数的某一点处用一个二次函数近似原函数,然后用这个二次函数的极小值点作为原函数的下一个迭代点。

上面这句话也说明,若原函数本身是一个二次函数,则牛顿法一步就能到达极小点或鞍点。若原函数本身是一个二次正定函数,则牛顿法一步到达最小值点。

扩展资料:

牛顿法的二阶收敛性:

若初始点 x0 充分靠近极值点 x*,并且极值点 x* 的黑塞矩阵非奇异,并且黑塞矩阵在极值点附近 Lipschitz 连续,则牛顿法具有二阶收敛性。

注:Lipschitz 连续是一种比普通连续性更强的连续,它限制了函数的改变速度。对于函数可行域的任意两点,存在一个常数 K。

牛顿迭代法二阶收敛。

参考资料来源:百度百科——二阶收敛

参考技术A 二阶收敛就是说某函数的二阶导数收敛二次收敛性是若一算法对Q正定的二次目标函数(f(x)=0.5xQx+bx+c)能在有限步内找出极小点来

深度学习中收敛是什么意思?

原理

收敛的意思是指某个值一直在往我们所期望的阈值靠,就拿深度学习中loss损失来做示例,如下一张图是loss在每轮训练时的一个曲线图,可以看到loss一直从一开始的1.8在往1.0降,1.0就是我们期望的阈值,而1.8是最开始loss最大损失值。

可以看到在训练过程中损失值一直在往我们期望的阈值上靠近,这个曲线非常平滑,没有出现曲线一直卡在某个点不下降或突然曲线上升了(这个情况是跑飞了)的原因,如果有可能是学习率设置的问题。

下图这个就是一个损失时跑飞的一个曲线图:

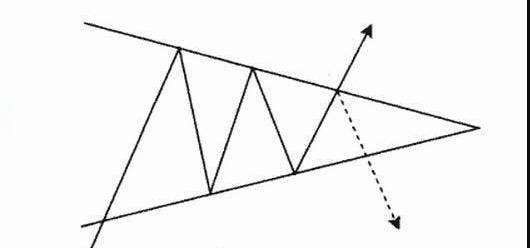

可以看到原本下降的过程中又突然增长回来了,这个原因可能是你学习率在进行衰减时出现了问题,这样的损失值在更新权重时肯定会有影响,这种情况也叫局部震荡,即在一个特定阈值附近进行来回跳跃,在1.0的阈值之间来回跳跃始终迭代不前,这种情况就出现了无法收敛的问题。

学习率代表了你loss损失值的利用率,所以你loss衰减取决于你的学习率。

以上是关于什么是二阶收敛和二次收敛的主要内容,如果未能解决你的问题,请参考以下文章