controller 节点 和 compute节点 哪个耗cpu

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了controller 节点 和 compute节点 哪个耗cpu相关的知识,希望对你有一定的参考价值。

通过rdo 配置计算节点由于只需要一个简单的环境(一个控制节点,一个计算节点),所以不想用fuel安装,感觉太麻烦了

于是我想用rdo安装两个独立的环境,然后将其中一个改装成计算节点

1. 创建两个centos7的虚拟机,分别用rdo 安装成功OpenStack L 版本的环境

将其中一个主机名改为controller 一个主机名改为 compute

2. 开始配置

控制节点上的配置就一个 在 /etc/hosts 中加入

192.168.0.1 compute

执行iptables -F (也可以自己设置安全策略,不然防火墙要阻止通信)

计算节点上需要修改 两个配置文件neutron.conf和nova.conf

(1)网络通用组件的配置包括认证机制、消息代理和插件。 (这一步笔者很懒,直接将控制节点的文件cp过来覆盖了)

修改配置文件 /etc/neutron/neutron.conf 并完成以下操作:

在 [database] 部分,注释所有 connection 选项,因为计算节点不会直接访问数据库。

在 [DEFAULT] 段,对 RabbitMQ 消息代理相关参数进行配置:

Select Text

1

2

3

4

5

[DEFAULT]

...

rpc_backend = rabbit

rabbit_host = 控制器

rabbit_password = RABBIT_PASS

将 RABBIT_PASS 替换为 RabbitMQ 服务中 guest 用户的密码。

在 [DEFAULT] 和 [keystone_authtoken] 部分,配置身份认证服务的访问:

Select Text

1

2

3

4

5

6

7

8

9

10

11

[DEFAULT]

...

auth_strategy = keystone

[keystone_authtoken]

...

auth_uri = http://控制器:5000/v2.0

identity_uri = http://控制器:35357

admin_tenant_name = service

admin_user = neutron

admin_password = NEUTRON_PASS

将其中的 NEUTRON_PASS 替换为您在身份认证服务中为 neutron 用户所设置的密码。

(2)修改 /etc/nova/nova.conf

需要修改为控制节服务的有:

identity_uri=http://控制器:35357

auth_uri=http://控制器:5000/v2.0

api_servers=控制器:9292

novncproxy_base_url=http://控制器:6080/vnc_auto.html

sql_connection=(和控制节点一致)

rabbit_hosts=控制器:5672

rabbit_host=控制器

在 [neutron] 部分,配置访问的参数:

Select Text

1

2

3

4

5

6

7

8

[neutron]

...

url = http://控制器:9696

auth_strategy = keystone

admin_auth_url = http://控制器:35357/v2.0

admin_tenant_name = service

admin_username = neutron

admin_password = NEUTRON_PASS

重启计算服务:

# systemctl restart openstack-nova-compute.service 参考技术A 你好。OpenStack最初是Rackspace和NASA共同投入的,现在是由开源社区维护。在9月18日即将在San Diego举行的Openstack Summit上也将有关于最新版本Folsom的消息。值得关注。

它就是一个IaaS的云平台软件。实际应用场景非常多,凡是IaaS可以应用的地方Openstack都可以做到。比如虚拟主机,出售计算资源,公司内部IT云计算解决方案等等。想知道更多案例可以看这里:

目前Openstack的优势在于它对于使用者来说是的,而且Openstack会得到了AT&T、Canonical、惠普、IBM、Nebula、Rackspace、Red Hat、SUSE、思科、戴尔、NetApp、Piston、雅虎、英特尔、NEC、VMware等赞助商的资金和技术支持。在各方面都是很有保障的。

至于使用Openstack带来的好处有很多,你可以参考云计算的基本优势。这里不多说了。

OpenStack---M版---双节点搭建---Cinder安装和配置

↓↓↓↓↓↓↓↓视频已上线B站↓↓↓↓↓↓↓↓

》》》》》》传送门

1.创建数据库并授权

2.获得admin凭证执行管理员命令并创建服务证书

3.创建块存储设备API接口

4.Controller节点安装块存储组件并配置

5.初始化块设备服务的数据库

6.配置计算节点以使用块设备存储

7.重启服务并设置开机启动

8.Compute节点安装并配置一个存储节点,此处用Compute节点代替

9.验证操作

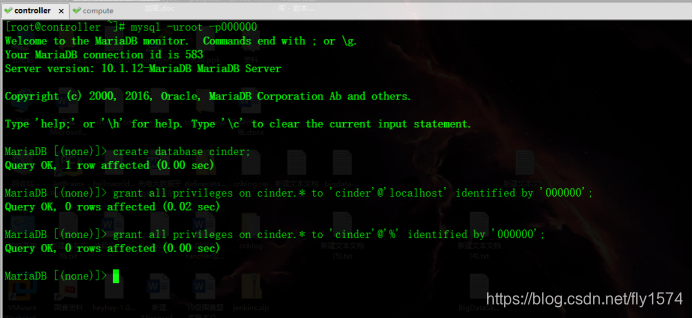

1.创建数据库并授权

# mysql -uroot -p000000

> create database cinder;

> grant all privileges on cinder.* to 'cinder'@'localhost' identified by '000000';

> grant all privileges on cinder.* to 'cinder'@'%' identified by '000000';

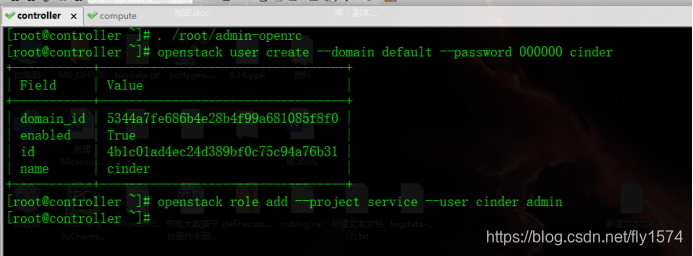

2.获得admin凭证执行管理员命令并创建服务证书

# . /root/admin-openrc

# openstack user create --domain default --password 000000 cinder

# openstack role add --project service --user cinder admin

创建服务实体

#openstack service create --name cinder --description "OpenStack Block Storage" volume

#openstack service create --name cinderv2 --description "OpenStack Block Storage" volumev2

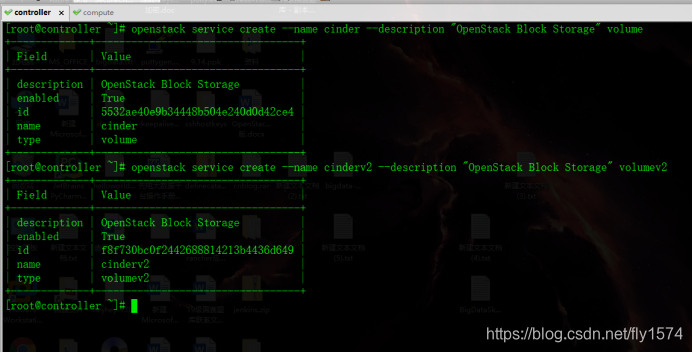

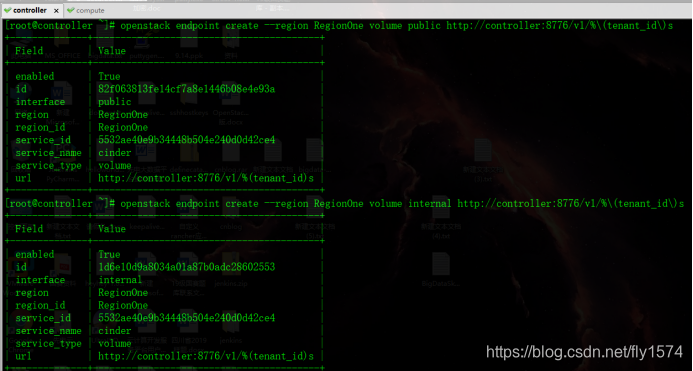

3.创建块存储设备API接口

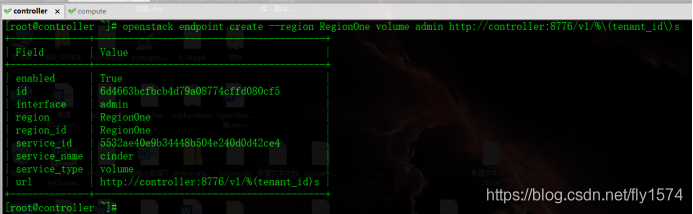

#openstack endpoint create --region RegionOne volume public http://controller:8776/v1/%(tenant_id)s

#openstack endpoint create --region RegionOne volume internal http://controller:8776/v1/%(tenant_id)s

#openstack endpoint create --region RegionOne volume admin http://controller:8776/v1/%(tenant_id)s

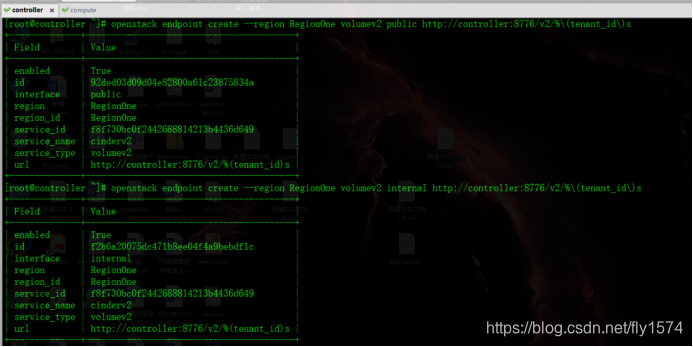

#openstack endpoint create --region RegionOne volumev2 public http://controller:8776/v2/%(tenant_id)s

#openstack endpoint create --region RegionOne volumev2 internal http://controller:8776/v2/%(tenant_id)s

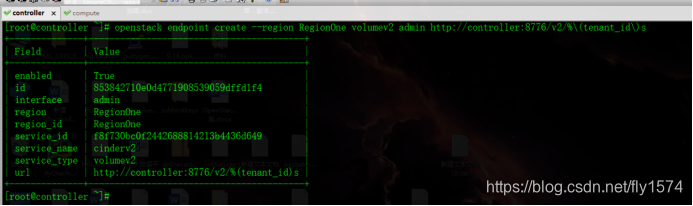

#openstack endpoint create --region RegionOne volumev2 admin http://controller:8776/v2/%(tenant_id)s

4.Controller节点安装块存储组件并配置

[root@controller ~]# yum -y install openstack-cinder

编辑 /etc/cinder/cinder.conf

#vi /etc/cinder/cinder.conf

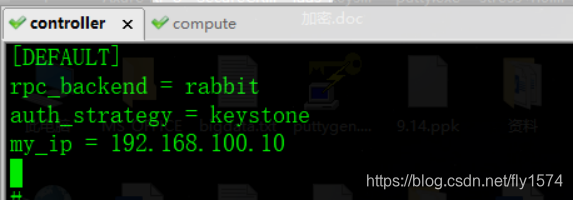

在 “[DEFAULT]” 下添加

rpc_backend = rabbit

auth_strategy = keystone

my_ip = 192.168.100.10

在[database]下添加

connection = mysql+pymysql://cinder:000000@controller/cinder

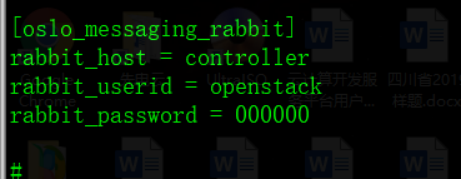

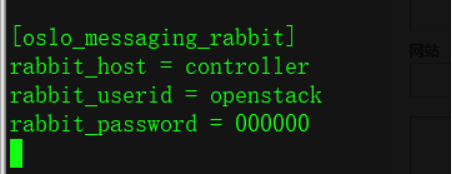

在[oslo_messaging_rabbit]部分,配置 “RabbitMQ” 消息队列访问:

rabbit_host = controller

rabbit_userid = openstack

rabbit_password = 000000

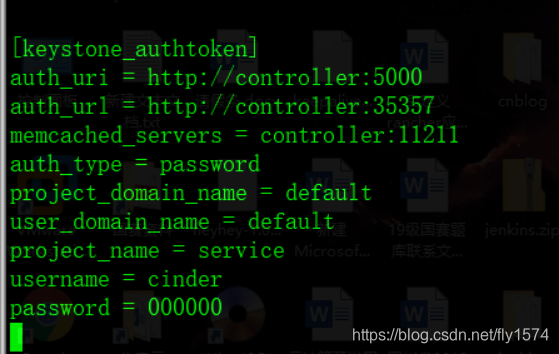

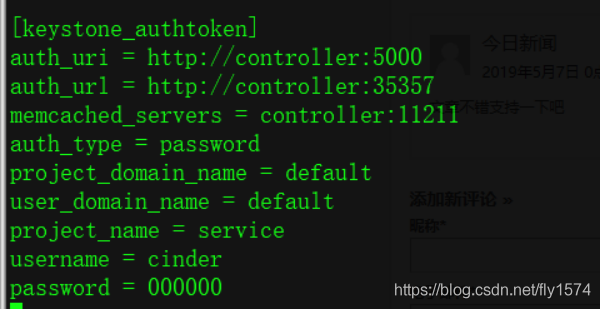

在[keystone_authtoken]部分,配置认证服务访问:

auth_uri = http://controller:5000

auth_url = http://controller:35357

memcached_servers = controller:11211

auth_type = password

project_domain_name = default

user_domain_name = default

project_name = service

username = cinder

password = 000000

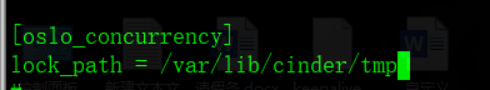

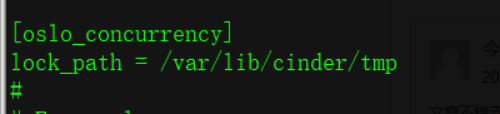

在 [oslo_concurrency] 部分,配置锁路径:

lock_path = /var/lib/cinder/tmp

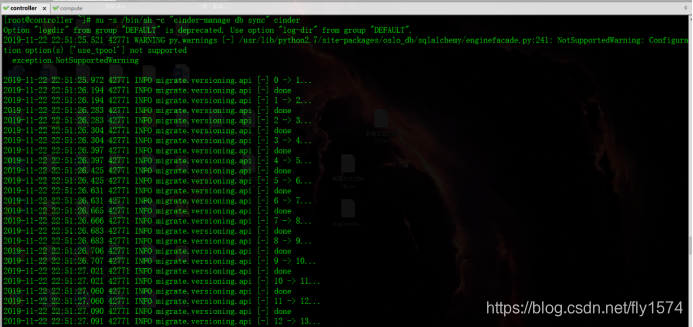

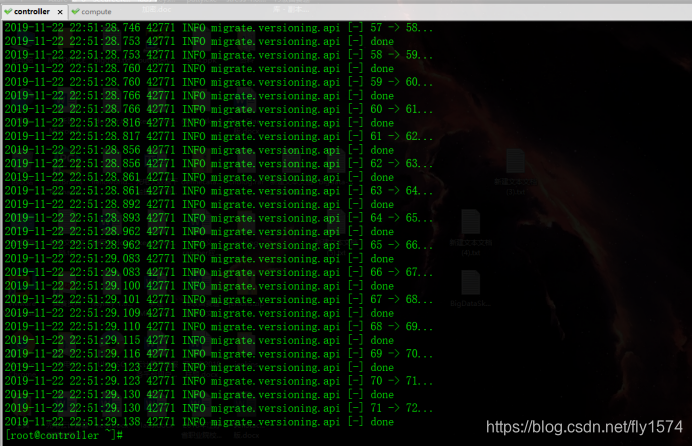

5.初始化块设备服务的数据库

# su -s /bin/sh -c "cinder-manage db sync" cinder

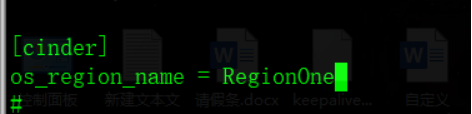

6.配置计算节点以使用块设备存储

编辑文件 /etc/nova/nova.conf 并添加如下到其中:

# [root@controller ~]# vi /etc/nova/nova.conf

在[cinder]下添加

os_region_name = RegionOne

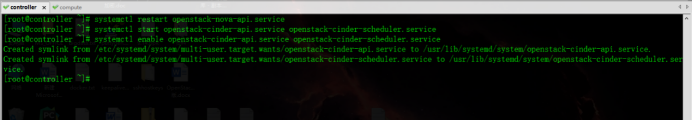

7.重启服务并设置开机启动

重启计算API 服务:

# systemctl restart openstack-nova-api.service

启动块设备存储服务,并将其配置为开机自启:

#systemctl start openstack-cinder-api.service openstack-cinder-scheduler.service

#systemctl enable openstack-cinder-api.service openstack-cinder-scheduler.service

8.Compute节点安装并配置一个存储节点,此处用Compute节点代替

1.安装并配置

1.安装支持的工具包LVM:

[root@compute ~]# yum -y install lvm2

启动LVM的metadata服务并且设置该服务随系统启动:

# systemctl start lvm2-lvmetad.service

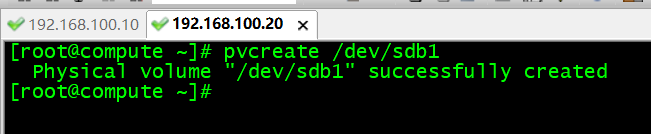

# systemctl enable lvm2-lvmetad.service2.创建LVM 物理卷 /dev/sdb:

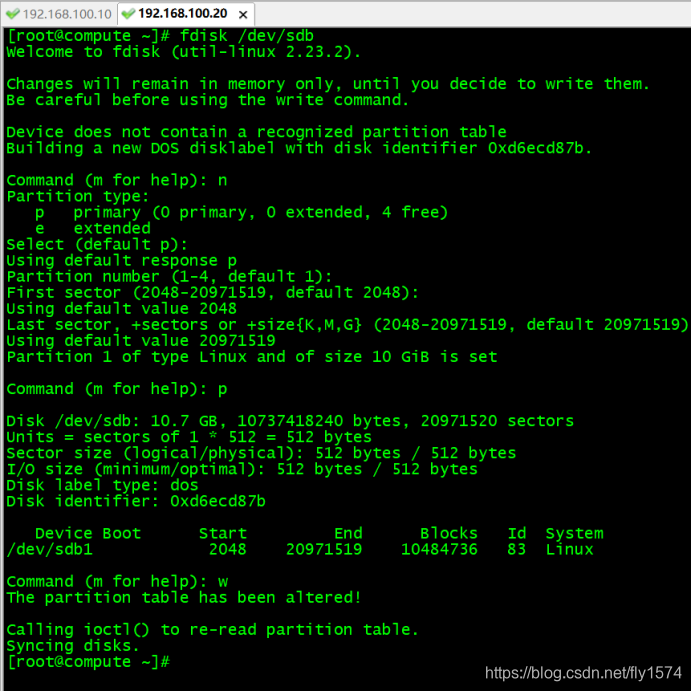

首先查看是否存在sdb

# lsblk首先执行如下命令

创建分区:

[root@compute ~]# fdisk /dev/sdb

# pvcreate /dev/sdb1

3.创建 LVM 卷组 cinder-volumes:

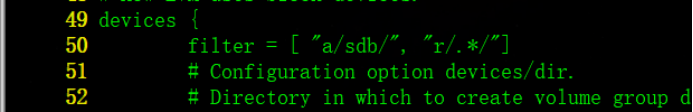

# vgcreate cinder-volumes /dev/sdb13.编辑/etc/lvm/lvm.conf文件,并修改

首先查看哪些分区使用了 LVM格式

# lsblk

# vi /etc/lvm/lvm.conf

在``devices``部分,添加一个过滤器,接受使用lvm的设备:

filter = [ "a/sdb/", "r/.*/"]

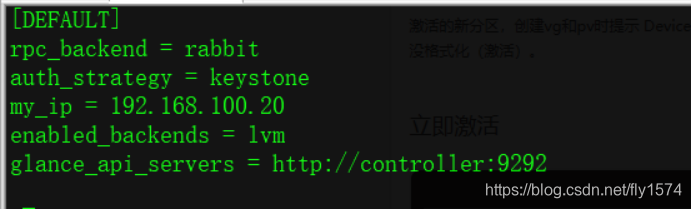

2.安装并配置组件(Compute节点)

1.安装软件包

# yum -y install openstack-cinder targetcli python-keystone2.编辑 /etc/cinder/cinder.conf

vi /etc/cinder/cinder.conf

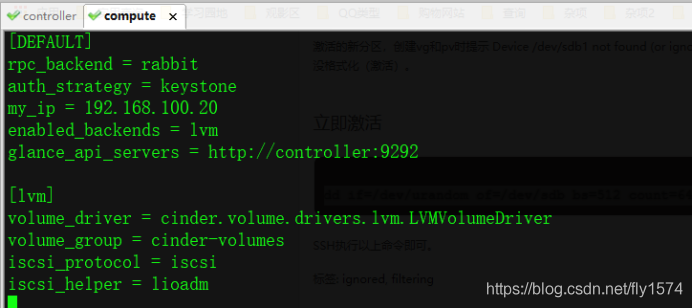

在[DEFAULT]下添加

rpc_backend = rabbit

auth_strategy = keystone

my_ip = 192.168.100.20 #这里的IP地址是存储节点的ip

enabled_backends = lvm

glance_api_servers = http://controller:9292

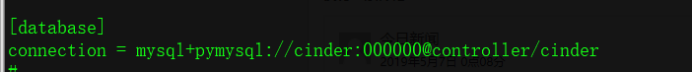

在[database]下添加

connection = mysql+pymysql://cinder:000000@controller/cinder

在[oslo_messaging_rabbit]”部分,配置 “RabbitMQ” 消息队列访问:

rabbit_host = controller

rabbit_userid = openstack

rabbit_password = 000000

在[keystone_authtoken]” 部分,配置认证服务访问:

auth_uri = http://controller:5000

auth_url = http://controller:35357

memcached_servers = controller:11211

auth_type = password

project_domain_name = default

user_domain_name = default

project_name = service

username = cinder

password = 000000

添加[lvm]项

[lvm]

volume_driver = cinder.volume.drivers.lvm.LVMVolumeDriver

volume_group = cinder-volumes

iscsi_protocol = iscsi

iscsi_helper = lioadm

在 [oslo_concurrency] 部分,配置锁路径:

lock_path = /var/lib/cinder/tmp

3.启动块存储卷服务及其依赖的服务,并将其配置为随系统启动

# systemctl start openstack-cinder-volume.service target.service

# systemctl enable openstack-cinder-volume.service target.service9.验证操作

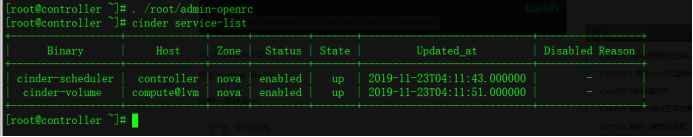

# . /root/admin-openrc

列出服务组件以验证是否每个进程都成功启动:

#cinder service-list

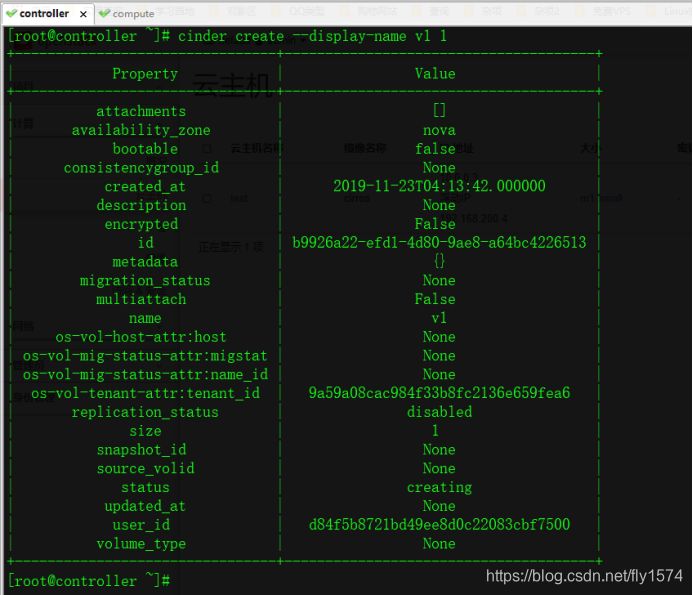

创建卷

# cinder create --display-name v1 1

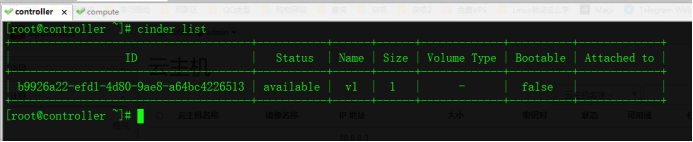

# cinder list

以上是关于controller 节点 和 compute节点 哪个耗cpu的主要内容,如果未能解决你的问题,请参考以下文章

OpenStack---M版---双节点搭建---Swift安装和配置