Redis如何保证主从库的数据一致?

Posted 不知所措的渣渣辉

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Redis如何保证主从库的数据一致?相关的知识,希望对你有一定的参考价值。

虽然说,已经有了AOF和RDB两种机制保证数据尽量少丢失数据,提高了数据库的可靠性。

但是Redis具有高可靠性,其实是有两层含义的:一是数据尽量少丢失,二是服务尽量少中断。

AOF 和 RDB 保证了前者,而对于后者,Redis 的做法就是增加副本冗余量,将一份数据同时保存在多个实例上。即使有一个实例出现了故障,需要过一段时间才能恢复,其他实例也可以对外提供服务,不会影响业务使用。

这也就产生了如何保证主从数据一致的问题。

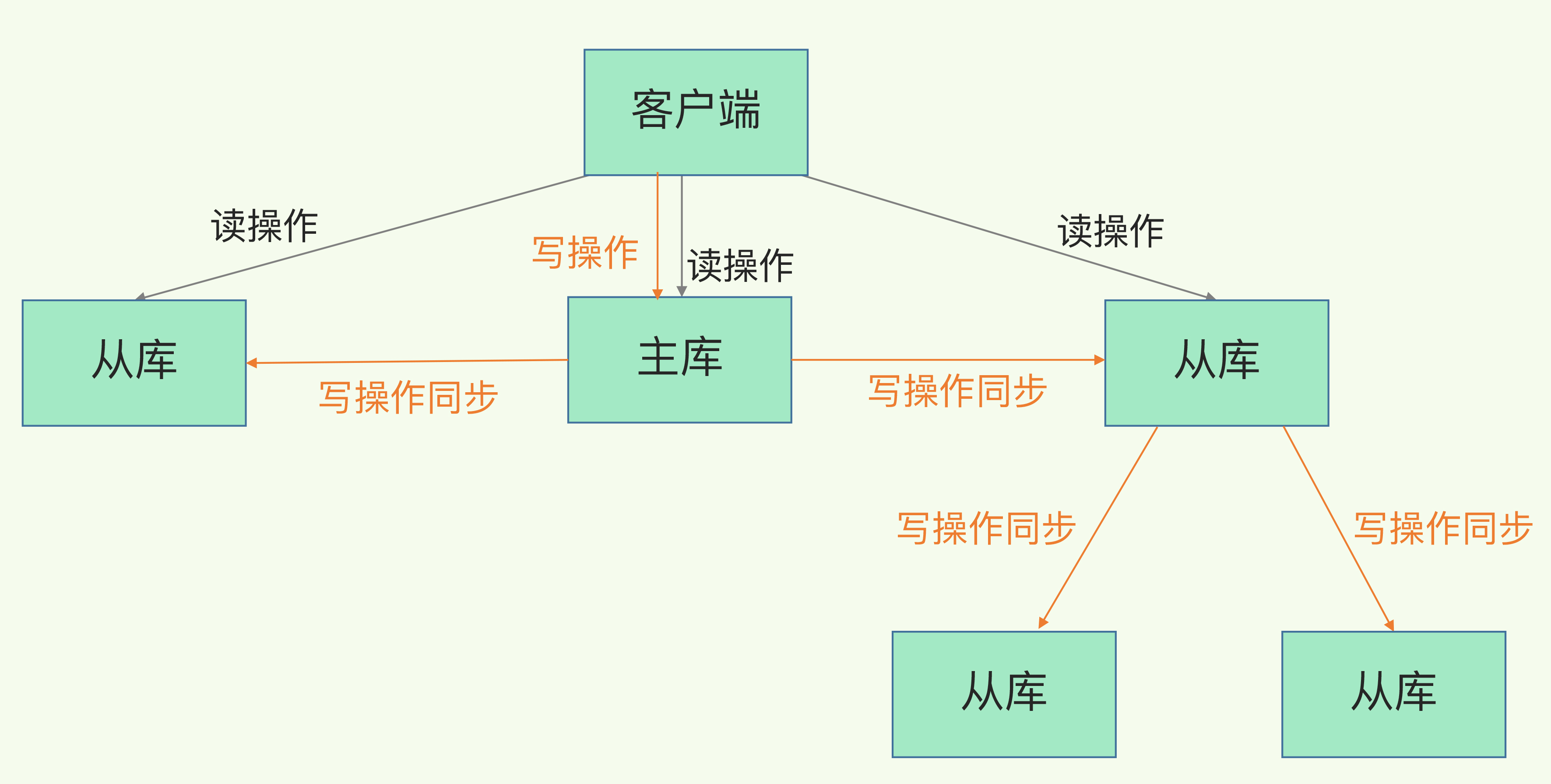

实际上,Redis 提供了主从库模式,以保证数据副本的一致,主从库之间采用的是读写分离的方式。

- 读操作:主库、从库都可以接收;

- 写操作:首先到主库执行,然后,主库将写操作同步给从库。

那么,为什么要采用读写分离的方式呢?

我们可以假设所有实例都能够接收写操作,每个实例都执行了一次写操作,这时候实例上的副本就不一致了,导致客户端可能读到旧值。当然,也可以通过一系列的加锁、实例间协商是否完成修改等一系列操作来保证数据一致,但这也带来了巨额的开销,是无法接受的。

而主从库模式一旦采用了读写分离,所有数据的修改只会在主库上进行,不用协调多个实例。主库有了最新的数据后,会同步给从库,这样,主从库的数据就是一致的。

那么,主从库同步是如何完成的呢?主库数据是一次性传给从库,还是分批同步?要是主从库间的网络断连了,数据还能保持一致吗?

下面就来研究一下主从库同步的原理,以及网络断连风险的方案。首先先来看看主从库间的第一次同步是如何进行的,这也是 Redis 实例建立主从库模式后的规定动作。

主从库间的第一次同步

当我们启动多个 Redis 实例的时候,它们相互之间就可以通过 replicaof(Redis 5.0 之前使用 slaveof)命令形成主库和从库的关系,之后会按照三个阶段完成数据的第一次同步。

例如,现在有实例 1(ip:172.16.19.3)和实例 2(ip:172.16.19.5),我们在实例 2 上执行以下这个命令后,实例 2 就变成了实例 1 的从库,并从实例 1 上复制数据:

replicaof 172.16.19.3 6379

接下来,我们就要学习主从库间数据第一次同步的三个阶段了。先看一下下面这张图,有个整体感知,后面再具体介绍。

- 第一阶段是主从库间建立连接、协商同步的过程,主要是为全量复制做准备。

在这一步,从库和主库建立起连接,并告诉主库即将进行同步,主库确认回复后,主从库间就可以开始同步了。

具体来说,从库给主库发送 psync 命令,表示要进行数据同步,主库根据这个命令的参数来启动复制。psync 命令包含了主库的 runID 和复制进度 offset 两个参数。

- runID,是每个 Redis 实例启动时都会自动生成的一个随机 ID,用来唯一标记这个实例。当从库和主库第一次复制时,因为不知道主库的 runID,所以将 runID 设为“?”。

- offset,此时设为 -1,表示第一次复制。

主库收到 psync 命令后,会用 FULLRESYNC 响应命令带上两个参数:主库 runID 和主库目前的复制进度 offset,返回给从库。从库收到响应后,会记录下这两个参数。

这里有个地方需要注意,FULLRESYNC 响应表示第一次复制采用的全量复制,也就是说,主库会把当前所有的数据都复制给从库。

- 在第二阶段,主库将所有数据同步给从库。从库收到数据后,在本地完成数据加载。

这个过程依赖于内存快照生成的 RDB 文件具体来说,主库执行

bgsave命令,生成 RDB 文件,接着将文件发给从库。从库接收到 RDB 文件后,会先清空当前数据库,然后加载 RDB 文件。这是因为从库在通过replicaof命令开始和主库同步前,可能保存了其他数据。为了避免之前数据的影响,从库需要先把当前数据库清空。

在主库将数据同步给从库的过程中,主库不会被阻塞,仍然可以正常接收请求。否则,Redis 的服务就被中断了。

但是,这些请求中的写操作并没有记录到刚刚生成的 RDB 文件中。为了保证主从库的数据一致性,主库会在内存中用专门的 replication buffer,记录 RDB 文件生成后收到的所有写操作。

- 最后,也就是第三个阶段,主库会把第二阶段执行过程中新收到的写命令,再发送给从库。

具体的操作是,当主库完成 RDB 文件发送后,就会把此时 replication buffer 中的修改操作发给从库,从库再重新执行这些操作。这样一来,主从库就实现同步了。

值得注意的是:第三阶段命令传播,主库如何知道发送的命令被从库成功接收?如果不知道,是否会存在数据丢失的风险?

- 主和从都维护了offset ,从把自己的offset告诉主,主会把这个offset和replica buffer中查看,是否有这个offset的数据,有就发送给从,从执行命令后会增加自己offset

使用主从级联模式分散压力

在主从库第一次数据同步中,会进行全量复制,需要完成两个耗时的操作:生成 RDB 文件和传输 RDB 文件。在从库数量多时,显然会导致主库就会导致主库忙于 fork 子进程生成 RDB 文件,进行数据全量同步。

fork 这个操作会阻塞主线程处理正常请求,从而导致主库响应应用程序的请求速度变慢。此外,传输 RDB 文件也会占用主库的网络带宽,同样会给主库的资源使用带来压力。那么,有没有好的解决方法可以分担主库压力呢?

解决方法就是“主-从-从”模式。该模式以级联的方式将主库生成RDB和传输RDB的压力分散到了从库上。

简单来说,我们在部署主从集群的时候,可以手动选择一个从库(比如选择内存资源配置较高的从库),用于级联其他的从库。然后,我们可以再选择一些从库(例如三分之一的从库),在这些从库上执行如下命令,让它们和刚才所选的从库,建立起主从关系。

replicaof 所选从库的IP 6379

这样一来,这些从库就会知道,在进行同步时,不用再和主库进行交互了,只要和级联的从库进行写操作同步就行了,这就可以减轻主库上的压力,如下图所示:

到这里,主从库间通过全量复制实现数据同步的过程就算是完成了,之后它们之间就会一直维护一个网络连接,主库会通过这个连接将后续陆续收到的命令操作再同步给从库,这个过程也称为基于长连接的命令传播,可以避免频繁建立连接的开销。

虽说很简单,可还是存在风险,最常见的就是网络断连或阻塞。如果网络断连,主从库之间就无法进行命令传播了,从库的数据自然也就没办法和主库保持一致了,客户端就可能从从库读到旧数据。

下面就来研究一下网络断连后的解决办法。

主从库间网络断连后的解决办法

在 Redis 2.8 之前,如果主从库在命令传播时出现了网络闪断,那么,从库就会和主库重新进行一次全量复制,开销非常大。

从 Redis 2.8 开始,网络断了之后,主从库会采用增量复制的方式继续同步。听名字大概就可以猜到它和全量复制的不同:

全量复制是同步所有数据,而增量复制只会把主从库网络断连期间主库收到的命令,同步给从库。

那么,增量复制时,主从库之间具体是怎么保持同步的呢?

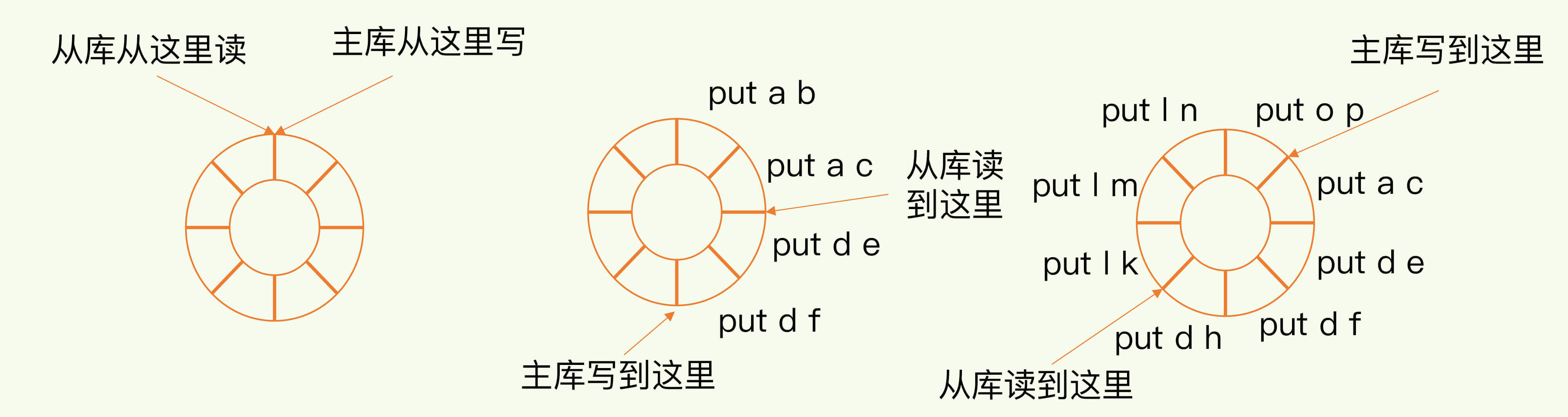

奥妙在于

repl_backlog_buffer环形缓冲区,主库会记录自己写到的位置,从库则会记录自己已经读到的位置。

当主从库断连后,主库会把断连期间收到的写操作命令写入 repl_backlog_buffer 这个缓冲区,需要注意断连后没有replication buffer。

刚开始的时候,主库和从库的写读位置在一起,这算是它们的起始位置。随着主库不断接收新的写操作,它在缓冲区中的写位置会逐步偏离起始位置,我们通常用偏移量来衡量这个偏移距离的大小,对主库来说,对应的偏移量就是

master_repl_offset。主库接收的新写操作越多,这个值就会越大。

同样,从库在复制完写操作命令后,它在缓冲区中的读位置也开始逐步偏移刚才的起始位置,此时,从库已复制的偏移量 slave_repl_offset 也在不断增加。正常情况下,这两个偏移量基本相等。

-

在从库重连之后,从库首先会给主库发送

psync命令,并把自己当前的slave_repl_offset发给主库,主库会判断自己的master_repl_offset和slave_repl_offset之间的差距。 -

在网络断连阶段,主库可能会收到新的写操作命令,所以,一般来说,

master_repl_offset会大于slave_repl_offset。此时,主库只用把master_repl_offset和slave_repl_offset之间的命令操作同步给从库就行。

就像刚刚示意图的中间部分,主库和从库之间相差了 put d e 和 put d f 两个操作,在增量复制时,主库只需要把它们同步给从库,就行了。

这里借助一张图,来回顾下增量复制的流程。

值得注意的是,因为

repl_backlog_buffer是一个环形缓冲区,所以在缓冲区写满后,主库会继续写入,此时,就会覆盖掉之前写入的操作。如果从库的读取速度比较慢,就有可能导致从库还未读取的操作被主库新写的操作覆盖了,这会导致主从库间的数据不一致。细节:既然有些未读取的操作被覆盖了,那这时候从库该怎么办?这时候主从库之间将进行全量复制。

因此,我们要想办法避免这一情况,一般而言,我们可以调整 repl_backlog_size 这个参数。这个参数和所需的缓冲空间大小有关。缓冲空间的计算公式是:

缓冲空间大小 = 主库写入命令速度 * 操作大小 - 主从库间网络传输命令速度 * 操作大小

在实际应用中,考虑到可能存在一些突发的请求压力,我们通常需要把这个缓冲空间扩大一倍,即 repl_backlog_size = 缓冲空间大小 * 2,这也就是 repl_backlog_size 的最终值。

举个例子,如果主库每秒写入 2000 个操作,每个操作的大小为 2KB,网络每秒能传输 1000 个操作,那么,有 1000 个操作需要缓冲起来,这就至少需要 2MB 的缓冲空间。否则,新写的命令就会覆盖掉旧操作了。为了应对可能的突发压力,我们最终把 repl_backlog_size 设为 4MB。

这样增量复制时主从库的数据不一致风险就降低了。但在并发请求量非常大的情况下,仍有缓冲空间不够的情况,主从库数据还是可能不一致。

对于这种情况,一方面可以根据Redis 所在服务器的内存资源再适当增加 repl_backlog_size 值;另一方面,可以通过切片集群的方法来分担单个主库的请求压力。

总结

本文主要是研究了Redis 的主从库同步的基本原理,关于全量复制、基于长连接的命令传播,以及增量复制。

-

全量复制虽然耗时,但是对于从库来说,如果是第一次同步,全量复制是无法避免的

小建议:一个 Redis 实例的数据库不要太大,一个实例大小在几 GB 级别比较合适,这样可以减少 RDB 文件生成、传输和重新加载的开销。另外,为了避免多个从库同时和主库进行全量复制,给主库过大的同步压力,我们也可以采用“主 - 从 - 从”这一级联模式,来缓解主库的压力。

-

长连接复制是主从库正常运行后的常规同步阶段。在这个阶段中,主从库之间通过命令传播实现同步

-

增量复制在主从库断连的情况比较有效

这里建议留意一下

repl_backlog_size这个配置参数。如果它配置得过小,在增量复制阶段,可能会导致从库的复制进度赶不上主库,进而导致从库重新进行全量复制。所以,通过调大这个参数,可以减少从库在网络断连时全量复制的风险。

MySQL主从数据不一致,需要重新关联

情况是这样的:目前的库是一主两从,大部分的修改和读操作都是在主库上完成的,两个从库基本只做热备之用。前段时间由于重启主库,所以业务人员临时启用了其中一台从库做为主库,并对从库进行了写入操作。后来主库重启好后,他们又让原来的主库恢复了主库的职能,之前暂时做从的数据库就断开了与主库的主从关系。现在他们需要我把断开的从库跟主库重新关联上,并表示一切的数据都以原来的主库为准,所以可以把从库上的东西都删掉,然后导入主库的数据。

目前有几个问题,一个是需要整个导出的库很大,光表数据大小就有61G,数据库目录的大小有100多G,其中ibdata1文件就占了85G;

第二个是数据库里的表只有一张用的是MYISAM引擎,其他都用的是INNODB引擎,所以不能使用xtrabackup工具来导出。

然后我想到了四种方案:

一是使用Innobackupex+binlog日志还原从库数据;

二是使用mysqldump+binlong日志来还原从库;

三是直接拷贝从库上的数据然后scp到需要重新关联的从库;

四是使用percona-toolkit工具来重构数据,使主从数据库数据一致。

我是倾向于mysqldump+binlong,但是本身数据库就很大,估计光导出就要很久了。。。

然后我又看网上说用Innobackupex导出大数据更快,但是毕竟要在正式环境上安装工具,怕对现网环境造成影响

第三种方案需要期间停止所有从库,然后转移数据,这对空间和时间都有很大的要求,恐怕不容易满足。。。而且不知道把从库都先停止了会不会让原本没有问题的从库出现新问题

第四种方案貌似需要在主库上进行操作,而且会重构主库上的数据,我觉得风险更大。。。所以正在纠结中,不知道该怎么办

不知各位有何意见,或者有什么新的方案能够一起分享下呢?

2. 在没有主键或者唯一键的情况下,Hash Scan / Hash Scan Over Index 的执行效率 在理论上分析高于 Table Scan 和Index Scan 。

3. 在没有主键或者唯一键的情况下,Slave 选择的二级索引是第一个所有的列都在 BI 中存在的索引,不一定是 Master 执行计划所选择的索引。 参考技术B 直接拷贝物理文件备份,但是这种方式会产生问题,INNODB引擎无法物理备份,需要修改后备份。不妨做个修改,以后的维护一劳永逸。数据库主从备份可能会产生一些问题,也就是数据不可逆,最好做成主主备份,尤其是web和后台数据库同时多用户使用的情况下。

master1上的my.cnf添加:

[mysqld]

# for repl

log-bin=mysql-bin

server-id=1

binlog-do-db=TestXXX

binlog-ignore-db=mysql

replicate-do-db=TestXXX

replicate-ignore-db=mysql

log-slave-updates

slave-skip-errors=all

auto_increment_increment=2# 应设为整个结构中服务器的总数

auto_increment_offset=1# 设定数据库中自动增长的起点,避免两台服务器数据同步时出现主键冲突

master2上的my.cnf添加:

[mysqld]

# for repl

log-bin=mysql-bin

server-id=2

binlog-do-db=TestXXX

binlog-ignore-db=mysql

replicate-do-db=TestXXX

replicate-ignore-db=mysql

log-slave-updates

slave-skip-errors=all

auto_increment_increment=2

auto_increment_offset=2

重启两台机器上的服务

master1上指定master2为主:

CHANGE MASTER TO MASTER_HOST='master2',MASTER_USER='username',MASTER_PASSWORD='passwd';

START SLAVE;

master2上指定master1为主:

CHANGE MASTER TO MASTER_HOST='master1',MASTER_USER='username',MASTER_PASSWORD='passwd';

START SLAVE;本回答被提问者和网友采纳

以上是关于Redis如何保证主从库的数据一致?的主要内容,如果未能解决你的问题,请参考以下文章

分布式存储引擎大厂实战——Redis主从数据库如何实现数据一致性