spark 与 Hadoop 融合后 Neither spark.yarn.jars nor spark.yarn.archive is set

Posted Hello_BeautifulWorld

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了spark 与 Hadoop 融合后 Neither spark.yarn.jars nor spark.yarn.archive is set相关的知识,希望对你有一定的参考价值。

参考文献:

http://blog.csdn.net/lxhandlbb/article/details/54410644

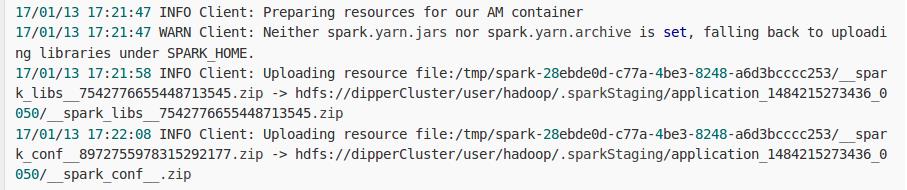

每次提交Spark任务到yarn的时候,总会出现uploading resource(打包spark jars并上传)到hdfs上。

恶劣情况下,会在这里卡住很久。

解决:

在hdfs上创建目录:

hdfs dfs -mkdir /spark_jars

上传spark的jars(spark1.6 只需要上传spark-assembly-1.6.0-SNAPSHOT-hadoop2.6.0.jar)

hdfs dfs -put /opt/spark/jars/* /spark_jars

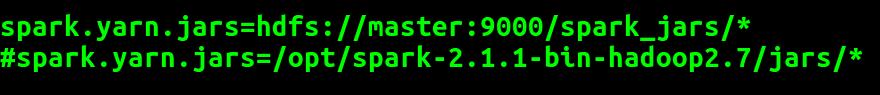

在spark的conf的spark-default.conf

添加配置 :

spark.yarn.jars=hdfs://master:9000/spark_jars/*

#spark.yarn.jars=/opt/spark-2.1.1-bin-hadoop2.7/jars/*

即可解决。不会出现这个问题。

以上是关于spark 与 Hadoop 融合后 Neither spark.yarn.jars nor spark.yarn.archive is set的主要内容,如果未能解决你的问题,请参考以下文章

报名|Hadoop与Spark大数据开发与案例分析”实战培训班