Reinforcement Learning强化学习系列之四:时序差分TD

Posted luchi007

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Reinforcement Learning强化学习系列之四:时序差分TD相关的知识,希望对你有一定的参考价值。

引言

前面一篇讲的是蒙特卡洛的强化学习方法,蒙特卡罗强化学习算法通过考虑采样轨迹,克服了模型未知给策略估计造成的困难,不过蒙特卡罗方法有一个缺点,就是每次需要采样完一个轨迹之后才能更新策略。蒙特卡洛方法没有充分利用学习任务的MDP结构,而时序差分学习方法Temporal Difference(TD)就充分利用了MDP结构,效率比MC要高,这篇文章介绍一下TD算法

Sarsa算法

Sarsa的算法如下:

Sarsa算法是on-policy方法,其原始策略和更新策略是一致的,而其更新策略和MC不一样的是其策略更新不需要采样一个完整的轨迹,在执行完一个动作后就可以更新其值函数。

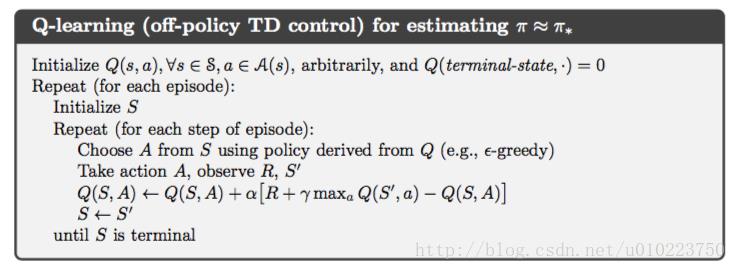

Q-learning算法

Q-learning算法则是一个off-policy的方法

以上是关于Reinforcement Learning强化学习系列之四:时序差分TD的主要内容,如果未能解决你的问题,请参考以下文章

强化学习专栏——Reinforcement Learning

Reinforcement Learning强化学习系列之一:model-based learning