Hadoop HA 搭建发现新增namenode其他节点报Retrying connect to server 0.0.0.0:8032异常

Posted 扫地增

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Hadoop HA 搭建发现新增namenode其他节点报Retrying connect to server 0.0.0.0:8032异常相关的知识,希望对你有一定的参考价值。

背景

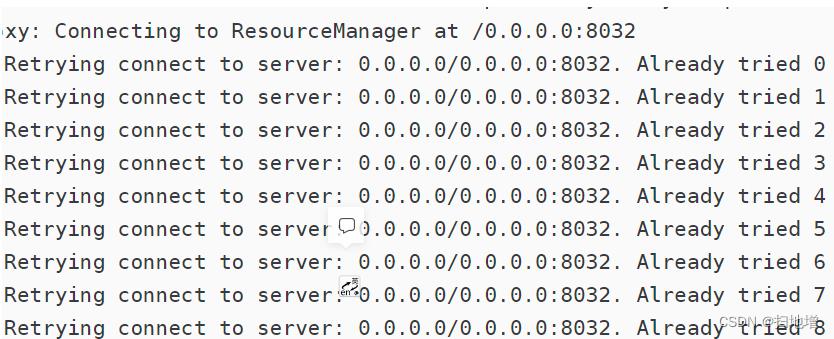

问题是在笔者配置集群高可用时出现,刚开始集群正常后来出现了新增的namenode服务起不起来后来修改该节点hostname替换为0.0.0.0后才得已解决,但是这个问题困扰了笔者在搭建ha开始到解决问题的日日夜夜,今天突然集群报错,造成集群瘫痪掉。在重启集群之后发下报如下错误:

报错

分析

面对这个报错只是知道是通信不上,按道理来说不应该啊因为大家知道0.0.0.0它表示本机中所有的IPV4地址。监听0.0.0.0的端口,就是监听本机中所有IP的端口。按道理来说不论如何都是能访问到的。但是在笔者去掉了本机hostname和0.0.0.0映射关系后集群出现了报错。其他节点无法访问本机。该异常二次发生,咦,刚刚已经解决了,为何还会发生呢?此时,心情是崩溃的。

产生原因

因为Client会去找Cluster要集群资源,而Client和Cluster要通信,就要能够在及裙房为内互相识别。但现在Client提交的spark任务默认寻找的本机,无法向集群提交,hostname无法被Cluster识别。所以,产生原因主要是Client的hostname被设置成了localhost.localdomain。换句话说,就是在/etc/hosts文件中给hostname和localhost.localdomain配置了映射关系。这个时候出问题的兄弟赶紧看看是否如此。

操作

查看hosts,发现果然如此,

cat /etc/hosts

修改掉后重启集群,发现集群各个角色运行正常。因为粗心造成这个bug真的让人很无语。大家一定要以此为鉴做事细心。加油💪🏻

以上是关于Hadoop HA 搭建发现新增namenode其他节点报Retrying connect to server 0.0.0.0:8032异常的主要内容,如果未能解决你的问题,请参考以下文章