安装datagrip以及datagrip连接hive

Posted 一个人的牛牛

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了安装datagrip以及datagrip连接hive相关的知识,希望对你有一定的参考价值。

目录

介绍:

DataGrip 出自JetBrains公司,是一款跨平台的数据库管理客户端工具,可在Windows,OS X 和 Linux上使用;同时支持多种数据库:SQL Server, Oracle, PostgreSQL, mysql, DB2, Sybase, SQLite, Derby, HyperSQL和H2;方便连接到数据库服务器,执行sql、创建表、创建索引以及导出数据等。

一、准备

1.1下载安装datagrip

官网:

下载 DataGrip:适用于数据库和 SQL 的跨平台 IDE

1.2安装配置好Hadoop、hive、MySQL

没有的可以查考:

Linux安装MySQL5.7(CentOS7)_一个人的牛牛的博客-CSDN博客_linux安装mysql5,7

下面的是Hadoop的,里面有hadoop2X、hadoop3X 的全分布和高可用(HA)的安装配置过程。

https://blog.csdn.net/qq_55906442/category_11761458.html

CentOS7安装hive(apache-hive-3.1.2-bin)_一个人的牛牛的博客-CSDN博客_centos7安装hive

二、安装连接

2.1安装datagrip

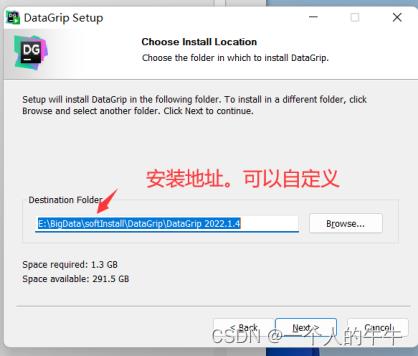

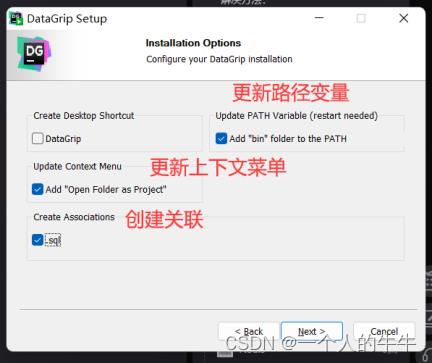

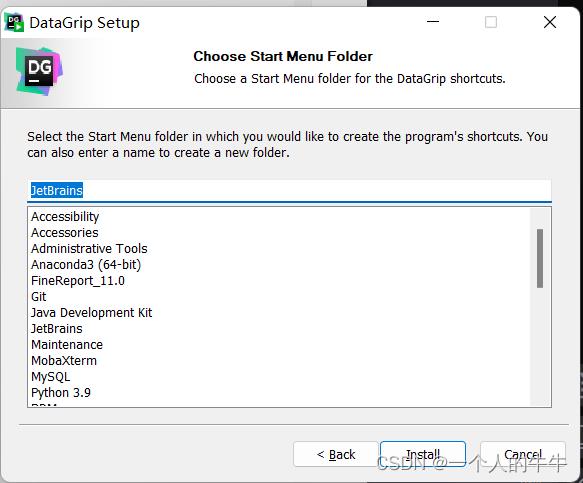

根据自己的情况修改和确认以下三个位置,其他步骤直接next。

安装完成后直接打开!

2.2配置hive

1.进入hive的conf文件夹配置hive-site.xml

配置参数注解:

hadoop01:主机名

metastore:mysql数据库名

offdb:mysql用户名

123456:mysql用户密码

/user/hive/warehouse:hdfs存储文件路径

thrift://hadoop01:9083:metastore的url

192.168.xxx.xxx:主机IP地址

root:hiveserver2的用户名

453216:hiveserver2用户密码vi hive-site.xml

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://hadoop01:3306/metastore?useSSL=false</value>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>offdb</value>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>123456</value>

</property>

<property>

<name>hive.metastore.warehouse.dir</name>

<value>/user/hive/warehouse</value>

</property>

<property>

<name>hive.metastore.schema.verification</name>

<value>false</value>

</property>

<property>

<name>hive.metastore.event.db.notification.api.auth</name>

<value>false</value>

</property>

<property>

<name>hive.cli.print.header</name>

<value>true</value>

</property>

<property>

<name>hive.cli.print.current.db</name>

<value>true</value>

</property>

<property>

<name>datanucleus.schema.autoCreateAll</name>

<value>true</value>

</property>

<property>

<name>hive.metastore.uris</name>

<value>thrift://hadoop01:9083</value>

</property>

<!--Hive执行引擎-->

<property>

<name>hive.execution.engine</name>

<value>mr</value>

</property>

<!--连接超时时间-->

<property>

<name>hive.spark.client.connect.timeout</name>

<value>300000ms</value>

</property>

<property>

<name>hive.spark.client.server.connect.timeout</name>

<value>300000ms</value>

</property>

<!--这是hiveserver2-->

<property>

<name>hive.server2.thrift.port</name>

<value>10000</value>

</property>

<property>

<name>hive.server2.thrift.bind.host</name>

<value>192.168.xxx.xxx</value>

</property>

<property>

<name>hive.server2.thrift.client.user</name>

<value>root</value>

<description>Username to use against thrift client</description>

</property>

<property>

<name>hive.server2.thrift.client.password</name>

<value>453216</value>

<description>Password to use against thrift client</description>

</property>

</configuration>

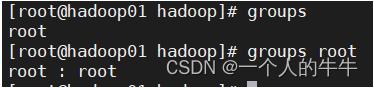

2.在hadoop的配置中添加hive远程连接

查看用户组

vi core-site.xml

<property>

<name>hadoop.proxyuser.root.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.root.groups</name>

<value>*</value>

</property>记得同步修改配置

3.重启Hadoop!

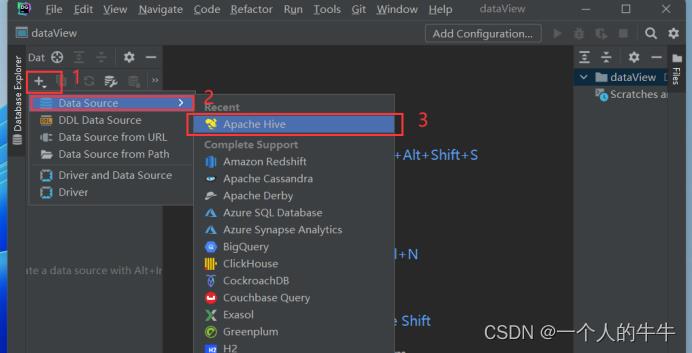

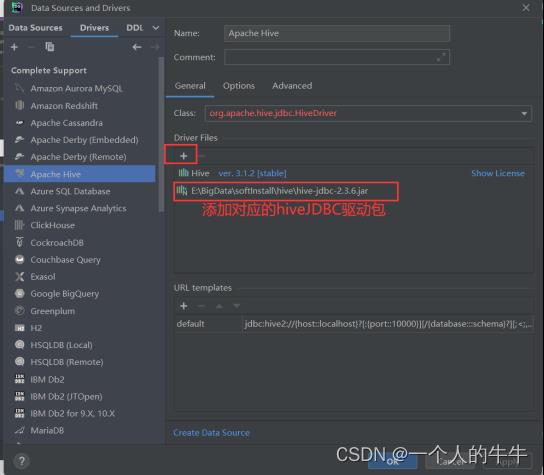

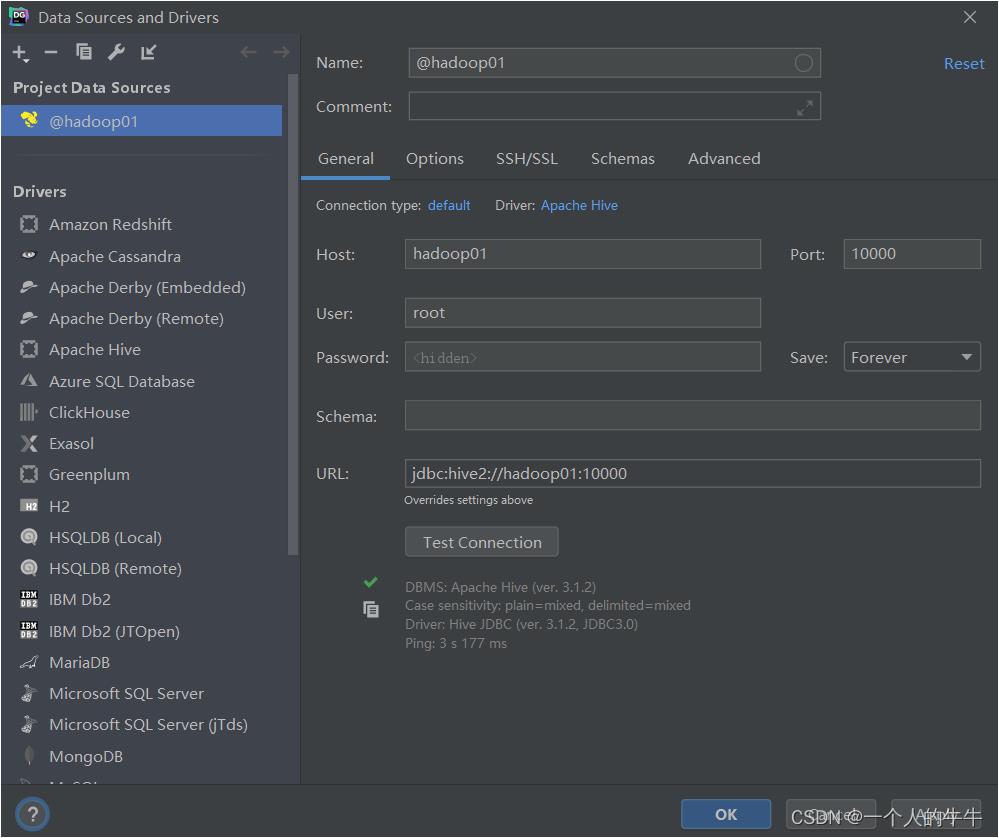

2.3datagrip连接hive

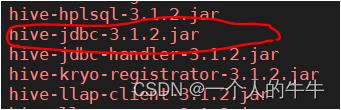

1.下载对应版本的jdbc驱动包

在hive的lib目录下下载hive-jdbc-3.1.2.jar

2.启动hiveserver2服务和metastore服务

nohup hive --service metastore &

nohup hive --service hiveserver2 &3.查看hiveserver2的端口号(没有就说明hiveserver2没有启动成功)

netstat -ntulp | grep 10000

4.查看hiveserver2和metastore的进程

jps查看

正常情况会出现两个runjar。

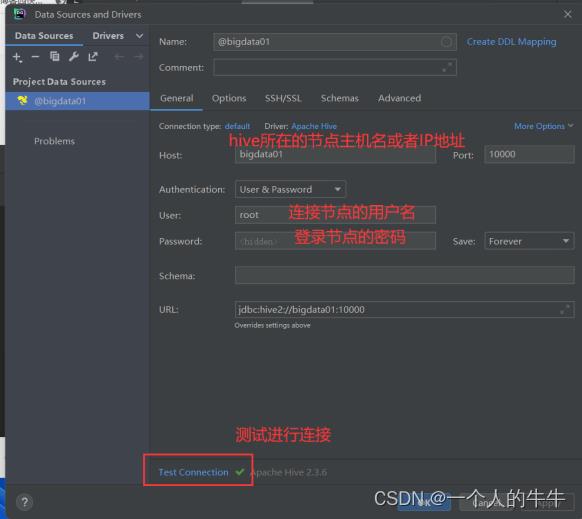

5.连接

输入正确的主机名、用户名、以及用户密码

test connection:测试连接

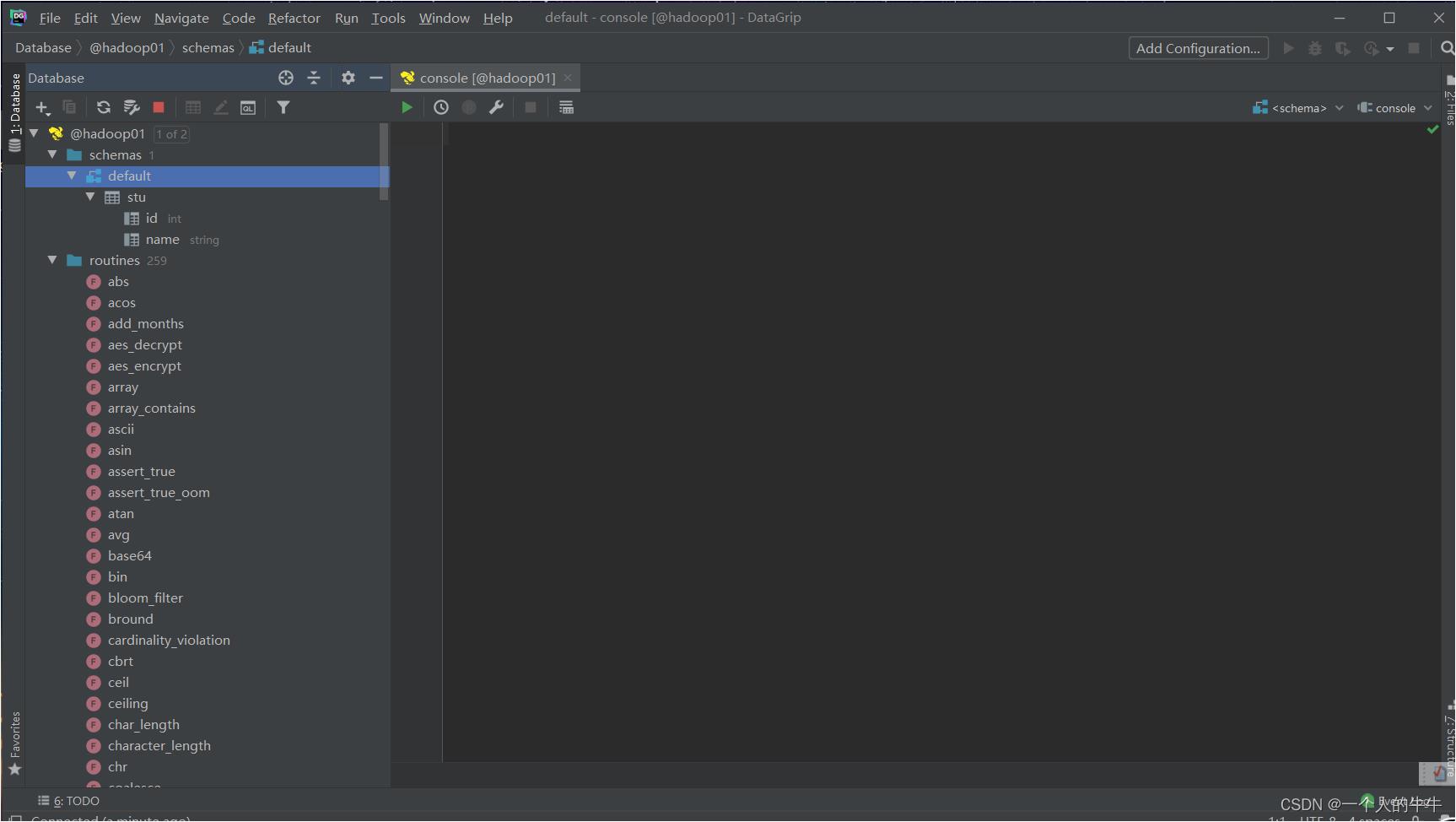

连接成功!!!!

连接成功!!!!

以上是关于安装datagrip以及datagrip连接hive的主要内容,如果未能解决你的问题,请参考以下文章