Linux小项目-行车记录仪项目设计

Posted DS小龙哥

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Linux小项目-行车记录仪项目设计相关的知识,希望对你有一定的参考价值。

1. 前言

行车记录这个设备相信大家应该都不陌生,它的功能主要是记录车辆行驶途中的影像及声音。

安装行车记录仪后,能够记录汽车行驶全过程的视频图像和声音,可为交通事故提供证据,喜欢自驾游的人,还可以用它来记录征服艰难险阻的过程。开车时边走边录像,同时把时间、速度、所在位置都记录在录像里,相当黑匣子。现在横穿马路的行车、摩托车,不交通规则形势的汽车也经常遇到,万一和他们产生了刮碰,有可能会被敲诈勒索,如果有了行车记录仪,司机可为自己提供有效的证据。

这篇文章就介绍在Linux最小系统开发板上如何实现行车记录仪的功能,开发板自带了8G的EMMC,也可以外扩SD卡。

首先,在设计行车记录仪这个项目之前,要先了解清楚行车记录仪的功能。

(1)行车记录运行起来后,需要间隔循环录制视频保存,一般是1~10分钟一段视频,这样设计的原理是方便按时间查找视频,也防止以为情况损坏视频编码, 导致视频无法正常播放。

(2)当车辆发生碰撞、急刹车等紧急情况下,自动录制视频当前时间段视频保存,方便后续直接查看。这个功能需要加速度计的支持,检测车辆的紧急刹车,碰撞等姿态。

当前项目里摄像头采用USB免驱摄像头替代,视频编码功能采用ffmpeg实现,所以需要交叉编译ffmpeg到嵌入式开发板上。

2. ffmpeg的交叉编译

ffmpeg下载地址: http://www.ffmpeg.org/download.html

[root@xl ffmpeg]# tar xvf ffmpeg-3.0.2.tar.bz2

[root@xl ffmpeg]# ./configure --disable-shared --enable-static --prefix=_install --cross-prefix=/work/arm-linux-gcc/opt/FriendlyARM/toolschain/4.5.1/bin/arm-linux- --arch=arm --target-os=linux --enable-gpl --disable-bzlib --disable-zlib --extra-cflags=-I/work/ffmpeg/x264/x264-snapshot-20160527-2245/_install/include/ --extra-ldflags=-L/work/ffmpeg/x264/x264-snapshot-20160527-2245/_install/lib --enable-ffserver --enable-ffmpeg --enable-libx264

[root@xl ffmpeg-3.0.2]# make && make install

编译ffmpeg还需要x264的库,编译ffmpeg前,需要先编译x264库。

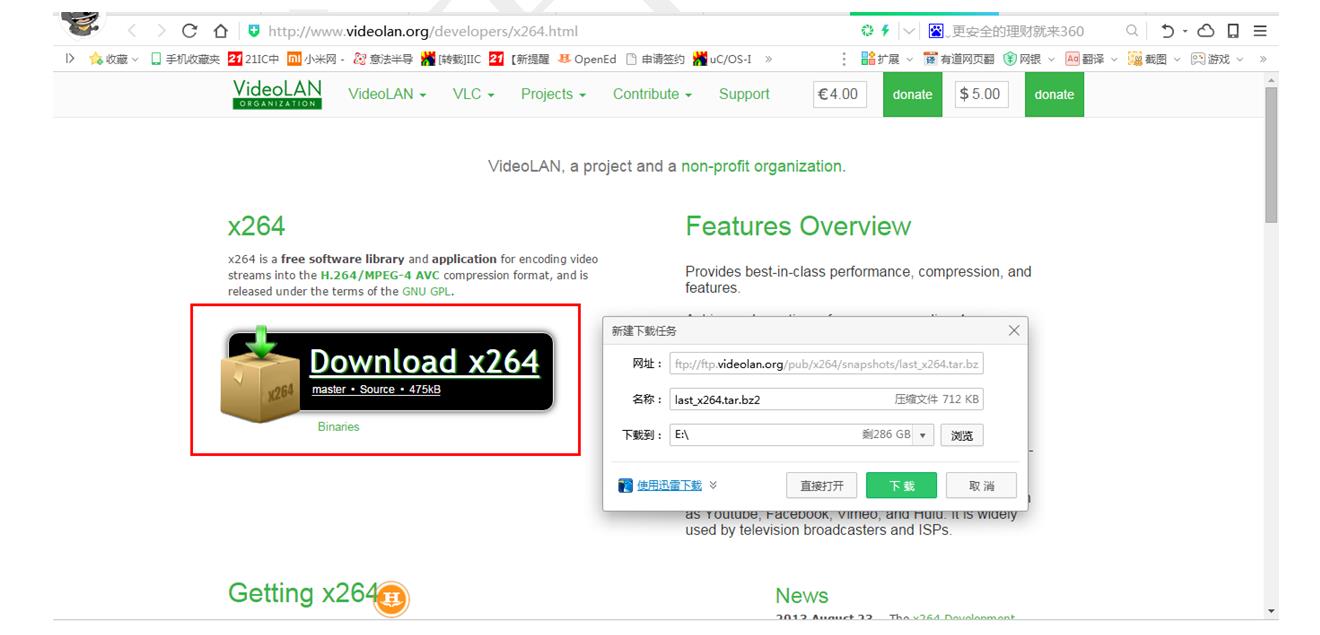

x264库下载地址: http://www.videolan.org/developers/x264.html

编译的步骤如下:

[root@xl x264]# tar -xjvf last_x264.tar.bz2

[root@xl x264-snapshot-20160527-2245]# ./configure --prefix=$PWD/_install --disable-asm

修改配置文件

[root@xl x264-snapshot-20160527-2245]# gedit config.mak

SYS_ARCH=X86改为ARCH=ARM

CC=gcc改为CC=arm-linux-gcc

LD=gcc -o改为LD=arm-linux-gcc -o

RANLIB=ranlib改为RANLIB=arm-linux-ranlib

AR=ar rc 改为AR=arm-linux-ar rc

取消两个选项

CFLAGS=-Wshadow -O3 -ffast-math -m32 -Wall -I. -I$(SRCPATH) -std=gnu99 -D_GNU_SOURCE -mpreferred-stack-boundary=5 -fomit-frame-pointer -fno-tree-vectorize

改为

CFLAGS=-Wshadow -O3 -ffast-math -Wall -I. -I$(SRCPATH) -std=gnu99 -D_GNU_SOURCE -fomit-frame-pointer -fno-tree-vectorize

[root@xl x264-snapshot-20160527-2245]# make && make install

3. 项目代码

下面的代码较多,直接将整份代码放在一个.c文件里,关于功能的解释在代码里都写了注释。

涉及到的技术有:ffmpeg的编码录制、声卡PCM数据采集,USB摄像头数据采集。

声卡的采集采用了alsa框架接口,USB摄像头使用的是V4L2框架接口。

下面代码实现的功能是10秒录制一段视频保存,视频文件名称使用时间命名,只是贴出了应用层的代码,加速度计mma766的驱动代码在上几篇文章里已经讲过了,这里就不再重复贴出来了。

具体实现的代码如下:

#include <stdlib.h>

#include <stdio.h>

#include <string.h>

#include <math.h>

#include <time.h>

#include <libavutil/avassert.h>

#include <libavutil/channel_layout.h>

#include <libavutil/opt.h>

#include <libavutil/mathematics.h>

#include <libavutil/timestamp.h>

#include <libavformat/avformat.h>

#include <libswscale/swscale.h>

#include <libswresample/swresample.h>

#include <stdio.h>

#include <sys/ioctl.h>

#include <linux/videodev2.h>

#include <string.h>

#include <sys/types.h>

#include <sys/stat.h>

#include <fcntl.h>

#include <sys/mman.h>

#include <poll.h>

#include <stdlib.h>

#include <stdio.h>

#include <sys/types.h>

#include <sys/socket.h>

#include <arpa/inet.h>

#include <pthread.h>

#include <signal.h>

#include <unistd.h>

#include <string.h>

#include <stdio.h>

#include <stdlib.h>

#include <alsa/asoundlib.h>

#include <signal.h>

#include <pthread.h>

#define STREAM_DURATION 10.0 /*录制10秒的视频,由于缓冲的原因,一般只有8秒*/

#define STREAM_FRAME_RATE 15 /* 15 images/s avfilter_get_by_name */

#define STREAM_PIX_FMT AV_PIX_FMT_YUV420P /* default pix_fmt */

#define SCALE_FLAGS SWS_BICUBIC

//固定摄像头输出画面的尺寸

#define VIDEO_WIDTH 640

#define VIDEO_HEIGHT 480

//存放从摄像头读出转换之后的数据

unsigned char YUV420P_Buffer[VIDEO_WIDTH*VIDEO_HEIGHT*3/2];

unsigned char YUV420P_Buffer_temp[VIDEO_WIDTH*VIDEO_HEIGHT*3/2];

/*一些摄像头需要使用的全局变量*/

unsigned char *image_buffer[4];

int video_fd;

pthread_mutex_t mutex;

pthread_cond_t cond;

/*一些audio需要使用的全局变量*/

pthread_mutex_t mutex_audio;

extern int capture_audio_data_init( char *audio_dev);

extern int capture_audio_data(snd_pcm_t *capture_handle,int buffer_frames);

/*

进行音频采集,采集pcm数据并直接保存pcm数据

音频参数:

声道数: 2

采样位数: 16bit、LE格式

采样频率: 44100Hz

*/

#define AudioFormat SND_PCM_FORMAT_S16_LE //指定音频的格式,其他常用格式:SND_PCM_FORMAT_U24_LE、SND_PCM_FORMAT_U32_LE

#define AUDIO_CHANNEL_SET 1 //1单声道 2立体声

#define AUDIO_RATE_SET 44100 //音频采样率,常用的采样频率: 44100Hz 、16000HZ、8000HZ、48000HZ、22050HZ

FILE *pcm_data_file=NULL;

int buffer_frames;

snd_pcm_t *capture_handle;

snd_pcm_format_t format=AudioFormat;

//保存音频数据链表

struct AUDIO_DATA

unsigned char* audio_buffer;

struct AUDIO_DATA *next;

;

//定义一个链表头

struct AUDIO_DATA *list_head=NULL;

struct AUDIO_DATA *List_CreateHead(struct AUDIO_DATA *head);

void List_AddNode(struct AUDIO_DATA *head,unsigned char* audio_buffer);

void List_DelNode(struct AUDIO_DATA *head,unsigned char* audio_buffer);

int List_GetNodeCnt(struct AUDIO_DATA *head);

// 单个输出AVStream的包装器

typedef struct OutputStream

AVStream *st;

AVCodecContext *enc;

/* 下一帧的点数*/

int64_t next_pts;

int samples_count;

AVFrame *frame;

AVFrame *tmp_frame;

float t, tincr, tincr2;

struct SwsContext *sws_ctx;

struct SwrContext *swr_ctx;

OutputStream;

static int write_frame(AVFormatContext *fmt_ctx, const AVRational *time_base, AVStream *st, AVPacket *pkt)

/*将输出数据包时间戳值从编解码器重新调整为流时基 */

av_packet_rescale_ts(pkt, *time_base, st->time_base);

pkt->stream_index = st->index;

/*将压缩的帧写入媒体文件*/

return av_interleaved_write_frame(fmt_ctx, pkt);

/* 添加输出流。 */

static void add_stream(OutputStream *ost, AVFormatContext *oc,

AVCodec **codec,

enum AVCodecID codec_id)

AVCodecContext *c;

int i;

/* find the encoder */

*codec = avcodec_find_encoder(codec_id);

if (!(*codec))

fprintf(stderr, "Could not find encoder for '%s'\\n",

avcodec_get_name(codec_id));

exit(1);

ost->st = avformat_new_stream(oc, NULL);

if (!ost->st)

fprintf(stderr, "Could not allocate stream\\n");

exit(1);

ost->st->id = oc->nb_streams-1;

c = avcodec_alloc_context3(*codec);

if (!c)

fprintf(stderr, "Could not alloc an encoding context\\n");

exit(1);

ost->enc = c;

switch ((*codec)->type)

case AVMEDIA_TYPE_AUDIO:

c->sample_fmt = (*codec)->sample_fmts ? (*codec)->sample_fmts[0] : AV_SAMPLE_FMT_FLTP;

c->bit_rate = 64000; //设置码率

c->sample_rate = 44100; //音频采样率

c->channels= av_get_channel_layout_nb_channels(c->channel_layout);

c->channel_layout = AV_CH_LAYOUT_MONO; AV_CH_LAYOUT_MONO 单声道 AV_CH_LAYOUT_STEREO 立体声

c->channels = av_get_channel_layout_nb_channels(c->channel_layout);

ost->st->time_base = (AVRational) 1, c->sample_rate ;

break;

case AVMEDIA_TYPE_VIDEO:

c->codec_id = codec_id;

//码率:影响体积,与体积成正比:码率越大,体积越大;码率越小,体积越小。

c->bit_rate = 400000; //设置码率 400kps

/*分辨率必须是2的倍数。 */

c->width =VIDEO_WIDTH;

c->height = VIDEO_HEIGHT;

/*时基:这是基本的时间单位(以秒为单位)

*表示其中的帧时间戳。 对于固定fps内容,

*时基应为1 / framerate,时间戳增量应为

*等于1。*/

ost->st->time_base = (AVRational)1,STREAM_FRAME_RATE;

c->time_base = ost->st->time_base;

c->gop_size = 12; /* 最多每十二帧发射一帧内帧 */

c->pix_fmt = STREAM_PIX_FMT;

c->max_b_frames = 0; //不要B帧

if (c->codec_id == AV_CODEC_ID_MPEG1VIDEO)

c->mb_decision = 2;

break;

default:

break;

/* 某些格式希望流头分开。 */

if (oc->oformat->flags & AVFMT_GLOBALHEADER)

c->flags |= AV_CODEC_FLAG_GLOBAL_HEADER;

/**************************************************************/

/* audio output */

static AVFrame *alloc_audio_frame(enum AVSampleFormat sample_fmt,

uint64_t channel_layout,

int sample_rate, int nb_samples)

AVFrame *frame = av_frame_alloc();

frame->format = sample_fmt;

frame->channel_layout = channel_layout;

frame->sample_rate = sample_rate;

frame->nb_samples = nb_samples;

if(nb_samples)

av_frame_get_buffer(frame, 0);

return frame;

static void open_audio(AVFormatContext *oc, AVCodec *codec, OutputStream *ost, AVDictionary *opt_arg)

AVCodecContext *c;

int nb_samples;

int ret;

AVDictionary *opt = NULL;

c = ost->enc;

av_dict_copy(&opt, opt_arg, 0);

ret = avcodec_open2(c, codec, &opt);

av_dict_free(&opt);

/*下面3行代码是为了生成虚拟的声音设置的频率参数*/

ost->t = 0;

ost->tincr = 2 * M_PI * 110.0 / c->sample_rate;

ost->tincr2 = 2 * M_PI * 110.0 / c->sample_rate / c->sample_rate;

//AAC编码这里就固定为1024

nb_samples = c->frame_size;

ost->frame = alloc_audio_frame(c->sample_fmt, c->channel_layout,

c->sample_rate, nb_samples);

ost->tmp_frame = alloc_audio_frame(AV_SAMPLE_FMT_S16, c->channel_layout,

c->sample_rate, nb_samples);

/* copy the stream parameters to the muxer */

avcodec_parameters_from_context(ost->st->codecpar, c);

/* create resampler context */

ost->swr_ctx = swr_alloc();

/* set options */

printf("c->channels=%d\\n",c->channels);

av_opt_set_int (ost->swr_ctx, "in_channel_count", c->channels, 0);

av_opt_set_int (ost->swr_ctx, "in_sample_rate", c->sample_rate, 0);

av_opt_set_sample_fmt(ost->swr_ctx, "in_sample_fmt", AV_SAMPLE_FMT_S16, 0);

av_opt_set_int (ost->swr_ctx, "out_channel_count", c->channels, 0);

av_opt_set_int (ost->swr_ctx, "out_sample_rate", c->sample_rate, 0);

av_opt_set_sample_fmt(ost->swr_ctx, "out_sample_fmt", c->sample_fmt, 0);

/* initialize the resampling context */

swr_init(ost->swr_ctx);

/* 毫秒级 延时 */

void Sleep(int ms)

struct timeval delay;

delay.tv_sec = 0;

delay.tv_usec = ms * 1000; // 20 ms

select(0, NULL, NULL, NULL, &delay);

/*

准备虚拟音频帧

这里可以替换成从声卡读取的PCM数据

*/

static AVFrame *get_audio_frame(OutputStream *ost)

AVFrame *frame = ost->tmp_frame;

int j, i, v;

int16_t *q = (int16_t*)frame->data[0];

/* 检查我们是否要生成更多帧,用于判断是否结束*/

if (av_compare_ts(ost->next_pts, ost->enc->time_base,STREAM_DURATION, (AVRational) 1, 1 ) >= 0)

return NULL;

#if 1

//获取链表节点数量

int cnt=0;

while(cnt<=0)

cnt=List_GetNodeCnt(list_head);

pthread_mutex_lock(&mutex_audio); /*互斥锁上锁*/

//得到节点数据

struct AUDIO_DATA *tmp=list_head;

unsigned char *buffer;

tmp=tmp->next;

if(tmp==NULL)

printf("数据为NULL.\\n");

exit(0);

buffer=tmp->audio_buffer;

//1024*16*1

memcpy(q,buffer,frame->nb_samples*sizeof(int16_t)*ost->enc->channels);//将音频数据拷贝进入frame缓冲区

List_DelNode(list_head,buffer);

free(buffer);

pthread_mutex_unlock(&mutex_audio); /*互斥锁解锁*/

#endif

frame->pts = ost->next_pts;

ost->next_pts += frame->nb_samples;

return frame;

/*

*编码一个音频帧并将其发送到多路复用器

*编码完成后返回1,否则返回0

*/

static int write_audio_frame(AVFormatContext *oc, OutputStream *ost)

AVCodecContext *c;

AVPacket pkt = 0 ;

AVFrame *frame;

int ret;

int got_packet;

int dst_nb_samples;

av_init_packet(&pkt);

c = ost->enc;

frame = get_audio_frame(ost);

if(frame