MLPs+ESN利用多层感知机MLPs对经典ESN(回声状态网络)的输出权值计算进行优化的MATLAB仿真

Posted fpga&matlab

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了MLPs+ESN利用多层感知机MLPs对经典ESN(回声状态网络)的输出权值计算进行优化的MATLAB仿真相关的知识,希望对你有一定的参考价值。

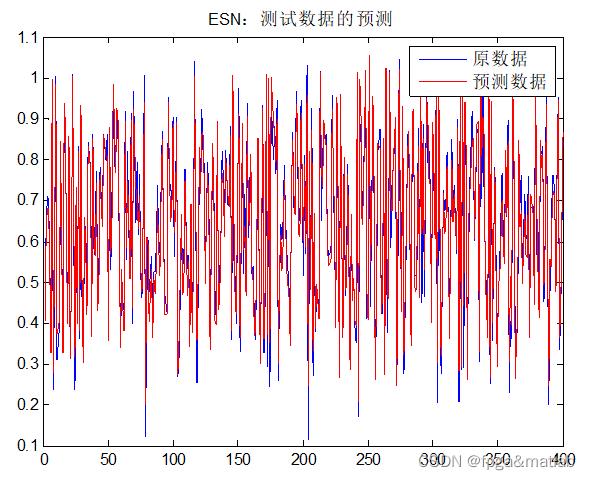

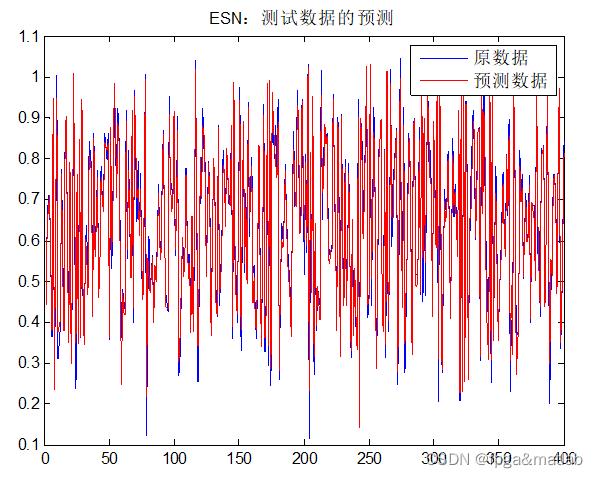

单独的ESN仿真:

ESN的运行结果如下所示:

这个部分的误差为:

0.0435

ESN部分就不多做介绍了,你应该了解的,下面我们对ESN和BP改进和极限学习改进分别进行修改和说明,并进行仿真。

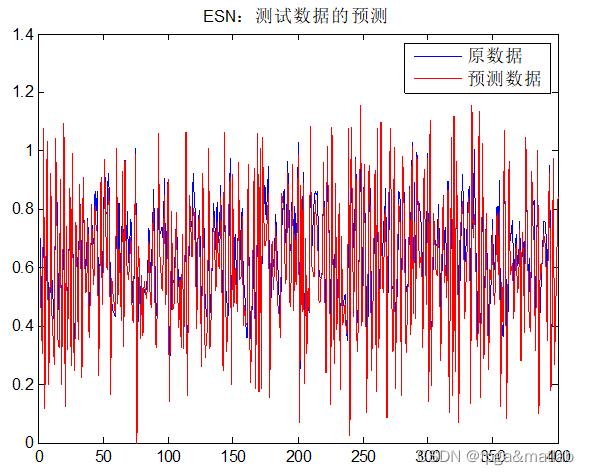

ESN+BP的仿真:

首先,在原始的ESN中,权值的计算是通过pseudoinverse.m这个函数进行计算的,其主要内容就是:

即:

这里,我们的主要方法为:

将 计算得到的权值作为bp神经网络迭代的初始值,然后以这个初始值为迭代过程的第一个值,不断的训练迭代,最后得到ESN-BP输出的权值,然后进行测试。

计算得到的权值作为bp神经网络迭代的初始值,然后以这个初始值为迭代过程的第一个值,不断的训练迭代,最后得到ESN-BP输出的权值,然后进行测试。

因此,其基本思路就是通过B-1T得到初始权值,然后通过bp网络进行迭代,得到最后优化后的值。

计算后的误差为0.0427

从上面的对比可知,采用BP神经网络进行权值系数的非线性更新之后,其误差可以进一步降低。但提升性能有限。

ESN+极限学习算法的仿真:

这个部分的原理和上面的相同,不同的是,我们需要使用极限学习方法对ESN网络的中的权值进行更新。

误差为:0.1050

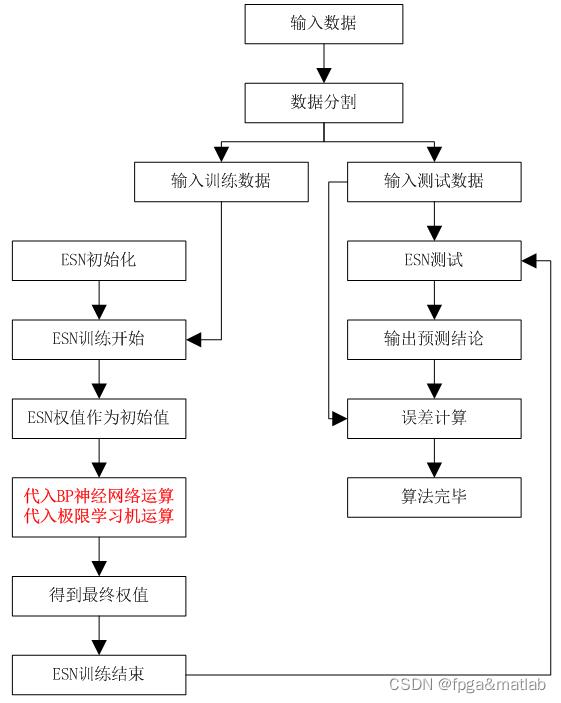

下面给出整个算法的流程框图:

2.部分核心代码

clc;

clear;

close all;

warning off;

RandStream.setDefaultStream(RandStream('mt19937ar','seed',1));

addpath 'func\\data_process\\'

addpath 'func\\Initial_ESN\\'

addpath 'func\\train_esn\\'

addpath 'func\\test_esn\\'

load data.mat

%数据分割

train_fraction = 0.5;

[trainInputSequence, testInputSequence] = split_train_test(inputSequence,train_fraction);

[trainOutputSequence,testOutputSequence] = split_train_test(outputSequence,train_fraction);

%generate an esn

nInputUnits = 2;

nInternalUnits = 32;

nOutputUnits = 1;

esn = generate_esn(nInputUnits,nInternalUnits,nOutputUnits,'spectralRadius',0.5,'inputScaling',[0.1;0.1],'inputShift',[0;0],'teacherScaling',[0.3],'teacherShift',[-0.2],'feedbackScaling',0,'type','plain_esn');

esn.internalWeights = esn.spectralRadius * esn.internalWeights_UnitSR;

%train the ESN

%discard the first 100 points

nForgetPoints = 100;

%这里,就固定设置一种默认的学习方式,其他的就注释掉了

[trainedEsn,stateMatrix] = train_esn(trainInputSequence,trainOutputSequence,esn,nForgetPoints) ;

%test the ESN

nForgetPoints = 100 ;

predictedTrainOutput = test_esn(trainInputSequence, trainedEsn, nForgetPoints);

predictedTestOutput = test_esn(testInputSequence, trainedEsn, nForgetPoints) ;

figure;

plot(testOutputSequence(nForgetPoints+4:end),'b');

hold on

plot(predictedTestOutput,'r');

legend('原数据','预测数据');

title('ESN-ELM:测试数据的预测');

%计算测试数据的预测结果:

estimatedOutput = predictedTestOutput(1:end-3);

correctOutput = testOutputSequence(nForgetPoints+4:end);

nEstimatePoints = length(estimatedOutput) ;

nForgetPoints = length(correctOutput) - nEstimatePoints ;

correctVariance = 1;

meanerror = sum((estimatedOutput - correctOutput).^2)/nEstimatePoints ;

err =(sqrt(meanerror./correctVariance));

err

3.参考文献

A05-22

以上是关于MLPs+ESN利用多层感知机MLPs对经典ESN(回声状态网络)的输出权值计算进行优化的MATLAB仿真的主要内容,如果未能解决你的问题,请参考以下文章