数据治理:Atlas搭建启动

Posted Lansonli

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了数据治理:Atlas搭建启动相关的知识,希望对你有一定的参考价值。

目录

3、修改 atlas-application.properties 配置文件

Atlas搭建启动

一、Atlas配置

这里安装Atlas选择单节点安装,一般公司使用单节点即可。安装步骤如下:

1、移动Atlas编译好的安装包

将编译好的Atlas安装包移动到/software下进入“/software/apache-atlas-sources-2.1.0/distro/target/apache-atlas-2.1.0-bin”路径下,将“apache-atlas-2.1.0”移动到“/software”下

[root@node3 ~]# cd /software/apache-atlas-sources-2.1.0/distro/target/apache-atlas-2.1.0-bin

[root@node3 apache-atlas-2.1.0-bin]# mv ./apache-atlas-2.1.0/ /software/2、修改atlas-env.sh配置文件

修改“$ATLAS_HOME/conf/atlas-env.sh”配置文件:

#配置Java home

export JAVA_HOME=/usr/java/jdk1.8.0_181-amd64/

#如果想要使用外部的HBase 改成false

export MANAGE_LOCAL_HBASE=false

#添加HBase 配置文件路径

export HBASE_CONF_DIR=/software/hbase-2.2.6/conf/

#如果想要使用外部的SOLR 改成false

export MANAGE_LOCAL_SOLR=false3、修改 atlas-application.properties 配置文件

修改“$ATLAS_HOME/conf/atlas-application.properties”配置文件:

#Hbase地址(对应的zk地址)配置(自带hbase会根据此端口启动一个zk实例)

#如果使用外部HBase,则填写外部zookeeper地址

atlas.graph.storage.hostname=node3:2181,node4:2181,node5:2181

#配置 Solr 的Zookeeper地址

atlas.graph.index.search.solr.zookeeper-url=node3:2181,node4:2181,node5:2181

#Solr地址配置

atlas.graph.index.search.solr.http-urls=http://node3:8983/solr

# Kafka相关配置,如果要使用外部的kafka,则改为false

atlas.notification.embedded=false

#内嵌kafka会根据此端口启动一个zk实例,如果使用外部kafka,

#则填写外部zookeeper地址

atlas.kafka.zookeeper.connect=node3:2181,node4:2181,node5:2181

#如果使用外部kafka,则填写外部broker server地址

atlas.kafka.bootstrap.servers=node1:9092,node2:9092,node3:9092

#访问Atlas webui 路径

atlas.rest.address=http://node3:21000二、Atlas启动

1、启动HDFS集群

#所有Zookeeper节点启动zookeeper

zkServer.sh start

#node1节点启动HDFS

[root@node1 ~]# start-all.sh2、启动HBASE集群

#node4节点上启动HBase集群

[root@node4 bin]# start-hbase.sh3、启动Kafka集群

#在Kafka每台节点上启动Kafka,这里Kafka节点为node1,node2,node3

cd /software/kafka_2.11-0.11.0.3

./startKafka.sh 4、启动Solr集群 并创建索引

#在每台Solr节点上启动Solr,Solr节点为node3,node4,node5

cd /software/solr-5.5.1/bin/

./solr start访问solr WebUI - http://node3:8983

#在Solr中执行如下创建索引命令,只需要执行一次即可

[root@node3 ~]# cd /software/solr-5.5.1/bin

[root@node3 bin]# solr create -c vertex_index -shards 3 -replicationFactor 1

[root@node3 bin]# solr create -c edge_index -shards 3 -replicationFactor 1

[root@node3 bin]# solr create -c fulltext_index -shards 3 -replicationFactor 1注意:如果以上创建错误,可以使用命令“solr delete -c $collection_name”删除重新创建。

5、启动Atlas

进入到“/software/apache-atlas-2.1.0/bin”目录下,执行以下命令启动atlas。

[root@node3 ~]# cd /software/apache-atlas-2.1.0/bin

#启动Atlas

[root@node3 bin]# ./atlas_start.py

starting atlas on host localhost

starting atlas on port 21000

...........................................................

Apache Atlas Server started!!!

注意:首次启动Atlas,出现“Apache Atlas Server started!!!”大约再等5分钟才能查看WebUI页面。如果出现错误日志在“$ATLAS_HOME/logs/”目录下,“application.log”和“atlas.xxx-xxx.err”日志文件中。

可以通过监控日志来查看是否启动完成,标志是日志不再动:

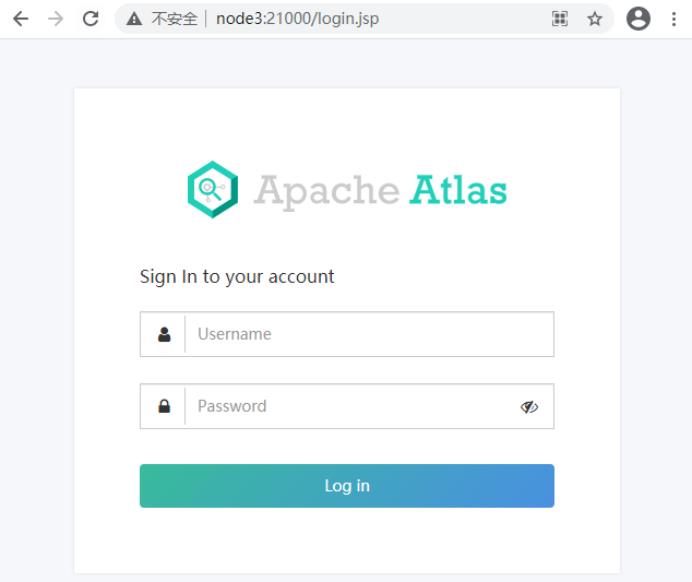

[root@node3 ~]# tail -f /software/apache-atlas-2.1.0/logs/application.log 6、访问Atlas :http://node3:21000

账号:admin,密码:admin,直接登录即可。

7、停止Atlas

[root@node3 ~]# cd /software/apache-atlas-2.1.0/bin

[root@node3 bin]# ./atlas_stop.py- 📢博客主页:https://lansonli.blog.csdn.net

- 📢欢迎点赞 👍 收藏 ⭐留言 📝 如有错误敬请指正!

- 📢本文由 Lansonli 原创,首发于 CSDN博客🙉

- 📢大数据系列文章会每天更新,停下休息的时候不要忘了别人还在奔跑,希望大家抓紧时间学习,全力奔赴更美好的生活✨

以上是关于数据治理:Atlas搭建启动的主要内容,如果未能解决你的问题,请参考以下文章