Reinforcement Learning强化学习系列之五:值近似方法Value Approximation

Posted luchi007

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Reinforcement Learning强化学习系列之五:值近似方法Value Approximation相关的知识,希望对你有一定的参考价值。

引言

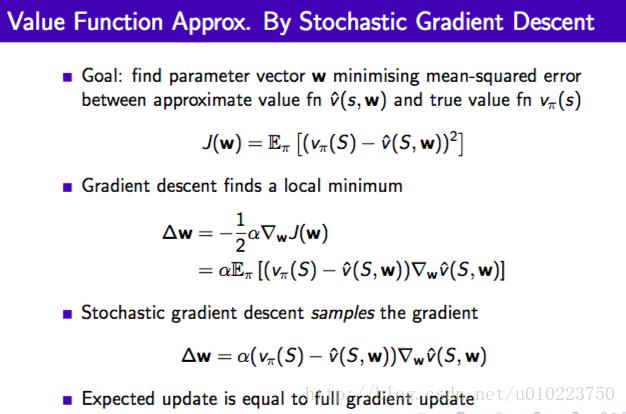

前面说到了强化学习中的蒙特卡洛方法(MC)以及时序差分(TD)的方法,这些方法针对的基本是离散的数据,而一些连续的状态则很难表示,对于这种情况,通常在强化学习里有2中方法,一种是针对value function的方法,也就是本文中提到的值近似(value approximation);另一种则是后面要讲到的policy gradient。

值近似的方法

值近似的方法根本上是使用一个值函数来近似表示该状态的返回值,对于状态

以上是关于Reinforcement Learning强化学习系列之五:值近似方法Value Approximation的主要内容,如果未能解决你的问题,请参考以下文章

强化学习专栏——Reinforcement Learning

Reinforcement Learning强化学习系列之一:model-based learning