Azure Data PlatformETL工具——ADF 数据集和链接服务

Posted 發糞塗牆

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Azure Data PlatformETL工具——ADF 数据集和链接服务相关的知识,希望对你有一定的参考价值。

本文属于【Azure Data Platform】系列。

接上文:【Azure Data Platform】ETL工具(7)——ADF copy data 详解

本文介绍ADF 的数据集 和链接服务

简述

ADF是主要用于处理数据的,处理数据得有源和目标。基于大数据云计算时代的普及, 数据源和目标已经广泛分布在全球各地,也包含了云和本地。

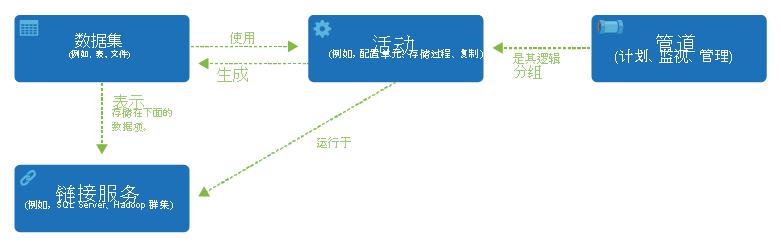

前面提到,ADF是以管道为基础运行的,而管道在运行时,会对数据进行操作,那这些“数据”怎么定义?这就涉及到数据集。数据集定义了数据的输出和输入。识别不同的数据源中的数据。

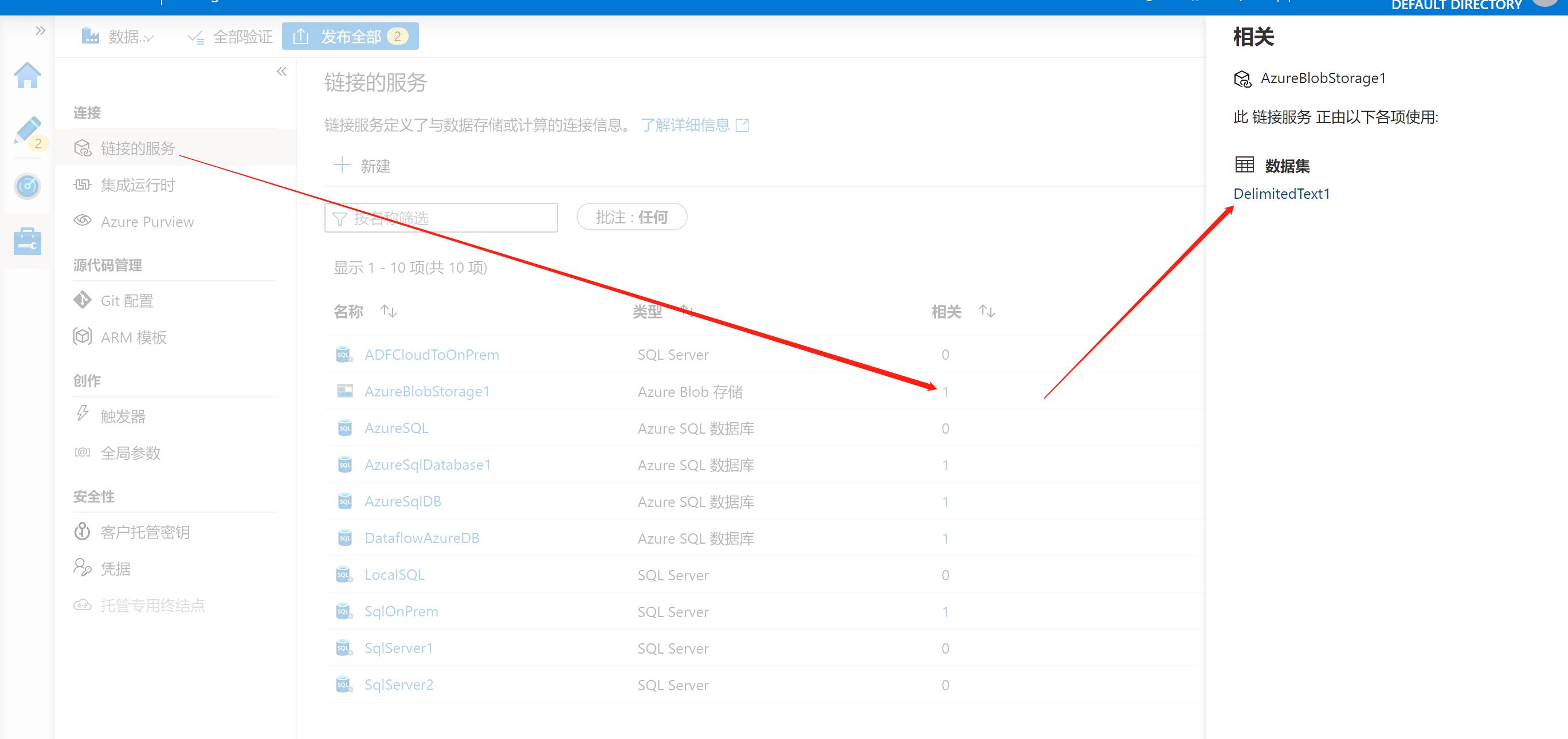

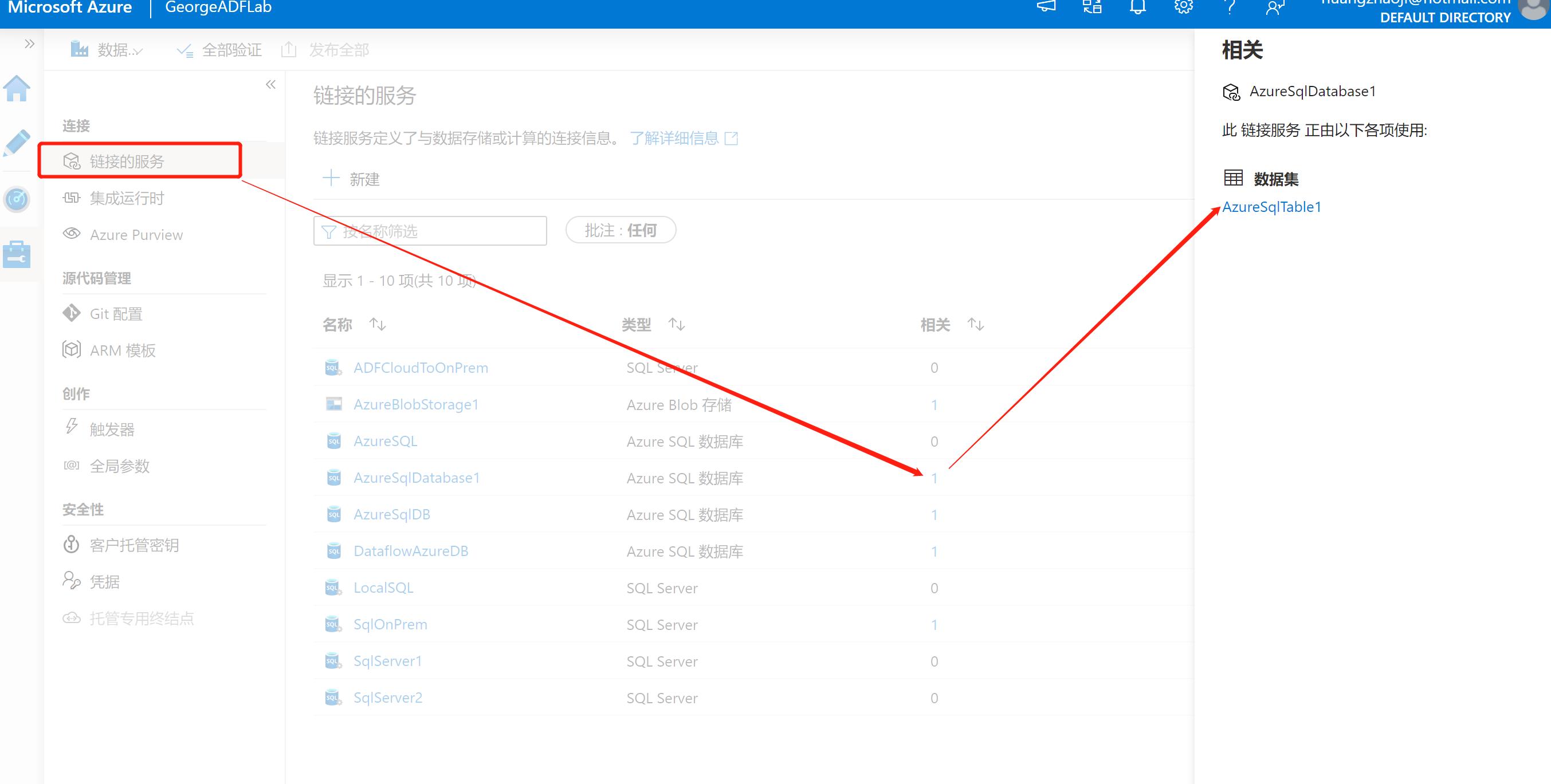

谈到数据集前,先要说一下链接服务(中文版的ADF称之为链接的服务,不过本人更加倾向于使用链接服务(linked services))。它把数据存储与服务连接起来,链接服务类似于连接字符串。定义了外部访问数据的必要信息。数据集代表链接的数据存储中的数据结构,而链接服务则定义到数据源的连接。

最常见的案例是从Blob中复制数据到SQL DB中, 那么就需要创建两个链接服务(1个是创建给Blob,1个是SQL DB), 然后两个数据集(1个定义blob文件的格式,1个是定义Azure DB中的数据表)

下图显示了管道、活动、数据集和链接服务之间的关系:

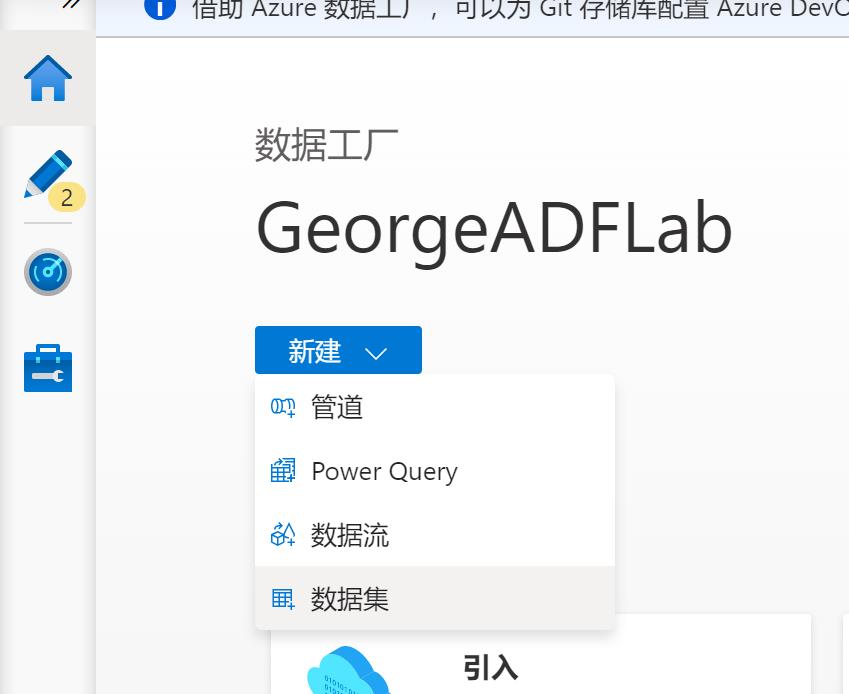

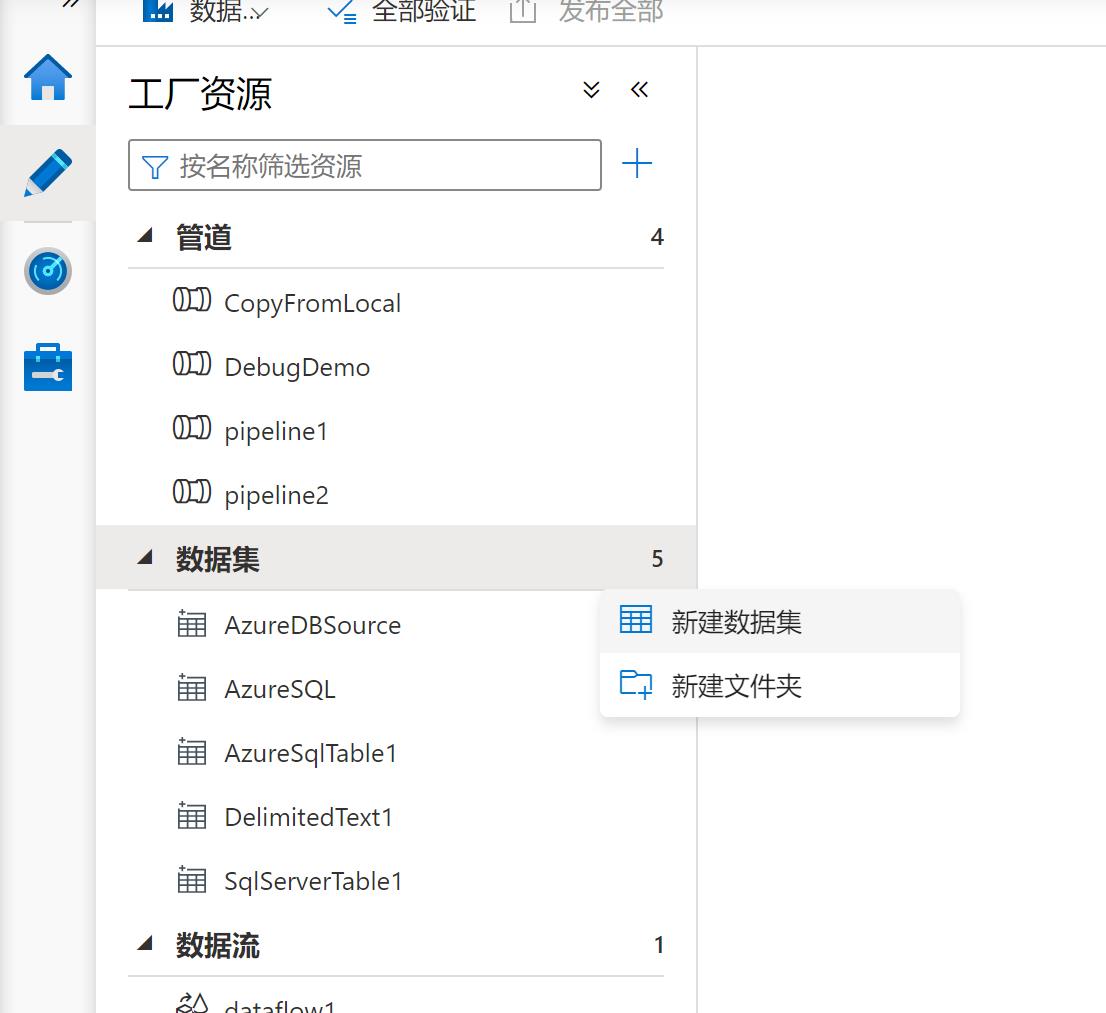

新建数据集

可以在不同的地方创建数据集:

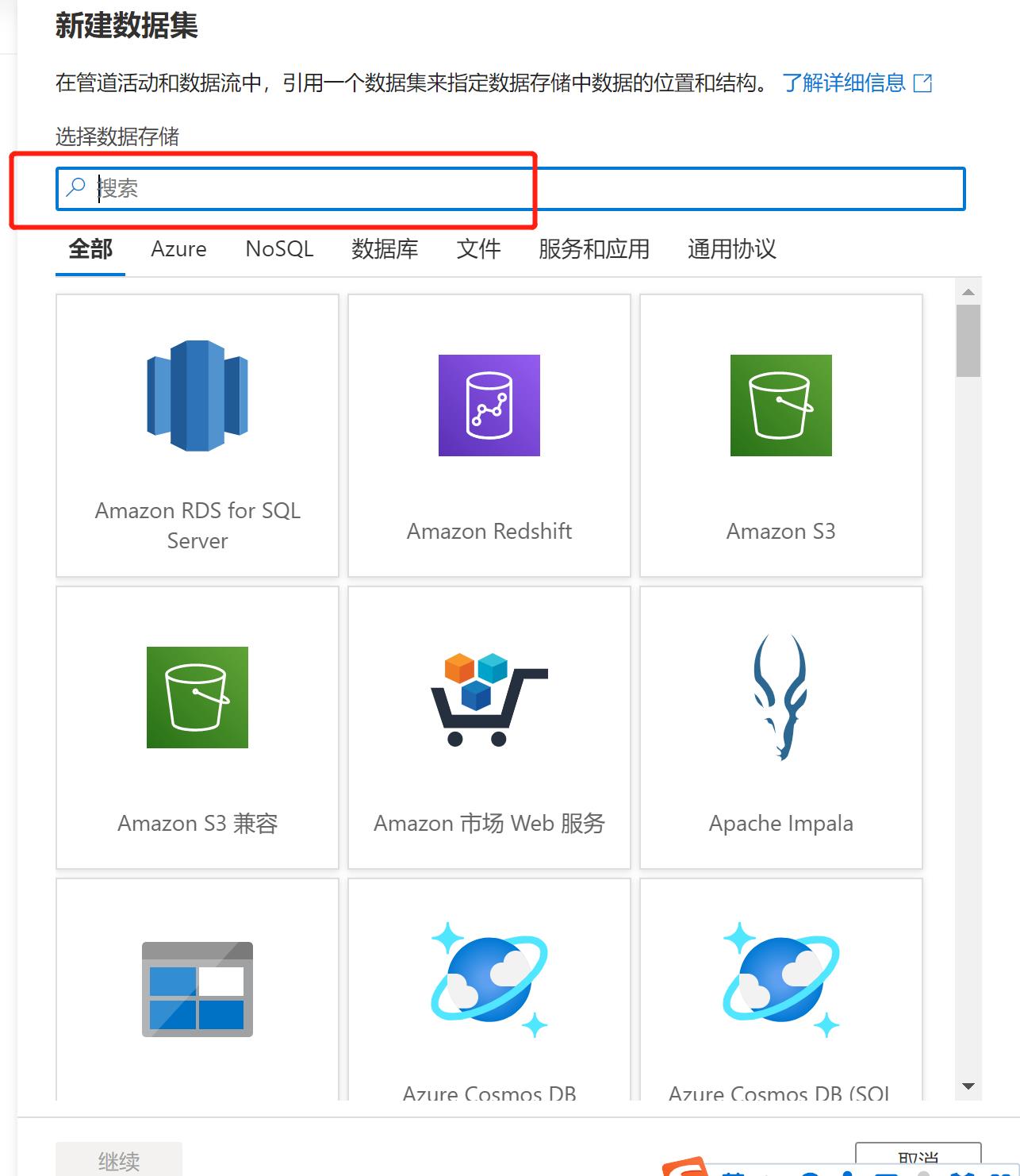

由于数据集的种类很多,通常搜索出来会更加快。

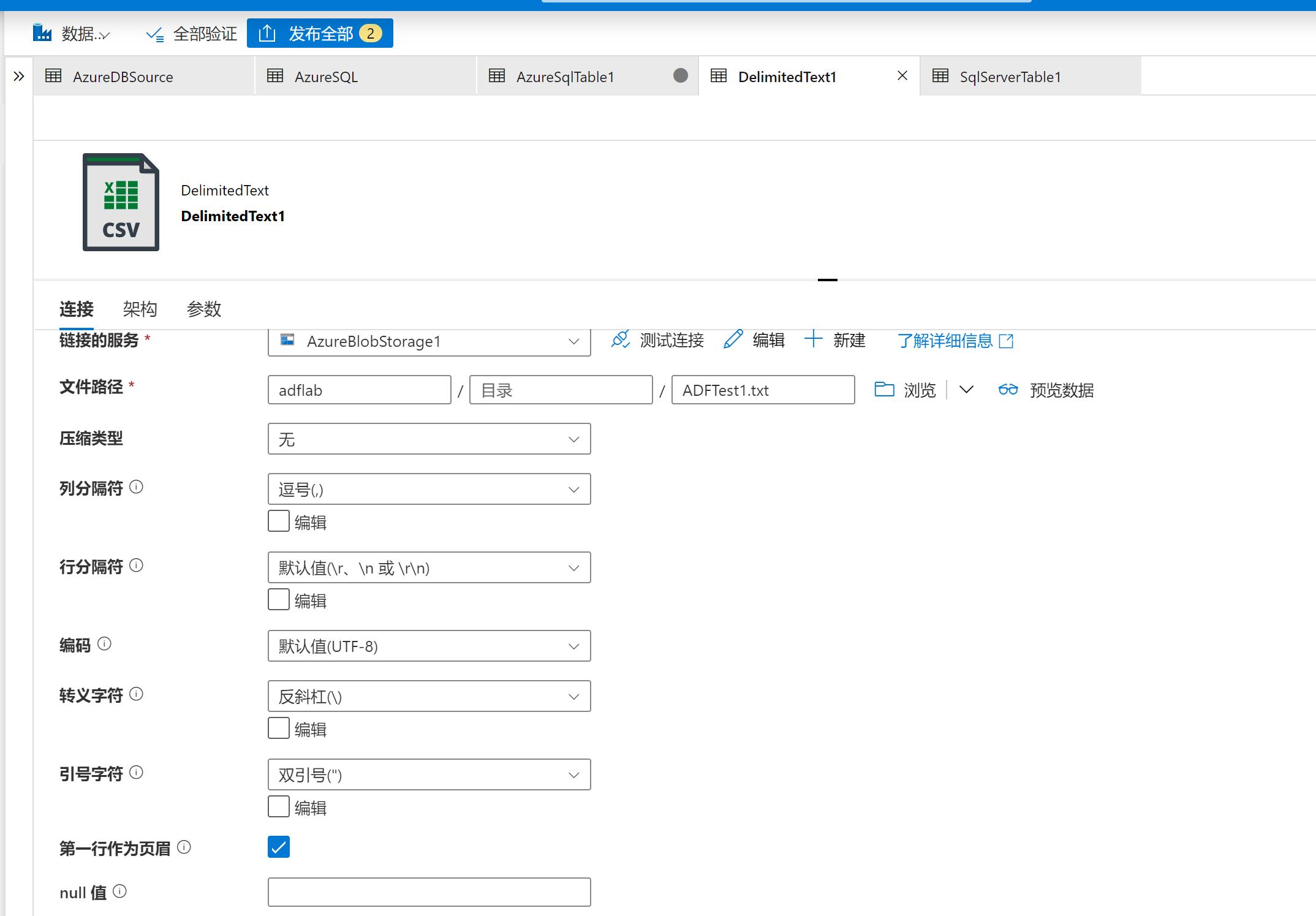

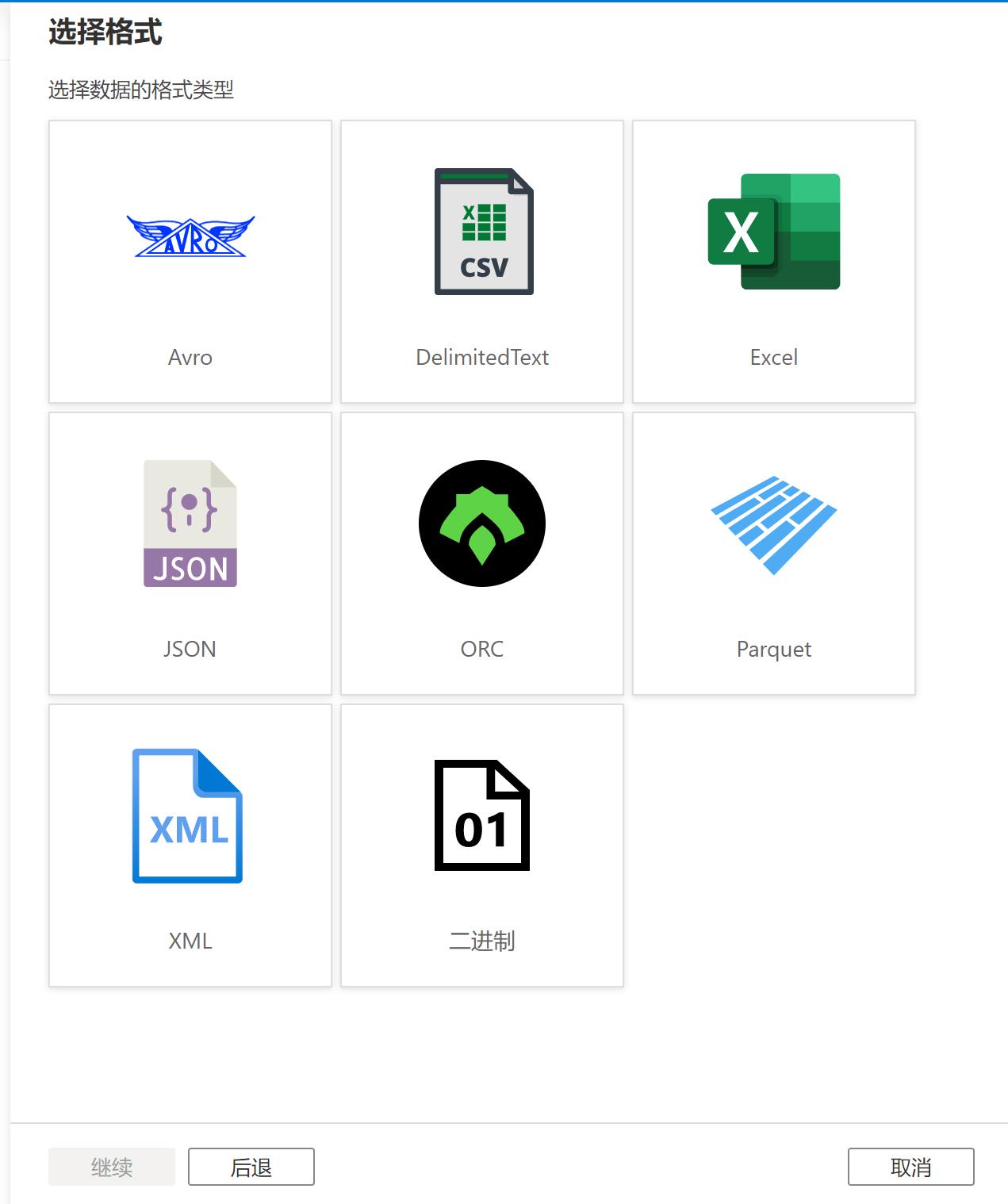

当选择了特定的数据集之后,根据其种类,还会有其他的选择,比如选择了Blob存储,下一步就是存储中的数据格式类型的选择:

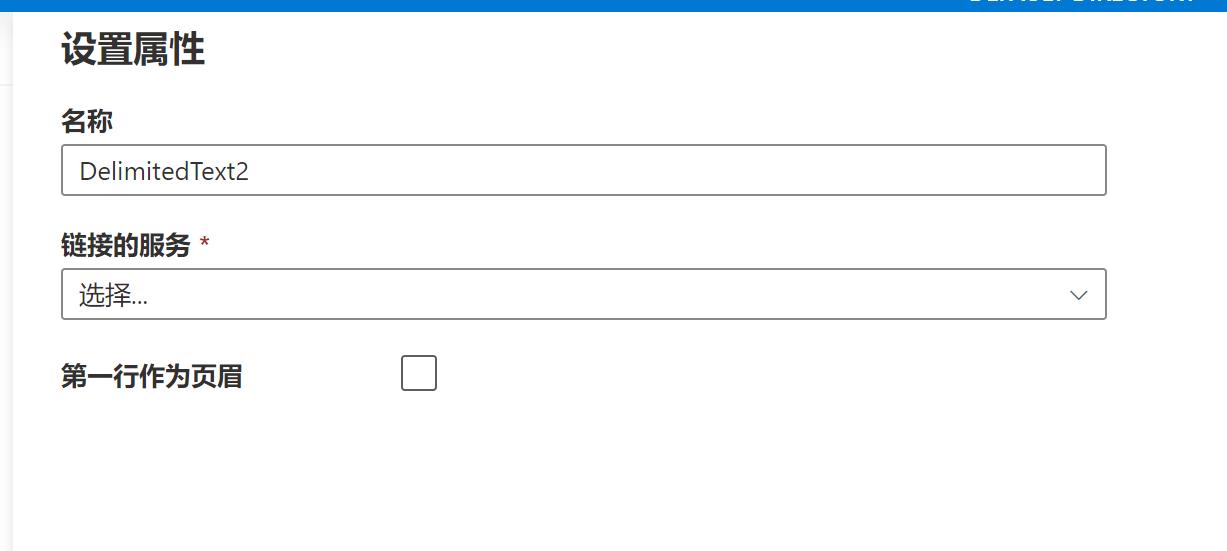

然后就是选择或新建链接服务:

根据不同的选择,会有更深入的一些选项可用:

配置成功后,就可以在后续的源和目标中使用。

以上是关于Azure Data PlatformETL工具——ADF 数据集和链接服务的主要内容,如果未能解决你的问题,请参考以下文章