如何用Python爬虫获取那些价值博文

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了如何用Python爬虫获取那些价值博文相关的知识,希望对你有一定的参考价值。

参考技术A过程大体分为以下几步:

1. 找到爬取的目标网址;

2. 分析网页,找到自已想要保存的信息,这里我们主要保存是博客的文章内容;

3. 清洗整理爬取下来的信息,保存在本地磁盘。

打开csdn的网页,作为一个示例,我们随机打开一个网页:

http://blog.csdn.net/u013088062/article/list/1。

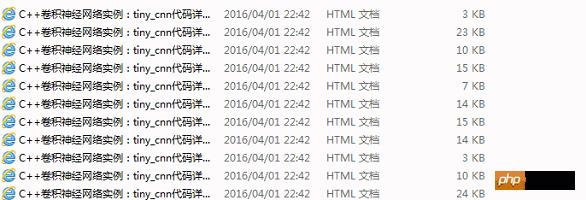

可以看到,博主对《C++卷积神经网络》和其它有关机计算机方面的文章都写得不错。

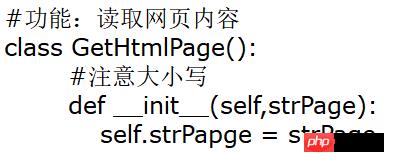

爬虫代码按思路分为三个类(class),下面3个带“#”的分别给出了每一个类的开头(具体代码附后,供大家实际运行实现):

采用“类(class)”的方式属于Python的面向对象编程,在某些时候比我们通常使用的面向过程的编程方便,在大型工程中经常使用面向对象编程。对于初学者来说,面向对象编程不易掌握,但是经过学习习惯之后,会逐步慢慢从面向过程到面向对象编程过渡。

特别注意的是,RePage类主要用正则表达式处理从网页中获取的信息,正则表达式设置字符串样式如下:

用正则表达式去匹配所要爬取的内容,用Python和其它软件工具都可以实现。正则表达式有许多规则,各个软件使用起来大同小异。用好正则表达式是爬虫和文本挖掘的一个重要内容。

SaveText类则是把信息保存在本地,效果如下:

用python编写爬虫代码,简洁高效。这篇文章仅从爬虫最基本的用法做了讲解,有兴趣的朋友可以下载代码看看,希望大家从中有收获。

附相关Python代码:

1#-*-coding:UTF-8-*-2import re

3import urllib2

4import sys

5#目的:读取博客文章,记录标题,用Htnl格式保存存文章内容

6#版本:python2.7.13

7#功能:读取网页内容

8class GethtmlPage():

9 #注意大小写

10 def __init__(self,strPage):

11 self.strPapge = strPage

12 #获取网页

13 def GetPage(self):

14 req = urllib2.Request(self.strPapge) # 建立页面请求

15 rep = req.add_header("User-Agent","Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/38.0.2125.122 Safari/537.36 SE 2.X MetaSr 1.0")

16 try:

17 cn = urllib2.urlopen(req) #网页请求

18 page = cn.read() #读网页

19 uPage = page.decode("utf-8") #网页编码

20 cn.close()

21 return uPage

22 except urllib2.URLError, e: #捕获异常

23 print 'URLError:', e.code

24 return

25 except urllib2.HTTPError, e: #捕获异常

26 print 'HTTP Error:' + e.reason

27 return

28 return rePage

29#正则表达式,获取想要的内容

30class RePage():

31#正则表达式提取内容,返回链表

32 def GetReText(self,page,recode):

33 rePage = re.findall(recode,page,re.S)

34 return rePage

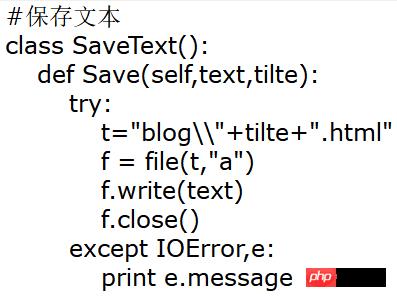

35#保存文本

36class SaveText():

37 def Save(self,text,tilte):

38 try:

39 t="blog\\\\"+tilte+".html"

40 f = file(t,"a")

41 f.write(text)

42 f.close()

43 except IOError,e:

44 print e.message

45if __name__ == "__main__":

46 s = SaveText()

47 #文件编码

48 #字符正确解码

49 reload(sys)

50 sys.setdefaultencoding( "utf-8" ) #获得系统的默认编码

51 #获取网页

52 page = GetHtmlPage("http://blog.csdn.net/u013088062/article/list/1")

53 htmlPage = page.GetPage()

54 #提取内容

55 reServer = RePage()

56 reBlog = reServer.GetReText(htmlPage,r'.*?(\\s.+?)') #获取网址链接和标题

57 #再向下获取正文

58 for ref in reBlog:

59 pageHeard = "http://blog.csdn.net/" #加链接头

60 strPage = pageHeard+ref[0]

61 tilte=ref[1].replace('[置顶]', "") #用替换的功能去除杂的英文

62 tilte=tilte.replace("\\r\\n","").lstrip().rstrip()

63 #获取正文

64 htmlPage = GetHtmlPage(strPage)

65 htmlPageData = htmlPage.GetPage()

66 reBlogText = reServer.GetReText(htmlPageData,'(.+?)')

67 #保存文件

68 for s1 in reBlogText:

69 s1='\\n'+s1

70 s.Save(s1,tilte)

如何用Python爬虫抓取网页内容?

比如新浪,QQ等

爬虫流程其实把网络爬虫抽象开来看,它无外乎包含如下几个步骤

模拟请求网页。模拟浏览器,打开目标网站。

获取数据。打开网站之后,就可以自动化的获取我们所需要的网站数据。

保存数据。拿到数据之后,需要持久化到本地文件或者数据库等存储设备中。

那么我们该如何使用 Python 来编写自己的爬虫程序呢,在这里我要重点介绍一个 Python 库:Requests。

Requests 使用

Requests 库是 Python 中发起 HTTP 请求的库,使用非常方便简单。

模拟发送 HTTP 请求

发送 GET 请求

当我们用浏览器打开豆瓣首页时,其实发送的最原始的请求就是 GET 请求

import requests

res = requests.get('http://www.douban.com')

print(res)

print(type(res))

>>>

<Response [200]>

<class 'requests.models.Response'> 参考技术A

首先,你要安装requests和BeautifulSoup4,然后执行如下代码.

from bs4 import BeautifulSoup

iurl = 'http://news.sina.com.cn/c/nd/2017-08-03/doc-ifyitapp0128744.shtml'

res = requests.get(iurl)

res.encoding = 'utf-8'

#print(len(res.text))

soup = BeautifulSoup(res.text,'html.parser')

#标题

H1 = soup.select('#artibodyTitle')[0].text

#来源

time_source = soup.select('.time-source')[0].text

#来源

origin = soup.select('#artibody p')[0].text.strip()

#原标题

oriTitle = soup.select('#artibody p')[1].text.strip()

#内容

raw_content = soup.select('#artibody p')[2:19]

content = []

for paragraph in raw_content:

content.append(paragraph.text.strip())

'@'.join(content)

#责任编辑

ae = soup.select('.article-editor')[0].text

这样就可以了

以上是关于如何用Python爬虫获取那些价值博文的主要内容,如果未能解决你的问题,请参考以下文章