关于 hadoop.tmp.dir 理解及配置

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了关于 hadoop.tmp.dir 理解及配置相关的知识,希望对你有一定的参考价值。

参考技术A 在HADOOP_HOME/etc/hadoop中的core-site.xml有个 hadoop.tmp.dir 配置的是Hadoop临时目录,比如HDFS的NameNode数据默认都存放这个目录下,查看*-default.xml 等默认配置文件,就可以看到很多依赖 user.name ,此时有个问题就是 NameNode 会将 HDFS 的元数据存储在这个/tmp目录下,如果操作系统重启了,系统会清空 /tmp 目录下的东西,导致NameNode元数据丢失,是个非常严重的问题,所有我们应该修改这个路径。修改完配置需要重新格式化NameNode!!!

如果需要重新格式化 NameNode,需要先将原来 NameNode 和 DataNode 下的文件全部删除,不然会报错,NameNode 和 DataNode 所在目录是在 core-site.xml中 hadoop.tmp.dir、 dfs.namenode.name.dir、dfs.datanode.data.dir属性配置的。

所以,建议:最好在安装配置HADOOP的时候,就给配置OK!

关于hadoop在Windows下安装的问题,求大戏帮忙。

我讲各个文件配置好以后,运行./hadoop namenode 时,出现了如下图所示情况:这时程序就不动了。

是我的hdfs-site没配置正确还是怎么?我的配置如下:

<property>

<name>dfs.data.dir</name>

<value>$hadoop.tmp.dir/dfs/data</value>

<property>

<name>dfs.name.dir</name>

<value>$hadoop.tmp.dir/dfs/name</value>

这里有错吗?或者我的其它地方配置有错?

PS:这是我以前出现这种错误时的原因。 参考技术A 从你的配置文件看,你参考的资料有点少,少一些配置的property,建议去我的百度博客看下,有一篇专门讲的如何配置hadoop,试试吧,希望对你有帮助~追问

能帮我看下这个东西吗?当我测试如下代码时:

$ mkdir input

$ cp conf/*.xml input

$ bin/hadoop jar hadoop-*-examples.jar grep input output ‘dfs[a-z.]+’

$ cat output/*

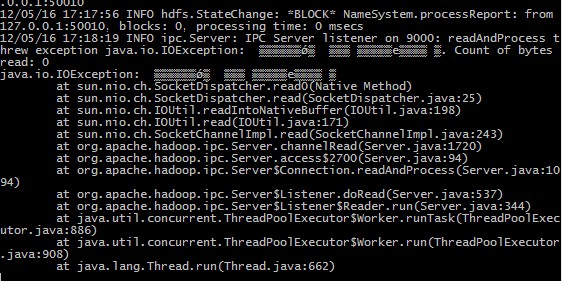

当我输入到:$ bin/hadoop jar hadoop-*-examples.jar grep input output ‘dfs[a-z.]+’时,就出现异常

如下图所示:

这是什么原因?

谢谢了!

以上是关于关于 hadoop.tmp.dir 理解及配置的主要内容,如果未能解决你的问题,请参考以下文章