论文笔记:Short-term origin-destination demand prediction in urban rail transit systems: A channel-wise a

Posted UQI-LIUWJ

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了论文笔记:Short-term origin-destination demand prediction in urban rail transit systems: A channel-wise a相关的知识,希望对你有一定的参考价值。

Short-term origin-destination demand prediction in urban rail transit systems: A channel-wise attentive split-convolutional neural network method

URT OD对的预测

1 intro

-

1.1 URT(城市轨道交通) OD预测的特点(难点)

- data availability

- 以交通预测为例,预测t+1时刻的交通数据,t时刻的实时数据也是知道的

- 但是对于URT OD来说,预测t+1时刻的OD对,往往t时刻的OD并不知道(因为乘客坐地铁通勤是需要一定时间的

- data dimensionality

- 如果地铁站数量是N的话,那么OD对的数量是

- 如果地铁站数量是N的话,那么OD对的数量是

- data sparsity

- OD对是很稀疏的

- data availability

1.2 之前的OD预测模型

- 可以分成三类

- 传统方法

- 最小二乘估计

- 概率分析

- 机器学习类方法

- 神经网络

- PCA

- SVD

- 深度学习类方法

- LSTM

- 每个点并行设计

- ——>效率不高,且没有考虑空间依赖关系

- 每个点并行设计

- CNN/GCN

- 多应用在道路OD预测,但那个问题的setting和URT OD的预测不太一样

- 道路OD预测中,实时和过去的ground-trurh OD对均不知道

- 多应用在道路OD预测,但那个问题的setting和URT OD的预测不太一样

- LSTM

- 传统方法

1.3 模型

- 提出了一种基于通道的注意力分离卷积神经网络(CAS-CNN)。

- 该模型由多个新颖的组成部分组成,

- 基于通道的注意机制和分离的CNN。

- 特别是,创新性地引入了进站/出战门控机制来解决数据可用性问题。

- 为了解决数据的维数和数据稀疏性问题,文章还首次提出了掩码损失函数。

2 问题定义

2.1 OD对预测

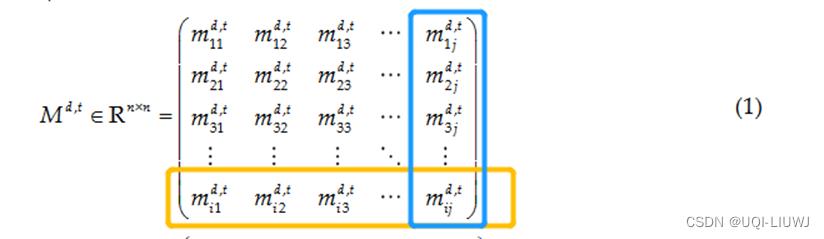

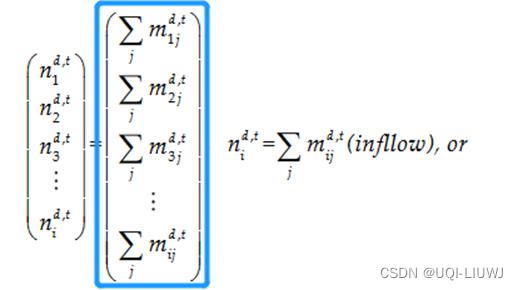

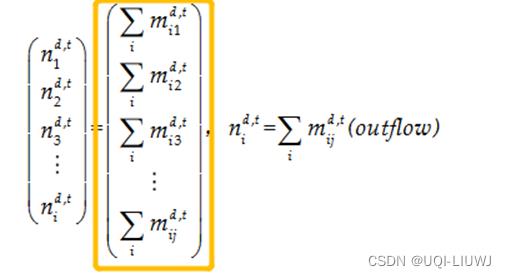

- 在第d天、时间间隔t时候的OD流量

- inflow/outflow

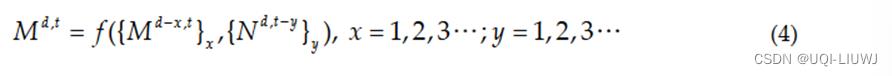

- URT OD 对预测,就是根据实时的inflow/outflow+过去几天的OD对,来预测当下的OD对

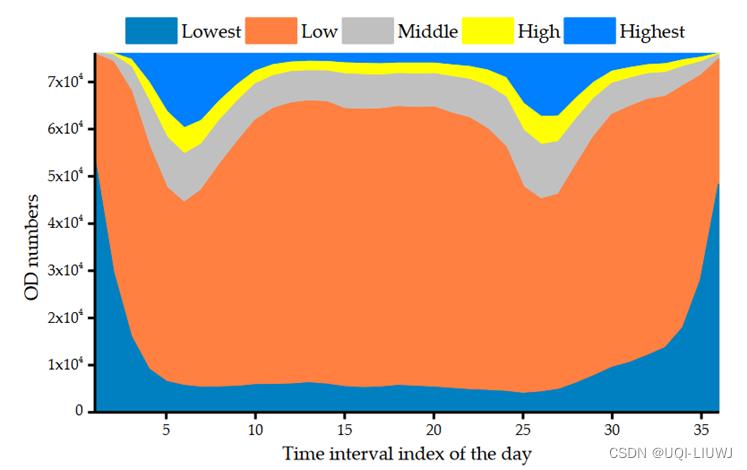

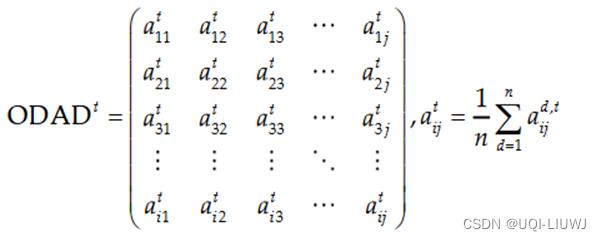

2.2 Origin–destination attraction degree (ODAD) level

- ODAD 水平

-

- 计算连续几天某一时间间隔的平均OD对

- ——>刻画各区域各时段OD对的特征

- ——>避免随机性

-

毕竟可以看到,无论是从一天的时间段,还是从OD对的index来看,OD对都是很稀疏的

3 模型

3.1 模型总览

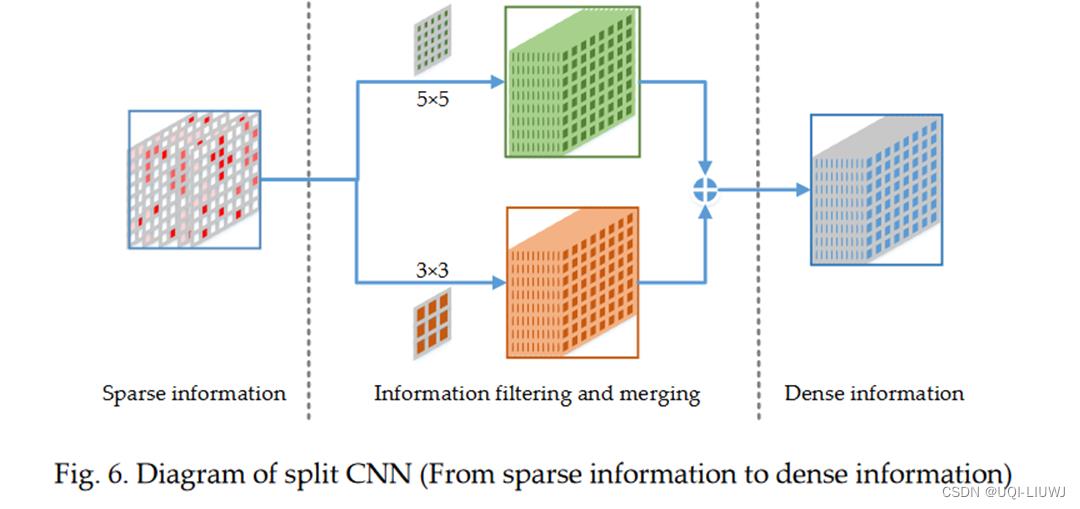

3.2 Split CNN(3*3 Conv+5*5 Conv)

- 通过卷积,可以从稀疏OD矩阵中提取出dense的数据

- 不同的卷积核大小可以提取出不同信息

- 有OD尖峰的区域——大的kernel可以捕获这种peak

- OD比较平缓的区域——小的kernel可以捕获这种平滑度

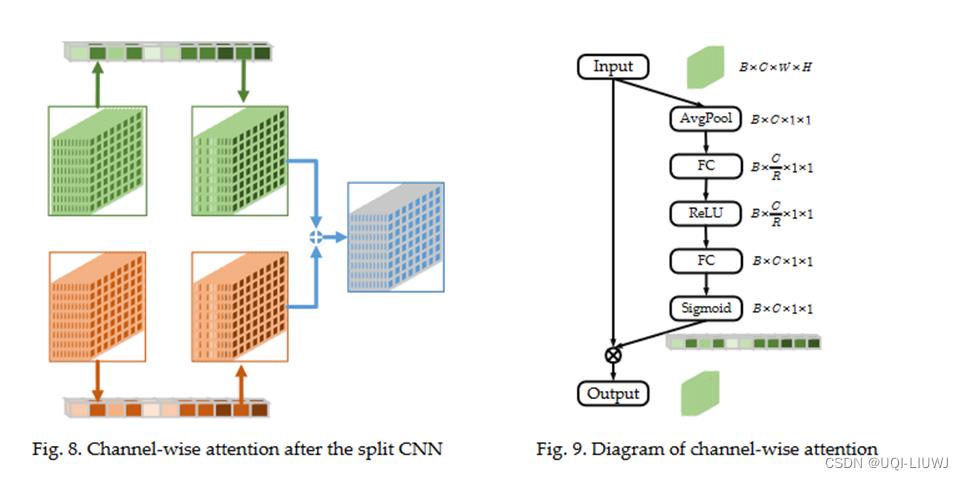

3.3 channel-wise attention

同一时间段,不同的日期,可能有不同的权重(比如周末和周中)

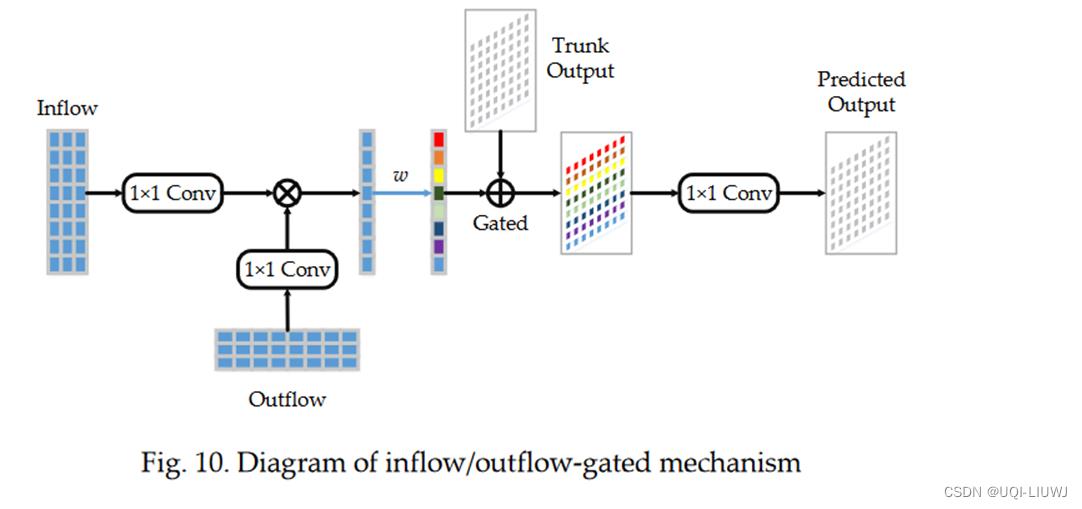

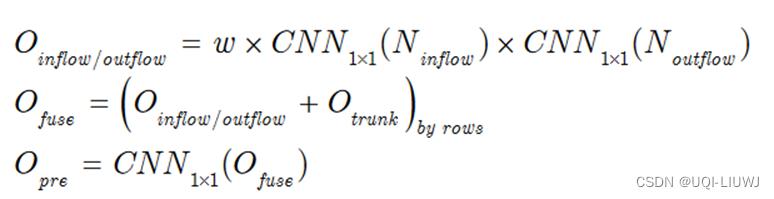

3.4 Inflow/outflow-gated mechanism

- Inflow/Outflow 经过1*1的CNN,维度从N*t变成N*1

- 1*1的CNN相当于整合了各个t的信息

- 这边的trunk output就是从historical OD data那边输出的东西

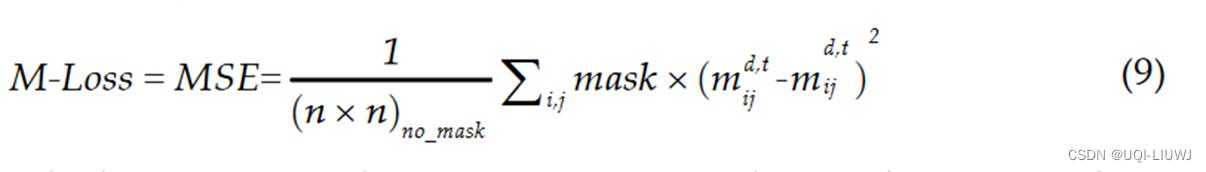

3.5 masked loss function

- 忽略那些零值/小值

- ——>解决数据维度问题和数据稀疏问题

4 实验部分

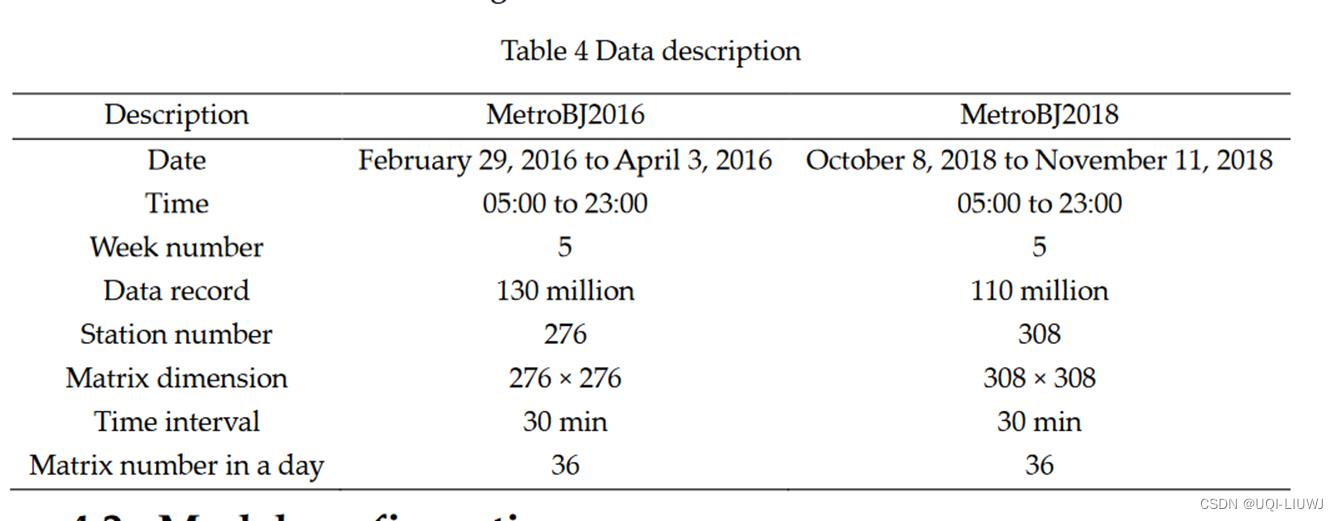

4.1 数据集

4.2 Metric

4.3 实验结果

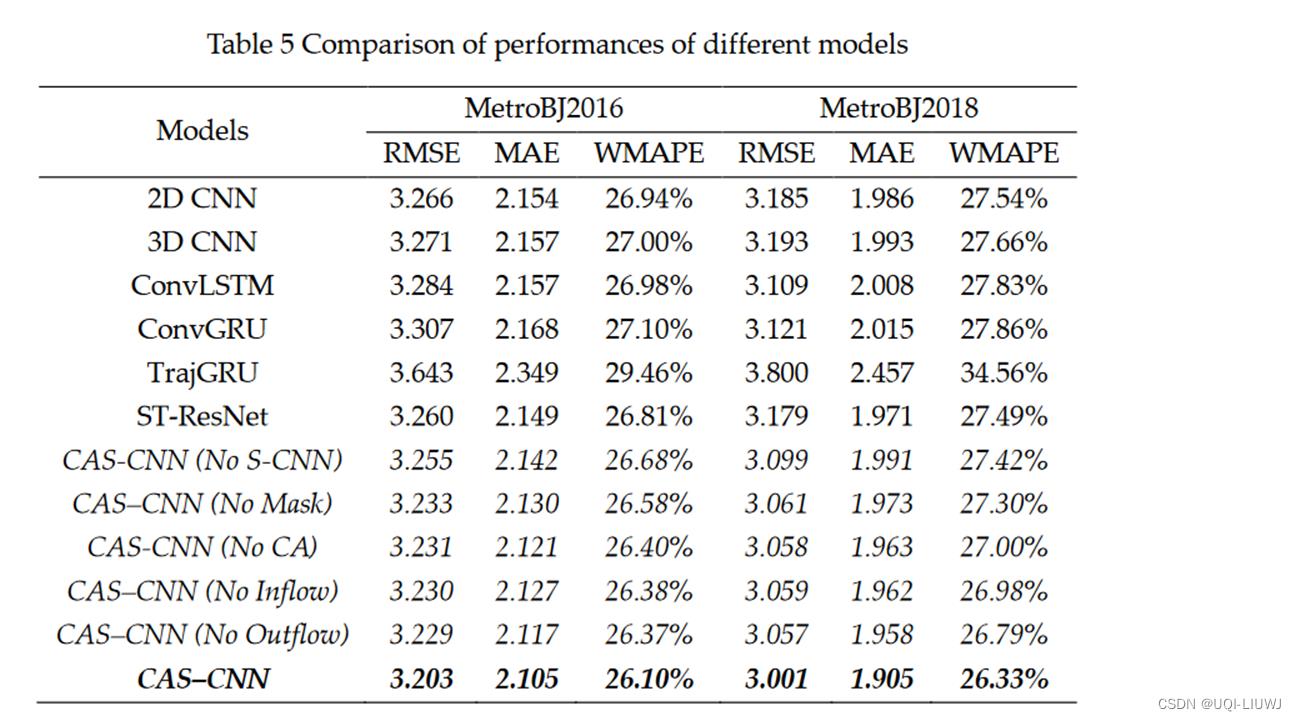

4.3.1 预测准确度

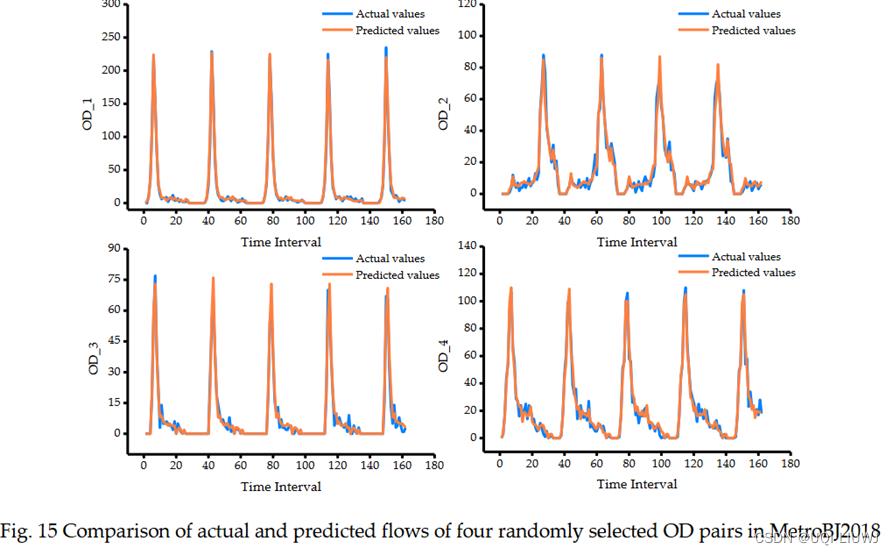

4.3.2 预测可视化

以上是关于论文笔记:Short-term origin-destination demand prediction in urban rail transit systems: A channel-wise a的主要内容,如果未能解决你的问题,请参考以下文章