:Transformers 介绍

Posted 小爷毛毛(卓寿杰)

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了:Transformers 介绍相关的知识,希望对你有一定的参考价值。

2017年,谷歌的研究人员发表了一篇论文,提出了一种用于序列建模的新型神经网络架构。这种架构被称为Transformer,在机器翻译质量和训练成本方面都优于递归神经网络(RNNs)。

与此同时,一种名为ULMFiT的有效迁移学习方法表明,在一个非常大和多样化的语料库上,训练长短期记忆(LSTM)网络,可以用很少的标记数据,产生SOTA的文本分类器。

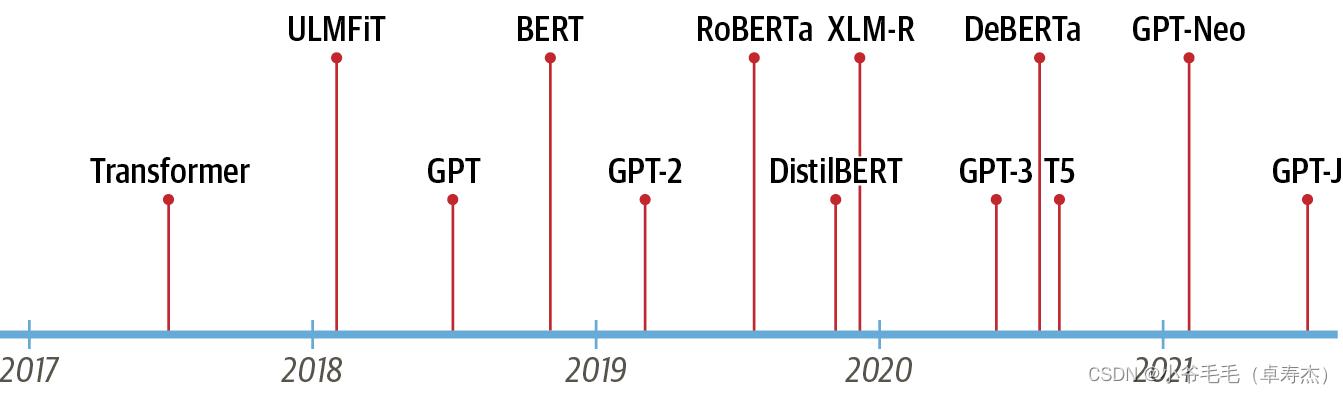

这些进展是当今最著名的两种transformers的催化剂:生成式预训练transformer(GPT)和来自transformer的双向编码器表示(BERT)。通过将transformer架构与无监督学习相结合,这些模型消除了从头开始训练特定任务架构的需要,并显著打破了NLP中的几乎所有基准。自从GPT和BERT发布以来,出现了大量的transformer模型;最突出的里程碑的时间轴如图1-1所示:

但我们要理解transformers的新颖之处,我们首先需要解释一下:

- 编码器解码器(encoder-decoder)框架

- 注意力(Attention)机制

- 迁移学习(Transfer learning)

在本章中,我们将介绍transformers普遍性的核心概念,了解他们擅长的一些任务&#x

以上是关于:Transformers 介绍的主要内容,如果未能解决你的问题,请参考以下文章