k8seasy安装单节点kubernetes

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了k8seasy安装单节点kubernetes相关的知识,希望对你有一定的参考价值。

参考技术A 系统:CentOS 7.6 64位1、更新升级内核

rpm -Uvh http://www.elrepo.org/elrepo-release-7.0-3.el7.elrepo.noarch.rpm

yum --enablerepo=elrepo-kernel install -y kernel-lt

grub2-set-default 0

服务器重启:shutdown -r now

查看内核版本:uname -a

Linux VM-0-214-centos 5.4.159-1.el7.elrepo.x86_64 #1 SMP Wed Nov 10 17:42:30 EST 2021 x86_64 x86_64 x86_64 GNU/Linux

2、k8seasy安装包准备

wget http://dl.k8seasy.com/installer

wget http://dl.k8seasy.com/installer.1.21

wget http://dl.k8seasy.com/kubernetes-server-linux-amd64.tar.gz

wget http://dl.k8seasy.com/pack.2020.10.02.bin

sudo ./installer --genkey -hostlist=172.17.0.214

sudo ./installer -kubernetestarfile kubernetes-server-linux-amd64.tar.gz -masterip 172.17.0.214

sudo ./installer --genkey -hostlist=172.16.16.9

sudo ./installer -kubernetestarfile kubernetes-server-linux-amd64.tar.gz -masterip 172.16.16.9 --skipDocker=1

scp ./k8skey.pem root@172.16.16.14:k8skey.pem

sudo ./installer -kubernetestarfile kubernetes-server-linux-amd64.tar.gz -masterip 172.16.16.9 --dashboardOnly=1

sudo ./installer -kubernetestarfile kubernetes-server-linux-amd64.tar.gz -masterip 172.16.16.9

创建集群,在172.16.16.8,172.16.16.12,172.16.16.4上安装k8s集群,这3个节点并不作为工作节点

sudo ./installer --genkey -hostlist=172.16.16.0

scp ./k8skey.pem root@172.16.16.12:k8skey.pem

scp ./k8skey.pem root@172.16.16.4:k8skey.pem

sudo ./installer -prepare

sudo ./installer -kubernetestarfile kubernetes-server-linux-amd64.tar.gz -masterip 172.16.16.8,172.16.16.12,172.16.16.4 --skipDocker=1

将密钥复制到其他节点

scp ./k8skey.pem root@172.16.16.6:k8skey.pem

将机器加入集群,只有第一台工作节点 需要加入时加上 --dashboardOnly=1 参数,

sudo ./installer -kubernetestarfile kubernetes-server-linux-amd64.tar.gz -masterip 172.16.16.8,172.16.16.12,172.16.16.4 --dashboardOnly=1

后面的节点 可以使用

sudo ./installer -kubernetestarfile kubernetes-server-linux-amd64.tar.gz -masterip 172.16.16.8,172.16.16.12,172.16.16.4

/etc/k8s/etcd/etcdctl --endpoint=https://172.16.16.4:2379 --ca-file=/etc/k8s/cert/ca.pem --cert-file=/etc/k8s/etcd/cert/etcd.pem --key-file=/etc/k8s/etcd/cert/etcd-key.pem member list

/etc/k8s/etcd/etcdctl --endpoint=https://172.16.16.4:2379 --ca-file=/etc/k8s/cert/ca.pem --cert-file=/etc/k8s/etcd/cert/etcd.pem --key-file=/etc/k8s/etcd/cert/etcd-key.pem cluster-health

/etc/k8s/etcd/etcdctl --endpoint=https://172.16.16.4:2379 --ca-file=/etc/k8s/cert/ca.pem --cert-file=/etc/k8s/etcd/cert/etcd.pem --key-file=/etc/k8s/etcd/cert/etcd-key.pem ls /kubernetes/network/subnets

/etc/k8s/etcd/etcdctl --endpoint=https://172.16.16.4:2379 --ca-file=/etc/k8s/cert/ca.pem --cert-file=/etc/k8s/etcd/cert/etcd.pem --key-file=/etc/k8s/etcd/cert/etcd-key.pem get /kubernetes/network/config

Kubernetes 集群 之 二进制安装部署(单Master节点)

目录

前言

一、常见的K8S按照部署方式

Minikube

- Minikube是一个工具,可以在本地快速运行一个单节点微型K8s,仅用于学习、 预览K8S的一些特性使用,没有商业价值。

- 部署地址: https://kubernetes.io/docs/setup/minikube

Kubeadmin

- Kubeadmin也是一个工具,提供 yum安装 kubeadm init 和 kubeadm join,用于快速部署K8s集群,相对简单。

- 部署地址: https://kubernetes.io/docs/reference/setup-tools/kubeadm/kubeadm/

- 缺点:证书只有一年,修改证书有效期为 100 年(默认为 1 年)

vim ./cmd/kubeadm/app/constants/constants.go,CertificateValidity =24.365.100修改后需要重新编译和安装服务。

二进制安装部署

- 大型企业生产首选,从官方下载发行版的二进制包,手动部署每个组件 和 自签TLS证书,组成K8S集群,新手推荐。

- 有 zip 和 tar.gz 两个系统的包

- https://github.com/kubernetes/kubernetes/releases

二、安装部署分析

先搭建单Master 集群(企业都是多Master 节点高可用,暂时部署一台)

Master 节点

| k8s集群master01 | 192.168.10.40 | kube-apiserver、kube-controller-manage、kube-scheduler、etcd |

| k8s集群master02 | 192.168.80.20 |

Worker Node 节点

| k8s集群node01 | 192.168.10.50 | kubelet、kube-proxy、docker、flannel |

| k8s集群node02 | 192.168.10.60 |

ETCD(实验为了节省机器,和Master Node 节点共用机器)

| etcd集群节点1 | 192.168.10.40 |

| etcd集群节点2 | 192.168.10.50 |

| etcd集群节点3 | 192.168.10.60 |

web服务负载均衡

| 负载均衡 nginx+keepalive01 (master) | 192.168.10.XX |

| 负载均衡 nginx+keepalive02 (backup) | 192.168.10.XX |

先所有机器关闭防火墙

systemctl stop firewalld

systemctl disable firewalld

setenforce 0

修改所有主机的主机名(方便部署)

hostnamectl set-hostname master01 10.40

hostnamectl set-hostname node01 10.50

hostnamectl set-hostname node02 10.60

ETCD 集群介绍:

- 使用三台 ETCD集群 实现高可用,可以容忍一台机器故障,如果使用5台,容忍2台机器故障,即容忍半数以上ETCD机器存活。

- ETCD集群也可以放在 Master 或 Node 节点的机器上,也可以独立部署在独立机器上。

- 注意点:ApiServer 和 ETCD 之间的通信需要CA证书进行加密;ETCD 与 ETCD 之间通信也需要通过证书加密,

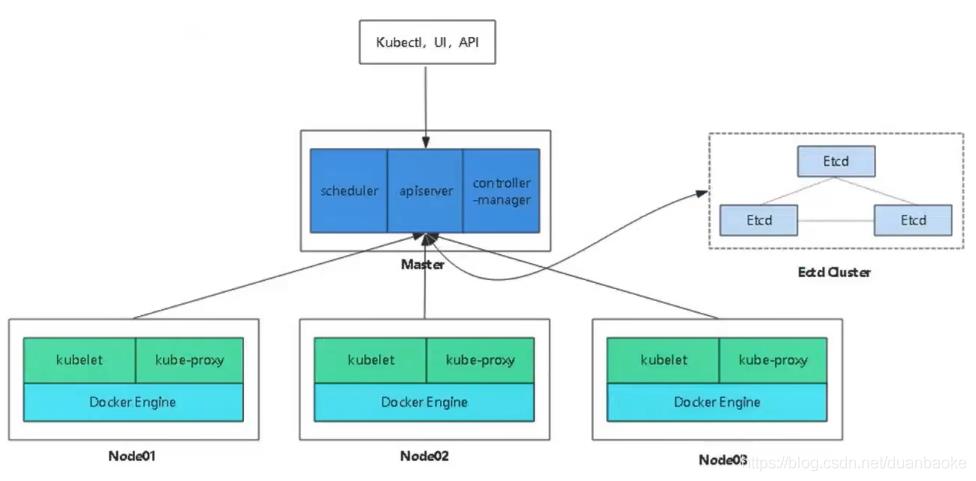

Kubernetes 单 Master 集群 架构图如下:

暂时没有node3

三、首先部署ETCD集群

3.1 ETCD 介绍

- ETCD 是Coreos团队于2013年6月发起的开源项目,它的目标是构建一个高可用的分布式键值(key-value)数据库。

- ETCD 内部采用raft协议作为一致性算法,ETCD 是 GO 语言编写的。

- ETCD 作为服务发现系统,有以下的特点:

- 简单:安装配置简单,而且提供了HTTP API进行交互,使用也很简单

- 安全:支持SSL证书验证(需要创建签发证书)

- 快速:单实例支持每秒2k+读操作

- 可靠:采用raft算法,实现分布式系统数据的可用性和一致性

ETCD 端口:

- ETCD 目前默认使用 2379 端口 提供 HTTP API服务,

- 2380 端口 和 peer通信(这两个端口已经被IANA(互联网数字分配机构)官方预留给ETCD )。

- 即 ETCD 默认使用 2379 端口对外为客户端提供通讯,使用端口 2380 来进行服务器间内部通讯。

ETCD 在生产环境中一般推荐集群方式部署。由于ETCD 的 Leader选举机制,要求至少为3台或以上的奇数台。

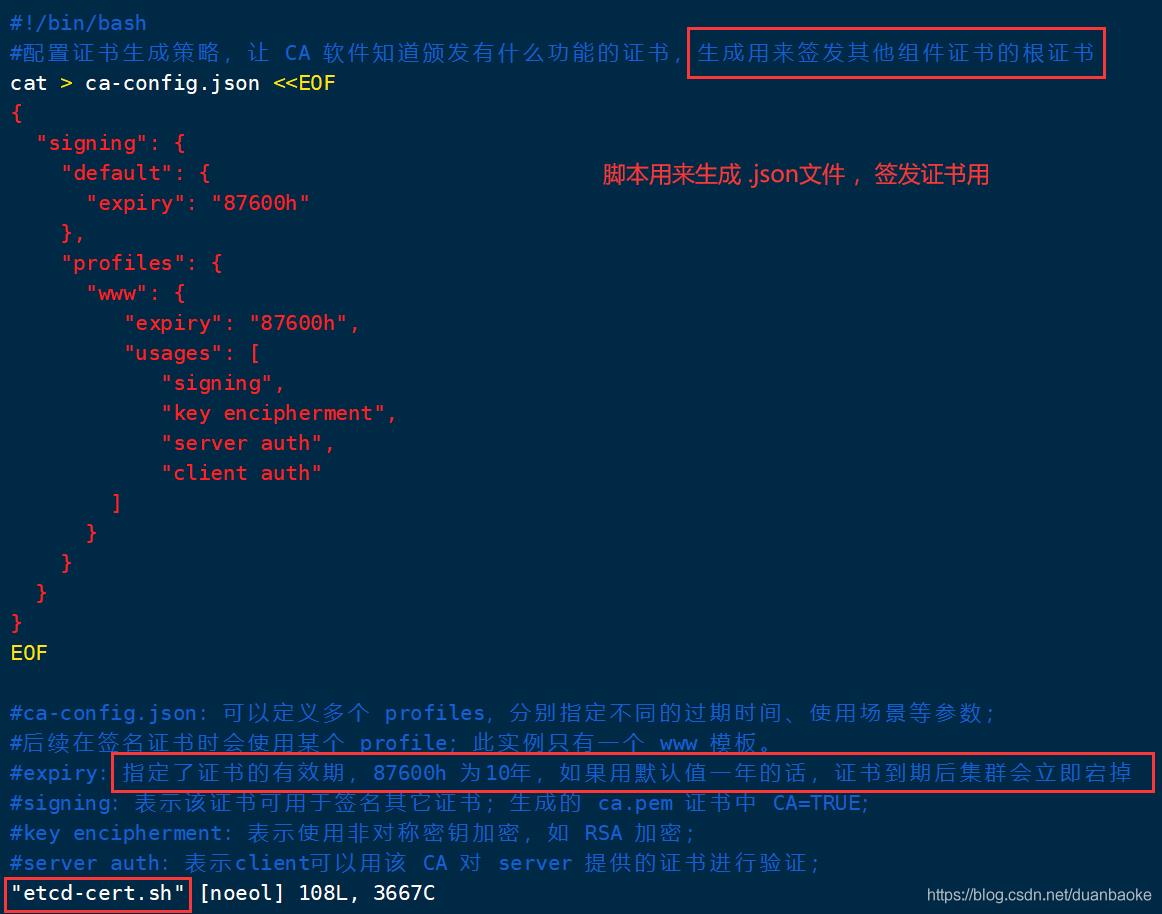

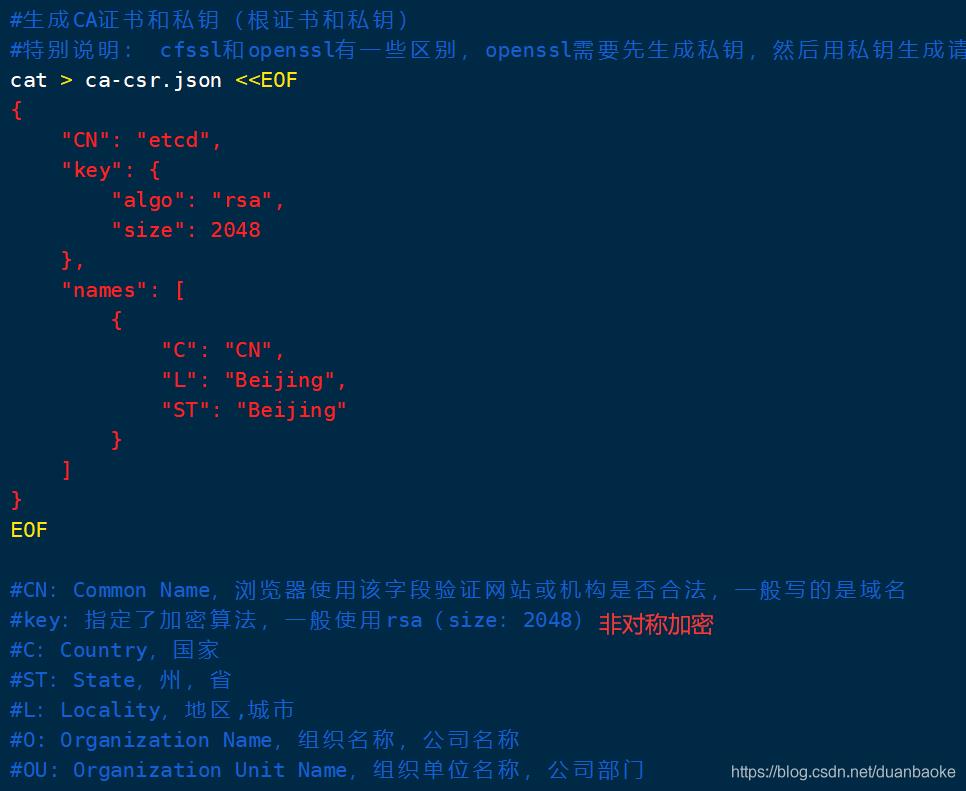

3.2 准备 CFSSL 证书签发环境

ETCD 通过CFSSL 生成证书。

CFSSL 是 CloudFlare 公司开源的一款 PKI/TLS 工具。CFSSI 包含一个命令行工具和一个用于签名、验证和捆绑TLS 证书的 HTTP API 服务。使用Go语言编写。

CFSSL 使用配置文件生成证书,因此自签之前,需要生成它识别的 .JSON 格式的配置文件,CFSSL 提供了方便的命令行生成配置文件。

CFSSL 用来为 ETCD 提供 TLS 证书,它支持签三种类型的证书:

- client 证书,服务端连接客户端时携带的证书,用于客户端验证服务端身份,如 kube-apiserver 访问 ETCD;

- server 证书,客户端连接服务端时携带的证书,用于服务端验证客户端身份,如 ETCD对外提供服务;

- peer 证书,相互之间连接时使用的证书,如 ETCD节点之间 进行验证和通信。

这里全部都使用同一套证书认证。

3.3 环境部署

3.3.1 搭建 ETCD 步骤

环境准备:

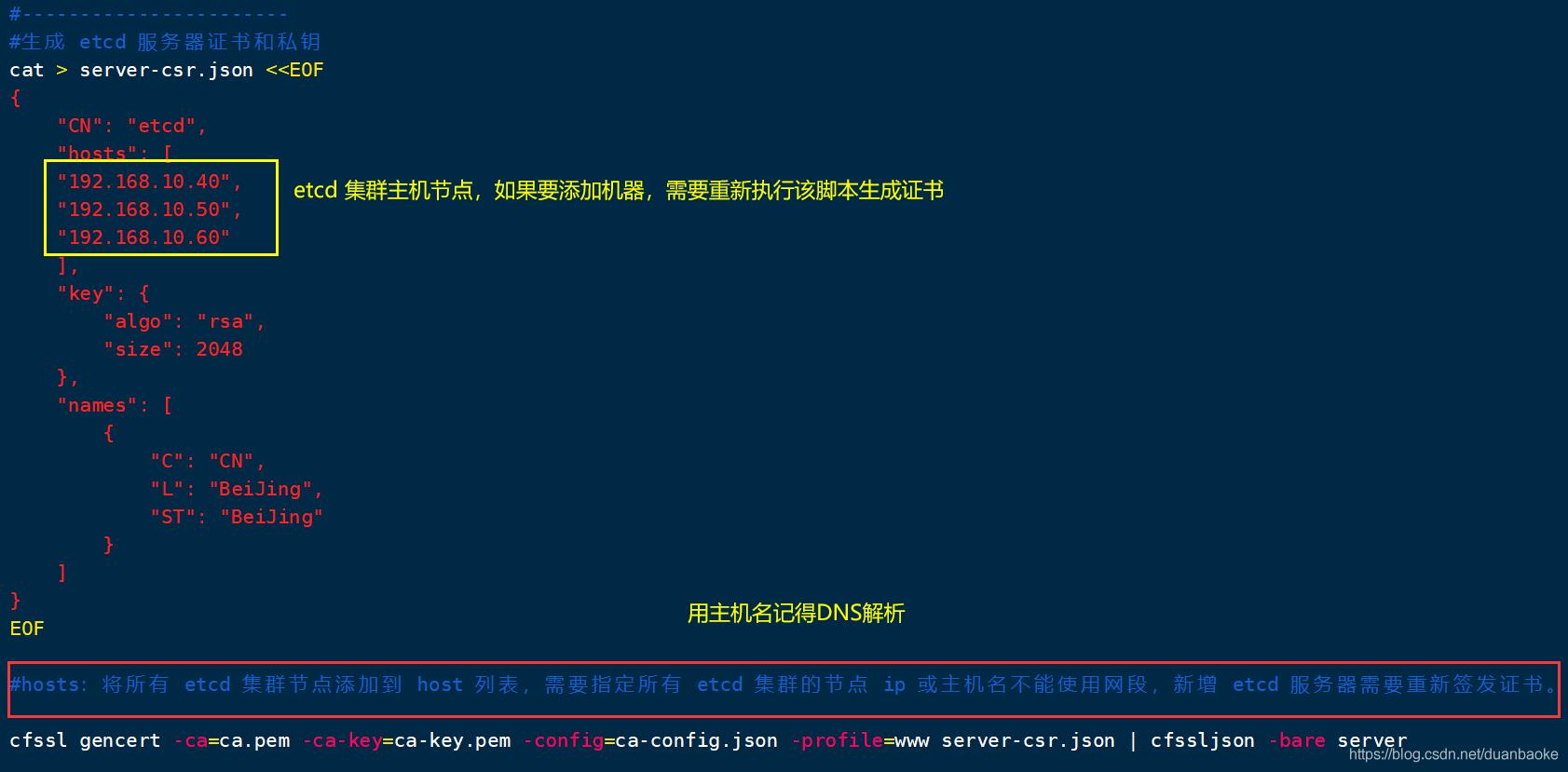

| etcd集群节点 node01 | 192.168.10.40 |

| etcd集群节点 node02 | 192.168.10.50 |

| etcd集群节点 node03 | 192.168.10.60 |

- 需要准备 CFSSL 证书生成工具,用它来生成证书;

- 准备 ETCD 二进制软件包;

- 生成 ETCD 的配置文件和服务管理文件;

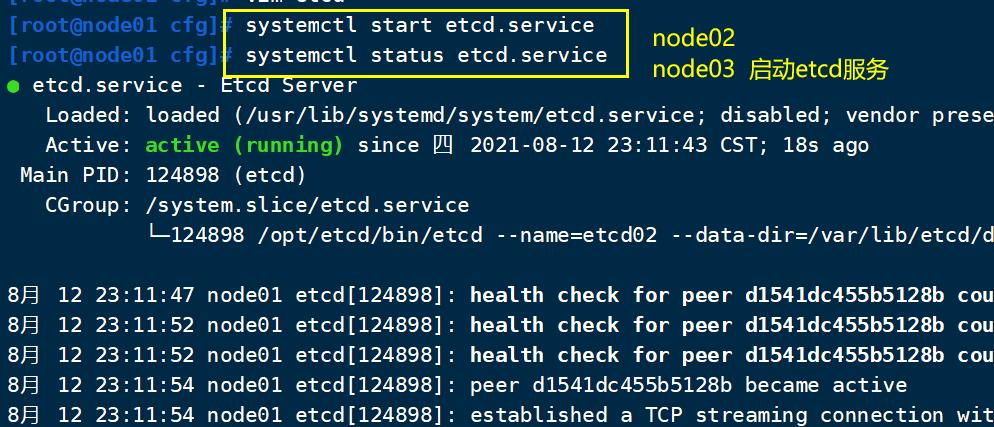

- 启动 ETCD 服务;

- 把经过上面一到四步骤在etcd01生成的配置文件、可执行文件、认证证书、etcd 服务管理文件,都复制到 etcd02,etcd03 节点上,分别在两台上修改配置文件中的节点名称与节点IP地址;

- 分别启动etcd,加入到 ETCD 集群中;

- 验证 ETCD 集群状态

主体架构:

- 三台 ETCD集群 实现高可用,容忍一台机器故障,即容忍半数以上ETCD机器存活。

- ETCD集群也可以放在 Master 或 Node 节点的机器上,也可以独立部署在独立机器上。这里为了节约机器 部署在Mster 和 Node机器上

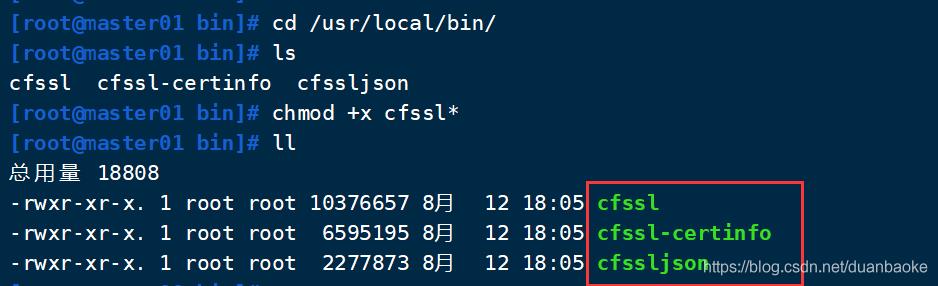

3.3.2 下载准备 CFSSL 证书制作工具

Linux 中下载命令用 wget 和 curl -L 重定向

wget https://pkg.cfssl.org/R1.2/cfssl_linux-amd64 -o /usr/local/bin/cfssl

wget https://pkg.cfssl.org/R1.2/cfssljson_linux-amd64 -o /usr/local/bin/cfssljson

wget https://pkg.cfssl.org/R1.2/cfssl-certinfo_linux-amd64 -0 /usr/local/bin/cfssl-certinfo

或

curl -L https://pkg.cfssl.org/R1.2/cfssl_linux-amd64 -o /usr/local/bin/cfss

curl -L https://pkg.cfssl.org/R1.2/cfssljson_linux-amd64 -o /usr/local/bin/cfssljson

curl -L https://pkg.cfssl.org/R1.2/cfssl-certinfo_linux-amd64 -o /usr/local/bin/cfssl-certinfo

下载CFSSL 证书工具后,放到 /usr/local/bin/ 目录中,为了全局能执行cfssl命令,赋予可执行权限

chmod +x /usr/local/bin/cfssl*

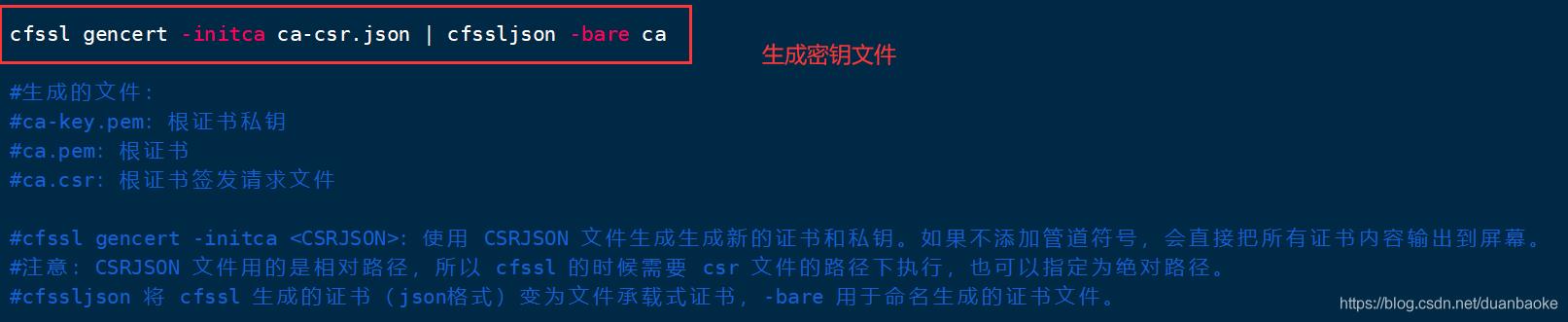

文件介绍:

- cfssl:证书签发的工具命令

- cfssljson:将cfssl 生成的证书(json格式)变为文件承载式证书cfssl-certinfo:验证证书的信息

- cfssl-certinfo:-cert<证书名称> #查看证书的信息

创建 k8s 工作目录

mkdir /opt/k8s

cd/opt/k8s/

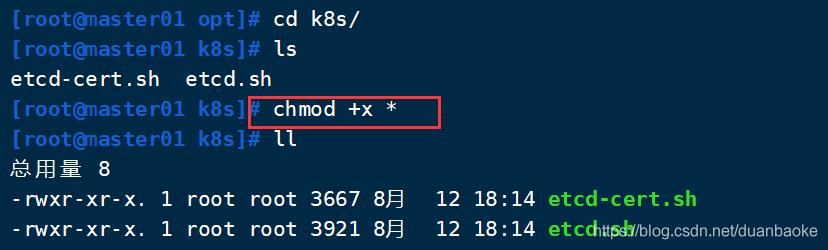

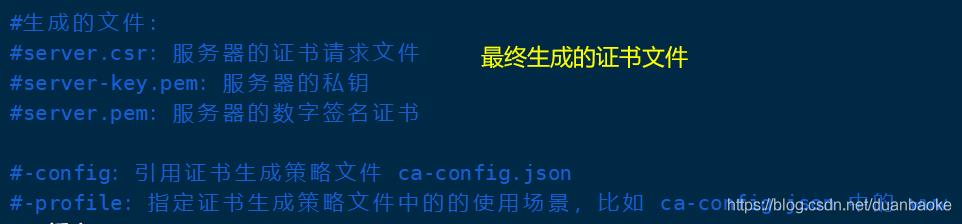

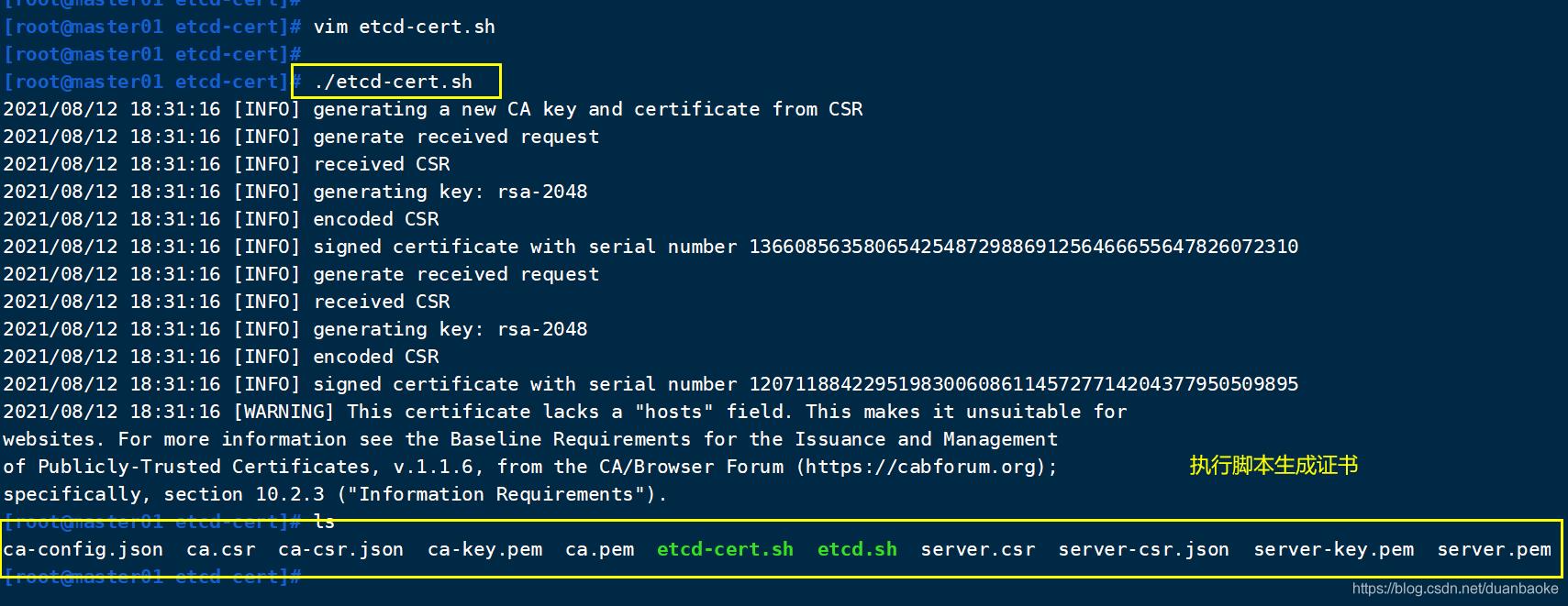

3.3.3 上传 etcd-cert.sh 和 etcd.sh 到 /opt/k8s/ 目录中

chmod +x etcd-cert.sh etcd.sh

#创建用于生成CA证书、etcd服务器证书 以及 私钥的目录

mkdir /opt/k8s/etcd-cert

mv etcd-cert.sh etcd-cert/

cd /opt/k8s/etcd-cert/

./etcd-cert.sh

#执行etcd-cert.sh脚本文件生成CA证书、etcd服务器证书以及私钥

etcd-cert.sh 用来定义签发根证书的信息,包括证书期限,JSON 格式。

特别说明: cfssl 和 openssl 有一些区别,openssl需要先生成私钥,然后用私钥生成请求文件,最后生成签名的证书和私钥等;而cfssl可以直接得到请求文件,不需要先生成私钥。

server.pem 证书用于客户端服务端通信的认证

ca.pem 证书用于验证是否合法

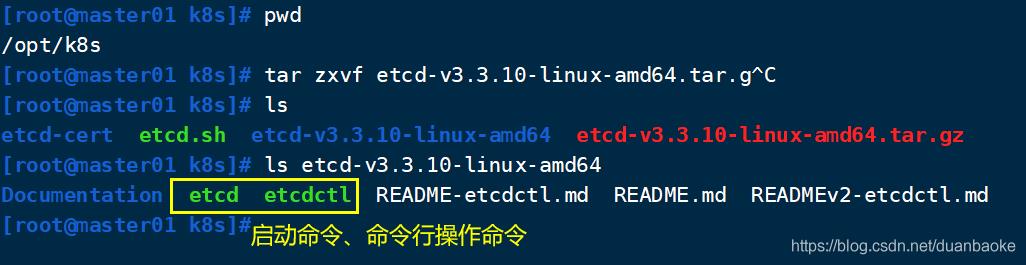

3.3.4 安装 ETCD 服务

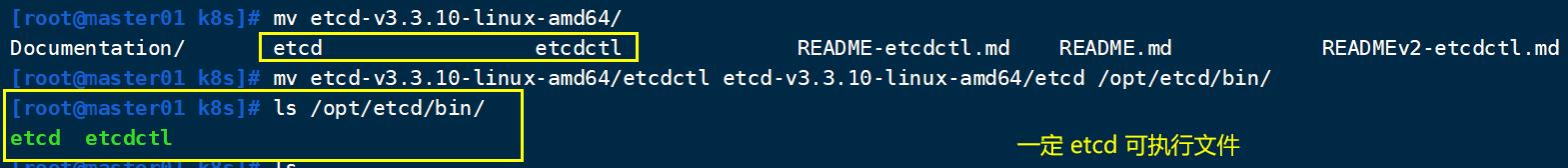

#上传 etcd-v3.3.10-linux-amd64.tar.gz 到/opt/k8s/目录中,解压etcd 压缩包

cd/opt/k8s/

tar zxvf etcd-v3.3.10-linux-amd64.tar.gz

ls etcd-v3.3.10-linux-amd64

etcd:就是etcd 服务的启动命令,后面可跟各种启动参数

etcdctl:主要为etcd 服务提供了命令行操作

创建用于存放etcd 配置文件,命令文件,证书的目录

mkdir -p /opt/etcd/{cfg,bin,ssl}

mv /opt/k8s/etcd-v3.3.10-linux-amd64/etcd /opt/k8s/etcd-v3.3.10-linux-amd64/etcdctl /opt/etcd/bin/

cp /opt/k8s/etcd-cert/ *.pem /opt/etcd/ssl/ #所有的pem证书移过去

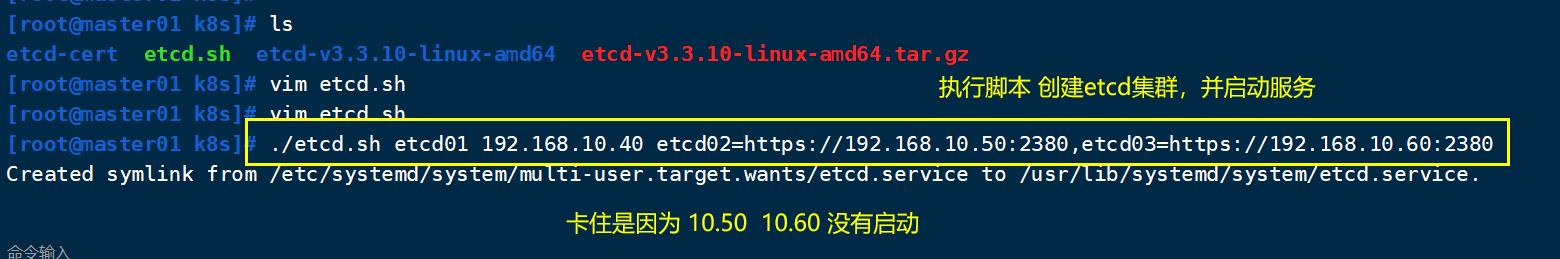

创建启动脚本 etcd.sh

./etcd.sh etcd01 192.168.10.40 etcd02=https://192.168.10.50:2380,etcd03=https://192.168.10.60:2380

#会发现卡住了,是因为在等待其他节点加入,

#这里需要三台etcd服务同时启动,如果只启动其中一台后,服务会卡在那里,直到集群中所有etcd节点都已启动,可忽略这个情况

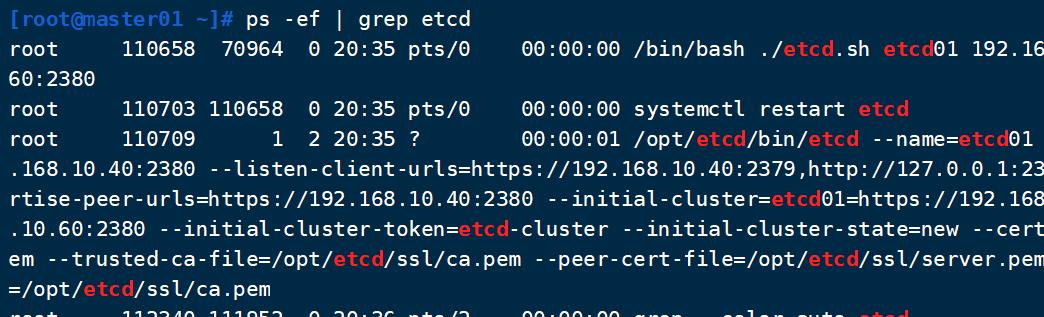

#另外打开一个窗口查看etcd进程是否正常

ps -ef | grep etcd

新开窗口发现服务已启动

etcd.sh 脚本内容如下

#!/bin/bash

# example: ./etcd.sh etcd01 192.168.10.40 etcd02=https://192.168.10.50:2380,etcd03=https://192.168.10.60:2380

#创建etcd配置文件/opt/etcd/cfg/etcd

ETCD_NAME=$1

ETCD_IP=$2

ETCD_CLUSTER=$3

WORK_DIR=/opt/etcd

cat > $WORK_DIR/cfg/etcd <<EOF

#[Member]

ETCD_NAME="${ETCD_NAME}"

ETCD_DATA_DIR="/var/lib/etcd/default.etcd"

ETCD_LISTEN_PEER_URLS="https://${ETCD_IP}:2380"

ETCD_LISTEN_CLIENT_URLS="https://${ETCD_IP}:2379"

#[Clustering]

ETCD_INITIAL_ADVERTISE_PEER_URLS="https://${ETCD_IP}:2380"

ETCD_ADVERTISE_CLIENT_URLS="https://${ETCD_IP}:2379"

ETCD_INITIAL_CLUSTER="etcd01=https://${ETCD_IP}:2380,${ETCD_CLUSTER}"

ETCD_INITIAL_CLUSTER_TOKEN="etcd-cluster"

ETCD_INITIAL_CLUSTER_STATE="new"

EOF

#Member:成员配置

#ETCD_NAME:节点名称,集群中唯一。成员名字,集群中必须具备唯一性,如etcd01

#ETCD_DATA_DIR:数据目录。指定节点的数据存储目录,这些数据包括节点ID,集群ID,集群初始化配置,Snapshot文件,若未指定-wal-dir,还会存储WAL文件;如果不指

定会用缺省目录

cat <<EOF >/usr/lib/systemd/system/etcd.service #定义ectd的启动脚本

[Unit] #基本项

Description=Etcd Server #类似为 etcd 服务

After=network.target #vu癌症

After=network-online.target

Wants=network-online.target

[Service] #服务项

Type=notify

EnvironmentFile=${WORK_DIR}/cfg/etcd #etcd文件位置

ExecStart=${WORK_DIR}/bin/etcd \\ #准启动状态及以下的参数

--name=\\${ETCD_NAME} \\

--data-dir=\\${ETCD_DATA_DIR} \\

--listen-peer-urls=\\${ETCD_LISTEN_PEER_URLS} \\

--listen-client-urls=\\${ETCD_LISTEN_CLIENT_URLS},http://127.0.0.1:2379 \\

--advertise-client-urls=\\${ETCD_ADVERTISE_CLIENT_URLS} \\ #以下为群集内部的设定

--initial-advertise-peer-urls=\\${ETCD_INITIAL_ADVERTISE_PEER_URLS} \\

--initial-cluster=\\${ETCD_INITIAL_CLUSTER} \\

--initial-cluster-token=\\${ETCD_INITIAL_CLUSTER_TOKEN} \\ #群集内部通信,也是使用的令牌,为了保证安全(防范中间人窃取)

--initial-cluster-state=new \\

--cert-file=${WORK_DIR}/ssl/server.pem \\ #证书相关参数

--key-file=${WORK_DIR}/ssl/server-key.pem \\

--peer-cert-file=${WORK_DIR}/ssl/server.pem \\

--peer-key-file=${WORK_DIR}/ssl/server-key.pem \\

--trusted-ca-file=${WORK_DIR}/ssl/ca.pem \\

--peer-trusted-ca-file=${WORK_DIR}/ssl/ca.pem

Restart=on-failure

LimitNOFILE=65536 #开放最多的端口号

[Install]

WantedBy=multi-user.target

EOF

#--listen-client-urls:用于指定etcd和客户端的连接端口

#--advertise-client-urls:用于指定etcd服务器之间通讯的端口,etcd有要求,如果--listen-client-urls被设置了,那么就必须同时设置--advertise-client-urls,所

以即使设置和默认相同,也必须显式设置

#--peer开头的配置项用于指定集群内部TLS相关证书(peer 证书),这里全部都使用同一套证书认证

#不带--peer开头的的参数是指定 etcd 服务器TLS相关证书(server 证书),这里全部都使用同一套证书认证

systemctl daemon-reload

systemctl enable etcd

systemctl restart etcd

3.3.5 配置 ETCD 集群

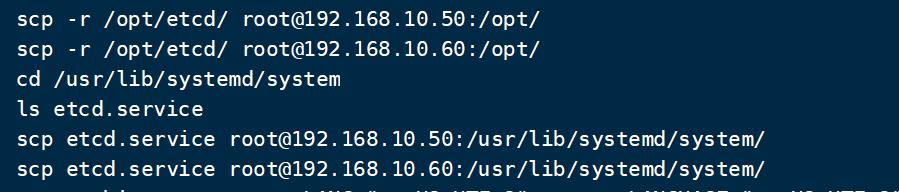

把 etcd 相关证书文件 和 命令文件全部拷贝到另外两个etcd集群节点,生成证书的文件都一样,所以证书是通用的。

#在192.168.10.40机器上 复制所有etcd文件

scp -r /opt/etcd/ root@192.168.10.50:/opt/

scp -r /opt/etcd/ root@192.168.10.60:/opt/

#复制etcd 启动服务

scp etcd.service root@192.168.10.50:/usr/lib/systemd/system/

scp etcd.service root@192.168.10.60:/usr/lib/systemd/system/

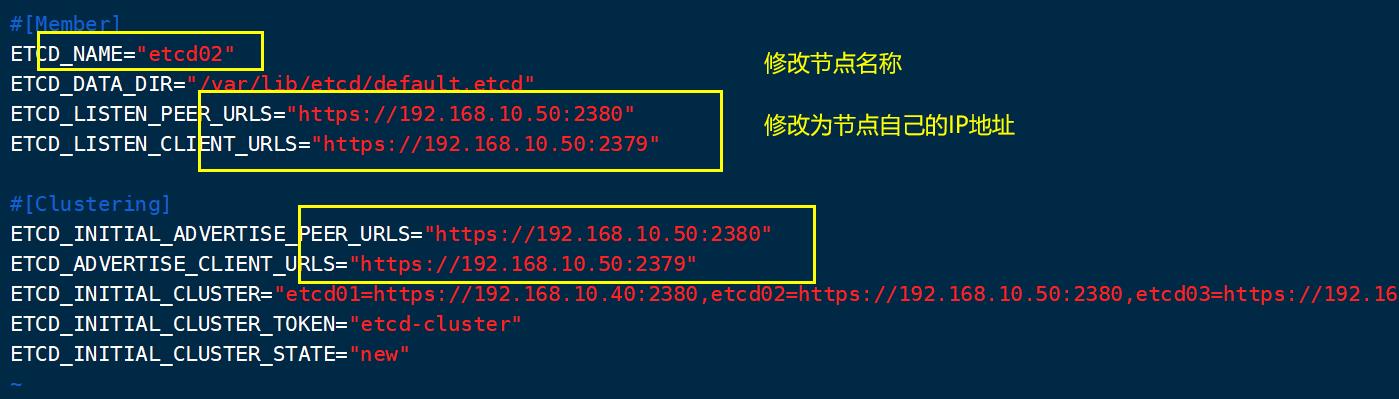

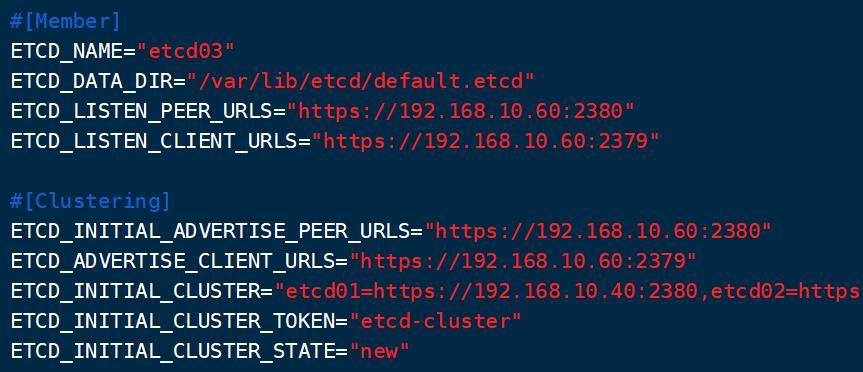

node02 node03 分别执行 vim /opt/etcd/cfg/etcd

#以 192.168.10.60 node03为例

#[Member]

ETCD_NAME="etcd03"

ETCD_DATA_DIR="/var/lib/etcd/default.etcd"

ETCD_LISTEN_PEER_URLS="https://192.168.10.60:2380"

ETCD_LISTEN_CLIENT_URLS="https://192.168.10.60:2379"

#[Clustering]

ETCD_INITIAL_ADVERTISE_PEER_URLS="https://192.168.10.60:2380"

ETCD_ADVERTISE_CLIENT_URLS="https://192.168.10.60:2379"

ETCD_INITIAL_CLUSTER="etcd01=https://192.168.10.40:2380,etcd02=https://192.168.10.50:2380,etcd03=https://192.168.10.60:2380"

ETCD_INITIAL_CLUSTER_TOKEN="etcd-cluster"

ETCD_INITIAL_CLUSTER_STATE="new"

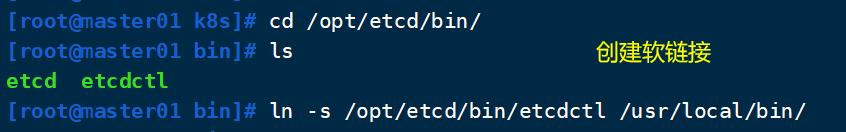

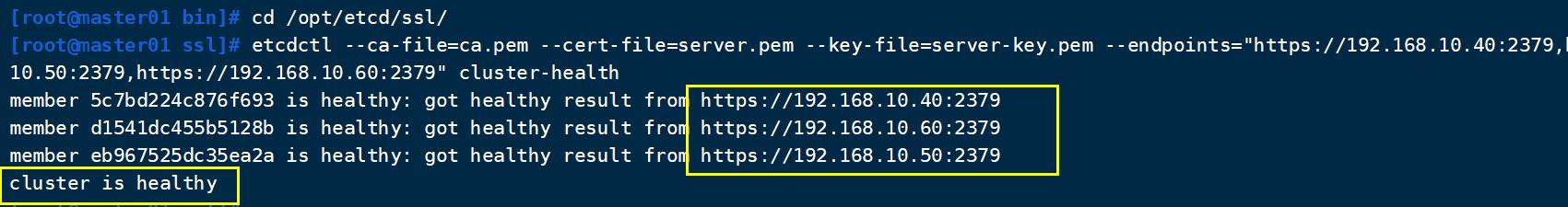

3.3.6 在Master01 节点上操作验证etcd集群状态

先将 master01 192.168.10.40 etcd 的 etcdctl 服务添加到环境变量中。

cd /opt/etcd/bin/

ln -s /opt/etcd/bin/etcdctl /usr/local/bin/

#一定要在/opt/etcd/ssl/ 目录下执行,因为--cert-file执行了认证文件了

#用外部端口2379

cd /opt/etcd/ssl/

etcdctl --ca-file=ca.pem --cert-file=server.pem --key-file=server-key.pem --endpoints="https://192.168.10.40:2379,https://192.168.10.50:2379,https://192.168.10.60:2379" cluster-health

-------------------

--cert-file:识别HTTPS端使用SSL证书文件

--key-file:使用此SSL密钥文件标识HTTPS客户端

--ca-file:使用此CA证书验证启用https的服务器的证书

--endpoints:集群中以逗号分隔的机器地址列表

cluster-health:检查etcd集群的运行状况

----------------------

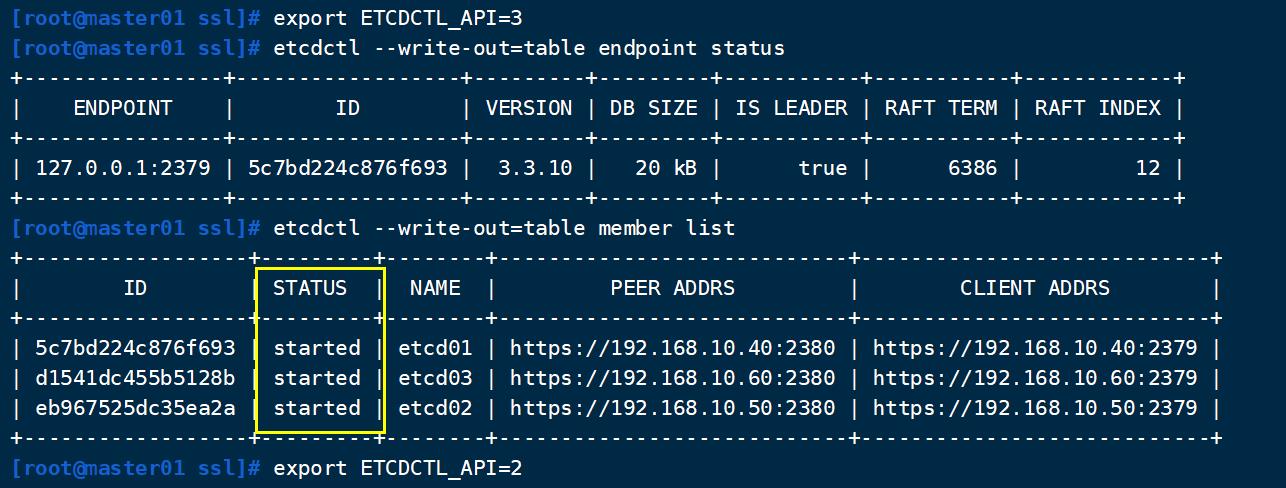

#切换到etcd3版本查看集群节点状态和成员列表

#v2和v3命令略有不同,etcd2和etcd3也是不兼容的,默认是v2版本

export ETCDCTL_API=3

etcdctl --write-out=table endpoint status

etcdctl --write-out=table member list

export ETCDCTL_API=2

#再切回v2版本, 就是用V3的功能看一下

集群中的列表都已经启动了,ETCD 集群搭建完成。

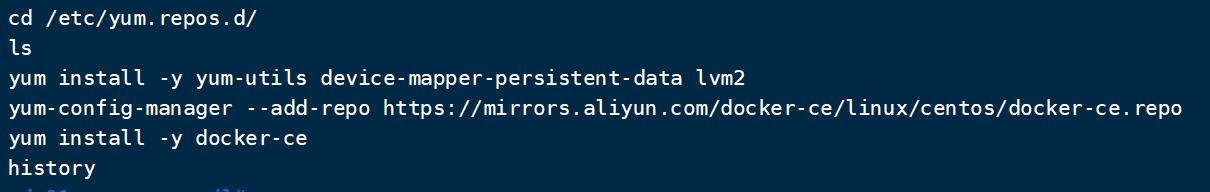

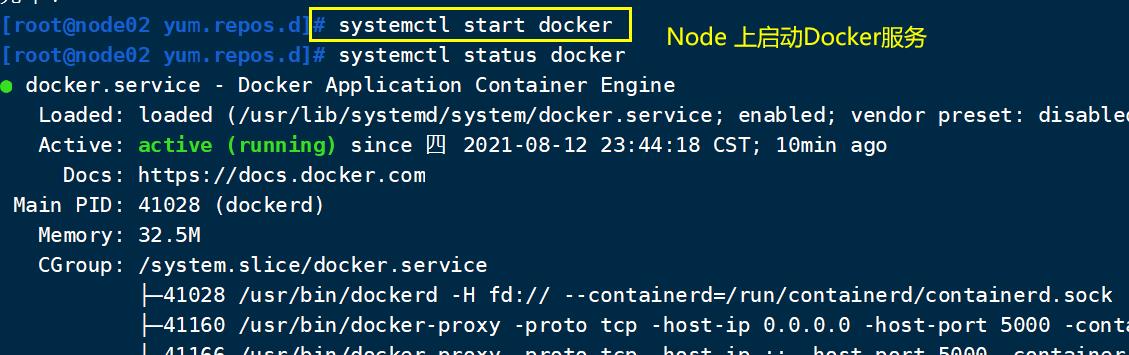

四、在所有 Node 节点上部署 Docker 引擎

在 192.168.10.50 、192.168.10.60 上安装 Docker

使用 yum 在线源 进行安装

#docker 安装详解:https://blog.csdn.net/duanbaoke/article/details/119022848?spm=1001.2014.3001.5501

#安装依赖包

yum install -y yum-utils device-mapper-persistent-data lvm2

yum-config-manager --add-repo https://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

yum install -y docker-ce ##这里我只安装docker-ce了

systemctl start docker

systemctl status docker

五、Flannel 网络配置

不同 Node 上 Pod 之间的通信?

K8S 中Pod 网络通信种类:

-

Pod内容器与容器之间的通信

在同一个 Pod 内的容器(Pod 内的容器是不会跨宿主机的)共享同一个网络命令空间,相当于它们在同一台机器上一样,可以用 localhost 地址访问彼此的端口。 -

同一个Node内 Pod之间的通信

每个Pod 都有一个真实的全局IP地址,同一个 Node内的不同Pod之间可以直接采用对方 Pod 的IP 地址进行通信,Pod1 与 Pod2 都是通过 Veth 连接到同一个docker0 网桥,网段相同(172.17.0.0 网段),所以它们之间可以直接通信。 -

不同 Node 上 Pod 之间的通信

Pod 地址与 docker0 在同一网段,docker0 网段与宿主机网卡是两个不同的网段,且不同 Node 之间的通信只能通过宿主机的物理网卡进行。 docker0 是所有 pod 对外通信的端口。

所以:

- 要想实现不同 Node 上Pod 之间的通信,就必须想办法通过主机的物理网卡IP地址进行寻址和通信。

- 因此要满足两个条件:

- Pod 的 IP不能冲突;

- 将 Pod 的 IP 和所在的 Node 的 IP 关联起来,通过这个关联让不同 Node 上 Pod 之间直接通过内网IP地址通信。

Overlay Network 与 VXLAN

Overlay Network:

- 叠加网络,在二层或者三层基础网络上叠加的一种虚拟网络技术模式,该网络中的主机通过虚拟链路隧道连接起来(类似于VPN)。

VXLAN:

- 将源数据包封装到 UDP中,并使用基础网络的 IP/MAC 作为外层报文头进行封装,然后在以太网上传输,到达目的地后由隧道端点解封装并将数据发送给目标地址。

- 性能比UDP好,默认模式是UDP

K8S三种网络:

- 节点网络

- POD网络

- Server网络

k8s 的网络模型思考:

- 从 k8s 的网络模型我们可以看出来,在 k8s 当中希望做到的是每一个 Pod 都有一个在集群当中独一无二的IP,并且可以通过这个IP直接跟集群当中的其他 Pod 以及节点自身的网络进行通信。

- 一句话概括就是 k8s 当中希望网络是扁平化的。

- 所以只要再符合 k8s 网络模型的要求,就可以以插件的方式在 k8s 集群中作为跨节点网络通信实现。

- 目前比较流行的实现有 Flannel, calico, weave, canal 等。

Flannel 介绍

Flannel 学习链接

https://www.cnblogs.com/goldsunshine/p/10740928.html

https://www.cnblogs.com/k8s/p/12066624.html

- Flannel是 CoreOS 团队针对 Kubernetes 设计的一个网络规划服务,简单来说,它的功能是:让集群中的不同Node节点主机创建的 Docker容器都具有全集群唯一的虚拟IP地址。

- 即Flannel是一个插件,实现不同 Node 上 Pod 之间的通信。

- Flannel 转发的时候会去 ETCD 的存储路由条目中去查找地址;

Flannel 的工作流程

功能: Flannel 可以让每一个 Pod 都有一个在集群当中独一无二的IP,可以通过这个IP 实现不同 Node 上 Pod 之间的通信。

工作流程:

- 在Pod 之间进行通信的时候

- Flannel 会把内部的pod数据包封装到 UDP 当中,这个UDP 中会包含源地址(自己 Pod 的地址)和目标 Pod IP 地址,Flannel 直接通过证书 和 ETCD 通信 获取路由表,根据在 ETCD 保存的路由表,将信息通过 物理网卡 转发给目的 Node;

- 目的 Node 在接受到转发来的数据后,由 Flannel 服务进行解封装,然后暴露出 UDP 里的目的 Pod ip ,再根据目的 IP 由 Flannel

以上是关于k8seasy安装单节点kubernetes的主要内容,如果未能解决你的问题,请参考以下文章