流量复制 - 工具对比

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了流量复制 - 工具对比相关的知识,希望对你有一定的参考价值。

参考技术A 线下的测试难以模拟真实流量, 尤其难以模拟正常流量混杂着各色异常流量;所以复制线上流量进行测试,能够覆盖很多无法预见的异常流量.流量复制工具有很多, 例如Gor、tcpreplay、tcpcopy等; 这些工具贴合真实场景,能模拟真实流量, 并支持流量的放大或缩小,更容易测试出程序的瓶颈和潜在问题.

ngx_http_mirror_module 模块可以复制原始请求(镜像)通过内部跳转到另一个location.

配置如下:

流量放大, 配置两个mirror即可.

使用是很方便,但是线上nginx一般都承载了不止一个业务,修改nginx配置后需要nginx -s reload来使之生效,这种操作在线上还是尽量需要避免的.

Goreplay是用Golang写的一个 HTTP 实时流量复制工具。功能更强大,支持流量的放大、缩小,频率限制,还支持把请求记录到文件,方便回放和分析,也支持和 ElasticSearch 集成,将流量存入 ES 进行实时分析。

可以将流量复制到文件,然后再对他们进行回放。回放的时候,流量会维持原始的时间间隔。如果你使用了百分比来进行速率限制,那么回放的速率会相应的增加或减少。有了这种速率限制,gor就可以用来进行压力测试.

可以使用时间戳命名录制文件,默认情况下,文件是按“块”存储的, 即文件大小到达上限后, 添加后缀并新建另一个文件, 示例如下:

默认是按"块"存储文件的方式,但是可以参数配置 –output-file-append ,效果如下

时间格式化文件名的配置说明:

默认格式是 %Y%m%d%H

目前这种方式只支持"input-file", 而且只能用百分比去控制回放速率; 这个回放的速率比例是相对于input的, 即按照录下来的流量的时间戳去进行回放.

以2倍速率回放

如果"input-flie"是多个文件,可以用正则去匹配

配合如下配置参数,可以更好进行压力测试:

简单的HTTP流量复制

HTTP流量复制频率控制(获取每秒超过10个请求)

HTTP流量复制缩小

HTTP流量记录到本地文件

HTTP流量回放和压测

HTTP流量过滤复制

自定义一些流量复制的参数

将流量复制两份到不同的测试服务

将流量像负载均衡一样分配到不同的服务器

更多参数请查阅官方文档 https://github.com/buger/goreplay/wiki

Tcpcopy是一种请求复制工具。可以将线上流量拷贝到测试机器,实时的模拟线上环境。在不影响线上用户的情况下,使用线上流量进行测试,以尽早发现bug。也可以通过放大流量,进行压力测试,评估系统承载能力.

Istio流量管理实践之: 基于Istio实现流量对比分析

流量镜像

流量镜像,也称为影子流量,流量镜像提供一种尽可能低的风险为生产带来变化的强大功能。镜像会将实时流量的副本发送到镜像服务。镜像流量发生在主服务的关键请求路径之外。

在非生产或者测试环境中,尝试访问一个服务所有可能的测试用例组合是个非常不现实的任务。 在某些情况下,编写这些用例的所有工作也可能与实际生产所需的用例不匹配。在理想情况下,可以使用实时的生产用例和流量来帮助完善在测试环境中错过的功能区域。

一旦我们能够可靠地镜像流量,就可以开始做一些有价值的事情,例如通过请求流量对比工具Diffy,可以将引入测试集群的流量与生产集群中的预期行为进行比较。例如,我们可能想比较请求结果与预期结果间的偏差,或是API协议中的数据损坏情况,以便更好地兼容。

除此之外,需要注意:

- 当流量镜像到不同的服务时,会发生在请求的关键路径之外;

- 忽略对任何镜像流量的响应; 流量被视为“即发即忘”;

流量对比

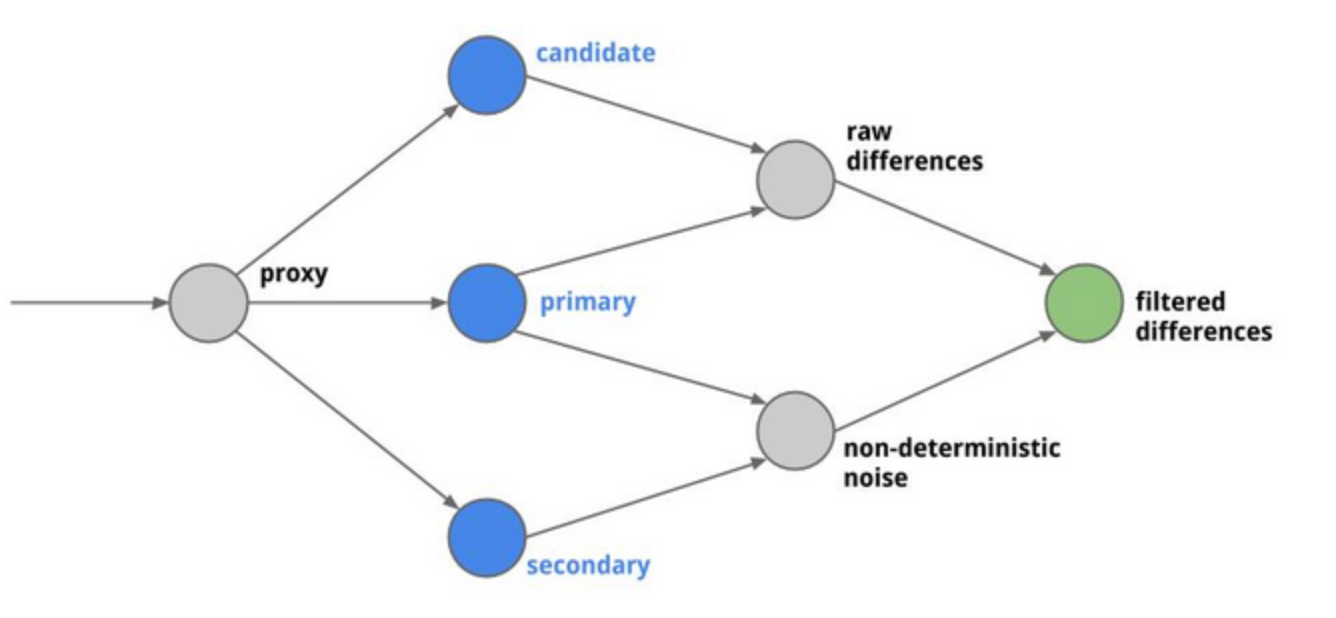

此处,插入一个代理就可以负责此类流量的协调,并对其进行有趣的比较。Diffy就是一款这样的代理工具。Diffy启动一个代理服务(例如监听端口8880),再根据用户设置的primary、secondary两个旧服务地址(primary和secondary代码完全相同,目的是为了减少噪音干扰)、candidate新服务地址。

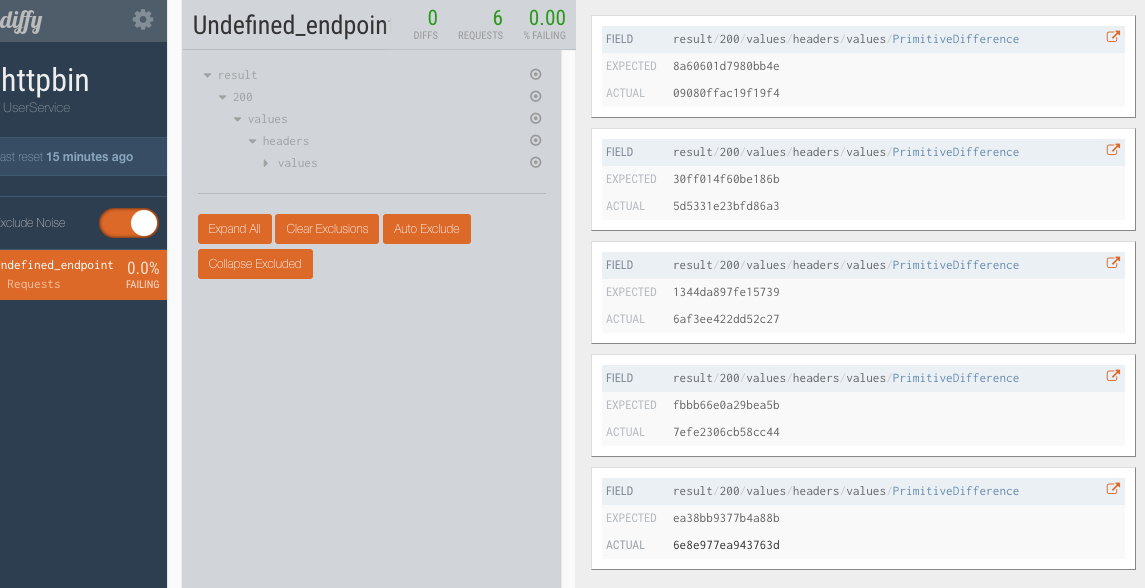

它还能够检测结果中的噪音,并通过先调用两个实时服务的实例来忽略它们(例如时间戳,单调递增计数器等提示),总结来说就是检测,然后在测试服务中忽略掉这部分。

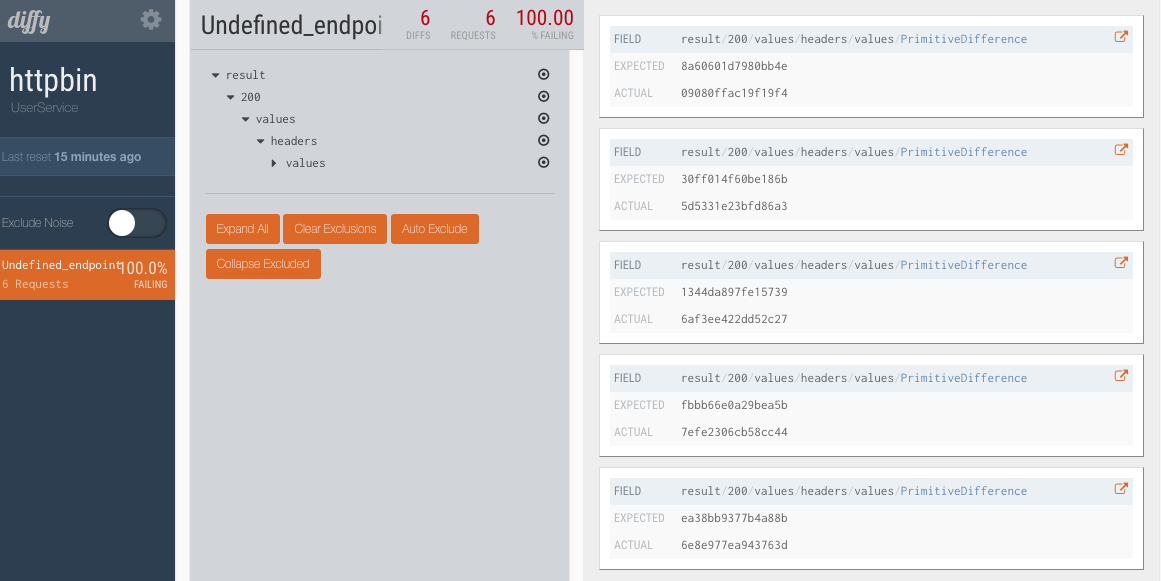

Diffy还提供了一个不错的页面可以用来查看调用结果、对比情况、和基于某些特征的过滤。它还有一个很好的管理控制台,可以查看有关调用比较结果的功能指标(metrics)和统计数据(statistics)。

创建用于Istio流量镜像的服务

在此任务中,将首先强制所有流量到 v1 版本的服务。然后,将使用规则将一部分流量镜像到 v2版本。

首先部署两个版本的示例服务。

版本1的部署使用了Docker镜像httpbin,提供常见的http请求访问:

apiVersion: extensions/v1beta1

kind: Deployment

metadata:

name: mirrorservice-sample-v1

spec:

replicas: 1

template:

metadata:

labels:

app: mirrorservice-sample

version: v1

spec:

containers:

- image: docker.io/kennethreitz/httpbin

imagePullPolicy: IfNotPresent

name: mirrorservice-sample

command: ["gunicorn", "--access-logfile", "-", "-b", "0.0.0.0:44134", "httpbin:app"]

ports:

- containerPort: 44134 版本2的部署使用了自定义的Docker镜像,对应的Dockerfile如下:

FROM nginx:latest

COPY default.conf /etc/nginx/conf.d/

EXPOSE 80所需的nginx 配置文件:

server {

listen 44134;

server_name localhost;

location / {

proxy_pass http://httpbin-diffy.diffy:8880/;

proxy_http_version 1.1;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";

}

}版本2的部署作为Istio的流量镜像目标,在接收到流量之后会转发到Diffy的代理中。当前没有直接将Diffy代理作为Isito流量镜像目标,原因是Diffy代理与Envoy代理目前本身有冲突,无法正常流量转发,因此需要此部署中转一下。

apiVersion: extensions/v1beta1

kind: Deployment

metadata:

name: mirrorservice-sample-v2

spec:

replicas: 1

template:

metadata:

labels:

app: mirrorservice-sample

version: v2

spec:

containers:

- name: mirrorservice-sample

image: registry.cn-beijing.aliyuncs.com/wangxining/mirrorservice:0.1

imagePullPolicy: Always

ports:

- containerPort: 44134对应的Kubernetes service:

apiVersion: v1

kind: Service

metadata:

name: mirrorservice-sample

spec:

type: ClusterIP

ports:

- name: http

port: 44134

selector:

app: mirrorservice-sample创建流量镜像的Istio策略

默认情况下,Kubernetes 在服务的两个版本之间进行负载均衡。创建如下流量镜像规则将 100% 的流量发送到 v1, 同时指定流量镜像到v2。当流量被镜像时,请求将通过其主机/授权报头发送到镜像服务附上 -shadow 。

apiVersion: networking.istio.io/v1alpha3

kind: DestinationRule

metadata:

name: mirrorservice-sample

spec:

host: mirrorservice-sample

subsets:

- name: v1

labels:

version: v1

- name: v2

labels:

version: v2

---

apiVersion: networking.istio.io/v1alpha3

kind: VirtualService

metadata:

name: mirrorservice-sample

spec:

hosts:

- mirrorservice-sample

http:

- route:

- destination:

host: mirrorservice-sample

subset: v1

weight: 100

#- destination:

# host: mirrorservice-sample

# subset: v2

# weight: 0

mirror:

host: mirrorservice-sample

subset: v2搭建Diffy用于请求流量对比

Diffy可以作为代理,截取请求并发送至所有运行的服务实例,通过对比响应结果来发现每次迭代代码中可能存在的问题。其中,Diffy上运行了三类代码实例:

- 线上稳定版本:一个运行线上稳定版本代码的节点

- 线上稳定版本备份:同样运行了线上的稳定版本,用于消除噪音

- 测试版本:待上线的测试版本,用于和线上环境代码进行对比

在实际Diffy测试中,会发现大部分的接口都会有一定差异,原因是这些响应中存在了噪音,噪音可能包括:

- server响应中生成的时间戳

- 随机生成的数字

- 系统服务间的有条件竞争

Diffy能够通过一定的方式,清除这类噪音,保证分析结果不被影响。

创建Diffy及示例服务

通过以下YAML创建Diffy服务:

apiVersion: v1

kind: Service

metadata:

name: httpbin-diffy

labels:

app: httpbin-diffy

spec:

ports:

- name: http-proxy

port: 8880

- name: http-admin

port: 8881

- name: http-console

port: 8888

selector:

app: httpbin-diffy

---

apiVersion: extensions/v1beta1

kind: Deployment

metadata:

labels:

app: httpbin-diffy

version: v2

name: httpbin-diffy-v2

spec:

replicas: 1

selector:

matchLabels:

app: httpbin-diffy

version: v2

template:

metadata:

labels:

app: httpbin-diffy

version: v2

spec:

containers:

- image: lordofthejars/diffy:1.0

imagePullPolicy: IfNotPresent

livenessProbe:

exec:

command:

- curl

- localhost:8888

initialDelaySeconds: 10

periodSeconds: 60

timeoutSeconds: 1

name: httpbin-diffy

args: ["-candidate=httpbin-candidate:8080", "-master.primary=httpbin-master:8080", "-master.secondary=httpbin-master:8080", "-service.protocol=http", "-serviceName=httpbin", "-proxy.port=:8880", "-admin.port=:8881", "-http.port=:8888", "-rootUrl=‘localhost:8888‘"]

ports:

- containerPort: 8888

name: http-console

protocol: TCP

- containerPort: 8880

name: http-proxy

protocol: TCP

- containerPort: 8881

name: http-admin

protocol: TCP

readinessProbe:

exec:

command:

- curl

- localhost:8888

initialDelaySeconds: 10

periodSeconds: 60

timeoutSeconds: 1

securityContext:

privileged: false通过以下YAML创建示例所用的primary、secondary(当前示例中与primary相同)与candidate服务:

apiVersion: v1

kind: Service

metadata:

name: httpbin-master

labels:

app: httpbin-master

spec:

ports:

- name: http

port: 8080

selector:

app: httpbin

version: v1

---

apiVersion: v1

kind: Service

metadata:

name: httpbin-candidate

labels:

app: httpbin-candidate

spec:

ports:

- name: http

port: 8080

selector:

app: httpbin

version: v2

---

apiVersion: extensions/v1beta1

kind: Deployment

metadata:

name: httpbin-v1

spec:

replicas: 1

template:

metadata:

labels:

app: httpbin

version: v1

spec:

containers:

- image: docker.io/kennethreitz/httpbin

imagePullPolicy: IfNotPresent

name: httpbin

command: ["gunicorn", "--access-logfile", "-", "-b", "0.0.0.0:8080", "httpbin:app"]

ports:

- containerPort: 8080

---

apiVersion: extensions/v1beta1

kind: Deployment

metadata:

name: httpbin-v2

spec:

replicas: 1

template:

metadata:

labels:

app: httpbin

version: v2

spec:

containers:

- image: docker.io/kennethreitz/httpbin

imagePullPolicy: IfNotPresent

name: httpbin

command: ["gunicorn", "--access-logfile", "-", "-b", "0.0.0.0:8080", "httpbin:app"]

ports:

- containerPort: 8080发送流量进行镜像验证

启动 sleep 服务,这样就可以使用 curl 来提供负载:

cat <<EOF | istioctl kube-inject -f - | kubectl create -f -

apiVersion: extensions/v1beta1

kind: Deployment

metadata:

name: sleep

spec:

replicas: 1

template:

metadata:

labels:

app: sleep

spec:

containers:

- name: sleep

image: tutum/curl

command: ["/bin/sleep","infinity"]

imagePullPolicy: IfNotPresent

EOF进入到SLEEP_POD, 具体POD名称根据实际赋值。

kubectl exec -it $SLEEP_POD -c sleep sh发送流量:

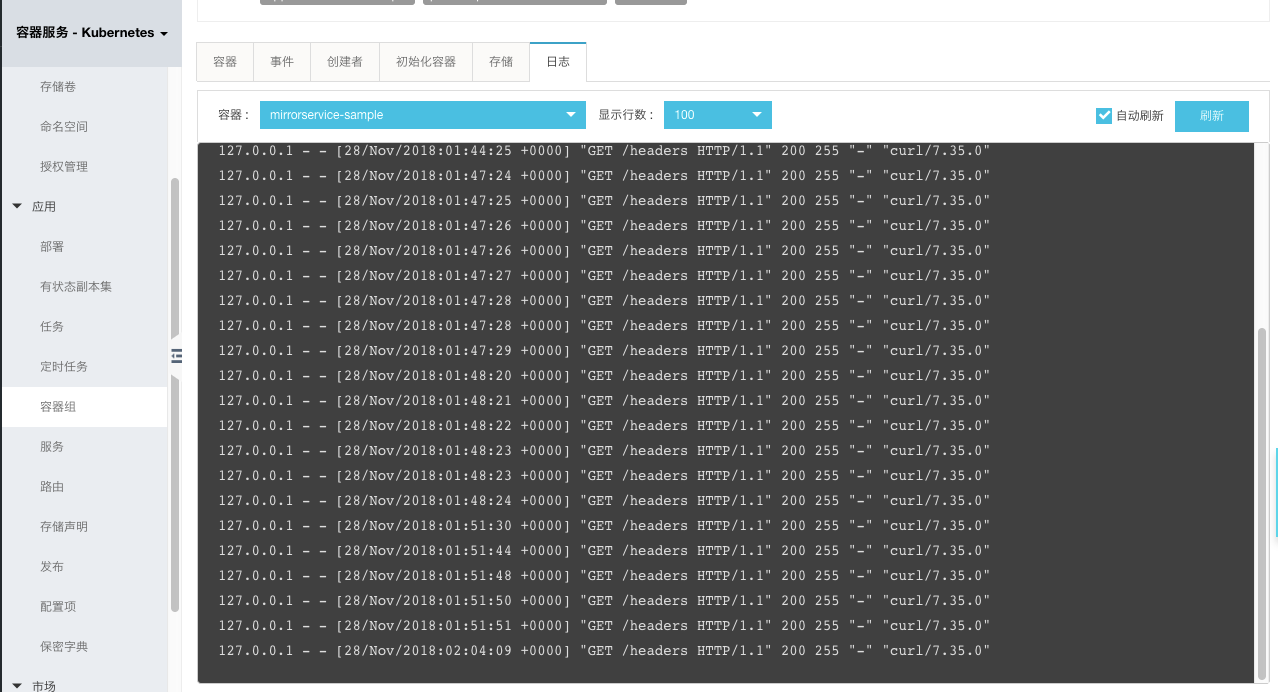

curl -v http://mirrorservice-sample:44134/headers可以查看 v1的访问日志记录,如下所示创建的请求100%指向了v1。

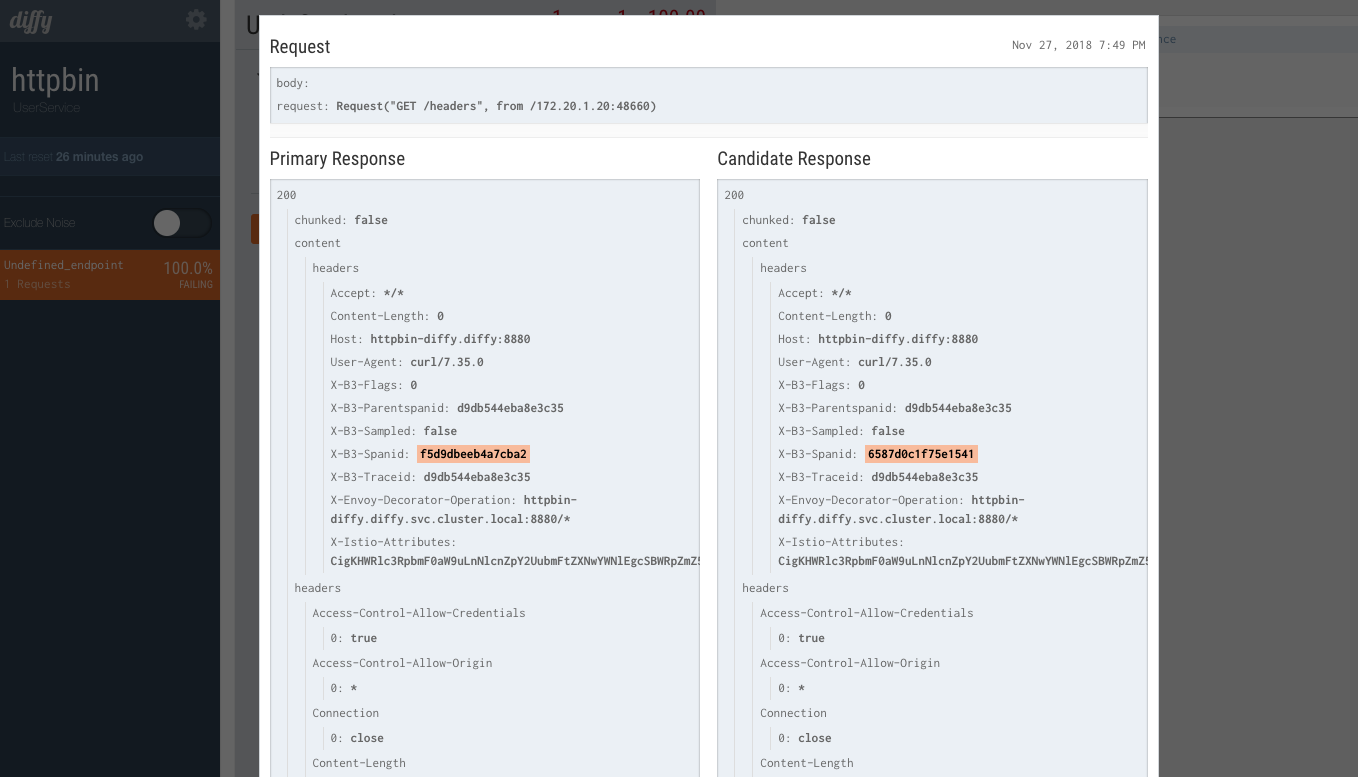

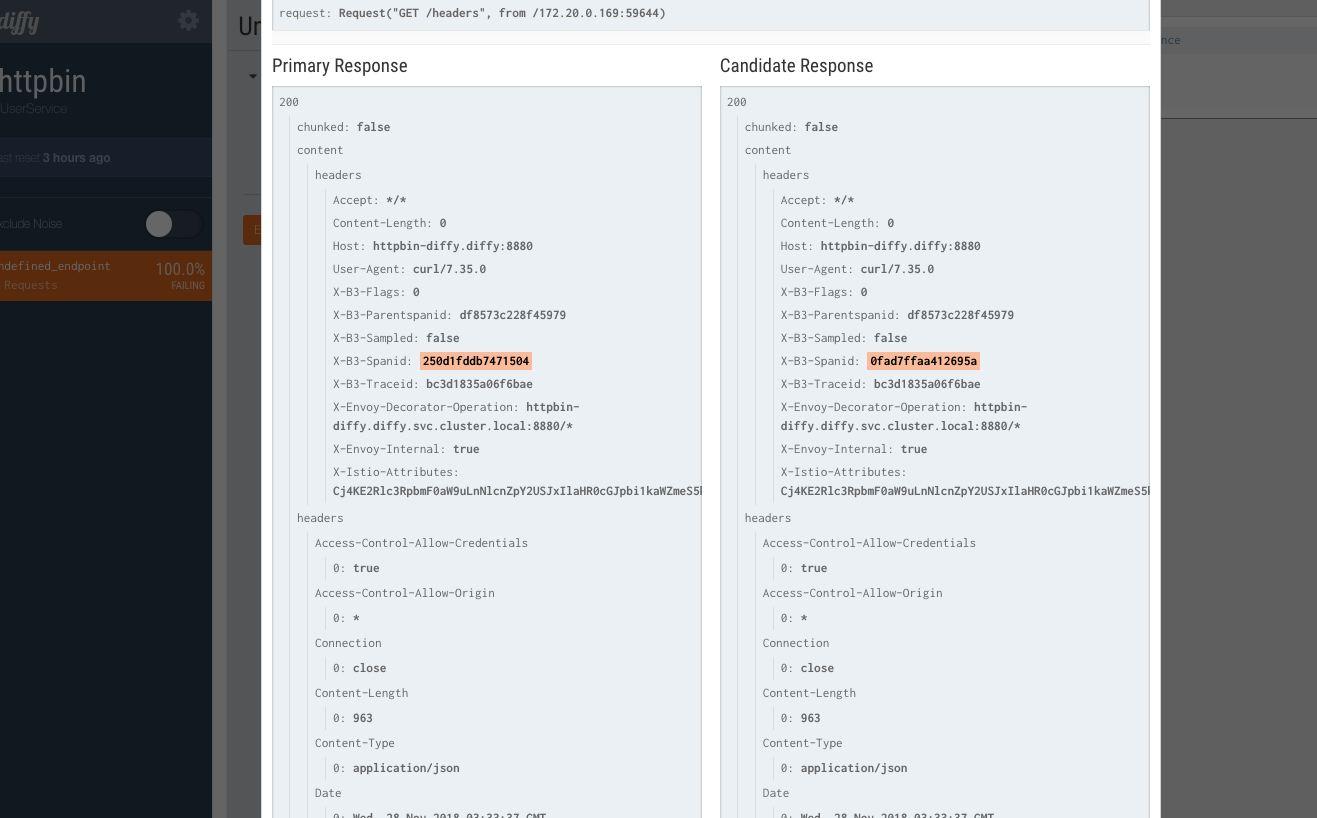

与此同时,查看Diffy的Web界面,可以看到创建的请求也被镜像到Diffy Proxy:

Diffy能够通过一定的方式,清除这类噪音,保证分析结果不被影响。

结论

流量镜像提供一种尽可能低的风险为生产带来变化的强大功能。镜像会将实时流量的副本发送到镜像服务,镜像流量发生在主服务的关键请求路径之外。一旦我们能够可靠地镜像流量,就可以开始做一些有价值的事情,例如通过请求流量对比工具Diffy,可以将引入测试集群的流量与生产集群中的预期行为进行比较。

支持流量镜像只是 Istio 的众多功能之一,它将使基于大型微服务的应用程序的生产部署与管理变得更加简单。欢迎大家使用阿里云上的容器服务,快速搭建微服务的开放治理平台Istio,比较简单地集成到自己项目的微服务开发中。

原文链接

更多技术干货 请关注阿里云云栖社区微信号 :yunqiinsight

以上是关于流量复制 - 工具对比的主要内容,如果未能解决你的问题,请参考以下文章

2023年十款开源测试开发工具分享(自动化性能造数据流量复制)