Android科大讯飞——语音识别

Posted 摸爬滚打的程序媛

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Android科大讯飞——语音识别相关的知识,希望对你有一定的参考价值。

目录

因为最近项目需要,需要集成语音识别的功能,这里记录下科大讯飞语音识别的集成和使用,也方便其它小伙伴参考,如果哪里有问题,可以提出来以便改正。

一、准备工作

1、注册一个讯飞开放平台账号,官网https://www.xfyun.cn/

2、登陆账号之后,在首页进入“控制台”。

3、 进入控制台后,选择“创建新应用”,填写相关信息后,提交。

4、应用创建成功之后,去下载你的应用需要的SDK,因为此项目是语音识别的,所以就选择“语音听写”这个SDK。

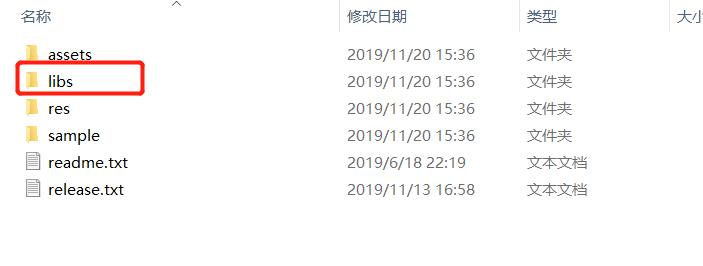

5、语音识别android SDK下载完成之后,解压出来如图所示。因为本案例只使用没有UI的识别,所以,我们只需要libs目录下的文件。

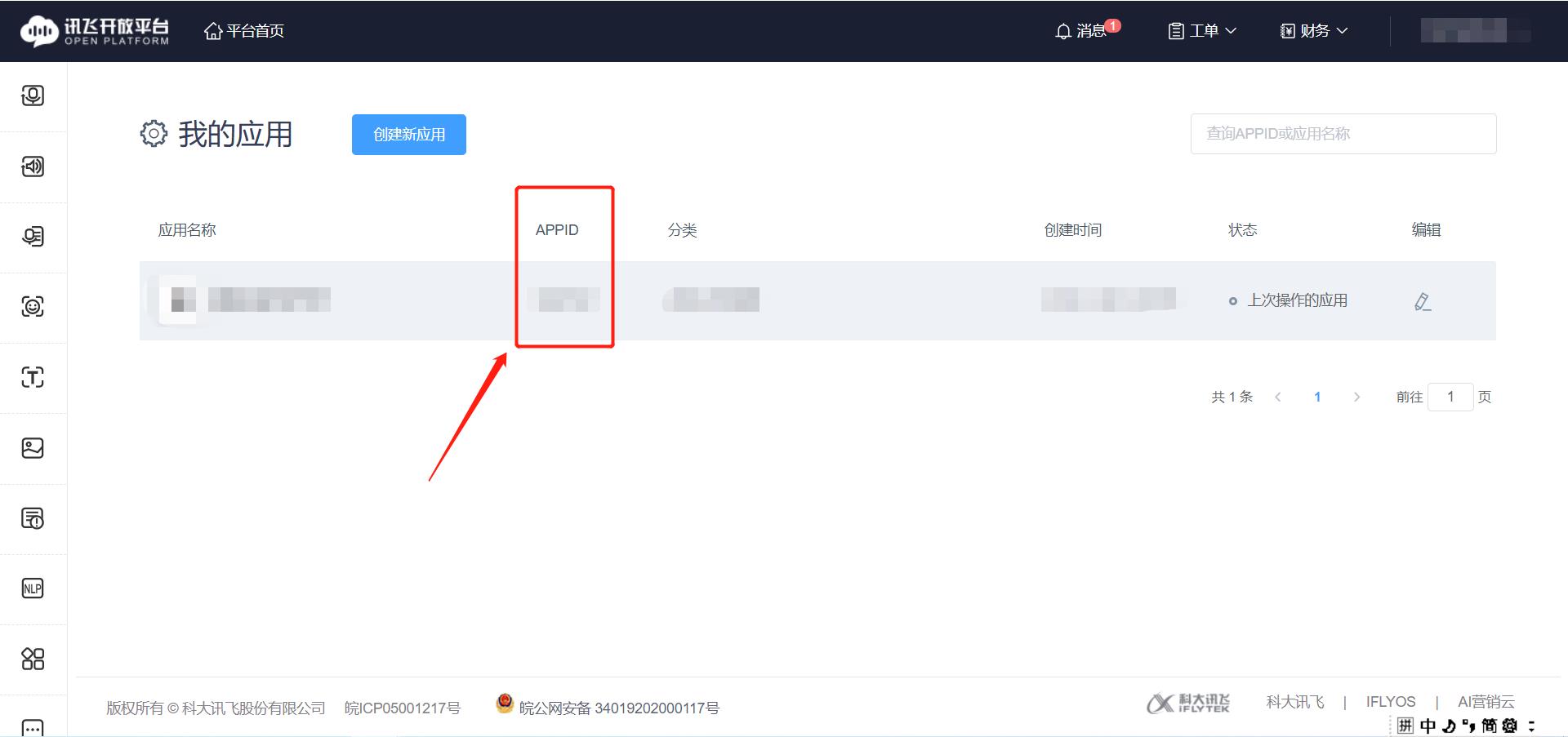

6、找到你刚刚创建的应用,保存下APP ID,这个到后面项目代码中会用到。

二、项目集成

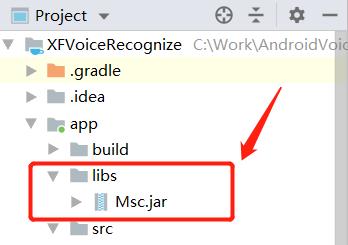

1、新建一个工程项目,将下载下来的SDK包中,libs目录下的Msc.jar包复制到项目的libs目录下,并添加为项目的依赖。

2、项目src/main/目录下,新建 jniLibs文件夹。

3、将SDK包中,libs目录下的arm64-v8a、armeabi-v7a两个文件夹,复制到项目的jniLibs目录下。

三、项目实战

1、添加用户权限(官方文档提供的权限,实际应用中根据实际项目需要进行删减)

注意:Android 6.0以后,一些危险权限需要动态申请。

<!--连接网络权限,用于执行云端语音能力 --> <uses-permission android:name="android.permission.INTERNET"/> <!--获取手机录音机使用权限,听写、识别、语义理解需要用到此权限 --> <uses-permission android:name="android.permission.RECORD_AUDIO"/> <!--读取网络信息状态 --> <uses-permission android:name="android.permission.ACCESS_NETWORK_STATE"/> <!--获取当前wifi状态 --> <uses-permission android:name="android.permission.ACCESS_WIFI_STATE"/> <!--允许程序改变网络连接状态 --> <uses-permission android:name="android.permission.CHANGE_NETWORK_STATE"/> <!--读取手机信息权限 --> <uses-permission android:name="android.permission.READ_PHONE_STATE"/> <!--读取联系人权限,上传联系人需要用到此权限 --> <uses-permission android:name="android.permission.READ_CONTACTS"/> <!--外存储写权限,构建语法需要用到此权限 --> <uses-permission android:name="android.permission.WRITE_EXTERNAL_STORAGE"/> <!--外存储读权限,构建语法需要用到此权限 --> <uses-permission android:name="android.permission.READ_EXTERNAL_STORAGE"/> <!--配置权限,用来记录应用配置信息 --> <uses-permission android:name="android.permission.WRITE_SETTINGS"/> <!--手机定位信息,用来为语义等功能提供定位,提供更精准的服务--> <!--定位信息是敏感信息,可通过Setting.setLocationEnable(false)关闭定位请求 --> <uses-permission android:name="android.permission.ACCESS_FINE_LOCATION"/> <!--如需使用人脸识别,还要添加:摄相头权限,拍照需要用到 --> <uses-permission android:name="android.permission.CAMERA" />

2、初始化即创建语音配置对象,只有初始化后才可以使用MSC的各项服务。建议将初始化放在程序入口处(如Application、Activity的onCreate方法)。此处将初始化工作放在新建的BaseApplication.java 中,并且在AndroidManifest.xml文件中使用该BaseApplication。

public class BaseApplication extends Application @Override public void onCreate() // 将“12345678”替换成您申请的APPID,申请地址:http://www.xfyun.cn // 请勿在“=”与appid之间添加任何空字符或者转义符 SpeechUtility.createUtility(this, SpeechConstant.APPID +"=12345678"); super.onCreate();

3、 初始化语音识别对象SpeechRecognizer,并初始化InitListener监听,获取初始化状态。

此处的setParameter()是根据自己需求加的,如果你需要添加其它参数,可以查看SDK 文档。

/** * 初始化语音识别对象 */ private void initVoiceRecognize() //获取系统默认语言 if (Build.VERSION.SDK_INT >= Build.VERSION_CODES.N) locale = LocaleList.getDefault().get(0); else locale = Locale.getDefault(); language = locale.getLanguage() + "-" + locale.getCountry(); Log.d(TAG, "系统默认language:"+language); // 初始化识别无UI识别对象 //使用SpeechRecognizer对象,可根据回调消息自定义界面; speechRecognizer = SpeechRecognizer.createRecognizer(MainActivity.this, initListener); if(speechRecognizer != null) //设置返回结果格式,目前支持json,xml以及plain 三种格式,其中plain为纯听写文本内容 speechRecognizer.setParameter(SpeechConstant.RESULT_TYPE, "plain"); // 设置语音前端点:静音超时时间,单位ms,即用户多长时间不说话则当做超时处理 //取值范围1000~10000 speechRecognizer.setParameter(SpeechConstant.VAD_BOS, "4000"); //设置语音后端点:后端点静音检测时间,单位ms,即用户停止说话多长时间内即认为不再输入, //自动停止录音,范围0~10000 speechRecognizer.setParameter(SpeechConstant.VAD_EOS, "1000"); //设置语音输入语言,zh_cn为简体中文,en_us为美式英文 if (language.equalsIgnoreCase("zh-CN")) // 设置语言 speechRecognizer.setParameter(SpeechConstant.LANGUAGE, "zh_cn"); else // 设置语言 speechRecognizer.setParameter(SpeechConstant.LANGUAGE, "en_us"); Log.d(TAG, "语音识别对象完成初始化"); else Log.d(TAG, "语音识别对象 == null");

//初始化对象时,通过此回调接口,获取初始化状态。 private InitListener initListener = new InitListener() @Override public void onInit(int i) Log.d(TAG, "SpeechRecognizer initListener() code = " + i); if (i != ErrorCode.SUCCESS) Log.e(TAG, "语音识别初始化失败,错误码:" + i); else Log.w(TAG, "语音识别初始化成功,错误码:" + i); ;

4、初始化识别监听RecognizerListener,用于startListening()开启监听。

//设置识别监听器,开始监听 speechRecognizer.startListening(recognizerListener);

//初始化识别监听器 private RecognizerListener recognizerListener = new RecognizerListener() @Override public void onVolumeChanged(int i, byte[] bytes) //音量变化 @Override public void onBeginOfSpeech() //开始说话 @Override public void onEndOfSpeech() //结束说话 //继续识别,并设置监听器 speechRecognizer.startListening(recognizerListener); @Override public void onResult(RecognizerResult recognizerResult, boolean b) //返回结果 返回的结果可能为null,请增加判断处理。 if(recognizerResult == null) Log.d(TAG, "识别出来 onResult:" + b + " recognizerResult == null"); else Log.d(TAG, "识别出来 onResult:" + b + " content:" + recognizerResult.getResultString()); tvRecognizeResult.setText(recognizerResult.getResultString()); @Override public void onError(SpeechError speechError) //错误回调 if(isRecognizing) Log.e(TAG, "语音识别出错 onError()"); @Override public void onEvent(int i, int i1, int i2, Bundle bundle) //扩展接口 ;

四、项目演练

注意:因为是在线语音识别,所以项目需要在真机,且有网络的情况下运行,demo代码中没有对网络状态进行判断,小伙伴们可以自行添加。

五、参考文档

语音听写 Android SDK 文档 https://www.xfyun.cn/doc/asr/voicedictation/Android-SDK.html

MSC Android API 文档:http://mscdoc.xfyun.cn/android/api/

六、案例源码

码云:https://gitee.com/lilium_foliage/XFVoiceRecognize

csdn:https://download.csdn.net/download/qq_38950819/12005144

以上是关于Android科大讯飞——语音识别的主要内容,如果未能解决你的问题,请参考以下文章