奇异值分解(SVD)和图像压缩

Posted deephub

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了奇异值分解(SVD)和图像压缩相关的知识,希望对你有一定的参考价值。

在本文中,我将尝试解释 SVD 背后的数学及其几何意义,还有它在数据科学中的最常见的用法,图像压缩。

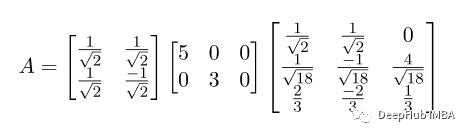

奇异值分解是一种常见的线性代数技术,可以将任意形状的矩阵分解成三个部分的乘积:U、S、V。原矩阵A可以表示为:

具体来说,A矩阵中的奇异值就是\\Sigma矩阵中的对角线元素,它们是矩阵A的特征值的平方根,表示A矩阵在各个主方向上的拉伸程度。U矩阵是AAT的特征向量构成的正交矩阵,表示数据集在降维后的新的坐标系中的投影。V矩阵是ATA的特征向量构成的正交矩阵,表示每个数据点在降维后的新坐标系中的坐标。

一个矩阵的奇异值(singular values)是指其奇异值分解中的\\Sigma矩阵的对角线上的元素,也就是特征值的平方根。换句话说,矩阵的奇异值是矩阵的奇异值分解中量度矩阵对输入矩阵进行的线性变换的尺度因子。

奇异值在很多应用中都有广泛的应用,例如在图像处理中,它可以用来对图像进行压缩和降噪;在推荐系统中,它可以用来对用户的偏好进行建模和推荐相关的产品或服务;在自然语言处理中,它可以用来对文本数据进行降维和特征提取等。

数学原理

如果我们有一个矩阵A

要计算 SVD,首先需要通过找到 AA^T 的特征值来计算奇异值。

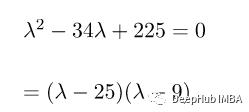

上述矩阵的特征方程为:

所以得到的奇异值是:

奇异向量就是 ATA 的正交特征向量集。ATA 的特征值是 25、9 和 0,由于 ATA 是对称的,我们知道特征向量是正交的。

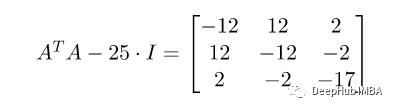

所以,先计算 λ=25

然后进行化简:

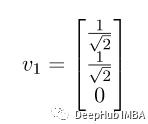

其方向的单位向量为:

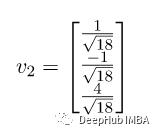

同理 对于 λ = 9,特征向量为:

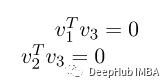

对于第三个特征向量 0,我们可以使用它垂直于 v1 和 v2 的属性:

求解上述方程得到第三个特征向量

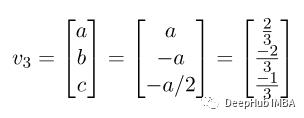

现在,我们计算 U,得到

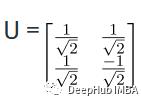

这样就得到了最终的 SVD 方程:

图像压缩

通过仅保留最重要的奇异值及其对应的奇异向量,SVD 被用于图像压缩以减小图像的大小。这可以从根本上减少在不丢失其最重要的视觉数据的情况下存储图像所需的额外存储量。

我们将使用下面的图像进行图像压缩:

导入库和读取图片十分简单

import requests

import cv2

import numpy as np

import matplotlib.pyplot as plt

img = cv2.imread('flower.bmp')

gray_image = cv2.cvtColor(img, cv2.COLOR_BGR2GRAY)

gray_image = gray_image.astype(np.float64)

这里我们将图像转换成灰度图,执行奇异值分解

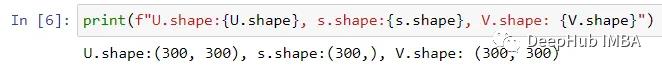

U, s, V = np.linalg.svd(gray_image, full_matrices=False)

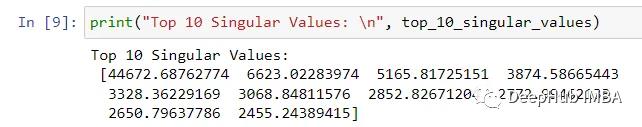

numpy中就包含了该方法,所有我们直接调用即可,我们看看前 10 个奇异值

top_10_singular_values = s[:10]

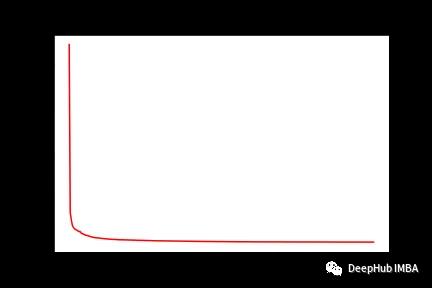

可视化

plt.plot(range(1, len(s) + 1), s, 'r-')

plt.xlabel("Rankings")

plt.ylabel("Singular Values")

plt.title("Singular Values versus their Rankings")

plt.savefig("Singular_values_vs_rankings.png")

plt.show()

从奇异值和排序图中可以注意到图像的大部分值都包含在少量奇异值中,所以可以得出到较高的奇异值包含的图像信息水平非常低,这也说明使用奇异值分解进行降维和图像压缩是可行的。

现在,让我们尝试重建和显示图像。

k_values = [10, 50, 100]

plt.figure(figsize=(12,6))

for i in range(len(k_values)):

low_rank = U[:, :k_values[i]] @ np.diag(s[:k_values[i]]) @ V[:k_values[i], :]

plt.subplot(2,3,i+1),

plt.imshow(low_rank, cmap='gray'),

plt.title(f"For K value = k_values[i]")

plt.savefig("Reconstruction_with_k_values.png")

可以注意到具有不同 K 值的所有图像都有显着差异。使用了前 10 个奇异值,结果图像一点也不清晰。使用了前 50 个奇异值,生成的图像比之前的图像清晰多了,但是还有一些轻微的模糊。当我们使用前 100 个奇异值时,图像比前两张图像越来越清晰,基本和原图很接近了。随着 K 值的增加,图像的清晰度也会增加。

总结

本文介绍了奇异值分解 (SVD) 的数学原理和一个实际的应用案例,可以看到SVD是一种强大的图像压缩方法,有助于在减小图像尺寸的同时保留大部分重要的视觉信息。

https://avoid.overfit.cn/post/f0a675aad6994b61a2aa93fb647a0633

作者:Neokai

奇异值分解(SVD)

参考技术A 奇异值分解(SVD)是一种矩阵因子分解方法。任意一个m*n的矩阵,都可以表示为三个矩阵的乘积(因子分解)的形式,分别是m阶正交矩阵、由降序排列的非负的对角线元素组成的m*n矩阵和n阶正交矩阵,称为该矩阵的奇异值分解。矩阵的奇异值分解一定存在,但不唯一。奇异值分解可以看作出矩阵数据压缩的一种方法。即用因子分解的方式近似地表示原始矩阵,这种矩阵在平方损失意义下的最优近似。矩阵的奇异值分解是指,将一个非零的m*n实矩阵 ,表示为以下三个实矩阵乘积形式的运算,即进行矩阵的因子分解

其中U是m阶正交矩阵,V是n阶正交矩阵, 是由降序排列的非负的对角元素组成的 的矩形对角矩阵

称为矩阵的奇异值分解, 称为矩阵A的奇异值, 的列向量称为左奇异向量, 的列向量成为右奇异向量

紧凑奇异值分解是与原始矩阵等秩的奇异值分解,截断奇异值分解是比原始矩阵降低秩的奇异值分解。在实际应用中,常常需要对矩阵的数据进行压缩,将其近似表示,奇异值分解提供了一种方法。奇异值分解是在平方损失意义下对矩阵的最优近似。紧奇异值分解对应着无损压缩,截断奇异值分解对应着有损压缩

设有 实矩阵A,其秩为rank(A) = r, ,则称 为A的紧奇异值分解,即

其中 是 矩阵, 是 矩阵, 是r阶对角矩阵,矩阵 由完全奇异分解中的前r列,矩阵 由V的前r列,矩阵 由 的前r个对角线元素得到,紧奇分解的对角矩阵 的秩与原始矩阵A的秩相等

在矩阵的奇异值分解中,只取最大的k个奇异值(k < r,r为矩阵的秩)对应的部分,就得到矩阵的截断奇异值分解。实际应用中提到的矩阵的奇异值分解,通常指截断奇异值分解

设A为 实矩阵,其秩rank(A)=r,且, ,则称 为矩阵A的截断奇异值分解

其中 是 矩阵, 是n*k矩阵, 是k阶对角矩阵;矩阵 由完全奇异分解U的前k列,矩阵 由V的前k列,矩阵 由 的前k个对角线元素得到。对角矩阵 的秩比原始矩阵A的秩低。

从线性变换的角度理解奇异值分解, 矩阵A表示从n维空间 到m空间 的一个线性变换,

x和Ax分别表示各自空间的向量。线性变换可以分解为三个简单的变换:一个坐标系的旋转或反射变换、一个坐标轴的缩放变换、另一个坐标系的旋转或反射。

对矩阵A进行奇异值分解,得到 ,V和U都是正交矩阵,所以V的列向量 构成空间的一组标准正交基,表示 中的正交坐标系的旋转或反射;U的列向量 构成 空间的一组标准正交基,表示 中正交坐标系的旋转或反射; 的对角元素 是一组非负实数,表示 中原始正坐标系坐标轴的 倍的缩放变换。

任意一个向量 ,经过基于 的线性变换,等价于经过坐标系的旋转或反射变换 ,坐标轴的缩放变换 ,以及坐标轴的旋转或反射变换U,得到相框

矩阵A是 的正交实矩阵,则矩阵 是n阶实对称矩阵,因而 的特征值都是实数,并且存在一个n阶正实矩阵V实现 的对角化,使得 成立,其中 是n阶对角矩阵,其对角元素由 的特征值组成。

而且, 的特征值都是非负的。事实上,令 是 的一个特征值,x是对应的特征向量,则

于是

可以假设正交矩阵V的列排列使得对应的特征值形成降序排列。

计算特征值的平方根(实际上解释矩阵A的奇异值)

设矩阵A的秩是r,rank(A)=r,则矩阵 的秩也是r。由于 是对称矩阵,它的秩等于正的特征值的个数。

对应的

令

其中 为 的特征值对应的特征向量, 为0特征值对应的特征向量。

则

这就是矩阵A的奇异值分解中的n阶正交矩阵V

令

则 是个一个r阶对角矩阵,其对角线元素为按降序排列的正的 ,于是 矩形对角矩阵 可以表示为

这就是矩阵A的奇异值分解中的 矩阵对角矩阵

接着构造m阶正交实矩阵U

令

则有

的列向量构成正交基是因为

对 的非零空间的一组标准正交基 ,令

并令

以上是关于奇异值分解(SVD)和图像压缩的主要内容,如果未能解决你的问题,请参考以下文章