从此告别繁琐的模型微调,LLM-Adapters助力NLP任务快速高效微调!

Posted PaperWeekly

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了从此告别繁琐的模型微调,LLM-Adapters助力NLP任务快速高效微调!相关的知识,希望对你有一定的参考价值。

动机和背景

大型语言模型(LLMs)的成功,如 GPT-3 和 ChatGPT,发起了许多替代方案的开发。这些替代方案通过使用特定于任务的数据(如 ChatDoctor)或指令数据(如 Alpaca),微调 LLMs 来提高性能。但是,其中最具吸引力的方法是基于 Adapter 的参数微调(PEFT),因为它只需要微调插入的外部参数,而不是整个与训练模型,就能获得不错的性能。

为了进一步研究 LLM 的 PEFT 方法,我们开发了一个易于使用的框架——LLM-Adapters,它将各种 Adapter 集成到 LLMs 中。该框架包括最先进的 LLMs,如 LLaMA、BLOOM 和 GPT-J 等模型,以及广泛使用的 Adapter,如 Series adapter、Parallel adapter 和 LoRA。同时,我们也会持续更新新的 LLMs 和 Adapter,以满足用户不断变化的需求。

项目名称:

LLM-Adapters: An Adapter Family for Parameter-Efficient Fine-Tuning of Large Language

论文链接:

https://arxiv.org/abs/2304.01933

开源链接:

https://github.com/AGI-Edgerunners/LLM-Adapters

如果您是自然语言处理领域的从业者或爱好者,LLM-Adapters 将是您的强大工具。使用这个框架,您可以快速实现高性能模型,而不需要进行繁琐的模型微调。无论您正在构建聊天机器人、进行文本分类,或是进行其他自然语言处理任务,LLM-Adapters 都能为您提供强有力的支持。不要犹豫,赶快试试吧,它会为您的工作带来意想不到的帮助!

Adapters大家族

Adapters 是包含少量可训练参数并集成到 LLM中的外部模块。在训练期间,LLM 的参数保持固定,而 Adapter 模型的参数被调整以执行特定的任务。因此,由 LLM 生成的表示不会因任务特定的调整而扭曲,而 Adapter 模型则获得了编码特定任务信息的能力。

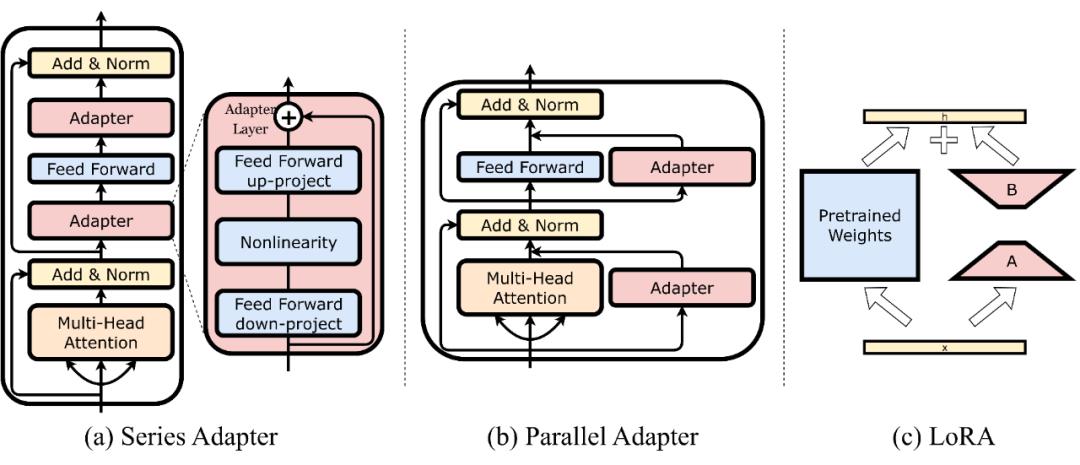

本框架在 LLM 中提出了三种 Adapter 类型:Series Adapter, Parallel Adapter 和 LoRA。我们将在之后的工作更新更多的 Adapter。

Series Adapter:受 [1] 的启发,我们的框架将瓶颈前馈层依次添加到 Transformer 的多头注意力层和前馈层。图(a)显示了瓶颈 Adapter 由两层前馈神经网络组成,包括一个下投影矩阵,一个非线性函数,和投影,以及输入和输出之间的残差连接

Parallel Adapter:将瓶颈前馈层与 LLMs 中 Transformer 的多头注意力层和前馈层并行集成。如图(b)所示,Adapter 与每个 Transformer 合并在一起

LoRA:[2] 提出了 LoRA,旨在用更少的可训练参数有效地微调预训练模型。LoRA 在 LLMs 的现有层中引入了可训练的低秩分解矩阵,使模型能够适应新的数据,同时保持原始 LLMs 固定以保留现有的知识。

具体来说,LoRA 通过注入低秩分解矩阵,对表示为矩阵乘法的每个模型层执行重新参数化,如图(c)所示。这种重新参数化使模型能够进行微调,而不需要计算完整的密集矩阵乘法,这可能是计算成本很高的。通过降低矩阵的秩,LoRA 有助于减少微调 llm 时的参数数量。

数据集验证

下面展示了不同模型是否可以使用的各类 Adapter:

我们 6 个数学推理数据集上,测试不同 LLMs 参数高效微调的精度,6 个数据集分别是:(1)MultiArith;(2)GSM8K;(3)AddSub;(4)AQuA;(5) SingleEq;(6)SVAMP.

我们使用 Zero-shot-Cot 方法在 GPT-3.5 text-Davinci-003 收集到的数据 math_data.json 进行微调。结果如下:

未来规划

在任务和数据集上:我们计划进一步扩展我们的推理任务,尽可能多的收集数据集

在 Adapter 上:我们将整合更多类型的 Adapter,并在大语言模型上测试

在 LLM 上:我们将整合更多的 LLM 进行测试

参考文献

[1] Neil Houlsby, Andrei Giurgiu, Stanislaw Jastrzebski, Bruna Morrone, Quentin De Laroussilhe, Andrea Gesmundo, Mona Attariyan, and Sylvain Gelly. 2019. Parameter-efficient transfer learning for nlp. In International Conference on Machine Learning, pages 2790–2799. PMLR. 2,3,4

[2] Edward J Hu, Yelong Shen, Phillip Wallis, Zeyuan Allen-Zhu, Yuanzhi Li, Shean Wang, Lu Wang, and Weizhu Chen. 2021. Lora: Low-rank adaptation of large language models. arXiv preprint arXiv:2106.09685. 2,3,4

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

·

·

信息收集从此告别手动模式,500个学生信息统计也不怕!

登记到眼花的成绩单统计不完的学生通讯录

各种教学质量评价、班委评价

……

01,学生信息统计篇

除了日常教学内容外,老师们的主要任务就是收收收……收什么呢?班级通讯录、学生社会实践情况汇总、教学计划安排等一系列的信息统计资料。

信息收集从此告别手动模式,500个学生信息统计也不怕!

统计班级通讯录信息时,从电子表格到打印出以「斤」论的纸质表格,再到分发给学生,加上不断的督促,最终还要逐个检查填写规范,各种信息收集下来,大家个个都熬成了熊猫眼。

02,毕业生信息统计篇

还有就是大四应届毕业生,面临着毕业设计、毕业论文开题等一系列流程,老师们要收集所有的题目完成审核、建议修改再反馈到每个同学,老师们和学生们纷纷操碎了心、熬坏了肝。

信息收集从此告别手动模式,500个学生信息统计也不怕!

其实信息收集本身并不复杂

难就难在面对海量数据却只能逐个录入

作为老师的我内心是绝望的

信息收集从此告别手动模式,500个学生信息统计也不怕!

减负——告别各种信息统计加班

推荐了一个好用的工具

——蜘蛛表格

蜘蛛表格在线收集表的出现,让信息收集和整理环节从线下移至线上,借助工具能力解放双手,让面对海量信息的老师们告别逐个手动处理的现状,实质上为老师们的工作减负。

使用后的感受就一个字:快!!!

如何利用蜘蛛表格在线收集表为工作减负呢?其实只需轻松四步,就可以体验到高效、轻松的信息收集能力。

03,减负指导手册来了

◆ 第一步【创建在线收集表】◆

如果你需要收集数据到表格,从蜘蛛表格模板创建一个表格,或者导入本地 Excel 表格到蜘蛛表格。

从蜘蛛表格的新建表单-导入工作表自动生成收集表,真是 real 实用!!!

对于手机号、证件信息、数字等特殊信息,也能进行相应的格式设置和有效性验证,规范的格式让数据信息的收集能够更准确有效,非常人性化。

◆ 第二步【发布在线收集表】◆

编辑好收集表后,点击「发布」,选择分享链接或生成二维码,一键发给特定好友或群组,就是这么轻松!

◆ 第三步【填写在线收集表】◆

你想坐着写?躺着写?还是跑着写?都没关系,无论是手机还是电脑,填写者都可以随时随地完成。

同时,蜘蛛表格还支持设置「填写权限」,既可全员开放又可针对指定成员填写,并对填写的内容绝对确保隐私安全,让你完全可以放心地用起来。

◆ 第四步【收集数据结果】◆

如何了解大家的填写进度?这么大量的收集表怎么快速汇总?

不用担心,在收集表的「收集结果」中可以实时查看收集详情,还可以点击「将结果汇总到表格」,瞬间生成关联的在线表格,实时编辑和整理。

没错,一键汇总就是这么简单!

学会以上四步,作为老师的你也能松松搞定各种信息收集统计,快让工作利器「蜘蛛表格 」给你的工作减负吧!

以上是关于从此告别繁琐的模型微调,LLM-Adapters助力NLP任务快速高效微调!的主要内容,如果未能解决你的问题,请参考以下文章