Docker容器网络配置

Posted 码出未来_远

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Docker容器网络配置相关的知识,希望对你有一定的参考价值。

Docker容器网络配置

文章目录

linux内核实现名称空间的创建

ip netns命令

可以借助ip netns命令来完成对 Network Namespace 的各种操作。ip netns命令来自于iproute安装包,一般系统会默认安装,如果没有的话,请自行安装。

注意:ip netns命令修改网络配置时需要 sudo 权限。

可以通过ip netns命令完成对Network Namespace 的相关操作,可以通过ip netns help查看命令帮助信息:

[root@localhost ~]# ip netns help

Usage: ip netns list

ip netns add NAME

ip netns attach NAME PID

ip netns set NAME NETNSID

ip [-all] netns delete [NAME]

ip netns identify [PID]

ip netns pids NAME

ip [-all] netns exec [NAME] cmd ...

ip netns monitor

ip netns list-id [target-nsid POSITIVE-INT] [nsid POSITIVE-INT]

NETNSID := auto | POSITIVE-INT

默认情况下,Linux系统中是没有任何 Network Namespace的,所以ip netns list命令不会返回任何信息。

创建Network Namespace

通过命令创建一个名为ns0的命名空间:

[root@localhost ~]# ip netns list

[root@localhost ~]# ip netns add ns0

[root@localhost ~]# ip netns list

ns0

新创建的 Network Namespace 会出现在/var/run/netns/目录下。如果相同名字的 namespace 已经存在,命令会报Cannot create namespace file “/var/run/netns/ns0”: File exists的错误。

[root@localhost ~]# ls /var/run/netns/

ns0

[root@localhost ~]# ip netns add ns0

Cannot create namespace file "/var/run/netns/ns0": File exists

对于每个 Network Namespace 来说,它会有自己独立的网卡、路由表、ARP 表、iptables 等和网络相关的资源。

操作Network Namespace

ip命令提供了ip netns exec子命令可以在对应的 Network Namespace 中执行命令。

查看新创建 Network Namespace 的网卡信息

[root@localhost ~]# ip netns exec ns0 ip addr

1: lo: <LOOPBACK> mtu 65536 qdisc noop state DOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

新创建的Network Namespace中默认创建一个lo回环网卡,此时网卡处于关闭状态,此时使用ping命令去尝试ping这个回环网卡

提示Network is unreachable

[root@localhost ~]# ip netns exec ns0 ping 127.0.0.1

connect: 网络不可达(Network is unreachable)

这时可以使用下面的命令来实现ping通

[root@localhost ~]# ip netns exec ns0 ip link set lo up

[root@localhost ~]# ip netns exec ns0 ping 127.0.0.1

PING 127.0.0.1 (127.0.0.1) 56(84) bytes of data.

64 bytes from 127.0.0.1: icmp_seq=1 ttl=64 time=0.024 ms

64 bytes from 127.0.0.1: icmp_seq=2 ttl=64 time=0.043 ms

64 bytes from 127.0.0.1: icmp_seq=3 ttl=64 time=0.038 ms

^C

--- 127.0.0.1 ping statistics ---

3 packets transmitted, 3 received, 0% packet loss, time 2041ms

rtt min/avg/max/mdev = 0.025/0.040/0.067/0.015 ms

转移设备

我们可以在不同的 Network Namespace 之间转移设备(如veth)。由于一个设备只能属于一个 Network Namespace ,所以转移后在这个 Network Namespace 内就看不到这个设备了。

其中,veth设备属于可转移设备,而很多其它设备(如lo、vxlan、ppp、bridge等)是不可以转移的

veth pair

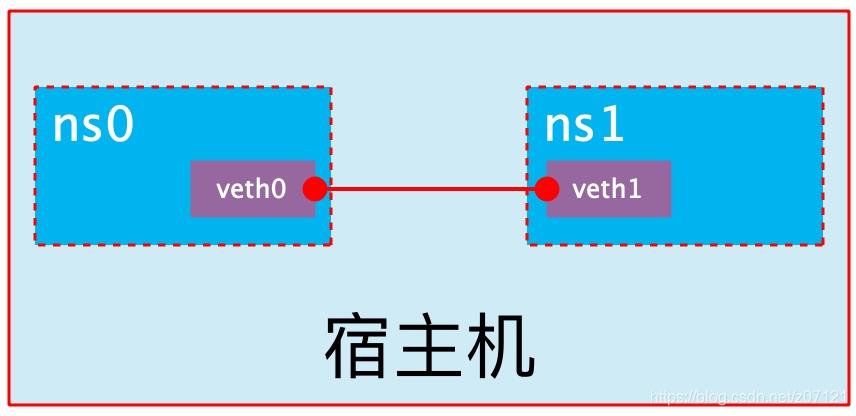

veth pair 全称是 Virtual Ethernet Pair,是一个成对的端口,所有从这对端口一 端进入的数据包都将从另一端出来,反之也是一样。

引入veth pair是为了在不同的 Network Namespace 直接进行通信,利用它可以直接将两个 Network Namespace 连接起来。

创建veth pair

[root@localhost ~]# ip link add type veth

[root@localhost ~]# ip a

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: ens33: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc fq_codel state UP group default qlen 1000

link/ether 00:0c:29:e1:7e:2b brd ff:ff:ff:ff:ff:ff

inet 192.168.207.137/24 brd 192.168.207.255 scope global dynamic noprefixroute ens33

valid_lft 1302sec preferred_lft 1302sec

inet6 fe80::d179:e52e:1aae:e40e/64 scope link noprefixroute

valid_lft forever preferred_lft forever

3: docker0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue state UP group default

link/ether 02:42:0e:35:2c:0e brd ff:ff:ff:ff:ff:ff

inet 172.17.0.1/16 brd 172.17.255.255 scope global docker0

valid_lft forever preferred_lft forever

inet6 fe80::42:eff:fe35:2c0e/64 scope link

valid_lft forever preferred_lft forever

53: vethb2b74d3@if52: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue master docker0 state UP group default

link/ether aa:0d:2e:45:41:a8 brd ff:ff:ff:ff:ff:ff link-netnsid 1

inet6 fe80::a80d:2eff:fe45:41a8/64 scope link

valid_lft forever preferred_lft forever

54: veth0@veth1: <BROADCAST,MULTICAST,M-DOWN> mtu 1500 qdisc noop state DOWN group default qlen 1000

link/ether f6:59:2d:4d:3c:dc brd ff:ff:ff:ff:ff:ff

55: veth1@veth0: <BROADCAST,MULTICAST,M-DOWN> mtu 1500 qdisc noop state DOWN group default qlen 1000

link/ether 46:50:13:92:82:b8 brd ff:ff:ff:ff:ff:ff

可以看到,此时系统中新增了一对veth pair,将veth0和veth1两个虚拟网卡连接了起来,此时这对 veth pair 处于”未启用“状态。

实现Network Namespace

利用veth pair实现两个不同的 Network Namespace 之间的通信。刚才我们已经创建了一个名为ns0的 Network Namespace,下面再创建一个信息Network Namespace,命名为ns1

[root@localhost ~]# ip netns list

[root@localhost ~]# ip netns list

ns1

ns0

将veth0加入到ns0,将veth1 加入到ns1

[root@localhost ~]# ip link set veth0 netns ns0

[root@localhost ~]# ip link set veth1 netns ns1

为veth pair配置ip地址,并且启用

[root@localhost ~]# ip netns exec ns0 ip link set veth0 up

[root@localhost ~]# ip netns exec ns0 ip addr add 1.1.1.1/24 dev veth0

[root@localhost ~]# ip netns exec ns1 ip link set lo up

[root@localhost ~]# ip netns exec ns1 ip link set veth1 up

[root@localhost ~]# ip netns exec ns1 ip addr add 1.1.1.2/24 dev veth1

查看这对veth pair的状态

[root@localhost ~]# ip netns exec ns0 ip a

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

54: veth0@if55: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue state UP group default qlen 1000

link/ether f6:59:2d:4d:3c:dc brd ff:ff:ff:ff:ff:ff link-netns ns1

inet 1.1.1.1/24 scope global veth0

valid_lft forever preferred_lft forever

inet6 fe80::f459:2dff:fe4d:3cdc/64 scope link

valid_lft forever preferred_lft forever

[root@localhost ~]# ip netns exec ns1 ip a

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

55: veth1@if54: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue state UP group default qlen 1000

link/ether 46:50:13:92:82:b8 brd ff:ff:ff:ff:ff:ff link-netns ns0

inet 1.1.1.2/24 scope global veth1

valid_lft forever preferred_lft forever

inet6 fe80::4450:13ff:fe92:82b8/64 scope link

valid_lft forever preferred_lft forever

从上面可以看出,已经成功的启用了这个veth pair 并且为每个veth设备分配了对应的ip地址,我们尝试在ns1中访问ns0的ip地址

[root@localhost ~]# ip netns exec ns1 ping 1.1.1.2

PING 1.1.1.2 (1.1.1.2) 56(84) bytes of data.

64 bytes from 1.1.1.2: icmp_seq=1 ttl=64 time=0.021 ms

64 bytes from 1.1.1.2: icmp_seq=2 ttl=64 time=0.025 ms

64 bytes from 1.1.1.2: icmp_seq=3 ttl=64 time=0.027 ms

可以看到,veth pair成功实现了两个不同Network Namespace之间的网络交互

veth pair设备重命名

[root@localhost ~]# ip netns exec ns0 ip link set veth0 down

[root@localhost ~]# ip netns exec ns0 ip link set dev veth0 name eth0

[root@localhost ~]# ip netns exec ns0 ifconfig -a

eth0: flags=4098<BROADCAST,MULTICAST> mtu 1500

inet 1.1.1.1 netmask 255.255.255.0 broadcast 0.0.0.0

ether 82:11:76:80:be:73 txqueuelen 1000 (Ethernet)

RX packets 11 bytes 866 (866.0 B)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 11 bytes 866 (866.0 B)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

[root@localhost ~]# ip netns exec ns0 ip link set eth0 up

[root@localhost ~]# ip netns exec ns0 ifconfig -a

eth0: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500

inet 1.1.1.1 netmask 255.255.255.0 broadcast 0.0.0.0

inet6 fe80::8011:76ff:fe80:be73 prefixlen 64 scopeid 0x20<link>

ether 82:11:76:80:be:73 txqueuelen 1000 (Ethernet)

RX packets 13 bytes 1046 (1.0 KiB)

RX errors 0 dropped 0 overruns 0 frame 0

TX packets 17 bytes 1382 (1.3 KiB)

TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0

以上是关于Docker容器网络配置的主要内容,如果未能解决你的问题,请参考以下文章