Multimodal biomedical AI

Posted gggsf

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Multimodal biomedical AI相关的知识,希望对你有一定的参考价值。

Multimodal biomedical AI

虽然人工智能改变了语言翻译、语音识别和自然图像识别等领域,但是医学方面相较于其他领域落后。很大一部分原因是因为复杂性和高维性,数据中包含大量独特的特征和信号,开发和验证适用于不同人群的解决方案面临技术挑战。随着基因测序等成本降低,数据采集、聚合和分析的能力也有所提高。医学方面的诊断、预后评估和决定方案处理来自多种来源和方式的数据,多模态人工智能模型开发融合了跨膜态数据,包括生物传感器、遗传、蛋白质组学等。该文概述了已经启用的关键应用,以及技术和分析方面的挑战。

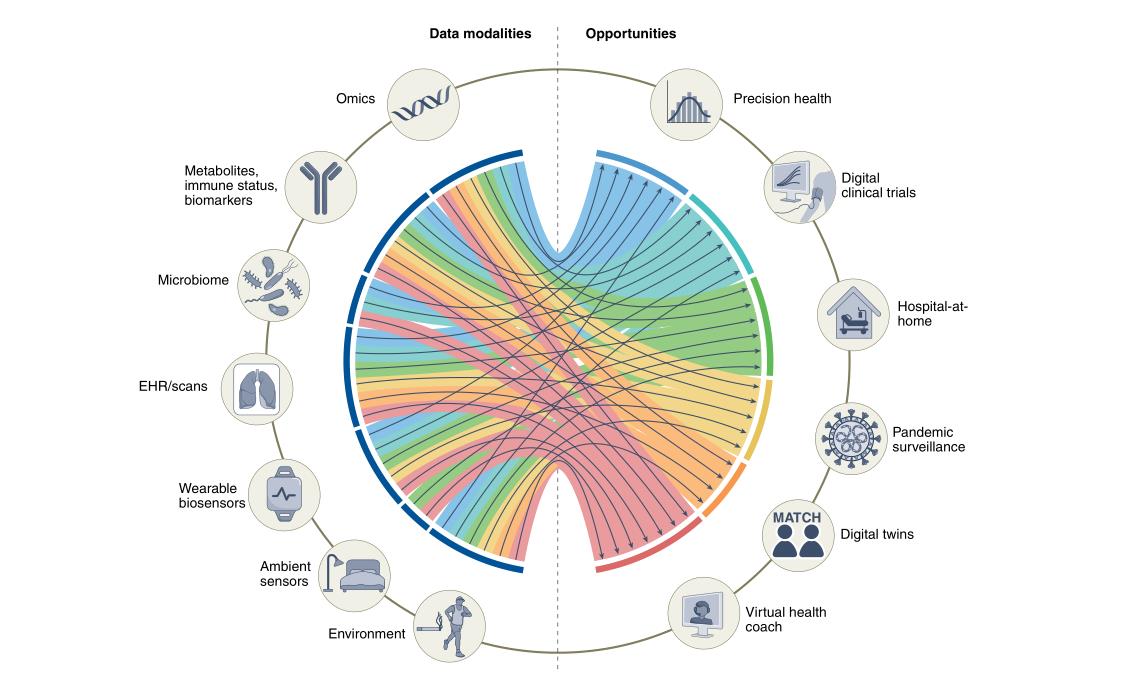

利用多模态数据的机会

二十年测序取得显著进展,利用新的技术发展可以获得精细生物数据。医学技术在医学各方面都取得了重大进展,提高了我们对生物学途径的理解。但是虽然数据很多,但是整合这些不同类型的数据仍然具有挑战性。已经有很多用于精确健康环境中的多组学数据集成,图神经网络就是一个。由节点和边组成众所周知的数据结构,知道相关数据结构可以提高模型性能,另一种方法是降维。经过不断的探索和发展,最终开发包含多层组学数据的多模态人工智能的能力将使我们达到对个体进行深度表型分析的预期目标。

数字化临床实验

随机临床试验用于调查因果关系,并提供证据支持在临床医学中使用新型诊断,预后和治疗干预。但是耗时费力,因为各方面的差异导致结果不是特别好。有效的将不同传感器的数据和临床数据结合仍然是一个挑战,在未来,这些数据的增加可用性和新的多模态学习技术将提高在数字临床试验中的能力。图神经网络最近被提出克服多个健康传感器数据缺失或者不规则采样的问题。利用不同模式数据的人工智能模型可能有助于识别或生成最优的合成对照。

远程监控:家庭医院

生物传感器、持续监测和分析等方面取得的进展,提高了在个人家中模拟医院环境的可能性,不仅有利于医院也有利于个人。可穿戴传感器发挥着巨大作用,将传感器与ehr结合,查询患者潜在疾病风险的相关信息。多模式和传感器数据的集成为改善远程患者检测提供了一个有希望的机会,由研究已经证明了多模式数据在这些场景中的潜力,利用穿戴设备和环境传感器的多模态数据可能有助于准确检测和分类这些活动中的困难。多模式远程患者检测也可以用于急性疾病的设置。为了安全性要对基于多模态人工智能的远程监控与住院进行随机试验,需要能够预测即将发生的恶化,并有系统干预,但这一点还没有实现。

大流行监测和疫情检测

比如COVID-19显示了检测的要性,一些国家整合移民地图、移动电话使用情况和卫生服务数据的多模式数据,预测疫情的蔓延并确定潜在病例。有研究证明了利用可穿戴设备跟踪静息心率和睡眠分钟来改善美国流感疾病的监测,也有旨在分析来自可穿戴设备的各种数据,以便快速检测流感、冠状病毒和其他快速传播的病毒性疾病的出现。多模态人工智能模型在大流行防备和应对中的其他几个用例已得到测试,取得了不错的结果。

数字双胞胎

目前依靠临床试验作为确定成功干预措施证据,100人,10人成功,90人未证实。数字双胞胎的补充方法利用大量数据来建模和高度预测某种治疗干预措施如何对特定患者诊断,填补知识空白,数字双胞胎是一种很有前途的靶点药物发现工具。在精准肿瘤学和心血管健康领域,有提出利用人工智能工具整合来自多个数据源的开发双胞胎数字,AI已经开发并测试了数字双胞胎模型,利用不同的临床数据集增强阿尔兹海默和多发性硬化症的临床试验。因为人类有机体复杂,医学中准确而有用的数字双胞胎技术的发展取决于收集大量和多样化的多模态数据的能力,开发出能够有效地从所有这些数据模式中学习并进行实时预测的人工智能模型。

虚拟健康助手

虚拟健康助理迄今尚未得到广泛开发,目前最流行的虚拟健康助手应用之一是糖尿病护理,并取得了不错的效果,这些公司的许多已经扩展到其他用例:高血压控制和减肥,虚拟健康教练也有偏头痛、哮喘等常见疾病,但是都是只用在小型观察中研究中。人工智能模型中多个数据源的成功集成将促进广泛关注的个性化虚拟健康助理的开发,虚拟助手可以利用基于基因测序、其他组学层、血液生物标志物和代谢物的持续监测等个性化档案,促进行为改变、回答与健康相关的问题。要充分发挥人工智能和多模态集成到虚拟健康助手的潜力,要面临很多挑战,技术挑战、数据相关挑战、隐私挑战。

多模态数据采集

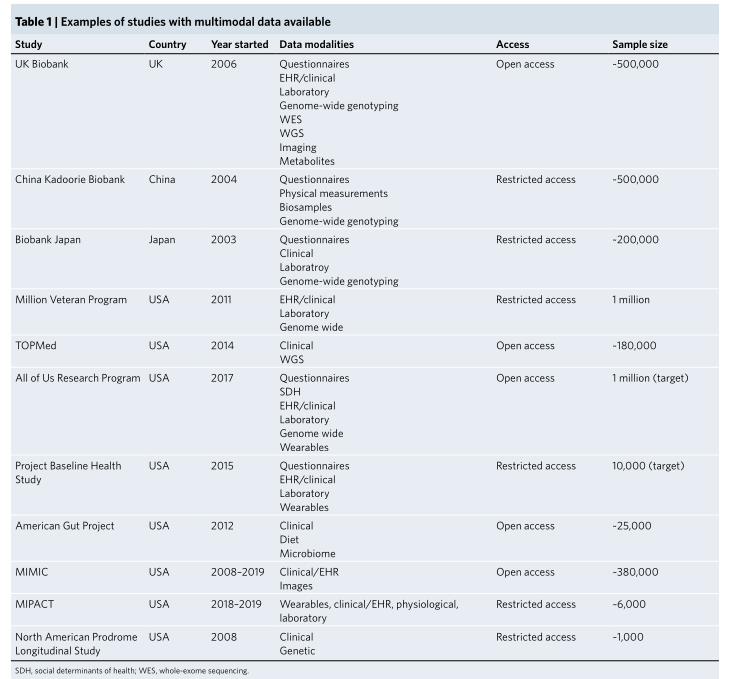

成功开发多模式数据应用程序的第一个要求收集、管理和协调表现型良好的大型注释数据集。很多国家和机构在建立深入的多模式数据资源,建立的数据资源和数据粒度对数据科学和机器学习非常有用。

这些数据集中的多模态数据可用性有助于一系列不同任务中实现更好的诊断性能,各种疾病数据的收集为多模式机器学习工作流的开发提供了力量。

技术挑战

实施和建模方面的挑战,健康数据本质上也是多模式的,而且包含很多领域,数据从宏观抽象到微观。

多模式机器学习是机器学习的一个子领域,旨在开发和训练能够利用多种不同类型数据的模式,学习将这些多种模式关联起来提高预测性能。2021年openAI发布了一种称为对比语言图像预训练(CLIP)架构,该架构在数百万图像-文本对上进行训练,没有微调的情况下,与竞争性的、完全受监督的模型性能相匹配。使用ConVIRT,图像编码器和文本编辑器被训练为通过最大化正确配对的图像和文本示例的相似度生成图像和文本表示,称为对比学习,优于自我监督和完全监督。

多模态学习框架的另一个理想特征是能够从不同的模态中学习,而不需要不同的模型架构,理想情况下,多模式模型将包含不同类型的数据,以灵活和稀疏的方式编码包含在这些不同类型的数据中的概念,为跨膜态的类似概念生成对齐的表示,并根据任务的要求提供任何任意类型的输出。

过去的几年,已经从具有强烈模态特定偏差的架构(CNN\\RNN)过渡到一种相对新颖的架构Transformer,在各种输入和输出模态和任务中都表现出良好的性能。该模型策略是允许神经网络在处理和最终做出决策时,动态的关注输入不同的部分。虽然自然语言处理中的每个输入标记(即,用于处理的最小单元)对应于特定单词,但其他模态通常使用图像或视频片段片段作为标记,Transformer架构允许我们统一跨模态学习的框架,但可能仍然需要特定于模态的标记化和编码。Meta AI(Meta Platforms)最近的一项研究提出了一个独立于感兴趣的模态的自我监督学习的统一框架,但仍需要模态特定的预处理和训练。自我监督多模式学习的基准使我们能够衡量跨模式方法的进展:例如,自我监督学习的领域不可知基准(DABS)是最近提出的一个基准,包括胸部X光、传感器数据以及自然图像和文本数据。

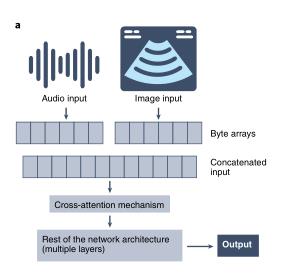

DeepMind(Alphabet)提出的最新进展,包括Perceiver117和PerceiverIO118,提出了一个跨具有相同骨干架构的模式学习的框架。重要的是,感知器架构的输入是模态不可知的字节阵列,它们通过注意力瓶颈来压缩,以避免依赖于大小的大内存成本,在处理这些输入之后,感知器可以将表示馈送到最终分类层,以获得每个输出类别的概率,而感知器IO可以通过指定感兴趣任务的查询向量将这些表示直接解码为任意输出。如图所示:

transformer的一个很有前途的方面是能够用未标记的数据学习有意义的表示,鉴于获得高质量标签所需的资源有限且昂贵,这在生物医学人工智能中至关重要。

DeepMind的一项研究表明,管理更高质量的图像-文本数据集可能比生成大型单模态数据集以及算法开发和训练的其他方面更重要。然而,在生物医学人工智能的环境中,这些数据可能并不容易获得。解决这个问题的一个可能的方法是利用一种模式的可用数据来帮助与另一种模式进行学习,这是一种被称为“共同学习”的多模式学习任务。尽管这种方法很有前景,但尚未在生物医学环境中进行广泛测试,需要进一步探索。

另一个重要的建模挑战及多模式健康数据中包含的维度数很高,(维度爆炸)。随着维度(即数据集中包含的变量或特征)的数量增加,携带这些特征的某些特定组合的人数减少(或者对于某些组合,甚至消失),导致“数据集盲点”,即,特征空间中没有任何观测的部分(特征或变量的所有可能组合的集合)。数据集盲点可能会损害模型性能,需要早期考虑,可以用几种策略缓解这个问题,使用最大性能任务收集数据、确保大而多的样本量、利用领域知识指导特征工程和选择、适当的模型训练和全面的模型监测。沿着这些思路,最近的研究表明,通过从大型数据库中检索信息来增强的模型优于在大型数据集上训练的大型模型,有效地利用了可用信息,还提供了额外的好处,如可解释性。

在多模态学习中,一种越来越常用的方法是将来自不同模态的数据组合起来,而不是简单地将几个模态单独输入到一个模型中,以提高预测性能过程,称为“多模态融合”。

不同数据模态的融合可以在过程的不同阶段进行。最简单的方法包括在任何处理(早期融合)之前连接输入模态或特征。方法简单,但是不适用于复杂的数据模式。

一种更复杂的方法是在训练过程中组合和共同学习这些不同模态的表示(联合融合),允许模态特定的预处理,同时仍然捕捉数据模态之间的交互。最后,一种替代方法是为每个模态训练单独的模型,并组合输出概率(后期融合),这是一种简单而稳健的方法,但代价是错过了可以从模态之间的交互中提取的任何信息。

DeepMind(使用通用代理Gato)最近进行的一项研究证明了这种方法的成功,该研究表明,将文本、图像和按钮等创建的各种代币连接起来,可以用来教模型执行几个不同的任务,从为图像加字幕、玩雅达利游戏到用机械臂堆叠积木,最近一项名为Align Before Fuse的研究表明,在融合模态之前,在模态之间对齐表示可能会在下游任务中获得更好的性能。

谷歌研究公司最近的一项研究建议使用注意力瓶颈进行多模态融合,从而限制跨模态信息流向部队模型。同时使用两种模式的另一个范例是从一种模式“翻译”到另一种模式,

多模式学习以加速的速度得到了改善,但我们预计目前的方法不太可能足以克服上述所有主要挑战。因此,需要进一步创新,以充分启用有效的多模式人工智能模型。

数据挑战

支撑数据健康的多维数据在收集、链接、注释等方面带来了广泛的挑战,尽管科学技术在促进数据收集和表型方面取得了显著进步,但生物医学数据集的这些特征之间不可避免地存在权衡。大样本量(在数十万至数百万的范围内)对于人工智能模型(尤其是多模态人工智能模型)的训练是可取的,但在大量参与者的情况下,快速实现深度表型和良好的纵向随访量表的成本,除非采取自动化的数据收集方法,否则在财务上是不可持续的。

人群、血统、收入水平、教育水平、医疗保健机会等取样在实践中很困难,再者,多模式人工智能所需的一个步骤是将数据集中的可用的所有数据类型进行适当的链接,是另一个挑战。还有,缺失数据的比例很高,有人提出了不同的策略来减少假设。其中包括结转插补,标记插,补值并添加上次测量时的信息,以及更复杂的策略,如使用可学习的衰减项来捕捉缺失数据和时间间隔的存在。

数据产生的时候几种偏见风险很重要,需要很多方法监测和减轻这些偏见。

隐私挑战

多模态人工智能在健康领域的成功及发展需要数据的深度和广度,比单模态人工智能更具隐私挑战。

鉴于隐私挑战,探索出多种技术解决方案,确保安全和隐私。

差分隐私:对数据的系统进行随机择优扰动,最终目标保持数据集的全局分布的同时掩盖个人级别的信息。

联合学习:允许几个个人或卫生系统在不传输原始数据的情况下集体训练模型。

同态加密:允许对加密的输入数据进行数学运算的加密技术,因此提供了在不泄露信息的情况下共享模型权重的可能性

群体学习:基于几个个人或组织在本地数据上训练模型,但不需要可信的中央服务器,因为它用区块链智能合约的使用取代了它。

以上方法可以一起使用。

边缘计算,获得额外的安全层,计算数据更接近数据源,与联邦学习等其他方法结合,避免将敏感数据传输到集中式服务器来提供更多的安全性,减低存储成本,延迟和带宽使用。

图像分割U-Net: Convolutional Networks for Biomedical Image Segmentation

| 原始题目 | U-Net: Convolutional Networks for Biomedical Image Segmentation |

|---|---|

| 中文名称 | U-Net:用于生物医学图像分割的卷积网络 |

| 发表时间 | 2015年5月18日 |

| 平台 | Miccai 2015 |

| 来源 | University of Freiburg, Germany |

| 文章链接 | https://arxiv.org/pdf/1505.04597.pdf |

| 开源代码 | 官方实现: https://lmb.informatik.uni-freiburg.de/people/ronneber/u-net/ (Caffe) |

摘要

人们普遍认为,深度网络的成功训练需要数千个标注的训练样本。

本文提出一种网络和训练策略,依赖于数据增强的强大使用,以更有效地使用可用的标注样本。

该架构由 捕获上下文的收缩路径和能够精确定位的对称扩展路径(a contracting path to capture

context and a symmetric expanding path that enables precise localization) 组成。

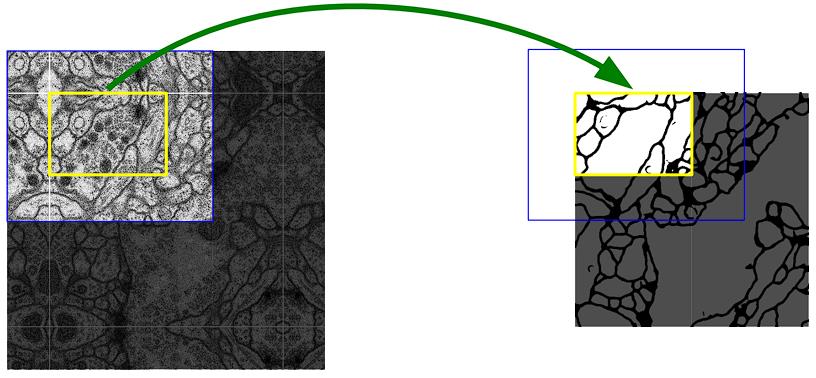

这样的网络可以从 很少的图像 中进行端到端训练,并在 ISBI challenge 中对电子显微镜堆栈中的神经元结构进行分割的性能优于之前的最佳方法(滑动窗口卷积网络 a sliding-window convolutional network)。

使用在透射光学显微镜图像(phase contrast and DIC)上训练的相同网络,我们在这些类别中以较大优势赢得了 2015 年 ISBI 细胞跟踪挑战赛。

此外,网络速度很快。在最近的 GPU 上,512x512 图像的分割耗时不到一秒。

总结:

- 数据增强

- contracting path 捕获上下文, symmetric expanding path 能够精确定位

- 需要的图像更少,可以端到端训练

- 性能好,速度快(最近的 GPU 上,512x512 图像的分割耗时不到一秒。)

5. 结论

u-net 架构在不同的生物医学分割应用上取得了非常好的性能。

由于使用 弹性变形(elastic deformations) 进行数据增强,它只需要很少的标注图像,并且在 NVidia Titan GPU (6 GB) 上的训练时间仅为10 小时。

给出了基于 Caffe[6]的完整实现和经过训练的网络。

我们确信 u-net 架构可以轻松地应用于更多的任务。

总结:

- 数据增强:elastic deformations,需要很少的标注图像

- 训练时间短

- 最重要的还是可以用于别的任务。

2. 网络架构

网络架构如 图1 所示。

图1所示。U-net架构(例如最低分辨率为 32x32 像素)。每个蓝色框对应于一个多通道特征图。通道数在方框的顶部表示。x-y 尺寸在 box 的左下边缘。白色框表示复制的特征映射。箭头表示不同的操作。

它由 一个收缩路径(contracting path)(左侧)和 一个扩展路径(expansive path)(右侧)组成。

收缩路径 遵循卷积网络的典型架构。

- 它由两个 3x3 卷积(无填充卷积)的重复应用组成,每个卷积后面都有一个 ReLU 和一个 stride 2 的 2x2 max pooling 操作用于下采样。

- 在每个下采样步骤,我们将 特征通道的数量 增加一倍。

扩展路径中的每一步都包括对特征图的上采样,然后是将特征通道数量减半的 2x2 卷积(“up-convolution”),与 收缩路径中相应裁剪的特征图的 concatenation,以及两个 3x3 卷积,每个卷积后面都是一个 ReLU。

裁剪是必要的,因为在每个卷积中会丢失边界像素。

在最后一层,使用 1x1 卷积将每个 64 个分量的特征向量映射到所需的类别数量。该网络总共有 23 个卷积层。

为了允许输出分割图的 无缝拼块(seamless tiling)(参见 图2 ),选择输入 分块(tile) 大小很重要,以便将所有 2x2 max pooling 操作应用于具有偶数 x 和 y 大小的层。

总结:

- 架构图一目了然

- 使用的是 无填充卷积

- 注意其中有个裁剪特征的操作

3. 训练

利用 输入图像及其对应的分割图,采用 随机梯度下降 实现Caffe[6]来训练网络。由于无填充卷积,输出图像比输入图像小一个恒定的边界宽度。

为了最小化开销并最大限度地利用 GPU 内存,我们倾向于使用较大的输入图像块,而不是较大的 batch size ,从而将 batch 减少为单个图像。因此,我们使用高 momentum(0.99),以便之前看到的大量训练样本确定当前优化步骤中的更新。

能量函数 通过在 最终特征图上 pixel-wise soft-max 并结合 cross entropy loss function 来计算。

soft-max 被定义为 \\(p_k(\\mathbfx)=\\operatornameexp(a_k(\\mathbfx))/\\left(\\sum_k^\\prime=1^K\\operatornameexp(a_k^\\prime(\\mathbfx))\\right)\\),其中 \\(a_k\\) 表示在 像素位置 \\(\\textbfx\\in\\Omega\\ \\ \\textwith\\ \\ \\Omega\\subset\\mathbbZ^2\\) 的 特征通道 k 中的激活函数。

K 是类别的数量,\\(p_k(x)\\) 是 approximated maximum-function。

即: 对于具有最大激活 \\(a_k\\) 的 k, \\(p_k(x) ≈1\\); 对于所有其他k, \\(p_k(x) ≈ 0\\)。

然后,cross entropy 在每个位置惩罚 \\(p_\\ell(\\textbfx)(\\textbfx)\\) 与 1 的 误差(deviation)。

这里 \\(\\ell:\\Omega\\to\\1,\\ldots,\\textK\\\\) 是每个像素的标签, \\(w:\\Omega\\rightarrow\\mathbbR\\) 是一个权重图,我们引入它是为了在训练中赋予一些像素更多的重要性。

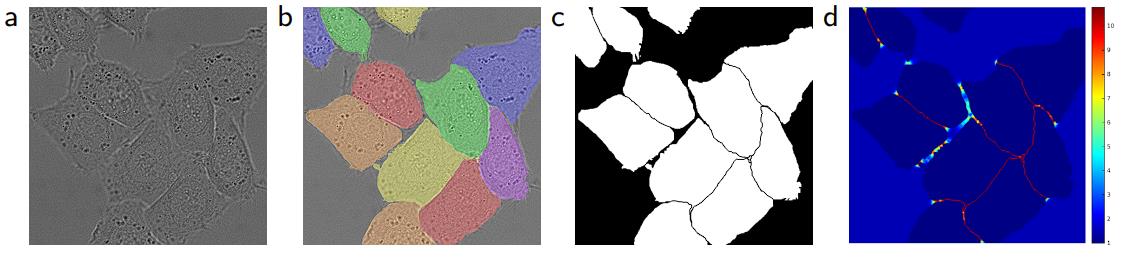

我们预先计算每个 ground truth 分割的权重图,以弥补训练数据集中特定类别像素的不同频率,并迫使网络学习我们在接触细胞之间引入的 小分离边界(参见 图3c和d )。

图3所示。用 DIC (differential interference contrast) microscopy 记录玻璃上的 HeLa 细胞。(a) 原始图像。(b) 覆盖 ground truth 分割。不同的颜色表示 HeLa 细胞的不同实例。(c) 生成的分割 mask(白色:前景,黑色:背景)。(d)使用 pixel-wise loss 权重进行映射,以迫使网络学习边界像素。

分离边界使用形态学操作计算。weight map 的计算如下:

其中 \\(w_c: Ω→R\\) 是平衡类频率的 weight map,\\(d_1: Ω→R\\) 表示到最近单元格边界的距离,\\(d_2: Ω→R\\) 到第二最近单元格边界的距离。在我们的实验中,我们设置 \\(w_0 = 10, σ≈5\\) 像素。

在具有许多卷积层和不同路径的深度网络中,良好的 权值初始化 是非常重要的。

否则,网络的某些部分可能会过度激活,而其他部分则永远不会做出贡献。

理想情况下,初始权重应该调整,使网络中的每个特征图都具有近似的单位方差。

对于具有我们的架构(alternating convolution and ReLU layers)的网络,这可以通过从标准差为\\(\\text\\sqrt2/N\\) 的高斯分布中提取初始权重来实现,其中 N 表示一个神经元[5]的传入节点数。

例如,对于一个 3x3 卷积和 前一层中的 64 个特征通道,N = 9·64 = 576。

3.1 数据增强

在只有少量训练样本的情况下,数据增强对于让网络获得所需的 invariance 和 robustness 至关重要。

在显微图像中,我们主要需要 平移和旋转不变性,以及对变形和灰度变化的鲁棒性。特别是训练样本的随机弹性变形似乎是用很少的标注图像训练分割网络的关键概念。我们在一个粗糙的 3 × 3网格 上使用随机位移向量生成平滑变形。位移从具有 10像素 标准差的高斯分布中采样。然后使用 双三次插值 计算每个像素的位移。收缩路径(contracting path) 末尾的 Drop-out layers 执行进一步的隐式数据增强。

4. 实验

- 数据集1:EM segmentation challenge [14] that was started at ISBI 2012 。训练集: a set of 30 images (512x512 pixels) 。Each image comes with a corresponding fully annotated ground truth segmentation map for cells (white) and membranes (black). 测试集标签未公开,需要发给比赛组织者。

- 数据集2:ISBI cell tracking challenge 2014 and 2015 的 光显微图像中的细胞分割任务。“PhC-U373” 和 DIC-HeLa 两个数据集。

参考:

以上是关于Multimodal biomedical AI的主要内容,如果未能解决你的问题,请参考以下文章

U-Net: Convolutional Networks for Biomedical Image Segmentation

Multimodal Machine Learning day29

论文笔记:nnU-Net: a self-configuring method for deep learning-based biomedical image segmentation

华为云技术分享多模态融合算法——Multimodal Compact Bilinear Pooling