TJ4DRadSet:自动驾驶4D成像雷达数据集

Posted Being_young

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了TJ4DRadSet:自动驾驶4D成像雷达数据集相关的知识,希望对你有一定的参考价值。

文章:TJ4DRadSet: A 4D Radar Dataset for Autonomous Driving

作者:Lianqing Zheng , Zhixiong Ma, Xichan Zhu , Bin Tan , Sen Li , Kai Long , Weiqi Sun

编辑:点云PCL

来源:arXiv 2022

欢迎各位加入免费知识星球,获取PDF论文,欢迎转发朋友圈。文章仅做学术分享,如有侵权联系删文。未经博主同意请勿擅自转载。

公众号致力于分享点云处理,SLAM,三维视觉,高精地图相关的文章与技术,欢迎各位加入我们,一起交流一起进步,有兴趣的可联系微信:920177957。本文来自点云PCL博主的分享,未经作者允许请勿转载,欢迎各位同学积极分享和交流。

摘要

下一代高分辨率汽车雷达(4D成像雷达)可以提供额外的高程测量值和更密集的点云,在自动驾驶中具有巨大的三维传感潜力,本文介绍了一个名为TJ4DRadSet的数据集,其中包含4D成像雷达数据用于自主驾驶研究。数据集是在各种驾驶场景中收集的,总共有7757个同步帧,分为44个连续序列,这些序列用3D边界框和轨迹ID进行了很好的标注,并为数据集提供了一个基于4D雷达的3D目标检测基线,以证明深度学习方法对4D雷达点云的有效性。可以通过以下链接访问数据集:https://github.com/TJRadarLab/TJ4DRadSet.

主要贡献

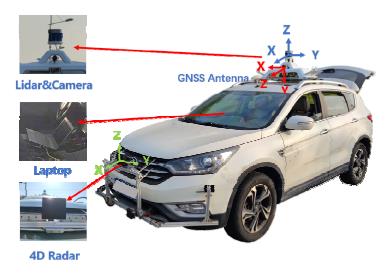

三维目标检测和跟踪对环境感知是至关重要,随着深度学习和人工智能的发展,大量的神经网络被应用于3D感知,训练3D物体检测网络需要大规模数据量,这些数据应涵盖许多不同场景和复杂的条件,此外,数据的基本真实性需要精确以便监督学习,以确保训练的网络有效性。与相机和激光雷达相比,很少有自动驾驶数据集包含4D雷达,这限制了深度学习在4D雷达点云中的研究和应用,为了填补这一空白,我们提出了一个名为TJ4DRadSet的自动驾驶4D成像雷达数据集。数据采集平台包含多个传感器,包括4D雷达、相机、激光雷达和全球卫星导航系统(GNSS),如图1所示。

图1.数据采集平台和坐标系

我们希望该数据集将促进基于4D成像雷达的感知算法的研究。我们的贡献如下:

提出了一个名为TJ4DRadSet的数据集,这是一个自动驾驶数据集,包含连续序列的4D雷达点云和3D标注内容,还提供了激光雷达、相机和全球卫星导航系统的多模态完整信息。

TJ4DRadSet包含40K帧的同步数据,其中7757帧,44个序列具有高质量的带标注的3D边界框和轨迹ID,3D标注系统使用联合多传感器标注和多轮手动检查TJ4DRadSet数据集

数据集涵盖各种道路条件,如高架道路、复杂交叉口、单向道路和城市道路。它还包括恶劣的照明条件,如强光和黑暗。该数据集适合开发基于4D雷达的3D感知算法,以促进其在高级自主驾驶中的应用。

为基于TJ4DRadSet数据集实现了4D雷达的三维目标检测提供了基线,结果表明,4D成像雷达在高水平自主驾驶方面具有广阔的应用前景。

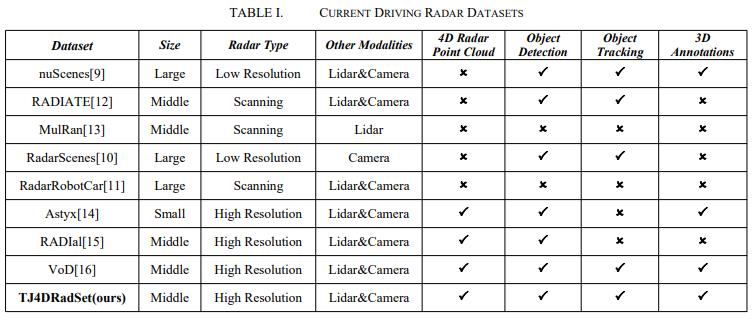

表一显示了包含雷达数据的每个数据集的比较,一些数据集包含低分辨率FMCW雷达,如nuScenes和RadarScenes,其雷达点云缺乏精确3D感知所需的高程信息,一些数据集使用雷达收集数据,如RadarRobotCar[、RADIATE和MulRan,其雷达数据主要解释为图像数据,缺乏多普勒速度。对于新一代4D成像雷达,4D点云将是主要的输出格式,包含空间信息和速度信息。目前,Astyx、RADIal和VoD数据集具有高分辨率4D雷达传感器。Astyx只有545帧点云数据,这些数据很小,缺乏跟踪信息。RADIal包含完整的雷达格式,如距离多普勒图和点云,其中只有2D标签框和“汽车”标签。VoD数据集是一种新型的汽车数据集,它与我们的工作是同一时期的,与VoD数据集相比,我们的数据集包含了更丰富、更具挑战性的驾驶场景。

主要内容

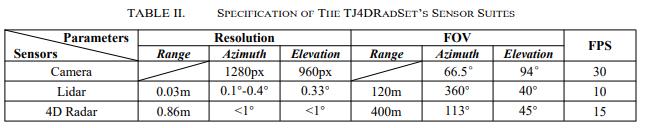

A、 传感器

TJ4DRadSet主要包括4D成像雷达、激光雷达和相机数据,如图1所示,相机和激光雷达安装在车顶支架上,4D成像雷达安装在前保险的中间,激光雷达可以360度扫描环境信息,而相机和4D雷达则可以捕获前方视野(FOV)中的信息,覆盖前方驾驶视野,各传感器的主要参数如表二所示,此外,GNSS信息被实时运动学(RTK)包含并校正,以实现高精度定位,其中包含自我车辆的速度和位置信息。

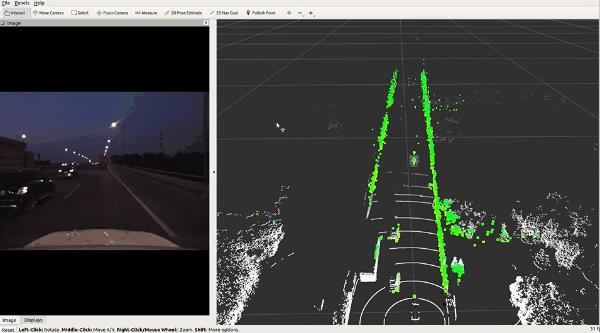

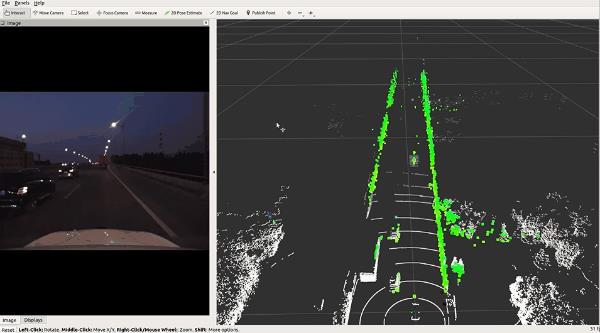

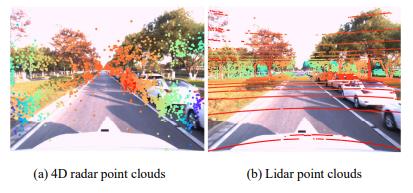

B、 传感器标定

多传感器标定是感知算法的基础,该过程主要包括内参校准、外参校准和时间校准。摄像机的固有参数和畸变系数通过MATLAB工具箱和棋盘进行校准,畸变系数用于校正以获得去畸变图像。4D雷达和激光雷达的固有参数已在工厂进行离线校准,它可以分为两个外参的标定过程:相机标定和激光雷达标定;4D雷达和激光雷达外参校准。相机和4D雷达的外部参数可以通过对其余两个外部参数进行矩阵运算来获得。不同传感器之间的外参表示为平移和旋转矩阵。对于相机和激光雷达外参校准,我们使用棋盘格对点云和图像数据进行2D-3D对齐,以完成粗略校准。然后,我们通过环境中的树和极点等静态对象手动微调外部参数。对于4D雷达和激光雷达的非本征标定,我们将其视为空间3D-3D点云对准。首先,将两个传感器之间的距离作为粗糙平移参数进行测量。然后在空间使用多个角反射器对外参进行微调。所有传感器在ROS驱动器下工作,由于每个传感器以不同的帧速率运行,因此我们使用数据的到达时间作为时间戳来对齐数据,最终的4D雷达和激光雷达点云投影到图像中,如图2所示。

图2.4D成像雷达和激光雷达点云投影

C、 数据收集和标注

TJ4DRadSet于2021第四季度在中国苏州收集,图3记录了数据收集的位置。数据集涵盖了广泛的驾驶条件,包括各种照明条件,如正常照明、强光和黑暗,以及不同的道路类型,如城市道路、高架道路和工业区,有复杂的场景,如对象密集的十字路口和简单的场景,例如有少量对象的单向街道。我们的采集系统基于ROS,所有传感器数据都完全记录在“rosbag”中。数据集的真值标签主要包括每个对象的3D边界框、类和轨迹id,激光雷达传感器的点云密度高于4D雷达,4D雷达可以更详细地描述物体的形状。因此,我们的标注系统主要依靠激光雷达点云和图像进行联合标注。然而,由于多径效应,一些由于遮挡而几乎没有激光雷达点的物体可能仍然会出现在4D雷达视场中,我们仍然会对它们进行标记,我们手动完成了标注,并进行了多次检查,以确保数据集的质量。

每个对象的三维边界框包括中心点(x y z)长度、宽度、高度(l w h)lwh和方向角(偏航角)。此外,我们还提供遮挡和截断指示器来区分不同的难度级别,数据集有八个类别(汽车、公共汽车、卡车、工程车、行人、摩托车手、自行车手和三轮车手)。为了平衡标签分布并提高网络性能,我们将“公共汽车”和“工程车”(大型)映射为“卡车”,将“摩托车手”映射为“自行车手”。其他对象的类映射到“其他车辆”。保留原始类,以便可以根据需要自定义映射。我们为跟踪任务的每个对象分配一个唯一的id。最后,提取了40K帧同步数据,其中标记了44个连续序列中的7757帧。

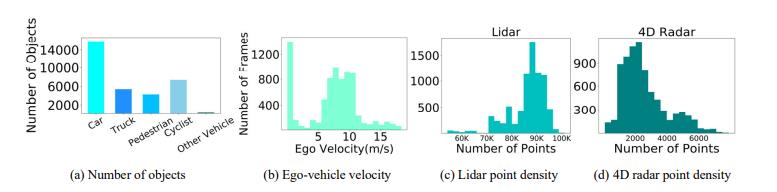

D、 数据集统计

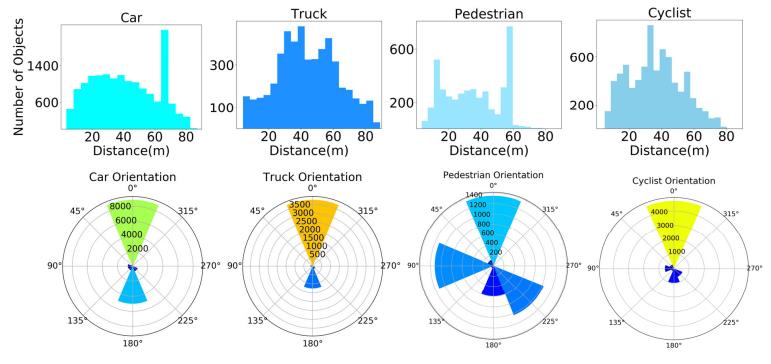

我们对数据集执行一些统计分析。图4(a)显示了每个类的对象数,其中“Car”最多,其次是“Cyclist”。“卡车”和“行人”的数量大致相同。图4(b)显示了自我车辆的速度分布,激光雷达和4D雷达的点云密度分布如图4(c)(d)所示。可以看出,4D雷达点云比激光点云稀疏,但雷达点包含更多特征,例如多普勒速度。此外,我们还计算了主要类的距离和方向的分布,如图5所示。

图4.一些基本统计数据

图5.“汽车”、“卡车”、“行人”和“自行车手”的距离和方向分布。

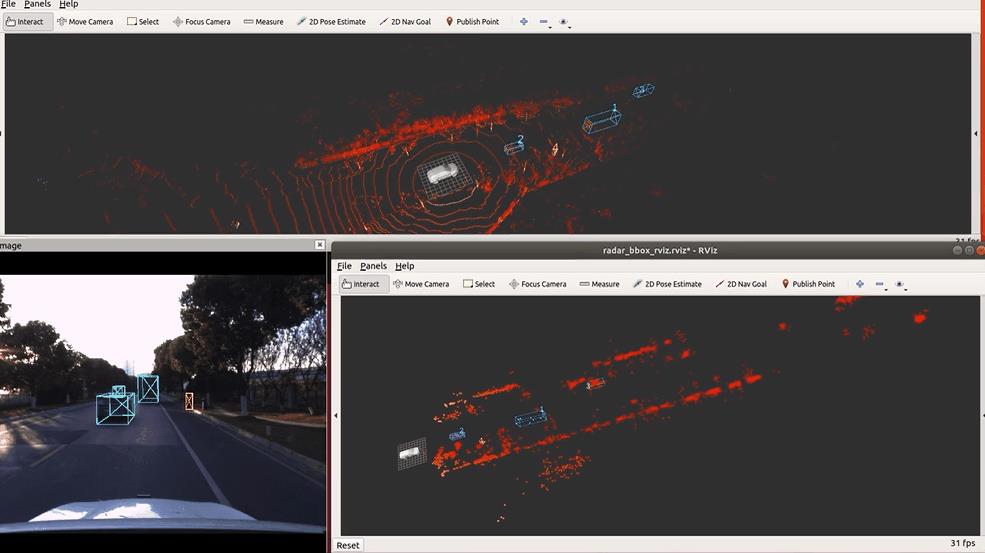

实验与结果

我们实现了基于4D雷达和激光雷达的三维目标检测基线,将数据集按序列划分为训练集和测试集,并保持测试集具有良好的覆盖率。这样,我们得到5717个训练样本和2040个测试样本,并保持数据分割不变。原始标注位于激光雷达坐标系下,通过激光雷达外参矩阵将标签传输到4D雷达坐标系。由于雷达点云的稀疏性,一些现有网络很难直接应用于这种数据格式。

本文使用PointPillars作为4D雷达和激光雷达的基线算法,因为它具有良好的适应性,并且兼顾了速度和精度。为了适应4D雷达数据,我们对原始配置进行了部分修改,并使用TJ4DRadSet重新训练了模型。沿x轴的检测范围设置为69.12m,我们使用雷达点云的五维特征,包括空间信息(z y z)、多普勒速度v和信噪比s。多普勒速度v是经过自我运动补偿后的绝对径向速度。

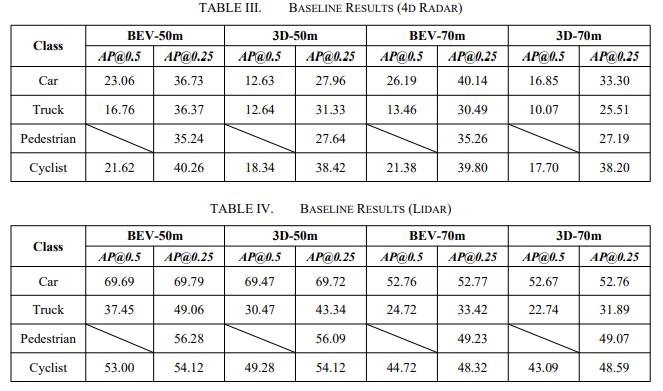

一些数据增强被用来增强网络的鲁棒性,包括世界随机旋转和随机缩放,使用Adam优化器对模型进行80个时期的训练,在评估阶段,选择平均精度(AP)作为度量,以评估每个类别的检测结果,具体而言,我们使用0.5和0.25 IoU阈值测试“汽车”、“卡车”和“自行车手”,仅使用0.25 Io阈值评估“行人”。将这两个阈值下的AP表示为AP@0.5和AP@0.25.表三和表四分别显示了使用4D雷达和激光雷达在不同距离(50m和70m)和视图(BEV、3D)下的基线性能。

结果清楚地表明,4D雷达具有三维感知的潜力。在BEV视图中,在0.25 IoU阈值下,所有类别的平均精度都超过30%。虽然基线算法可以取得一些结果,但4D雷达与激光雷达之间仍有很大差距。在相同算法(PointPillars)下,激光雷达的检测结果完全优于4D雷达,这可能是由于以下几个原因:

(1)4D雷达的点密度较低,这可能使基线网络难以有效提取特征。

(2)不同的数据扩充也会对结果产生影响。如何更好地提取4D雷达点云特征并融合其他模式的信息,是一个备受关注的问题。

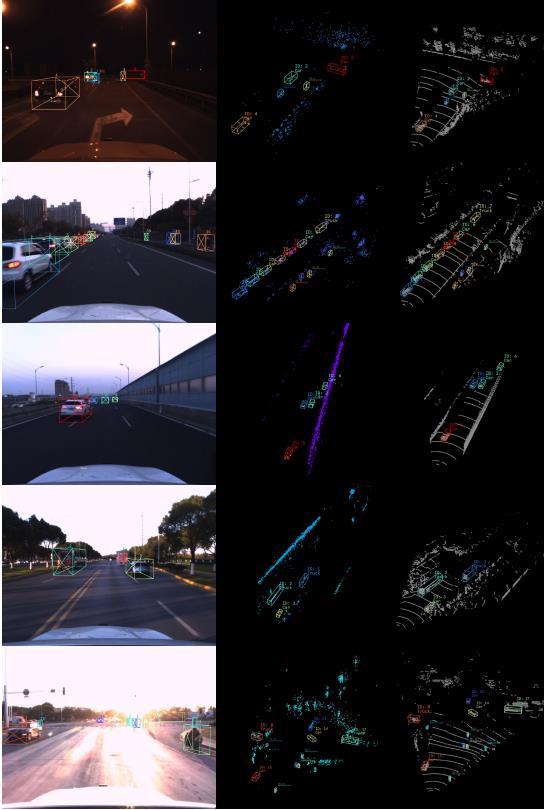

图6显示了一些典型的场景

总结

本文介绍了包含4D雷达点云的多模式自动驾驶数据集TJ4DRadSet,该数据集用于研究基于4D成像雷达的3D感知算法,对数据集进行了详细描述,并进行了基线实验,未来,我们将进一步扩展数据集,研究基于4D雷达的融合算法、点云增强和特征表示。

更多详细内容请加入知识星球查看原文。

资源

自动驾驶及定位相关分享

【点云论文速读】基于激光雷达的里程计及3D点云地图中的定位方法

自动驾驶中基于激光雷达的车辆道路和人行道实时检测(代码开源)

更多文章可查看:点云学习历史文章大汇总

SLAM及AR相关分享

结构化PLP-SLAM:单目、RGB-D和双目相机使用点线面的高效稀疏建图与定位方案

如果你对本文感兴趣,请后台发送“知识星球”获取二维码,务必按照“姓名+学校/公司+研究方向”备注加入免费知识星球,免费下载pdf文档,和更多热爱分享的小伙伴一起交流吧!

以上内容如有错误请留言评论,欢迎指正交流。如有侵权,请联系删除

扫描二维码

关注我们

让我们一起分享一起学习吧!期待有想法,乐于分享的小伙伴加入免费星球注入爱分享的新鲜活力。分享的主题包含但不限于三维视觉,点云,高精地图,自动驾驶,以及机器人等相关的领域。

分享及合作方式:微信“920177957”(需要按要求备注) 联系邮箱:dianyunpcl@163.com,欢迎企业来联系公众号展开合作。

点一下“在看”你会更好看耶

以上是关于TJ4DRadSet:自动驾驶4D成像雷达数据集的主要内容,如果未能解决你的问题,请参考以下文章