大数据Presto:Presto安装搭建

Posted Lansonli

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了大数据Presto:Presto安装搭建相关的知识,希望对你有一定的参考价值。

文章目录

10、将Presto安装包分发到node4,node5节点上并配置

二、Presto 命令行cli安装

Presto安装搭建

一、Presto Server安装

Presto的安装搭建可以参照官网:

https://prestodb.io/docs/current/installation/deployment.html#installing-presto

详细步骤如下:

1、 划分节点

| 节点IP | 节点名称 | 角色 |

| 192.168.179.6 | node3 | coordinator |

| 192.168.179.7 | node4 | worker |

| 192.168.179.8 | node5 | worker |

2、首先下载Presto Server

下载地址:https://prestodb.io/download.html

这里下载最新版本为“presto-server-0.276”,下载完成之后是一个tar包:“presto-server-0.276.tar.gz”。

本次教程使用的版本是“presto-server-0.259.tar.gz”

下载地址:Release 0.259 — Presto 0.277 Documentation

3、上传安装包,解压

将以上下载好的Presto Server 上传到node3节点上“/software”目录下,解压并修改名称:

[root@node3 software]# tar -zxvf ./presto-server-0.259.tar.gz

[root@node3 software]# mv presto-server-0.259 presto-0.259

4、创建”data”目录

在node3节点“/software/presto-0.259”目录下,创建“data”目录,此目录后面配置存放presto的日志数据及临时数据。

[root@node3 ~]# mkdir /software/presto-0.259/data5、创建“etc”目录

在node3节点“/software/presto-0.259”目录下,创建“etc”目录,此目录存放presto数据源配置信息。

[root@node3 ~]# mkdir /software/presto-0.259/etc以上目录中的需要配置的配置文件有:

- node.properties:配置每个节点的配置信息

- jvm.config:关于JVM内存配置信息。

- config.properties:Presto Server配置信息

- catalog.preperties:配置Presto的数据源Connector信息。

6、配置node.properties

在node3“/software/presto-0.259/etc”目录下创建node.properties并配置:

[root@node3 ~]# cd /software/presto-0.259/etc/

[root@node3 etc]# vim node.properties

#配置内容如下

#环境的名称。集群中的所有Presto节点必须具有相同的环境名称。

node.environment=production

#每个节点的id,presto每个节点都必须有不同的节点id

node.id=ffffffff-ffff-ffff-ffff-ffffffffffff1

#临时数据和目录的位置

node.data-dir=/software/presto-0.259/data7、配置jvm.config

在node3“/software/presto-0.259/etc”目录下创建jvm.config并配置:

[root@node3 ~]# cd /software/presto-0.259/etc/

[root@node3 etc]# vim jvm.properties

#配置内容如下

-server

-Xmx16G

-XX:+UseG1GC

-XX:G1HeapRegionSize=32M

-XX:+UseGCOverheadLimit

-XX:+ExplicitGCInvokesConcurrent

-XX:+HeapDumpOnOutOfMemoryError

-XX:+ExitOnOutOfMemoryError8、配置config.properties

在node3“/software/presto-0.259/etc”目录下创建config.properties,此配置文件主要配置哪些节点是coordinator和worker节点,配置如下:

[root@node3 ~]# cd /software/presto-0.259/etc/

[root@node3 etc]# vim config.properties

#配置的内容如下

#指定当前节点是否是coordinator节点,true是coordinator节点,false是worker节点

coordinator=true

#是否将当前coordinator节点当做worker,如果节点既是coordinator又是worker节点会影响当前节点性能

node-scheduler.include-coordinator=false

#Presto服务器的端口

http-server.http.port=8080

#查询使用集群中最大的内存量

query.max-memory=50GB

#每台节点使用最大用户内存量,用户内存用于:join,agg聚合等。

query.max-memory-per-node=1GB

#每台节点使用的最大用户内存和系统内存量,系统内存用于input/output/exchange buffers等

query.max-total-memory-per-node=2GB

#使用Discovery来发现集群中所有worker节点

discovery-server.enabled=true

#连接Discovery使用的URI,由于是内嵌,与coordinator的节点端口一致

discovery.uri=http://node3:80809、配置Hive数据源

由于启动Presto后,需要通过Connector连接数据源来显示数据,所以这里先配置下Hive数据源Connector。在node3“/software/presto-0.259/etc”目录下创建“catalog”目录,在此目录下创建hive.properties,并写入:

connector.name=hive-hadoop2

hive.metastore.uri=thrift://node1:9083

hive.config.resources=/software/hadoop-2.9.2/etc/hadoop/core-site.xml,/software/hadoop-2.9.2/etc/hadoop/hdfs-site.xml10、将Presto安装包分发到node4,node5节点上并配置

[root@node3 ~]# scp -r /software/presto-0.259/ node4:/software/

[root@node3 ~]# scp -r /software/presto-0.259/ node5:/software/- 修改node4节点“/software/presto-0.259/etc/node.properties”:

#环境的名称。集群中的所有Presto节点必须具有相同的环境名称。

node.environment=production

#每个节点的id,presto每个节点都必须有不同的节点id

node.id=ffffffff-ffff-ffff-ffff-ffffffffffff2

#临时数据和目录的位置

node.data-dir=/software/presto-0.259/data- 修改node4节点“/software/presto-0.259/etc/config.properties”,写入:

#指定当前节点是否是coordinator节点,true是coordinator节点,false是worker节点

coordinator=false

#Presto服务器的端口

http-server.http.port=8080

#查询使用集群中最大的内存量

query.max-memory=50GB

#每台节点使用最大用户内存量,用户内存用于:join,agg聚合等。

query.max-memory-per-node=1GB

#每台节点使用的最大用户内存和系统内存量,系统内存用于input/output/exchange buffers等

query.max-total-memory-per-node=2GB

#连接Discovery使用的URI,由于是内嵌,与coordinator的节点端口一致

discovery.uri=http://node3:8080- 修改node5节点“/software/presto-0.259/etc/node.properties”:

#环境的名称。集群中的所有Presto节点必须具有相同的环境名称。

node.environment=production

#每个节点的id,presto每个节点都必须有不同的节点id

node.id=ffffffff-ffff-ffff-ffff-ffffffffffff3

#临时数据和目录的位置

node.data-dir=/software/presto-0.259/data- 修改node5节点“/software/presto-0.259/etc/config.properties”,写入:

#指定当前节点是否是coordinator节点,true是coordinator节点,false是worker节点

coordinator=false

#Presto服务器的端口

http-server.http.port=8080

#查询使用集群中最大的内存量

query.max-memory=50GB

#每台节点使用用户的最大内存量

query.max-memory-per-node=1GB

#每台节点使用用户和系统的最大内存量,没有单独配置,与上面一样

query.max-total-memory-per-node=2GB

#连接Discovery使用的URI,由于是内嵌,与coordinator的节点端口一致

discovery.uri=http://node3:8080

11、启动HDFS,启动Hive元数据

[root@node1 ~]# hive --service metastore &12、启动/停止Presto Server

分别在node3,node4,node5节点上启动Presto Server,启动可以采用前台方式,日志会打印到控制台,也可以采用后台方式启动Presto,日志存放在“/software/presto-0.259/data/var/log”路径下。

#前台启动,如果停止直接ctrl+c

[root@node3 ~]# /software/presto-0.259/bin/launcher run

[root@node4 ~]# /software/presto-0.259/bin/launcher run

[root@node5 ~]# /software/presto-0.259/bin/launcher run

#后台启动/停止

[root@node3 ~]# /software/presto-0.259/bin/launcher start/stop

[root@node4 ~]# /software/presto-0.259/bin/launcher start/stop

[root@node5 ~]# /software/presto-0.259/bin/launcher start/stop以上安装好了presto的服务端,也配置了Hive Connector,现在还不能查询数据,需要安装Presto的客户端才可以查询。

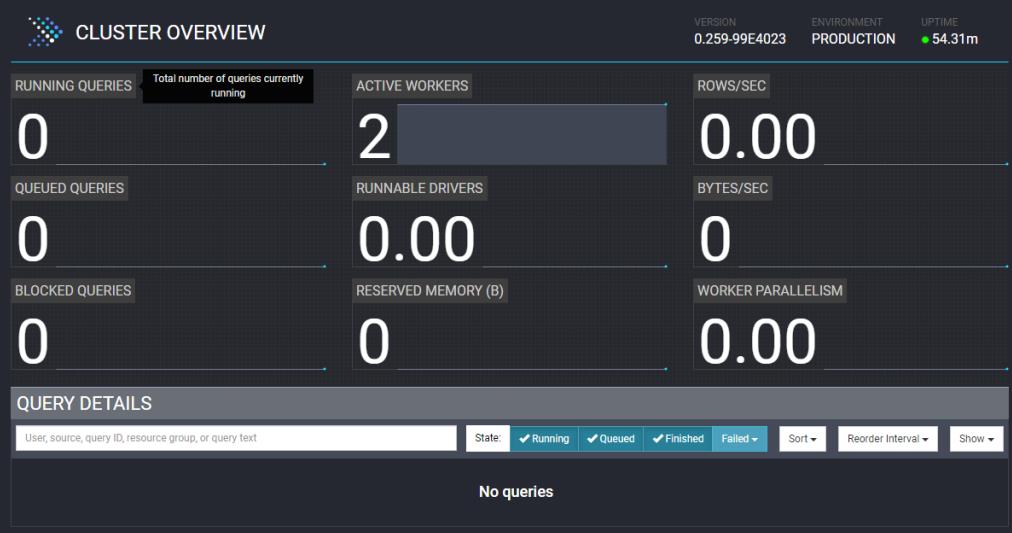

13、查看webui

启动完成之后,可以登录“node3:8080”查看presto WebUI监控页面信息:

二、Presto 命令行cli安装

Presot cli 就是交互式的查询shell窗口,方便写SQL查询Presto数据。安装Presto 命令行 cli步骤如下:

1、下载jar包

在https://prestodb.io/download.html下载Presto cli对应的jar包,下载后为:presto-cli-0.259-executable.jar。

2、上传jar包,修改名称,并赋值权限

将下载好的jar包,上传到node3,node4,node5任意节点任意目录,这里上传到node3“/software/presto-0.259”目录下,修改jar包名称为“presto”并赋权限。

[root@node3 ~]# cd /software/presto-0.259/

[root@node3 presto-0.259]# mv presto-cli-0.259-executable.jar presto

[root@node3 presto-0.259]# chmod +x presto3、启动Presto cli

在node3上执行如下命令:

[root@node3 ~]# cd /software/presto-0.259/

[root@node3 presto-0.259]# ./presto --server node3:8080 --catalog hive --schema default注意:--server执行连接Presto的coordinator节点,--catalog指定连接hive,这里写的名字和“/software/presto-0.259/etc/catalog”路径中配置的properties名称保持一致。--schema 指定连接Hive的哪个库。

执行如下查询命令:

#查看Hive中的库

presto:default> show schemas;

#查看表

presto:default> show tables;

#查询数据

presto:default> select * from to_song_info_d limit 20;

#退出客户端

presto:default> quit;注意:在presto中显示结果时使用了分页,不是一次性将所有结果都显示出来,按上下箭头可以查看所有数据结果或者按空格键进行翻页查看,若想要向前向后翻页,可以按键盘上的“page up”和“page down”,按“q”可以退出查询。

- 📢博客主页:https://lansonli.blog.csdn.net

- 📢欢迎点赞 👍 收藏 ⭐留言 📝 如有错误敬请指正!

- 📢本文由 Lansonli 原创,首发于 CSDN博客🙉

- 📢停下休息的时候不要忘了别人还在奔跑,希望大家抓紧时间学习,全力奔赴更美好的生活✨

以上是关于大数据Presto:Presto安装搭建的主要内容,如果未能解决你的问题,请参考以下文章