深度学习中的FLOPs是什么?如何计算的?

Posted 静待花开s0

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了深度学习中的FLOPs是什么?如何计算的?相关的知识,希望对你有一定的参考价值。

1.区分FLOPs和FLOPS

FLOPS:注意全大写,是floating point operations per second的缩写,意指每秒浮点运算次数,理解为计算速度。是一个衡量硬件性能的指标。

FLOPs:注意s小写,是floating point operations的缩写(s表复数),意指浮点运算数,理解为计算量。可以用来衡量算法/模型的复杂度。

注意在深度学习中,我们用的是FLOPs,也就是说计算量,即用来衡量算法/模型的复杂度。

2.计算方法

注:以下不考虑activation function的运算。

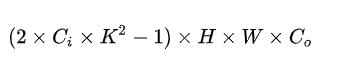

2.1 卷积层:

Ci=input channel,

k=kernel size,

H,W=output feature map size,

Co=output channel.

2是因为一个MAC算2个operations。不考虑bias时有-1,有bias时没有-1。

(注:这里的MAC是乘加的意思,所以是两个operation)

上面针对一个input feature map,没考虑batch size。

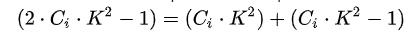

理解上面这个公式分两步,括号内是第一步,计算出output feature map的一个pixel,然后再乘以HWCo拓展到整个output feature map。括号内的部分又可以分为两步,

第一项是乘法运算数,第二项是加法运算数,因为n个数相加,要加n-1次,所以不考虑bias,会有一个-1,如果考虑bias,刚好中和掉,括号内变为

第一项是乘法运算数,第二项是加法运算数,因为n个数相加,要加n-1次,所以不考虑bias,会有一个-1,如果考虑bias,刚好中和掉,括号内变为

2.2 全联接层:

I=input neuron numbers, O=output neuron numbers.

2是因为一个MAC算2个operations。

不考虑bias时有-1,有bias时没有-1。

分析同理,括号内是一个输出神经元的计算量,拓展到O了输出神经元。

参考:https://www.zhihu.com/question/65305385/answer/451060549

以上是关于深度学习中的FLOPs是什么?如何计算的?的主要内容,如果未能解决你的问题,请参考以下文章