一文回顾Aleo到底有多卷

Posted 枫之子叶

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了一文回顾Aleo到底有多卷相关的知识,希望对你有一定的参考价值。

年底的Aleo是区块链行业的一场大事,由于融资超过两亿美元这样的光环围绕,Aleo出道即备受关注,网上不少教程也是满天飞,甚至在激励测试开始之前,就已经非常卷了,而大家都在认为激励测试在两三周之后开始,没想到官方杀了个回马枪,直接12月2日开始激励测试,同时分配token细则也公布了出来!

简单来说,就一句话,钱少事多,按照暴躁兔之前的估算,单个token价格如果是2u的话,参与aleo没啥可玩的了,但是寒冷的冬天也需要显卡的热度(有些人可能真的需要放客厅取暖),于是这样就卷起来了。

接下来暴躁兔回顾一下在参与aleo过程中感受到市场到底有多饥渴。

第一天12月2日除了早上用CPU来参与的人能获得点东西之外,基本上大部分人是啥都没有的,这点确实让人感觉到很惨,最终有人总结了第一天的成绩,CPU没戏,直接考虑GPU。而不少群里还充斥着GPU利用率不高或者没锄头的问题(相对来说是这样的,但是GPU仍然具有优势)。

当大家开始投身GPU的时候,第二天测试网崩了,全网不处块让一些人不断吐槽,不得不说,上次测试激励网的时候就出现这种情况,这次又来,让人不禁感到怀疑项目方的技术实力和水平,不过怀疑归怀疑,该参与的还是要参与。大部分人一边等着网络恢复正常,一边等着别人能出锄头或者加入池子来分杯羹。

这种心态在后面也确实得到了满足,目前用的比较多的锄头方案是damominer的,锄头最先出来的是linux版的,算力相较win版的搞了一倍左右,hpool的还是比较稳的,damominer的表现也不错,鱼池也开通了池子,虽然他们之前就开通了,但是由于技术问题又下架了。

要说总结,不得不说,aleo真的让人很崩溃。

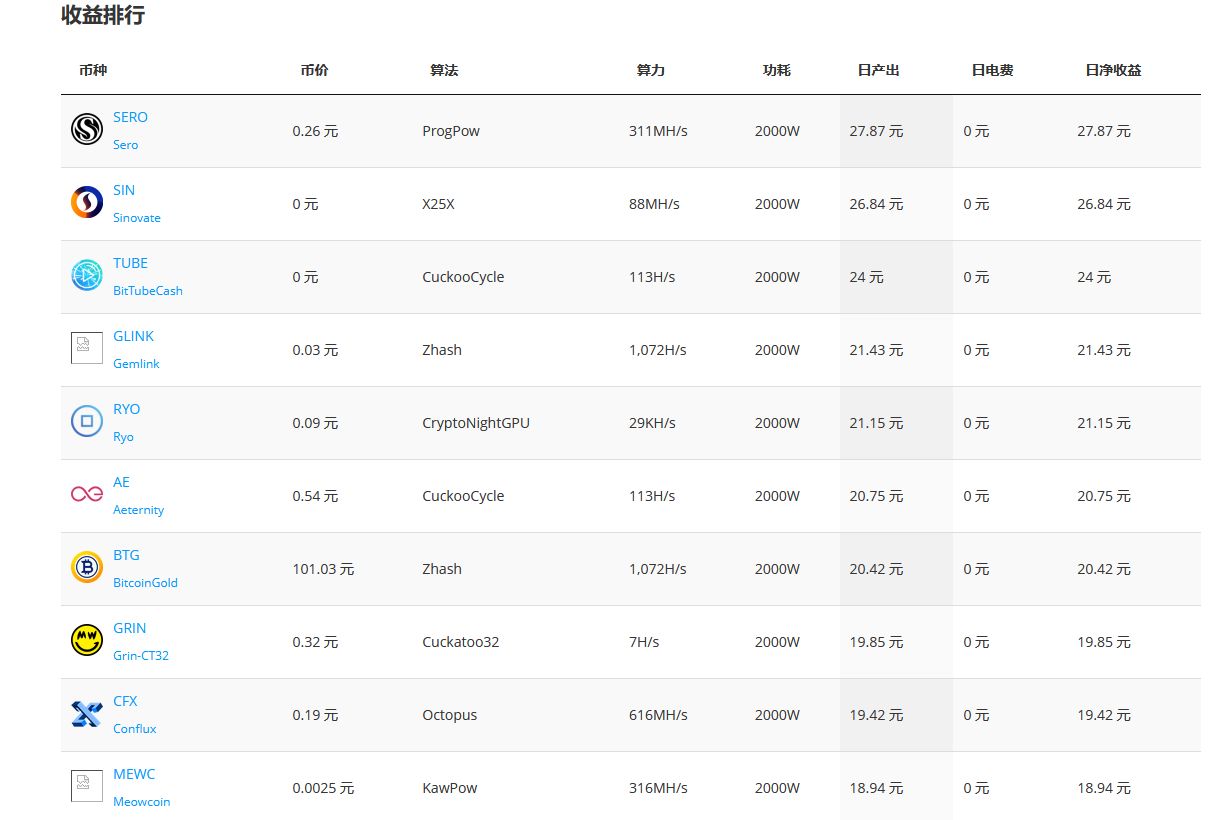

接下来说说收益,我们以3080为例:

租服务器的话,一天的价格至少在好几百,而最后收益中sero收益为27块,不得不说这让人感觉很无语,回本遥遥无期。

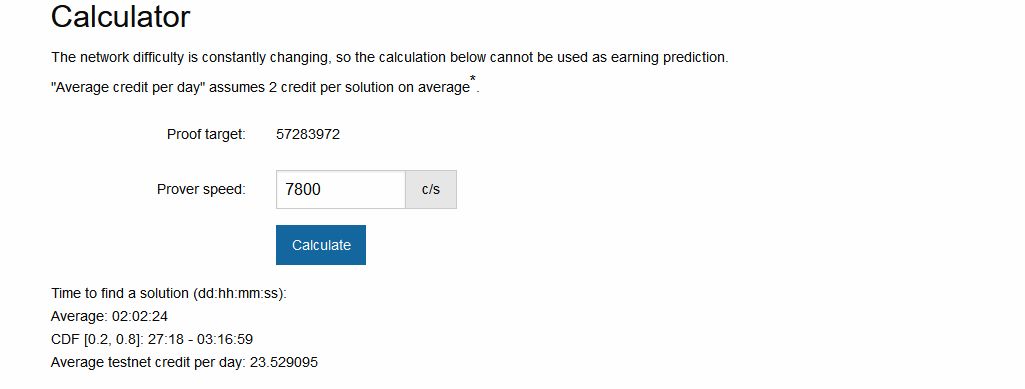

而如果你参与aleo,则一天可以获得23个分(12月8日),最后换成主网token的话,也就是4.6个。此时按照我们每个2u来估算的话,那么也就是9.2u,也就是说,远超上面最高的sero。

更不用说有的人将aleo单个token估值到达几十u(虽然我们认为这不太靠谱),这也是aleo为何能吸引不少玩家参与的原因。也就是说如果你之前是显卡玩家,那么大概率是要切到aleo之上的。

不过最后话说回来,即使收益很高,但是仍然是亏本的,这有比较大的概率。我们是保守估值2u,在市场中也有人估值5u或者10u,再高的话,短期不太现实,因此我们满打满算以10u来计算,一天也就是46u,换算过来也就是三百多块钱,如果你租服务器,那么基本上是没啥收益。

如果你是自己的卡,那么我们按照现在市场二手卡的价格3500一个3080来算,机器成本大致在3万左右(因为还要选择好一点的u),也就是说理论上100天,你就白获得了8卡的平台(实际会更久,因为参与人数也在不断增加,可能最终要200天甚至300天)

如果你只参与一个月,那么等小黄鱼出掉的时候,可能你的卡也贬值了一些,我们以贬值10%来计算,那么将会是这样

一个月后你3万的硬件,到时候只值2.7万,亏了3000

然后你获得了积分大约为400个(难度也会上升,这个是估算)

最后的收益可能会在160-800u之间

扣去硬件损耗成本,也就是说5u左右刚好回本,没有赢也没有输。刚好在大家最高估值的中间,属于比上不足,比下有余那种,这种情况下, 确实也不太好判断。同时这也是市场潜移默化中的一个选择。

也就是说参与者可能最多赚个辛苦钱,其实并不是特别好赚,其实这种情况在ironfish上也有所体现,ironfish在上显卡之后,其实也是非常卷,直到最后全网算力达到一条直线,这也是市场最终的选择。

最后是否值得

长期来看,应该是值得的,毕竟目前市场中如此亮眼的项目,除了aptos和sui之外,基本上已经没有了,因此如果进入牛市,那么基本上10u是大概率会过去的,这点毫无疑问,因此长期来看,是值得的,但是这是否是最优途径,目前还是比较难说的,因为在熊市中,破发之类的事情也是常有的,因此如果你想快进快出,那么不太建议深度参与,如果你很有耐心,那么倒是可以试试。

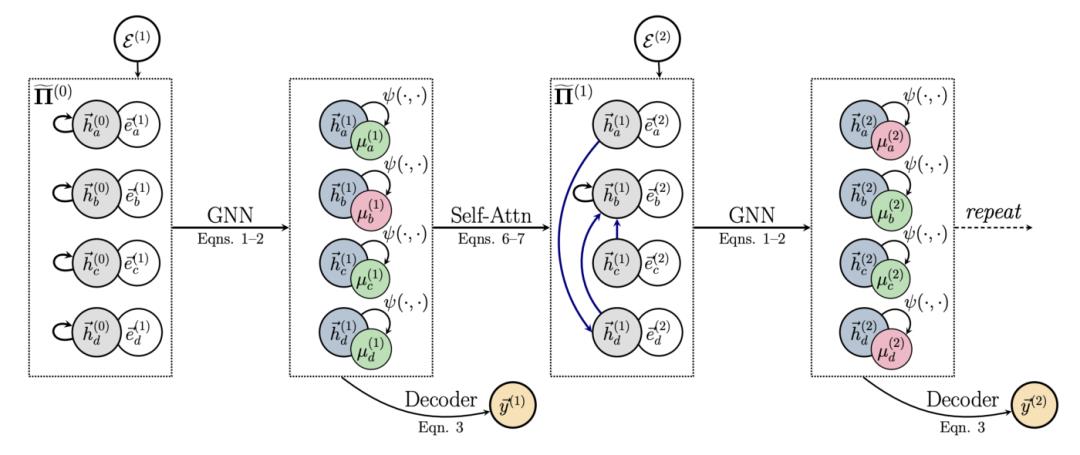

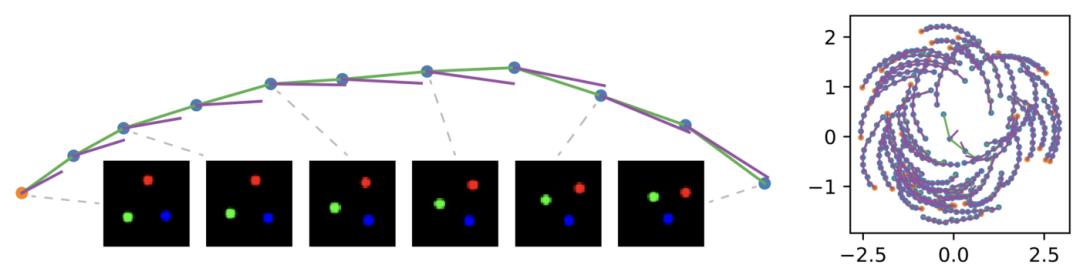

图机器学习有多大神力?一文带你回顾2020,展望2021

新智元报道

【新智元导读】近两年,图机器学习可谓是机器学习研究领域的新星,随着模型的更新和应用的推广,越来越多的人开始把注意力转向了这一方向。过去一年中,图机器学习在哪方面有突破呢,在未来的一年中,哪些分支和方向会成为新的研究趋势呢?这篇文章,带你领略该领域诸多名人的最新思考。

消息传递(Message Passing)

算法推理(Algorithmic reasoning)

关系结构发现(Relational structure discovery)

表现力(Expressive Power)

可扩展性 (Scalability)

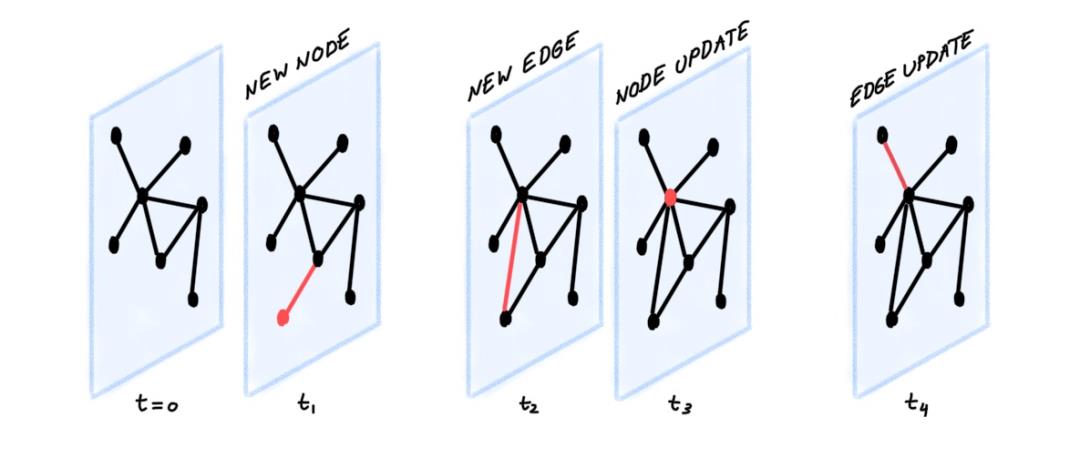

动态图(Dynamic graphs)

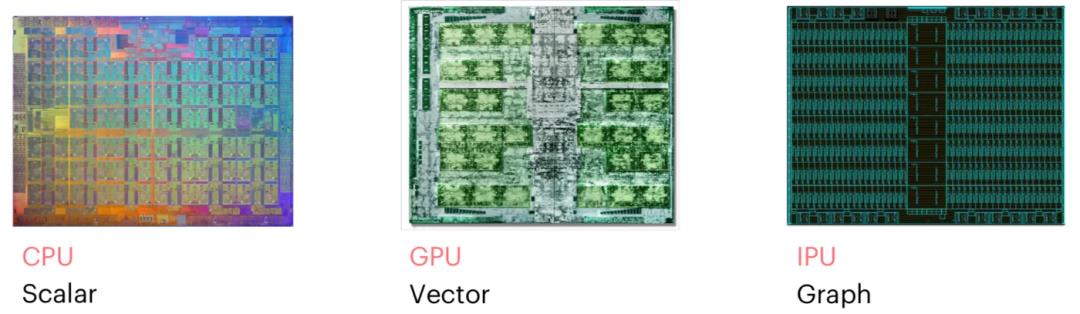

新硬件(New hardware)

以上是关于一文回顾Aleo到底有多卷的主要内容,如果未能解决你的问题,请参考以下文章