FFMPEG关键结构体——AVFrame

Posted 陈小帅hh

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了FFMPEG关键结构体——AVFrame相关的知识,希望对你有一定的参考价值。

一、AVFrame结构体

AVFrame结构体一般用于存储原始数据(即非压缩数据,例如对视频来说是YUV,RGB,对音频来说是PCM),此外还包含了一些相关的信息。

比如说,解码的时候存储了宏块类型表,QP表,运动矢量表等数据。编码的时候也存储了相关的数据。因此在使用FFMPEG进行码流分析的时候,AVFrame是一个很重要的结构体。

AVFramet通常在解码时包含较多的码流参数,编码时主要用于承载图像数据或者音频采样数据。结构体的定义位于libavutil/frame.h,这里介绍解码情况下的主要变量

1.变量介绍

①uint8_t *data[AV_NUM_DATA_POINTERS];

(1)图像数据:

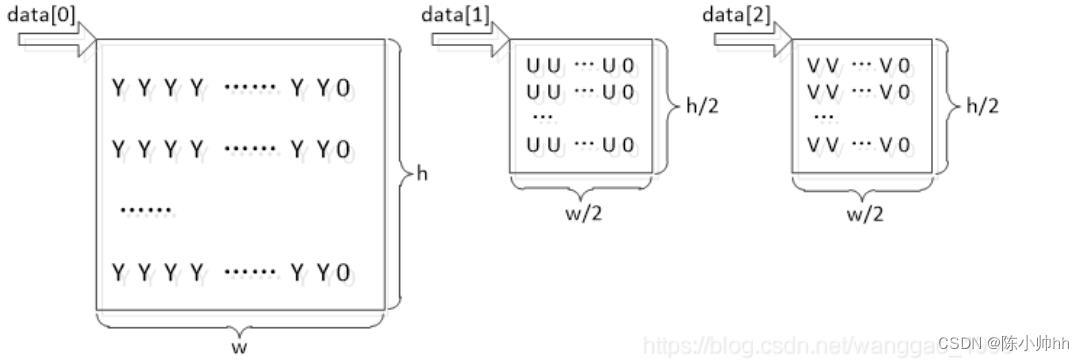

对于packed格式的数据(例如RGB24),会存到data[0]里面。

对于planar格式的数据(例如YUV420P),则会分开成data[0],data[1],data[2]…(YUV420P中data[0]存Y,data[1]存U,data[2]存V)

(2)音频数据:

采样数据PCM, 保存方式同图像数据。 对于对于planar格式的音频数据通道数超过8时,其余通道数据存放于extended_data中。

②int linesize[AV_NUM_DATA_POINTERS];

行字节的跨度,相当于stride。对于data[i]区域中的一行像素占用的字节数,对于RGB24理论是wh3, 0, …; 对于yuv420p,理论是w, w/2, w/2, 0, …。但ffmpeg内存会填充对齐,实际行字节数会大于等于理论值。

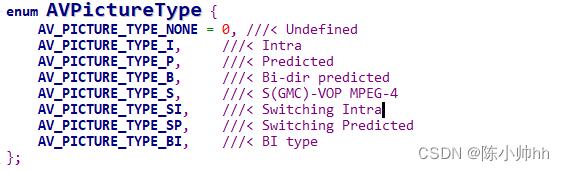

③enum AVPictureType pict_type;

帧数据类型,部分摘取如下

二、常用函数介绍

1、av_frame_alloc()

申请AVFrame结构体空间,同时会对申请的结构体初始化。注意哦,这个函数只是创建AVFrame结构的空间,AVFrame中的uint8_t *data[AV_NUM_DATA_POINTERS]空间此时NULL,不会创建的。

2、av_frame_free()

释放AVFrame的结构体空间。这个函数就有点意思了。因为他不仅仅释放结构体空间,还涉及到AVFrame中的uint8_t *data[AV_NUM_DATA_POINTERS];字段的释放问题。,如果AVFrame中的uint8_t *data[AV_NUM_DATA_POINTERS]中的引用==1,则释放data的空间。

3、int av_frame_ref(AVFrame *dst, const AVFrame *src)

对已有AVFrame的引用,这个引用做了两个动作:1、将src属性内容复制到dst,2、对AVFrame中的uint8_t *data[AV_NUM_DATA_POINTERS]字段引用计数+1。

4、void av_frame_unref(AVFrame *frame)

对frame释放引用,做了两个动作:1、将frame的各个属性初始化,2、如果AVFrame中的uint8_t *data[AV_NUM_DATA_POINTERS]中的引用==1,则释放data的空间。当然,如果data的引用计数>1则由别的frame去检测释放。

5、av_frame_get_buffer()

这个函数是建立AVFrame中的uint8_t *data[AV_NUM_DATA_POINTERS]内存空间,使用这个函数之前frame结构中的format、width、height:必须赋值,要不然函数怎么知道创建多少字节的空间呢!

三、常规解码流程使用

3个步骤:

①AVFrame *pFrame = av_frame_alloc()分配一个AVFrame对象,缓冲区data[]未分配。

②使用调用av_receive_frame解码,会对pFrame分配data[]缓冲区并保存解码数据;每一次使用后,必须需要使用av_frame_unref释放缓冲区,否则重复解码会造成内存泄露。

③需要使用av_frame_free 释放整个对象。

AVFrame *pFrame = av_frame_alloc(); // [1]

while()

…

av_receive_frame(ctx, pFrame);

… // process

av_frame_unref(pFrame); // [2]

av_frame_free(pFrame); // [3]

四、图像处理

前面提到,ffmpeg内部编码器对于图像处理部分为了方便优化处理,通常创建的缓冲区比原始图像大,实际有效数据部分只是缓冲区的一部分。这一种优化方案直接反应在linesize上,使用8或16或32字节对齐,取决于平台。

对于分辨率为638*272的视频解码后yuv420p的缓冲区 linsesize为640,320,320,…,内存布局结构如下图

图中,其中w = 640 , h = 320。可以看到,在三个通道中每一行数据间进行了数据填充,Y区域的行字节数不等于638,U/V区域的行字节数也不等于319。注意观察data[2],data[1],data[0]之间的差值。

如果我们需要yuv三个分量无填充的 yuv420p数据,可以手动分配大小为wh3/2的内存,再从解码后AVFrame的data[]中拷贝出来。

1、分配缓冲区内存

①方法一:使用malloc原生的内存管理方式,

uint8_t yuv_buf = malloc(w*h*3/2);

②方法二:fmpeg内存分配函数

// yuv420p对齐处理 变量

AVFrame *frame_yuv = av_frame_alloc();

// 分配缓冲区,接收转换后yuv420p的1字节对齐数据,分辨率不改变

av_image_alloc(frame_yuv->data, frame_yuv->linesize,

video_decoder_ctx->width, video_decoder_ctx->height, AV_PIX_FMT_YUV420P, 1);

// 对于编码,需要AVFrame有对应的参数

frame_yuv->width = video_decoder_ctx->width;

frame_yuv->height = video_decoder_ctx->height;

frame_yuv->format = AV_PIX_FMT_YUV420P;

③方法三:原生指针加ffmpeg内存分配函数

uint8_t *yuvbuf;

int linesize[4];

av_image_alloc(&yuvbuf, linesize, video_decoder_ctx->width, video_decoder_ctx->height,

AV_PIX_FMT_YUV420P, 1);

④方法四:使用av_frame_get_buffer函数(注意检查内存是否连续)

AVFrame *frame_yuv = av_frame_alloc();

frame_yuv->width = video_decoder_ctx->width;

frame_yuv->height = video_decoder_ctx->height;

frame_yuv->format = AV_PIX_FMT_YUV420P;

// 使用一下函数必须先指定frame的 音频/视频 参数

av_frame_get_buffer(frame_yuv, 1); // align = 0, 由系统选择最优对齐方式

注意,av_frame_get_buffer(frame_yuv, 1); 保证y,u,v分量数据区域是1字节对齐的、连续的,但是y,u,v三个数据区不是1字节对齐、也不是连续的。例如,手动分配100*100尺寸的yuv420的数据分量部分

AVFrame *frame_yuv = av_frame_alloc();

frame_yuv->width = 100;

frame_yuv->height = 100;

frame_yuv->format = AV_PIX_FMT_YUV420P;

av_frame_get_buffer(frame_yuv, 1);

结果如下图,三个分量数据区指针从小到大为 u < y < v,指针之间的间隔不等于wh,也不等于wh/2。

注意:后两种方式一种是使用裸指针,一种借助AVFrame,虽然访问管理缓冲区的方式不同,但是都用到了av_image_alloc,都需要传递缓冲区指针和接收linesize的数组。

FFMPEG关键结构体

// FFMPEG关键结构体:

// 转载 http://blog.csdn.net/leixiaohua1020/article/details/14214577

// 2016.2.26

AVFrame(位于avcodec.h)结构体一般用于存储原始数据。

===============================================================================

下面看几个主要变量的作用(在这里考虑解码的情况):

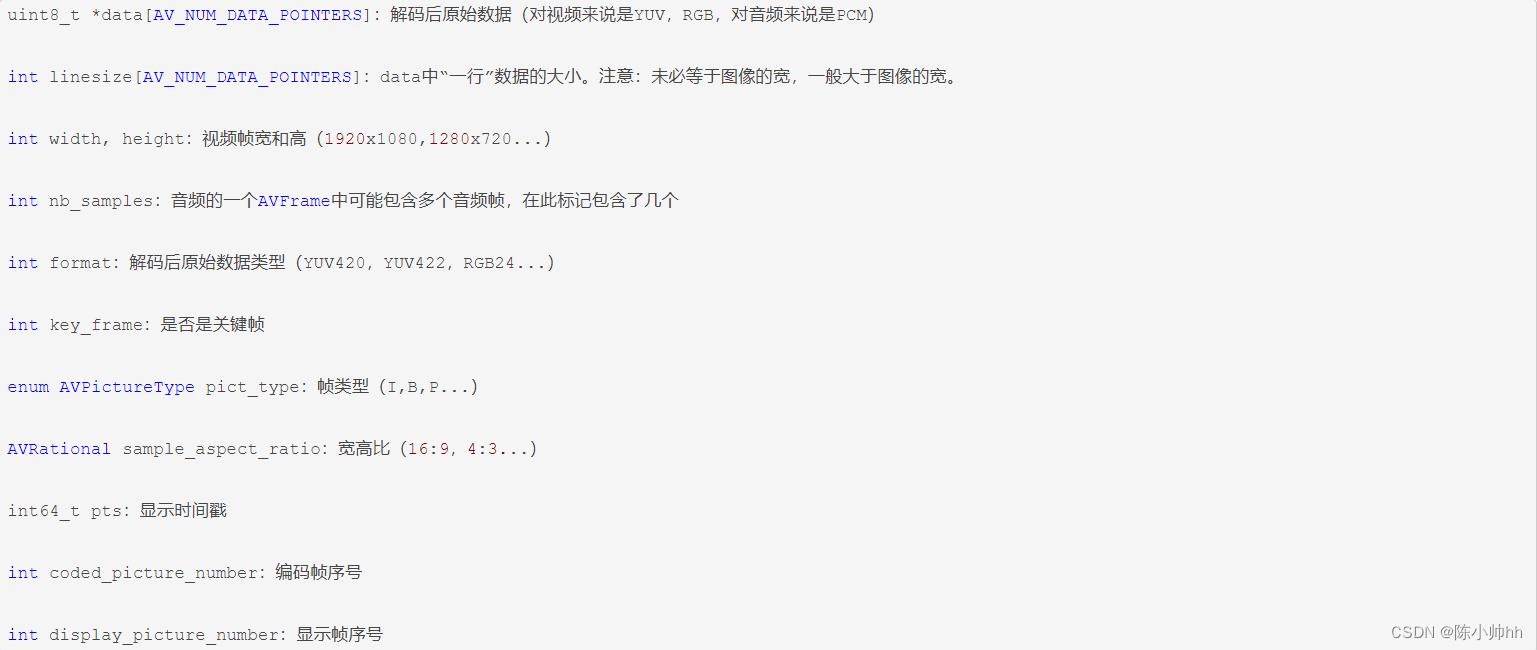

uint8_t *data[AV_NUM_DATA_POINTERS]:解码后原始数据(对视频来说是YUV,RGB,对音频来说是PCM)

int linesize[AV_NUM_DATA_POINTERS]:data中“一行”数据的大小。注意:未必等于图像的宽,一般大于图像的宽。

int width, height:视频帧宽和高(1920x1080,1280x720...)

int nb_samples:音频的一个AVFrame中可能包含多个音频帧,在此标记包含了几个

int format:解码后原始数据类型(YUV420,YUV422,RGB24...)

int key_frame:是否是关键帧

enum AVPictureType pict_type:帧类型(I,B,P...)

AVRational sample_aspect_ratio:宽高比(16:9,4:3...)

int64_t pts:显示时间戳

int coded_picture_number:编码帧序号

int display_picture_number:显示帧序号

int8_t *qscale_table:QP表

uint8_t *mbskip_table:跳过宏块表

int16_t (*motion_val[2])[2]:运动矢量表

uint32_t *mb_type:宏块类型表

short *dct_coeff:DCT系数,这个没有提取过

int8_t *ref_index[2]:运动估计参考帧列表(貌似H.264这种比较新的标准才会涉及到多参考帧)

int interlaced_frame:是否是隔行扫描

uint8_t motion_subsample_log2:一个宏块中的运动矢量采样个数,取log的

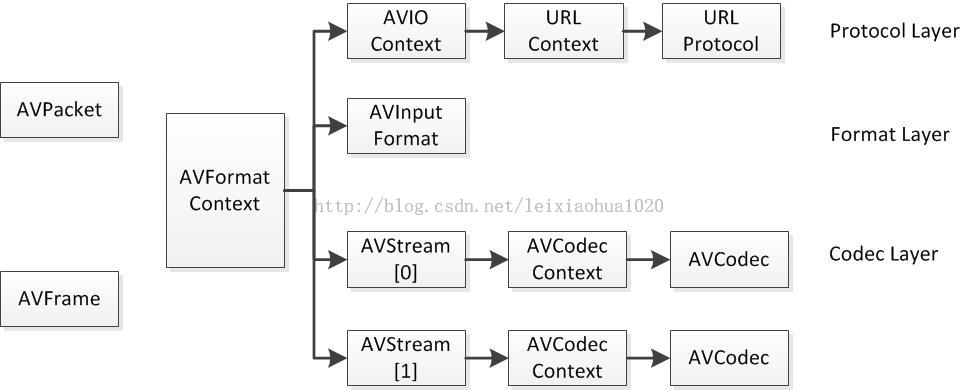

AVFormatContext(位于avformat.h)是一个贯穿始终的数据结构,很多函数都要用到它作为参数,

它是FFMPEG解封装(flv,mp4,rmvb,avi)功能的结构体。

===============================================================================

下面看几个主要变量的作用(在这里考虑解码的情况):

struct AVInputFormat *iformat:输入数据的封装格式

AVIOContext *pb:输入数据的缓存

unsigned int nb_streams:视音频流的个数

AVStream **streams:视音频流

char filename[1024]:文件名

int64_t duration:时长(单位:微秒us,转换为秒需要除以1000000)

int bit_rate:比特率(单位bps,转换为kbps需要除以1000)

AVDictionary *metadata:元数据

AVCodecContext(位于avcodec.h)中很多的参数是编码的时候使用的

===============================================================================

下面挑一些关键的变量来看看(这里只考虑解码)。

enum AVMediaType codec_type:编解码器的类型(视频,音频...)

struct AVCodec *codec:采用的解码器AVCodec(H.264,MPEG2...)

int bit_rate:平均比特率

uint8_t *extradata; int extradata_size:针对特定编码器包含的附加信息(例如对于H.264解码器来说,存储SPS,PPS等)

AVRational time_base:根据该参数,可以把PTS转化为实际的时间(单位为秒s)

int width, height:如果是视频的话,代表宽和高

int refs:运动估计参考帧的个数(H.264的话会有多帧,MPEG2这类的一般就没有了)

int sample_rate:采样率(音频)

int channels:声道数(音频)

enum AVSampleFormat sample_fmt:采样格式

int profile:型(H.264里面就有,其他编码标准应该也有)

int level:级(和profile差不太多)

AVIOContext(位于avio.h)是FFMPEG管理输入输出数据的结构体。

===============================================================================

AVIOContext中有以下几个变量比较重要:

unsigned char *buffer:缓存开始位置

int buffer_size:缓存大小(默认32768)

unsigned char *buf_ptr:当前指针读取到的位置

unsigned char *buf_end:缓存结束的位置

void *opaque:URLContext结构体

AVCodec(位于avcodec.h)是存储编解码器信息的结构体。

===============================================================================

下面说一下最主要的几个变量:

const char *name:编解码器的名字,比较短

const char *long_name:编解码器的名字,全称,比较长

enum AVMediaType type:指明了类型,是视频,音频,还是字幕

enum AVCodecID id:ID,不重复

const AVRational *supported_framerates:支持的帧率(仅视频)

const enum AVPixelFormat *pix_fmts:支持的像素格式(仅视频)

const int *supported_samplerates:支持的采样率(仅音频)

const enum AVSampleFormat *sample_fmts:支持的采样格式(仅音频)

const uint64_t *channel_layouts:支持的声道数(仅音频)

int priv_data_size:私有数据的大小

AVStream(位于avformat.h)是存储每一个视频/音频流信息的结构体。

===============================================================================

重要的变量如下所示:

int index:标识该视频/音频流

AVCodecContext *codec:指向该视频/音频流的AVCodecContext(它们是一一对应的关系)

AVRational time_base:时基。通过该值可以把PTS,DTS转化为真正的时间。FFMPEG其他结构体中也有这个字段,

但是根据我的经验,只有AVStream中的time_base是可用的。PTS*time_base=真正的时间

int64_t duration:该视频/音频流长度

AVDictionary *metadata:元数据信息

AVRational avg_frame_rate:帧率(注:对视频来说,这个挺重要的)

AVPacket attached_pic:附带的图片。比如说一些MP3,AAC音频文件附带的专辑封面。

AVPacket(位于avcodec.h)是存储压缩编码数据相关信息的结构体。

===============================================================================

重要的变量有以下几个:

uint8_t *data:压缩编码的数据。

例如对于H.264来说。1个AVPacket的data通常对应一个NAL。

注意:在这里只是对应,而不是一模一样。他们之间有微小的差别:使用FFMPEG类库分离出多媒体文件中的H.264码流

因此在使用FFMPEG进行视音频处理的时候,常常可以将得到的AVPacket的data数据直接写成文件,从而得到视音频的码流文件。

int size:data的大小

int64_t pts:显示时间戳

int64_t dts:解码时间戳

int stream_index:标识该AVPacket所属的视频/音频流。

以上是关于FFMPEG关键结构体——AVFrame的主要内容,如果未能解决你的问题,请参考以下文章