Springboot中kafka解决数据重复消费问题

Posted 小王同鞋

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Springboot中kafka解决数据重复消费问题相关的知识,希望对你有一定的参考价值。

原因:

消费者处理比较耗时,一次poll的数据,在max.poll.interval.ms达到最大值后仍未完成,未提交offest,默认值为5分钟。

解决办法

1.提高max.poll.interval.ms的值。

Ⅰ.使用springboot自动配置方式

spring:

kafka:

bootstrap-servers: 127.0.0.1:9092

#分号不能去

consumer:

auto-offset-reset: latest

key-deserializer: org.apache.kafka.common.serialization.StringDeserializer

# 值的反序列化方式

value-deserializer: org.apache.kafka.common.serialization.StringDeserializer

max:

poll:

interval:

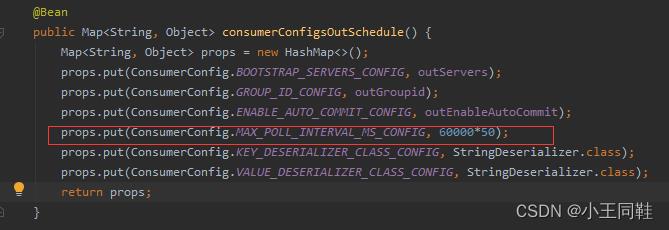

ms: 60000*50 Ⅱ.使用自定义配置kafkaConfig则在消费者配置部分添加

2.自定义逻辑去重。

kafka重复消费数据,内含福利

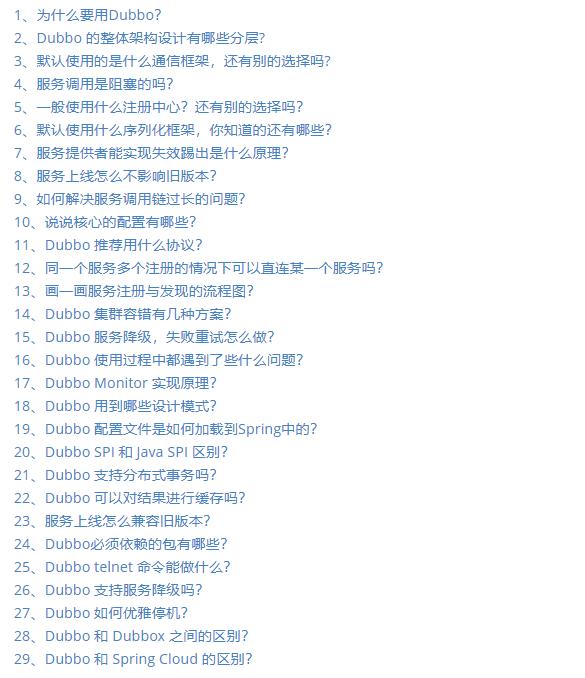

Dubbo面试专题

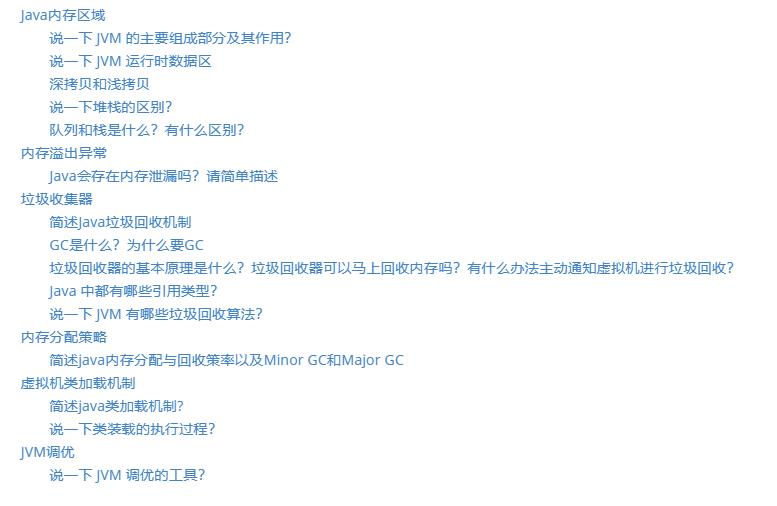

JVM面试专题

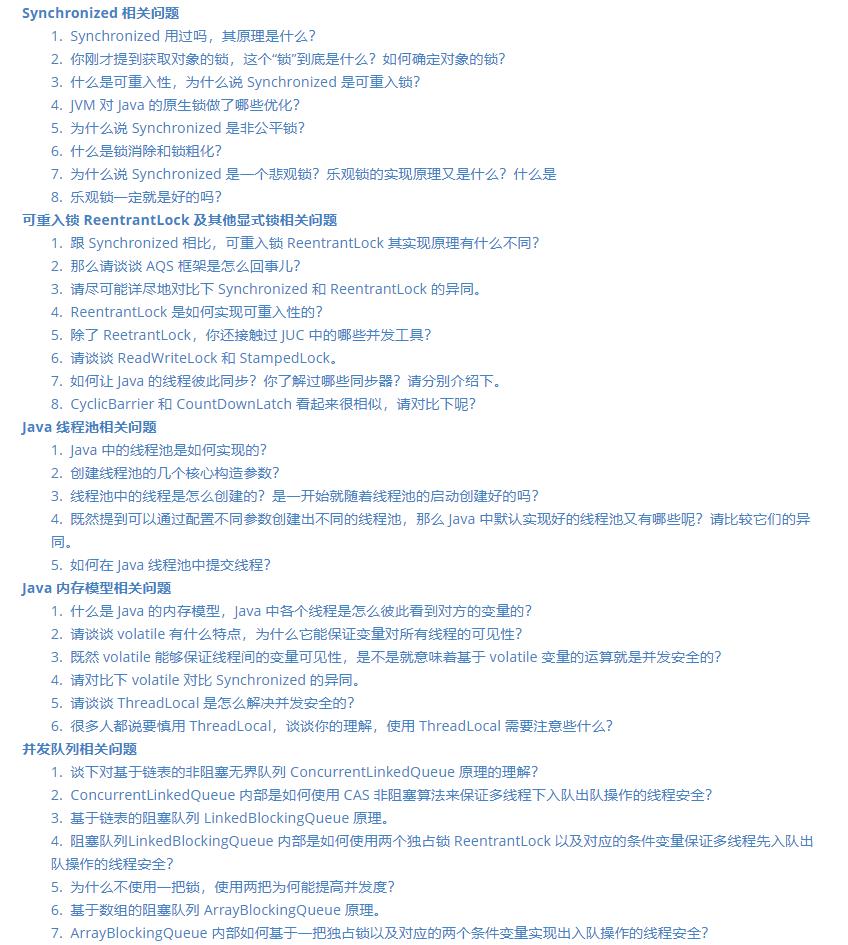

Java并发面试专题

Kafka面试专题

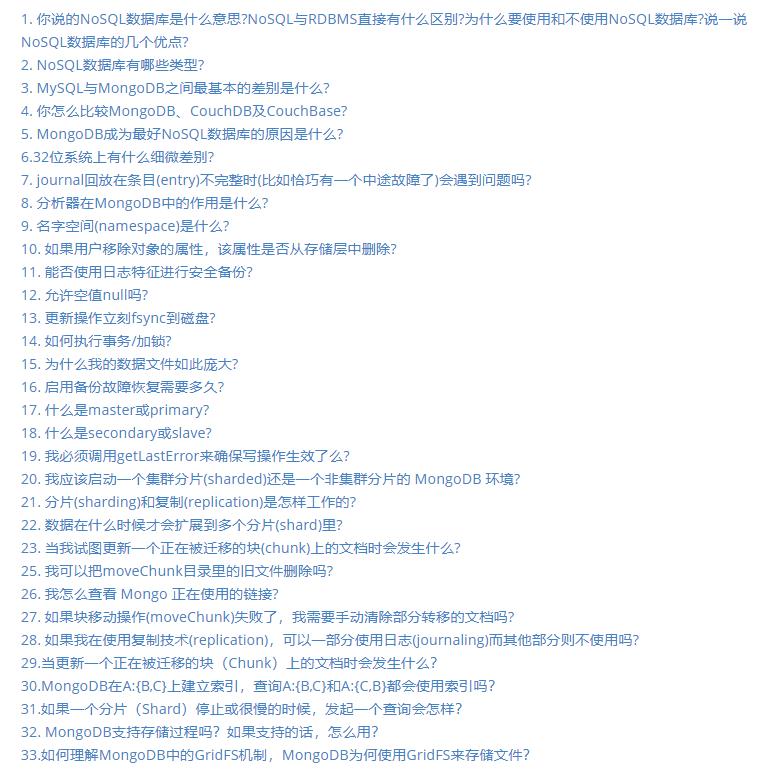

MongDB面试专题

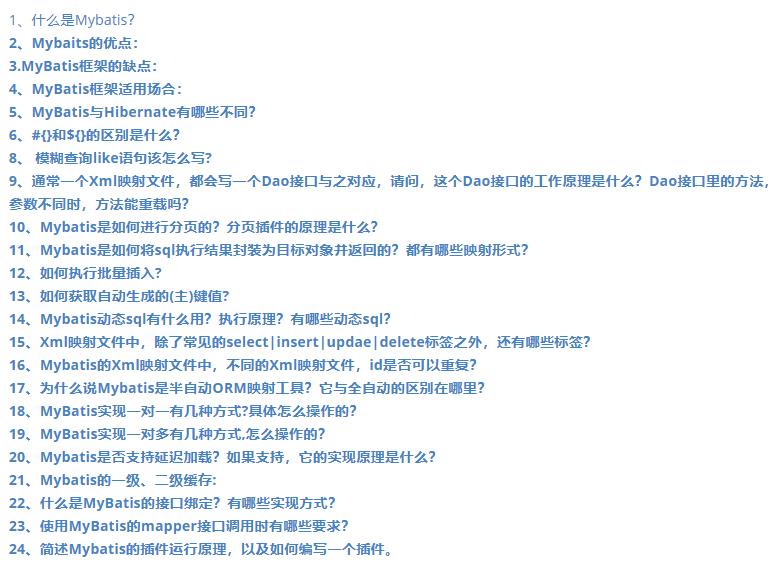

MyBatis面试专题

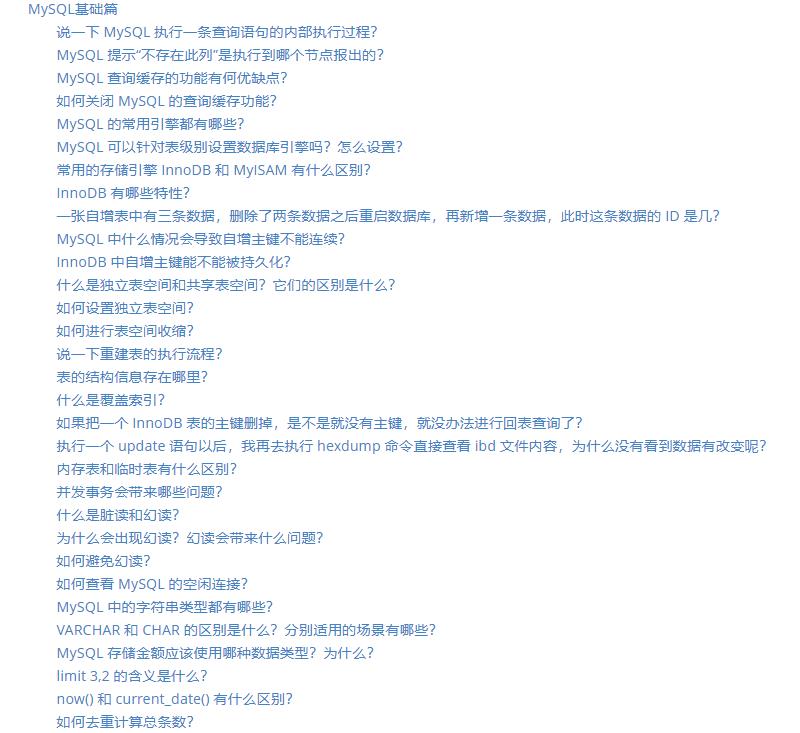

MySQL面试专题

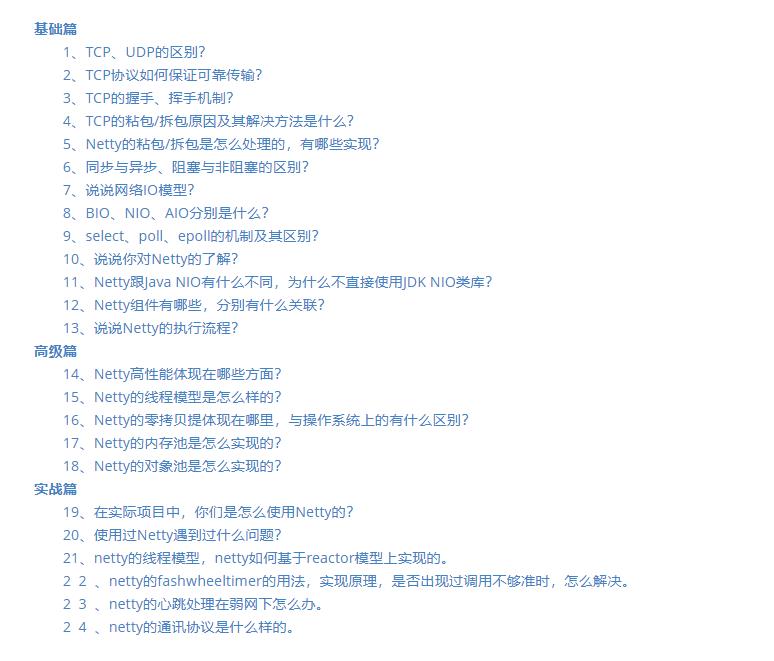

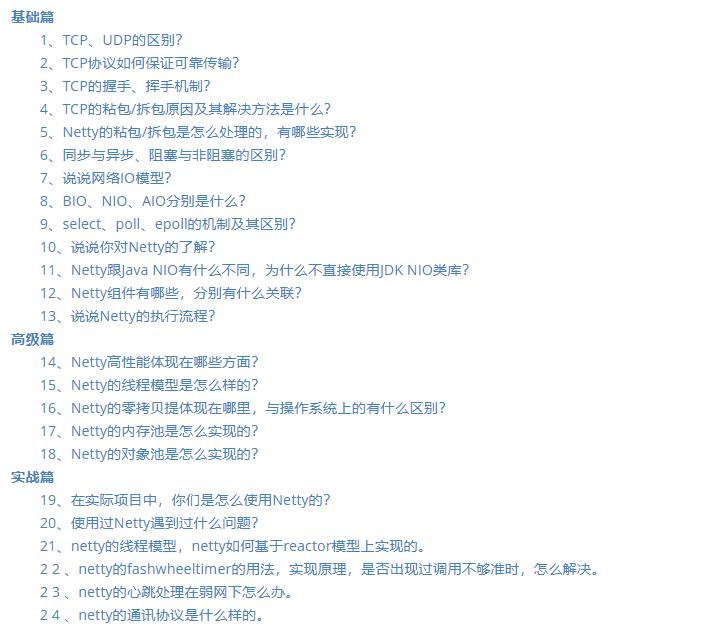

Netty面试专题

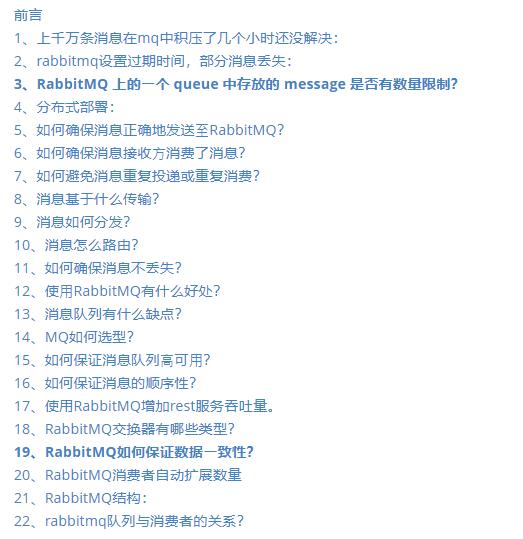

RabbitMQ面试专题

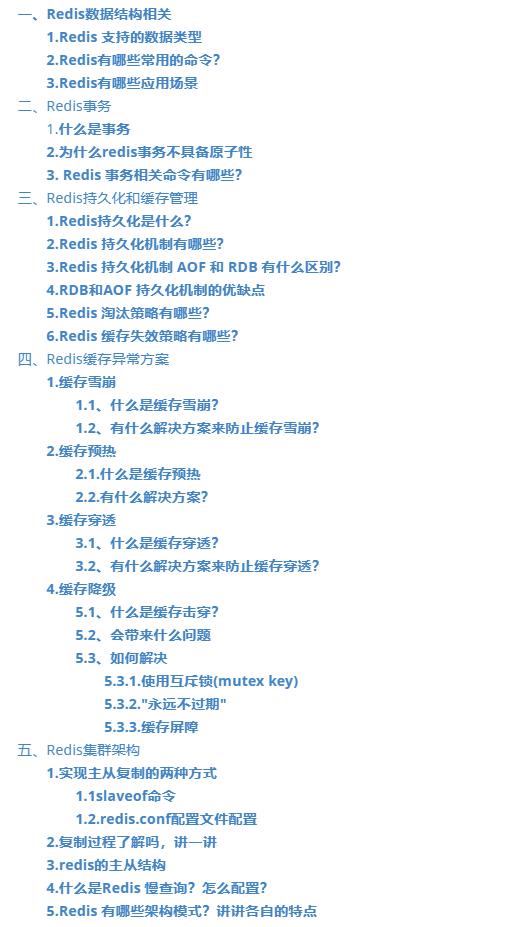

Redis面试专题

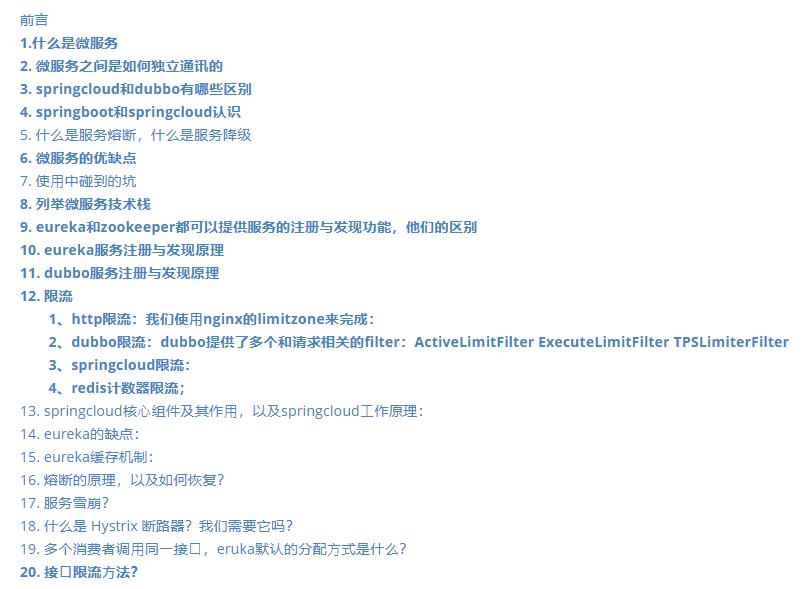

Spring Cloud面试专题

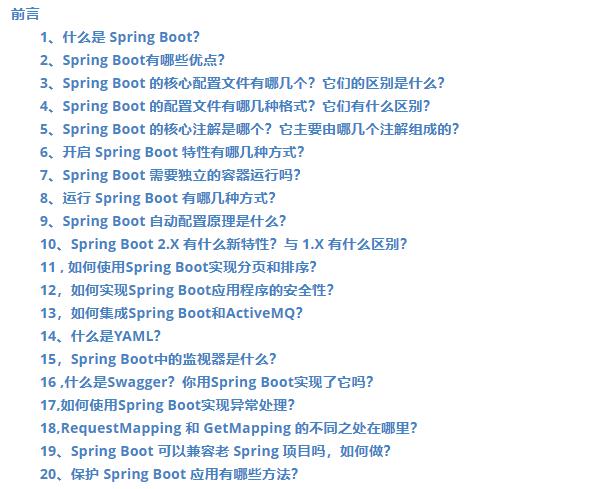

SpringBoot面试专题

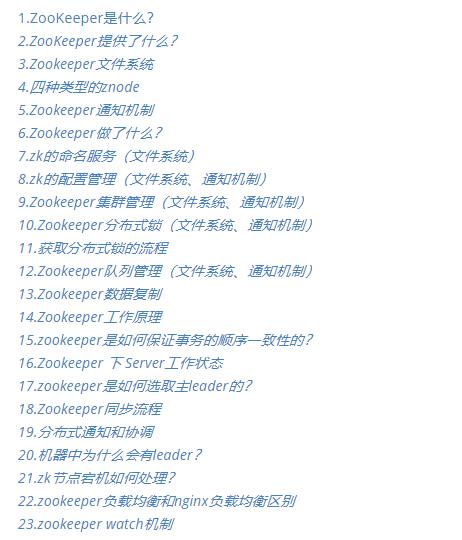

zookeeper面试专题

最后

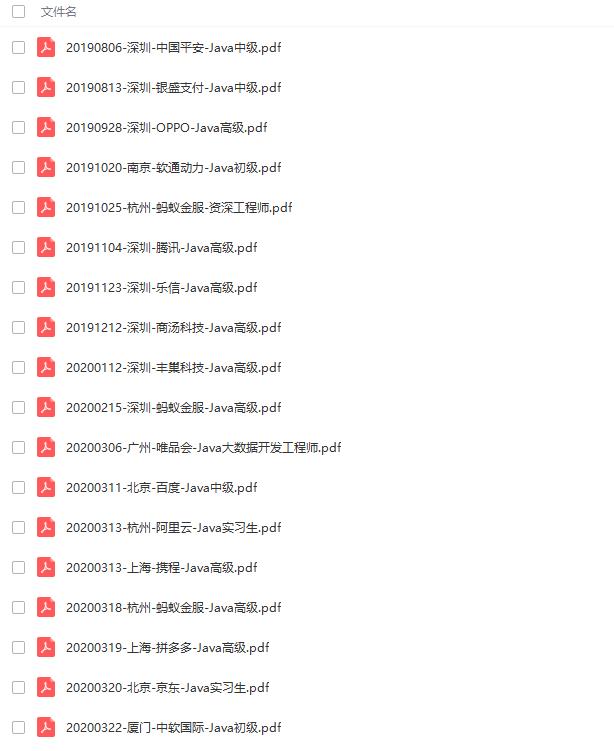

我还通过一些渠道整理了一些大厂真实面试主要有:蚂蚁金服、拼多多、阿里云、百度、唯品会、携程、丰巢科技、乐信、软通动力、OPPO、银盛支付、中国平安等初,中级,高级Java面试题集合,附带超详细答案,希望能帮助到大家。

还有专门针对JVM、SPringBoot、SpringCloud、数据库、Linux、缓存、消息中间件、源码等相关面试题。

缓存、消息中间件、源码等相关面试题。**

[外链图片转存中…(img-bEH0Uzik-1625945833772)]

以上是关于Springboot中kafka解决数据重复消费问题的主要内容,如果未能解决你的问题,请参考以下文章