人工智能之华为云5G基站有AI,智能处理流量“潮汐”

Posted ╰つ栺尖篴夢ゞ

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了人工智能之华为云5G基站有AI,智能处理流量“潮汐”相关的知识,希望对你有一定的参考价值。

一、5G 基站能否智能“省电”?

① 能耗和能效

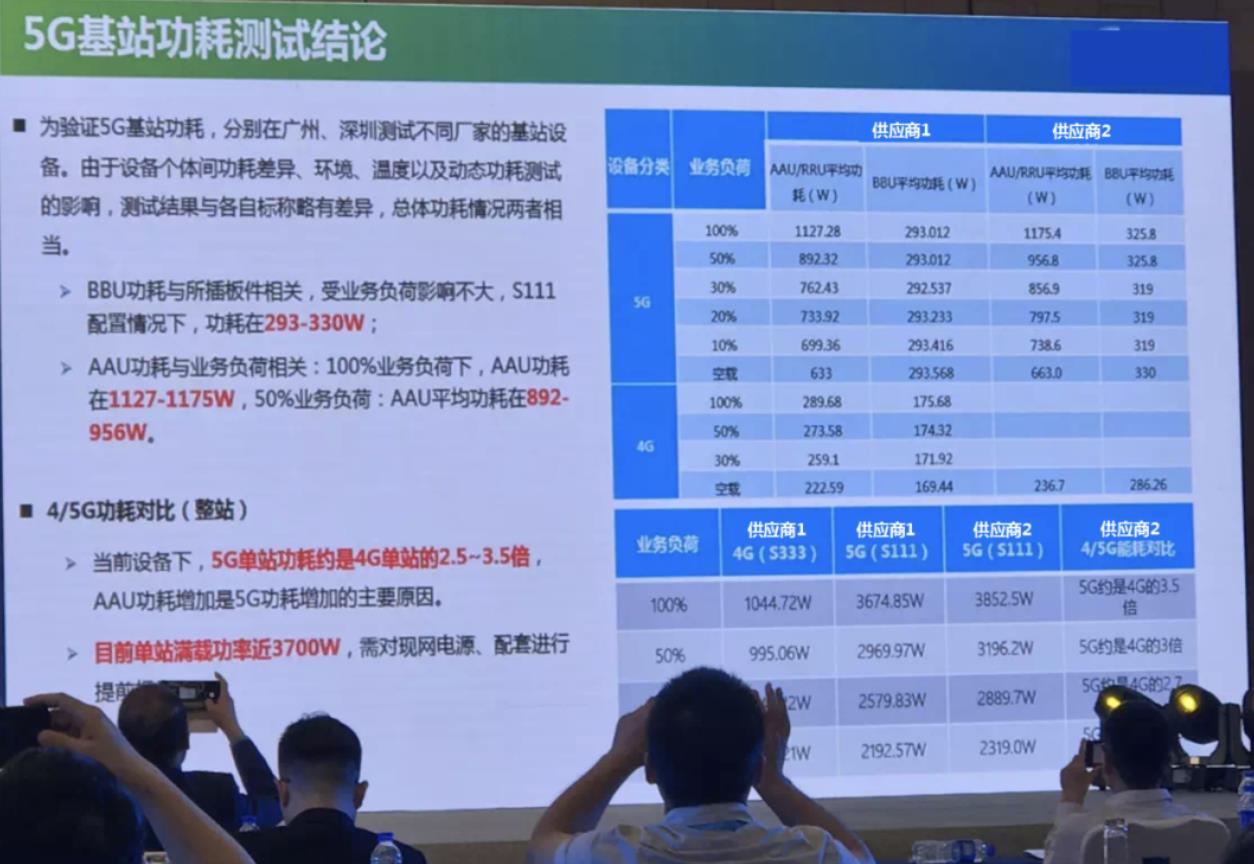

- 随着中国 5G 基站部署规模的扩大,5G 基站能耗惊人的说法甚嚣尘上,众口铄金,5G 基站似乎坐实“电老虎”的尴尬地位。如下是一张某运营商的内部流出照片,从中可以看出,5G AAU 和 4G RRU 的满载功耗相差极为悬殊,不得不承认 5G 的能耗确实远高于 4G:

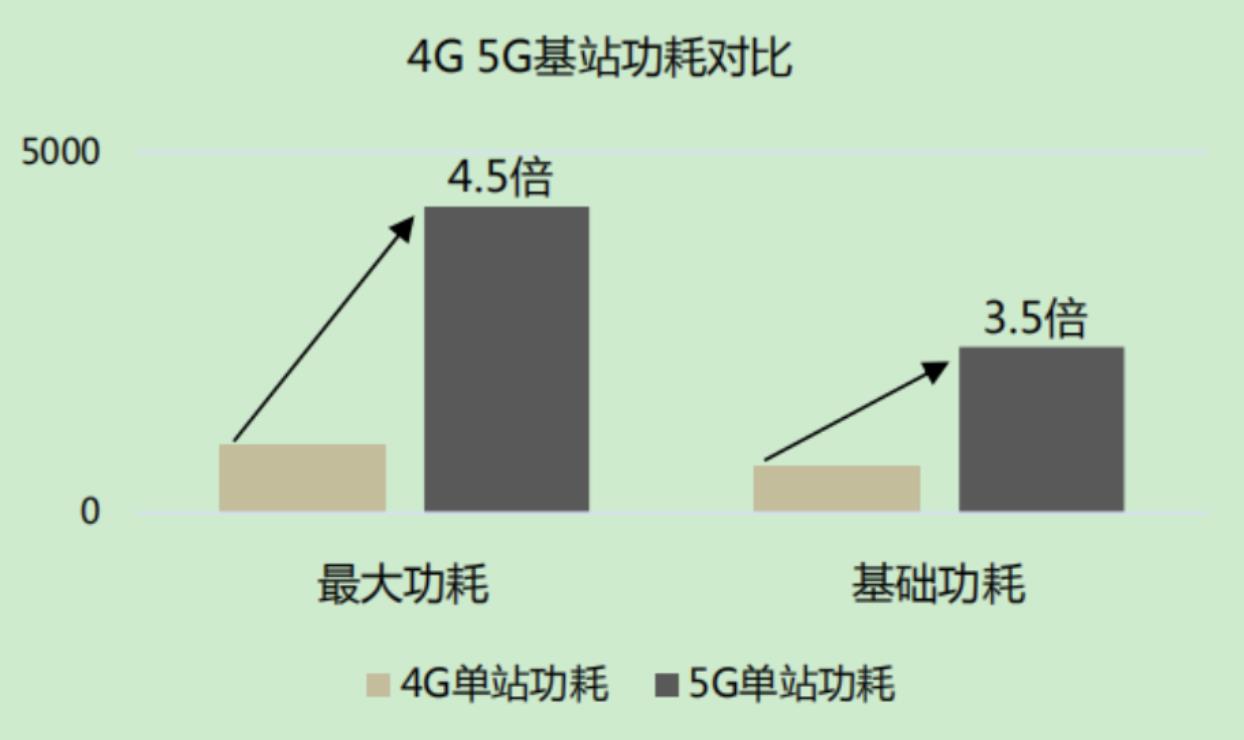

- 在移动的节能技术白皮书中,也明确地写着:“2019 年初 5G 基站功耗约为 4G 基站的 3~4 倍,高功耗是运营商大规模部署 5G 的棘手问题”:

- 联通也在其白皮书中写道:“5G 基站设备能耗在单个站点(机房)能耗比例预计将达到 50%,因此降低 5G 基站设备能耗将是未来提升无线网络能效的重要手段之一”。

- 5G 和 4G 的数据比较:

-

- 5G 的 Sub6G 频段载波带宽最大是 100MHz,而 4G 的单载波带宽仅为 20MHz,也就是说 5G 的载波带宽是 4G 的 5 倍;

-

- 主流的 5G AAU 采用大规模天线阵列,拥有 64 路数据收发通道,而 4G 设备最多也就 4T4R,仅有 4 路数据收发通道,也就是说 5G 的收发通道数是 4G 的 16 倍。

- 在上述 5G 和 4G 的比较加持之下,5G 的小区下行峰值速率可达 7.2Gbps,而 4G 的峰值速率仅为 400Mbps(0.4Gbps),也就是说 5G 小区单位时间可发送的数据是 4G 的 18 倍。

- 对于数据传输速率和能耗之间的关系,业界早有一个概念叫做“能效”,其意思就是网络对电能的利用效率,能效越高,每度电能传输的数据越多。

- 根据前面示意图中提到的数据简单算一下,便可知理论上 4G 每度电可下载 620GB 的数据,而 5G 则每度电可下载 2875GB 的数据,也就是说,5G 的能效是 4G 的 4.6 倍,因此只看能耗,不讲能效,简单地说 5G 太过耗电是不负责任的说法。但在三大运营商目前的 4G 和 5G 网络中,5G 基站的产生的数据量少,电费占比又高确实是不争的事实。

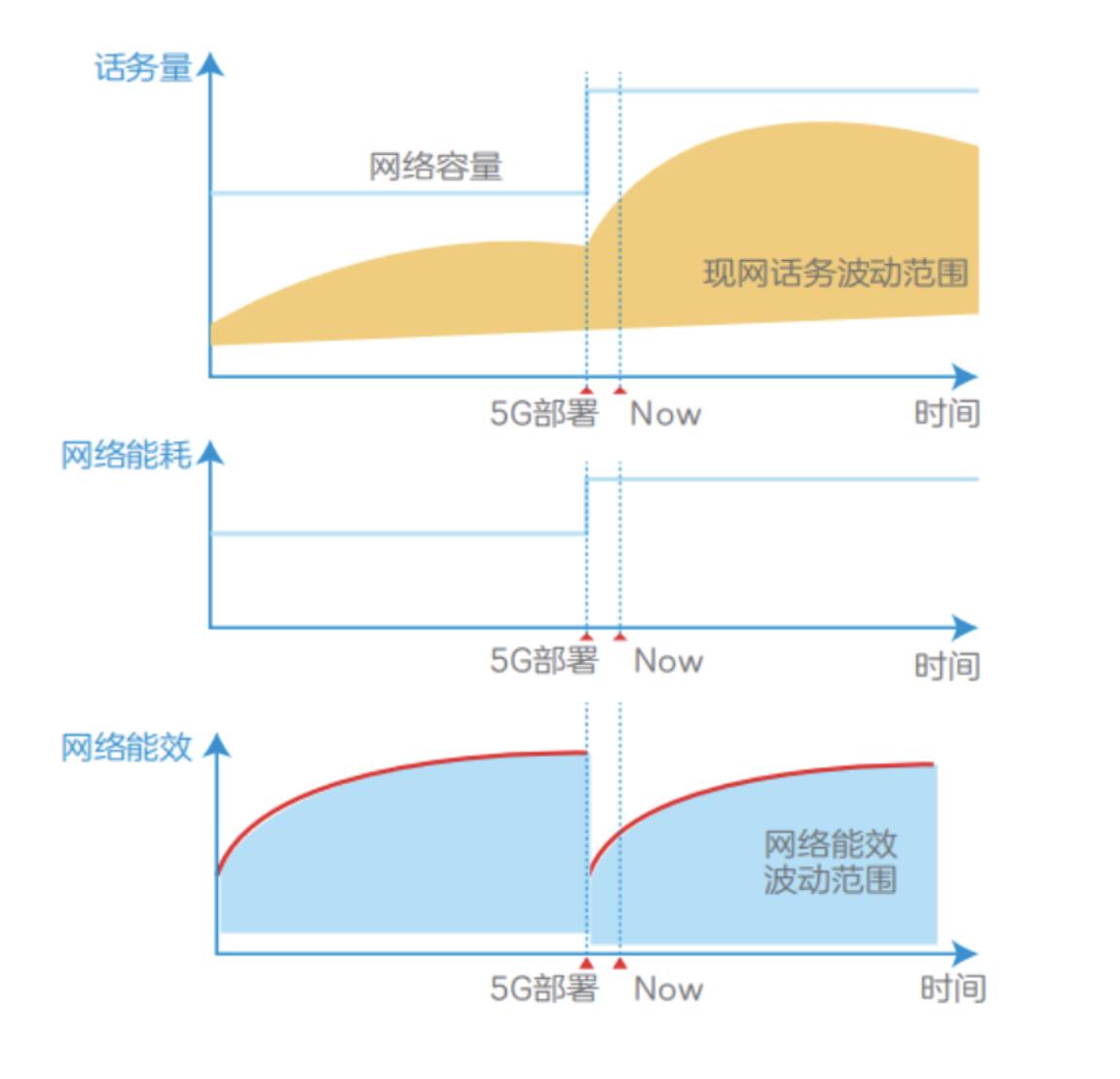

- 如下所示,在 5G 部署初期,网络的理论容量上了一个台阶,能耗也随之大涨,但话务量还没起来,导致能效处于低谷,只能眼睁睁地看着电能的流逝而创造不了应有的价值:

- 因此,确实需要降低 5G 网络能耗,毕竟运营商数据业务增量不增收的窘境由来已久,成本能省一点是一点,何况这 5G 的流量也还没增起来。

② 网络耗电情况分析

- 运营商的成本大体上分为两大块:资产支出和运营费用,资产支出就是运营商用来买设备的钱,运营费用就是维护网络正常运转所支出的费用,电费当然属于运营成本的一部分。

- 运营费用包罗万象,占比多的有营销费用,网间结算,人力成本,站点租金,设备维护等,其中电费约占 15% 到 30%,不同运营商的数据都不尽相同。

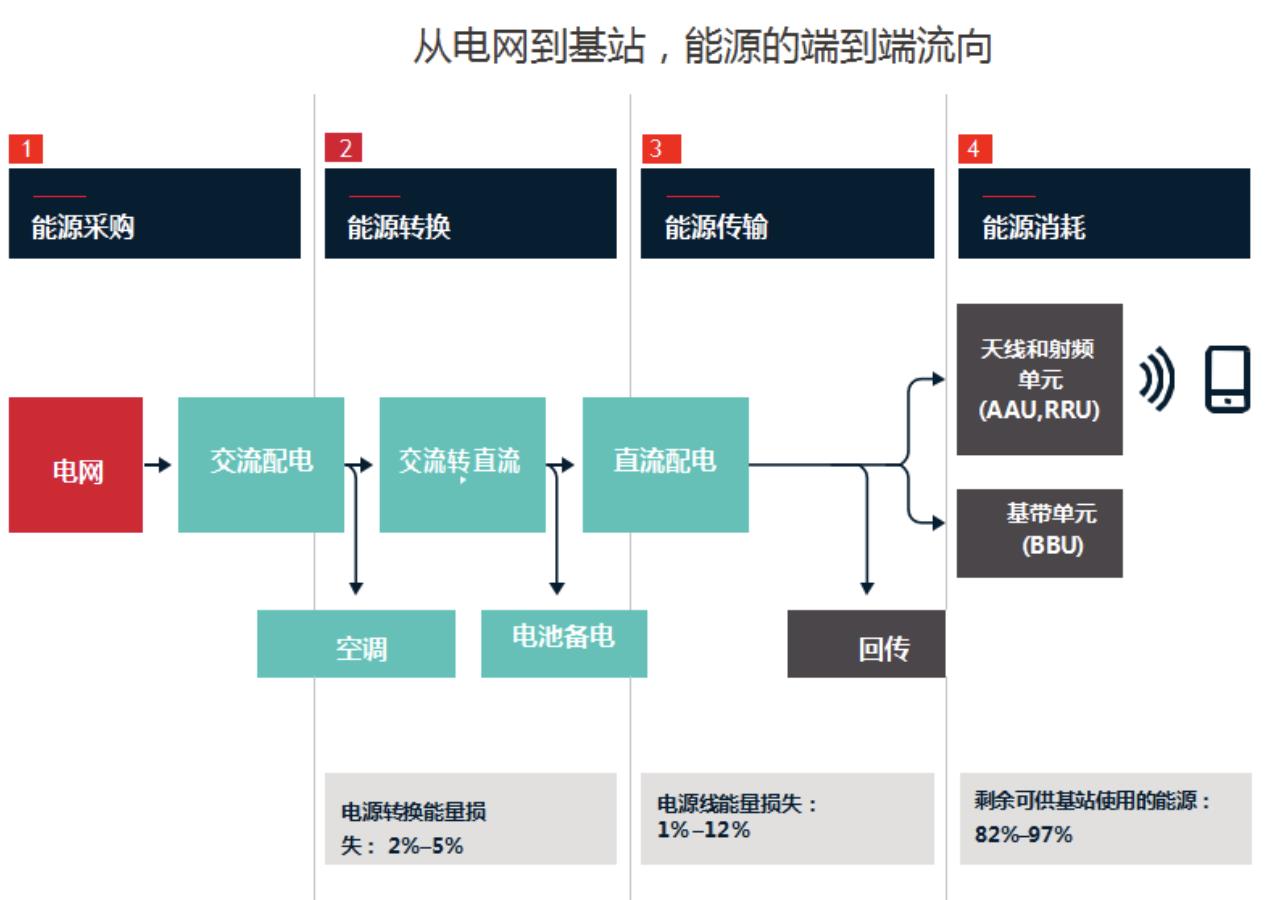

- 首先,运营商从电网取得交流电,但机房里绝大多数的设备都无法直接使用交流电,因此需要通过整流器,把交流电转换为直流电。在这个过程中会有 2% 到 5% 的能量损失。

- 然后,直流电需要通过电源分配模块,把输入的电源分到机房内的多个设备上去,比如 BBU 一路电,每个 RRU 各一路电,一般每个站点都会有一个 BBU,以及 3 到 9 个 RRU,这个过程中会有 1% 到 12% 的能量损失。

- 最后,剩余的 82% 到 97% 的电能被传送到基站的 BBU 和 RRU(或者 AAU),以及传输设备来驱动数据处理和传输,之后一部分化作天线的信号发射出去和手机通信,大部分则成为热耗消散于无形,如果热耗导致机房温度过高,还需空调降温,使机房的能耗更高。

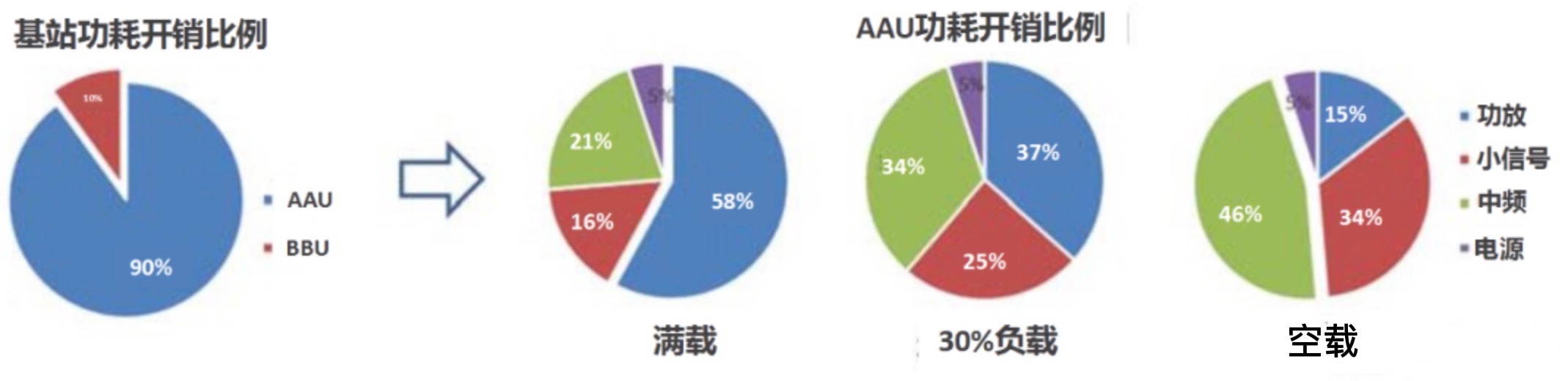

- 基站设备是机房的核心,也是最关键的耗能设备,其内包含基带单元(BBU)和射频单元(5G AAU), 其中射频单元(AAU)约占整个基站能耗的 90%,是不折不扣的耗电大户。

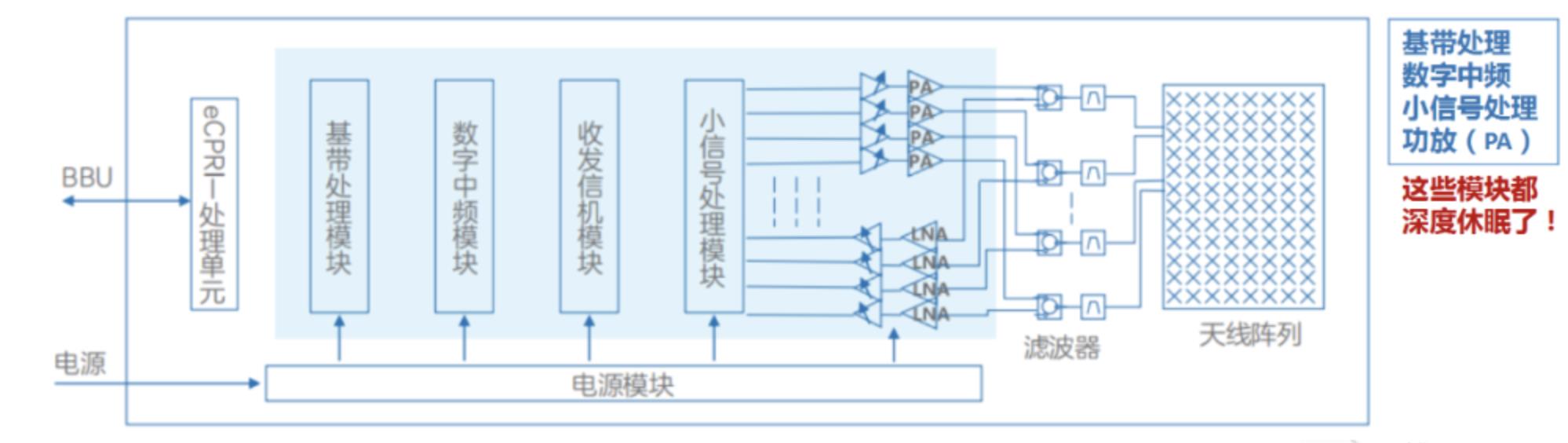

- BBU 的功耗占比为 10%,且其功耗比较稳定,一般与基站的话务量关系不大,而 AAU 的功耗则和站点的负荷密切相关,流量越大,功耗越高。如下所示,AAU 中的耗能大户是功放,小信号处理,及中频这几个模块,功放是其中最关键的耗能器件,且负荷越高,功放的耗能占比越高:

二、日出而作,日落而息:基站变“聪明”了?

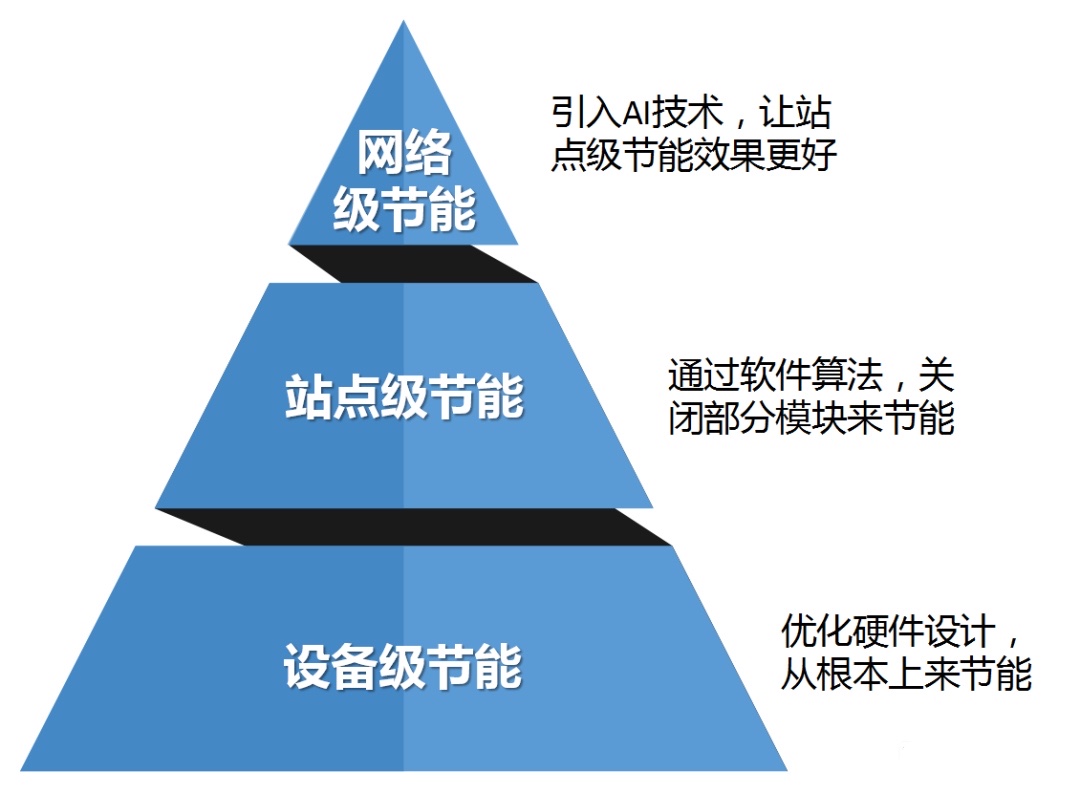

- 要实现基站节能效果,不但需要从硬件上提升,还要从软件上优化,必要时引入大数据和人工智能来辅助,可分为设备级,站点级,网络级这三个节能层次:

① 设备级节能

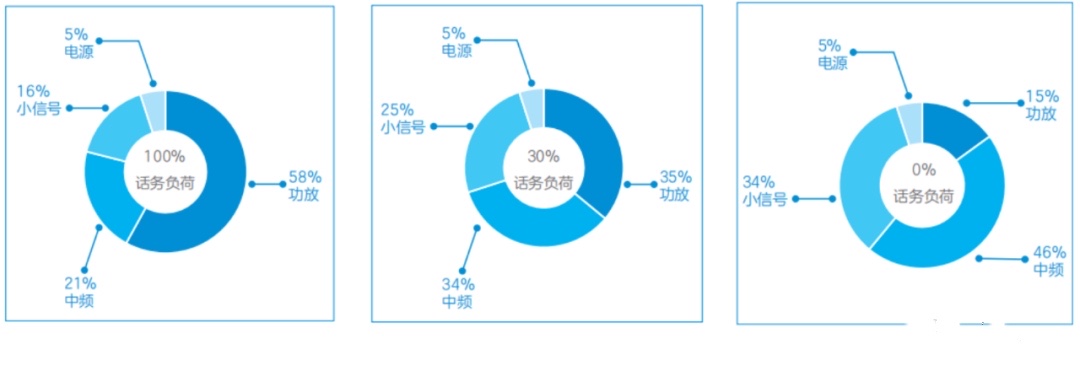

- AAU 内部各个模块在不同负荷下的能耗占比:

- 要让基站设备的能耗更低,首先得从“芯”开始。不断引入高集成度、高性能基带处理、数字中频处理芯片,配合使用高集成度收发信机,来让这些模块把基础能耗降下来。最直接的办法就是,芯片的制程工艺从 28nm,14nm 向 10nm,7nm 升级,再向 5nm 发起冲击,只为缩小面积,提升集成度,增强性能降低功耗。这还远不够,更重要的是需不断提升功耗的扛把子器件——功放的工作效率。

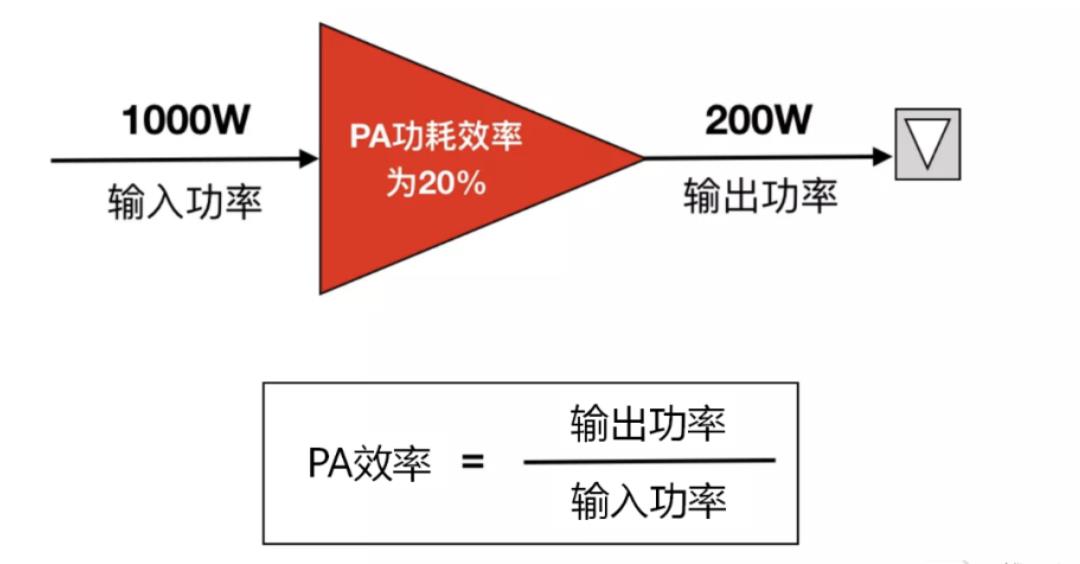

- 功放的全称是功率放大器(英文是 Power Amplifier,简称 PA),其作用是把上级模块处理过的信号功率放大,之后才能使用天线往外发射。AAU 有一个非常重要的指标,就是发射功率,一般在 200 到 300 多瓦,这一切的实现大都是功放的功劳。功放的核心指标则是“功放效率”,算法很简单,就是用功放的输出功率除以输入功率,再换算成百分比。

- 如下图为例,功放的输入功率为 1000W,最终输出 200W 的发射信号,可计算得出:功放效率为 20%,这个值是非常低的,为获得 200W 的信号功率,产生 800W 的热耗:

- 业界通过坚持不懈的努力,采用氮化镓等新材料,并不断优化算法,最终让 AAU 内的功放效率提升到 50% 以上。通过上述这些努力,可大幅降低设备的硬件本身的工作能耗,下来的站点级节能,就是要通过软件算法来在空闲时间优化或者关闭部分模块,更进达到更近一步省电的目的。

② 站点级节能

- 站点级节能在设备级节能的基础上,通过软件算法,在网络空闲时段关闭站点内的部分器件来实现节能效果。

- 站点级节能主要包含功放调压,符号关闭,通道关闭,小区关闭,深度休眠等技术。

(A)功放调压

- 功放的工作电压在和它的输出功率相匹配时,效率才能达到最优。一般来说,功放的工作电压是为了满足最大机顶功率而设计的。

- 但在实际应用中,往往射频模块的输出功率并未完全使用,或者在闲时关闭了部分载波,从而不需要功放输出最大功率。这样一来,功放就无法工作在最高效率的状态。

- 因此需要灵活地调整功放的工作电压,让功放尽可能地工作在高效率状态,从而达到节能的目的,这就是“功放调压”技术。

- 功放调压技术在 2G,3G 和 4G 阶段已经被广泛应用,主要用于 RRU 的节能,在 5G 时代可以继续发挥作用。

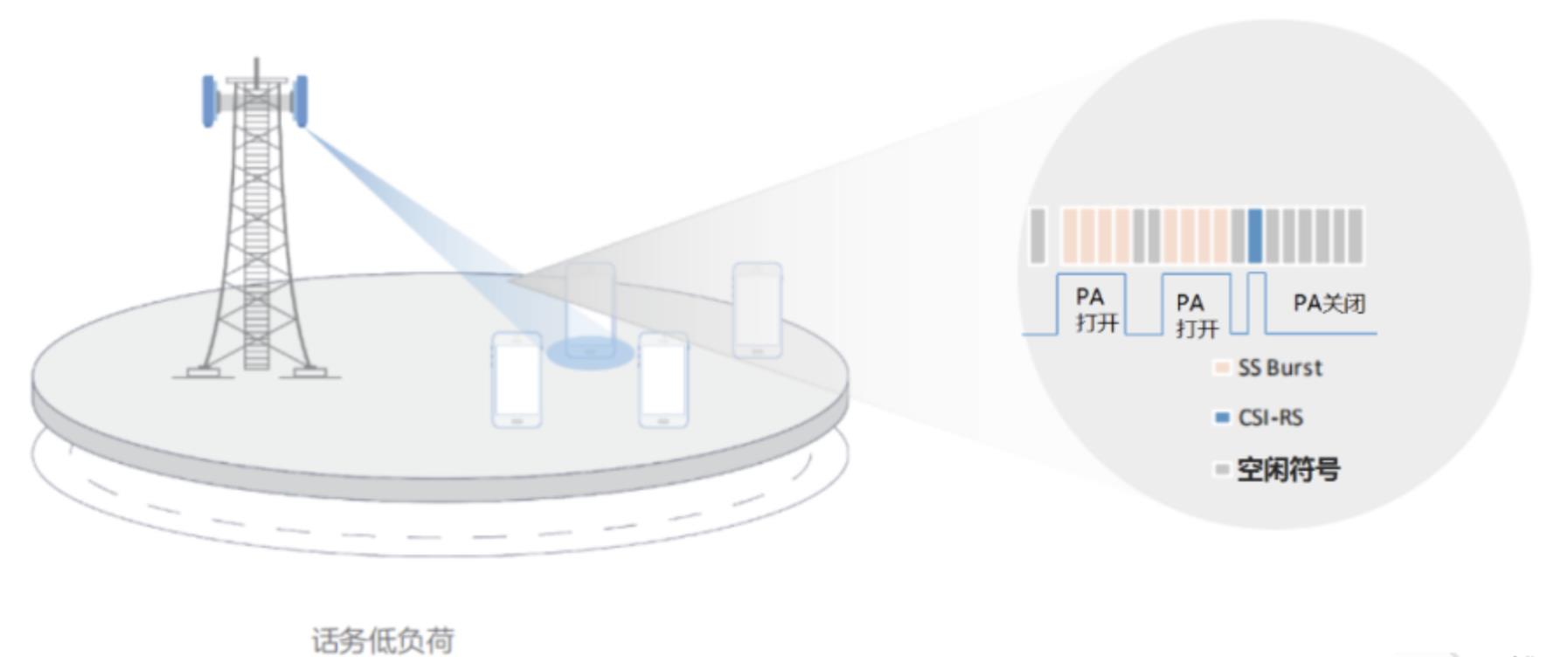

(B)符号关闭

- 在网络运行中,不可能总是处于大流量状态,总是有的时候忙一些,有的时候闲一些,这就为我们提供了节能的机会。

- 以 Sub6G 频段,子载波间隔 30KHz 的 5G 小区为例,其一个时隙的时长是 0.5 毫秒,内含 14 个符号,每个符号 0.357 毫秒,如果某个符号没有用户需要发数据,那么就把功放关闭,到下一个符号时再打开。

- 这个功能在实现时还可以更主动一些,那就是网络尽可能地把大部分用户的数据都攒到同一个符号(同一时间)上发送,这样其他时隙关闭的概率就大了很多。

- 虽然符号关闭看起来不起眼,关闭一个符号,才多大点时间,能省多少电?但积少成多,还是可以达到相当的省电效果的。

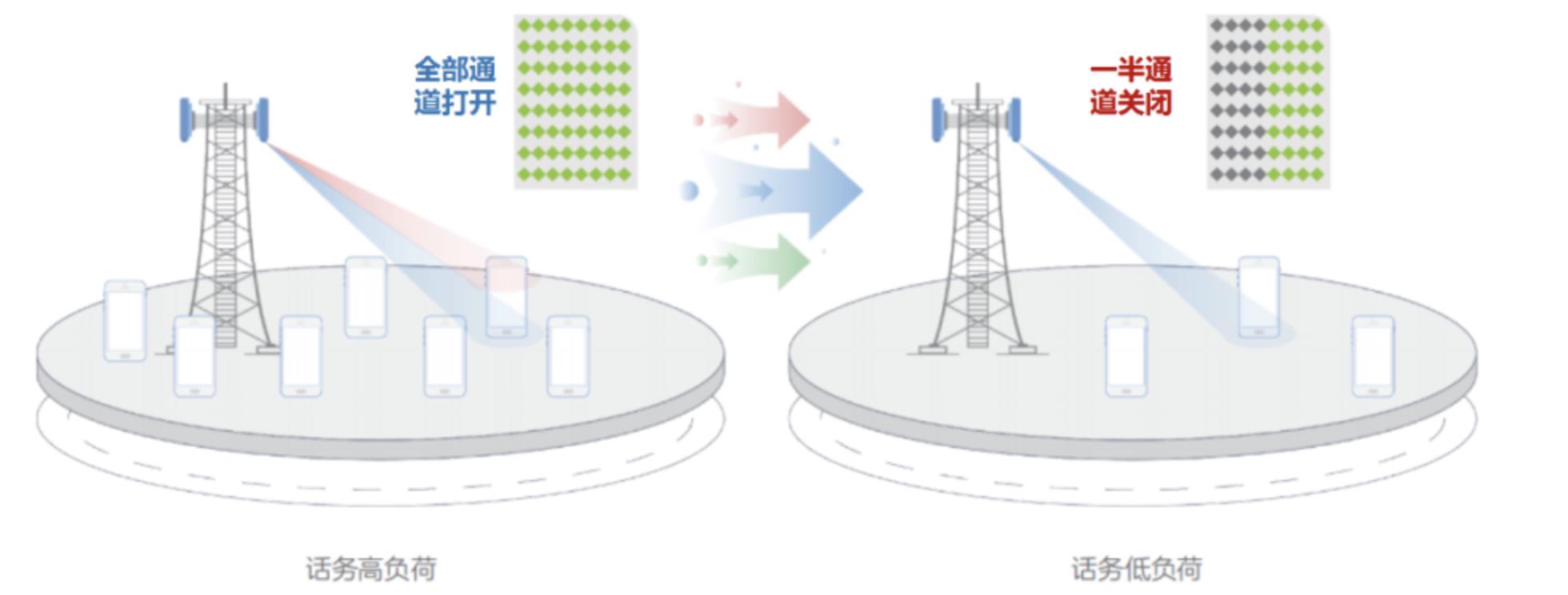

(C)通道关闭

- 5G AAU 的核心技术是 Massive MIMO,由大量的天线振子组成,内部可支持多达 64 个功放,实现 64 通道的信号发射。

- 在早晚高峰期,多个用户都在用手机进行大流量业务,64 个通道的 AAU 可提供多达 16 路数据独立发射,小区容量非常高。但到夜深人静的时候,网络基本没什么人用,这 64 通道却还在孜孜不倦地工作,这样确实太费电。

- 因此,可以随着话务量的降低,逐步关闭 AAU 内的部分通道,比如从 64 通道降低到 48 通道,再降低到 32 通道乃至 16 通道,来达到省电的目的。

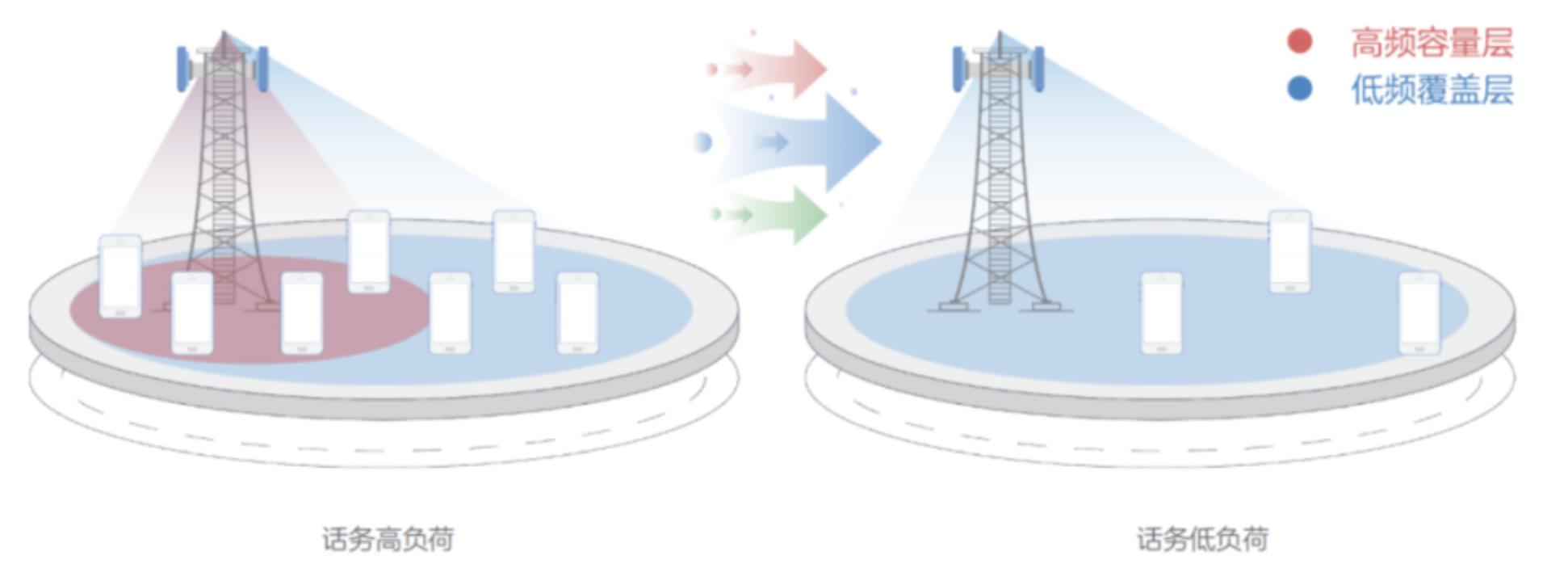

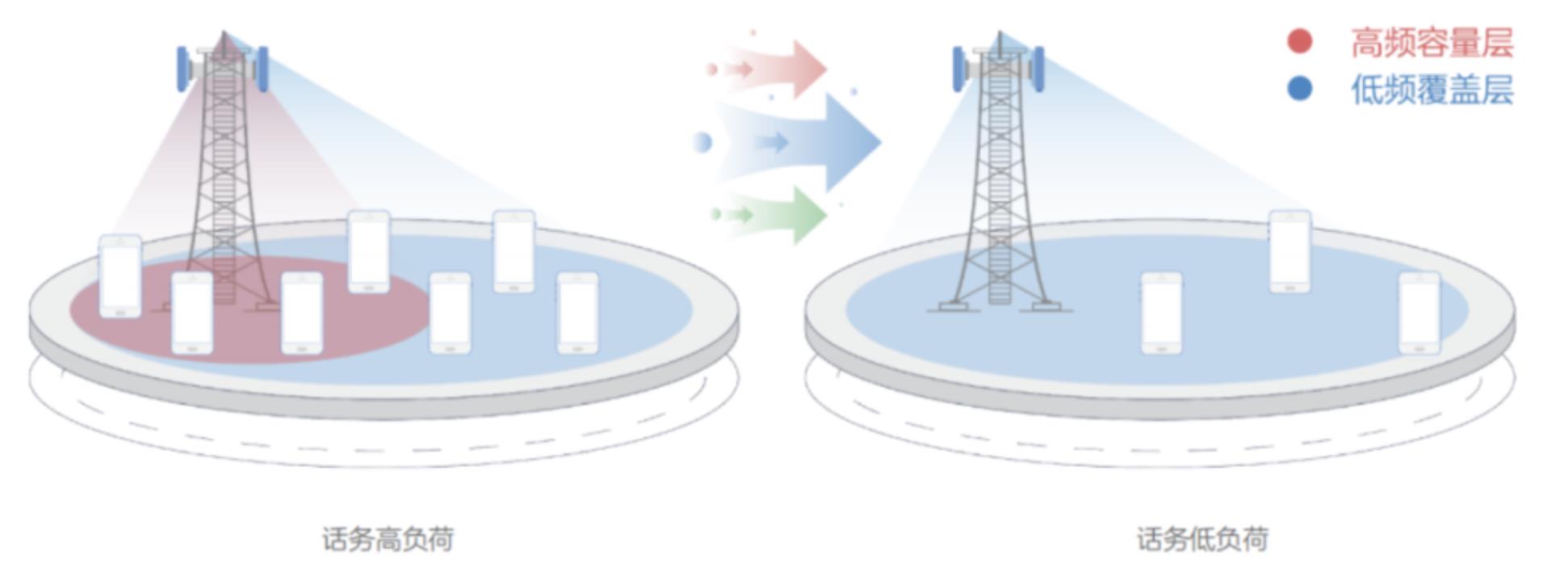

(D)小区关闭

- 一般来说,一张无线通信网都是由 900M,1800M,2100M,2600M,4900M 等多个频率层,以及 2G,3G,4G 和 5G 等多种制式组成的多频多模网。

- 低频段由于传输损耗小,穿透能力强,一般用作连续覆盖层。而高频段一般带宽较大,但覆盖性能不佳,一般用作容量层。

- 因此,在低话务时段,网络非常空闲,可以干脆关闭高频网络层小区,只使用低频小区来提供基础覆盖。

- 在 NSA 场景下,4G 小区频段低,属于覆盖层,而 5G 小区频段高,属于容量层,用来进行热点覆盖补充。

- 到了低话务时段,反正没有什么人用,可以把 5G 小区直接关闭,4G 小区提供的覆盖和容量也足以满足全部业务使用。

(E)深度休眠

- 5G 小区关闭之后,AAU 就可以进入深度休眠模式,直接沉睡过去,实现极致省电。

- 如下图是 AAU 的内部结构图,可以看出,在进入深度休眠模式之后,基带处理,数字中频,小信号处理,以及功放模块这些耗电大户都被关闭,只保留电源模块和 eCPRI 接口单元醒着随时待命。

③ 网络级节能

- 上面的站点级节能技术已经很牛逼了,那么哪些站点可以开通节能?在什么时间段开启效果好?各种节能功能关这关那的,大量的参数该如何配置优化才能不影响下网络性能?要回答上述问题,就需要对整网大量站点的容量,负荷,话务趋势,参数配置进行大量的分析,才能确定可以开哪些节能功能,什么时间开启,以及参数如何设置。

- 即便如此,为保障网络 KPI 不恶化,节能功能的开通及参数配置往往都是非常保守的,最终取得的节能效果必然大打折扣。在这个大数据和人工智能起飞的时代,无线通信的大量用户无时无刻都在网络中产生海量的数据,非常适合于大数据的应用和人工智能(Artificial Intelligence,AI)的实施。

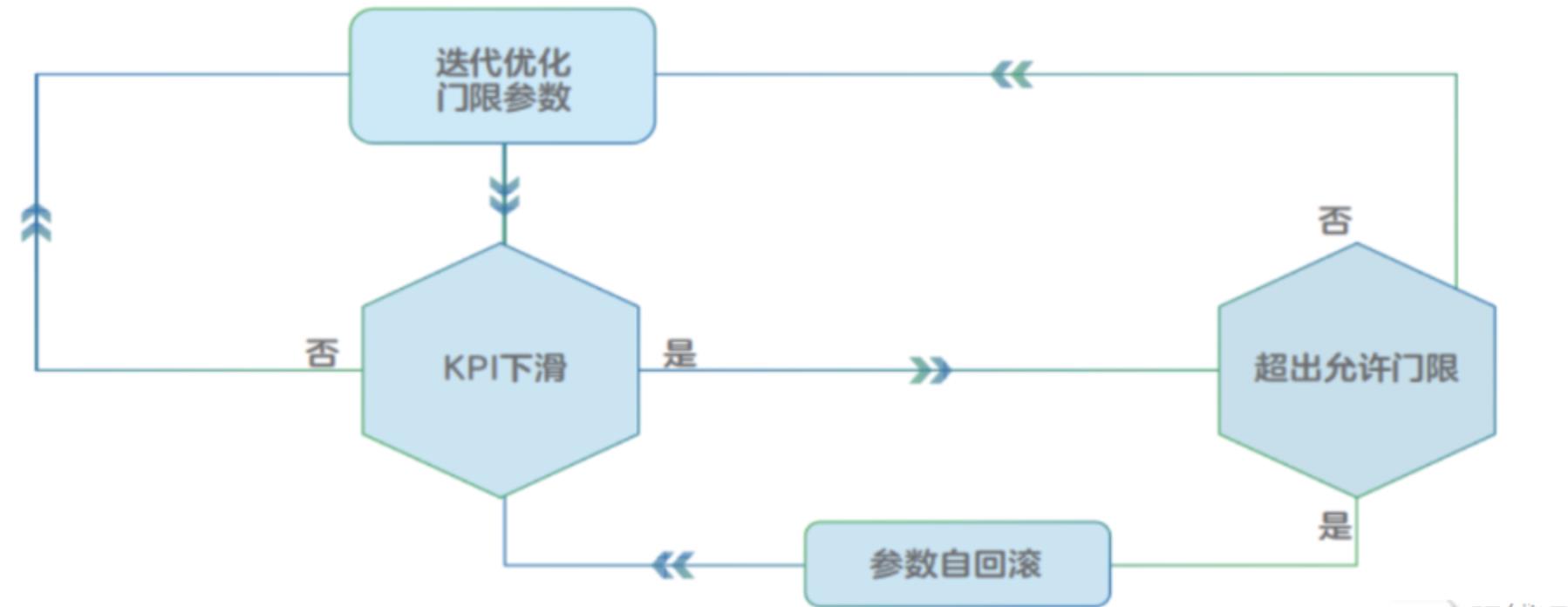

- 因此 5G 的网络节能也需要搭载 AI 技术,让话务预测,节能策略分析,参数优化,效果评估的循环自动化,智能化,从而脱离脱离低效的人工干预。

- 如下所示,AI 节能系统在初始数据设置完成之后便开始执行,如果节能生效且网络 KPI 在可接受范围,则进一步优化节能参数并试图获得更佳的节能效果,如果 KPI 恶化,则要把节能参数撤回之前的版本,如此循环往复,最终使网络中的所有站点达到最佳的节能状态:

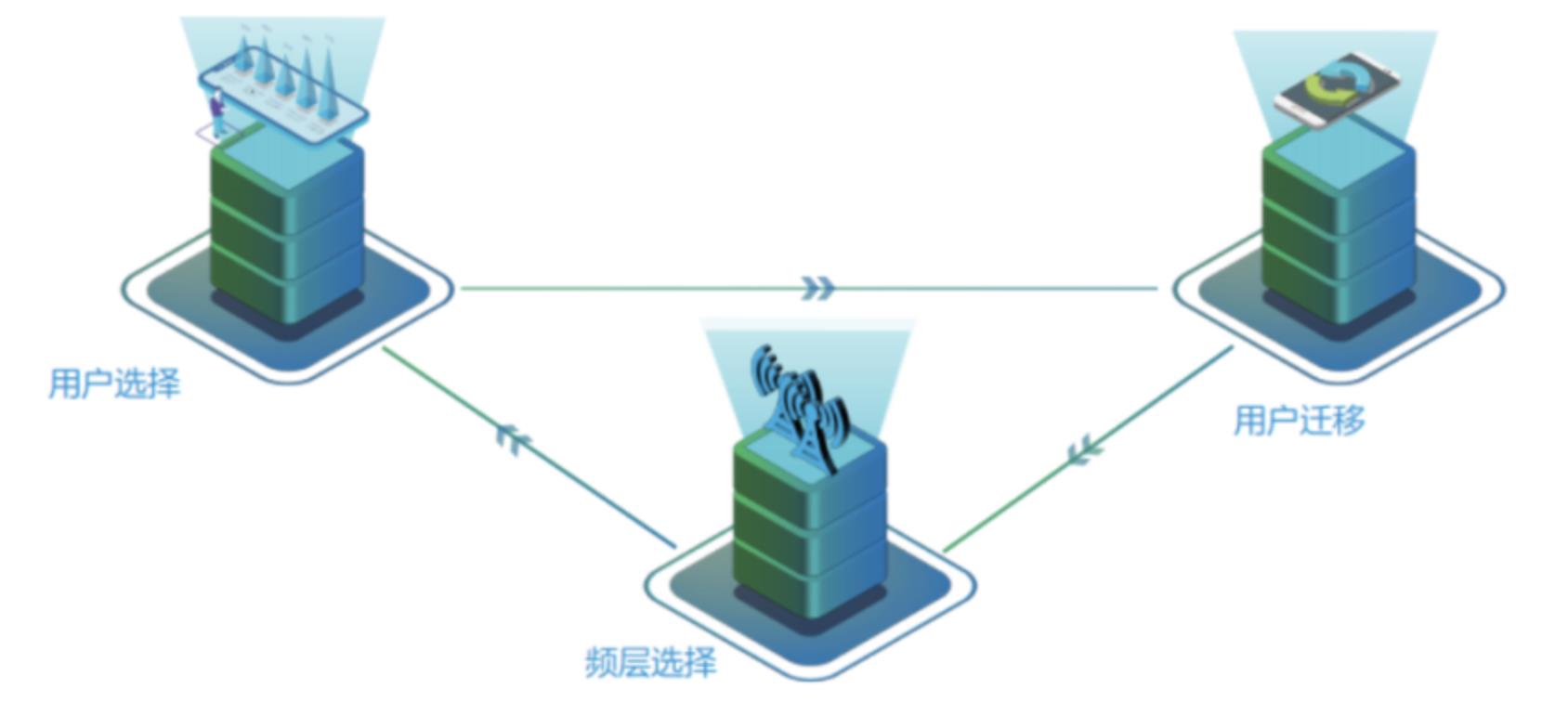

- 这一切操作,都是由机器自动完成,从而把人从纷繁负责的低效工作中解脱出来。更进一步的,AI 还可以不断分析用户的行为,判断用户正在进行的业务对网络能力的需求,自动把用户分流到合适的频率和制式。

- 夜深人静时,某几个用户在 5G 小区下,但也就是用微信在聊天,这并不需要使用 5G 网络,4G 完全可以满足需求。于是,网络主动把这些用户迁移到 4G 小区,从而让 5G 小区完全空闲,然后 5G 基站就可以关闭并进入深度休眠状态,从而达到省电的目的:

④ 终端级节能

- 对于普通用户来说,对运营商的基站费不费电并没有直观的感受,只需要上网速度快体验好,同时手机的电量能扛就行。

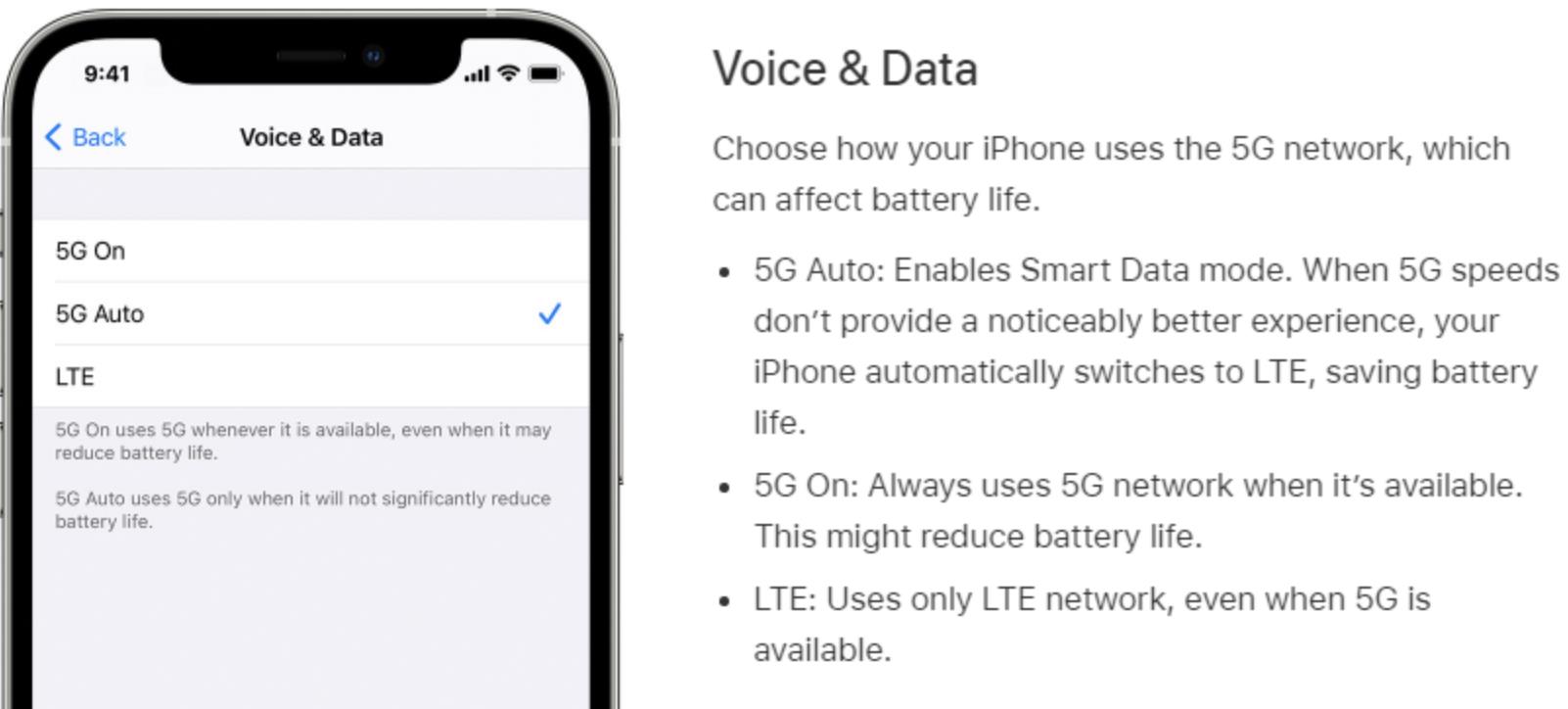

- 例如,苹果就在 iPhone 12 上新增了一个叫做“智能数据模式”的功能,在手机的设置界面叫做“5G Auto”:当用户使用需要更高速率的应用程序时,设备将从 4G 切换到 5G;反之,当较低速率完全能满足要求时,连接将自动从 5G 切换到 4G,这样能最大化电池的使用时间:

- 5G 基站节能降耗,对运营商来说,不单是降低成本,更是一个企业降低碳排放,扼制全球变暖的社会责任所在。而普通用户,也是节能降耗中关键的一环,业界的一切努力,都是为了以最高的能效,向每一个用户提供最好的服务。

三、如何智能处理流量“潮汐”?

① 神经网络预测训练

- 神经网络预测控制(Neural NetworkPredictive Control),人脑是一个高度复杂的、非线性的并行信息处理系统,模仿人脑的工作机理建立起来的人工神经网络具备较强的非线性输入输出映射能力。如果将人工神经网络应用于预测控制,即形成神经网络预测控制(Neural Network Predictive Control),简称 NNPC。

- 神经网络在处理非线性问题方面有着别的方法无法比拟的优势,而预测控制对于具有约束的卡边操作问题具有非常好的针对性,因此将神经网络与预测控制相结合,发挥各自的优势,对非线性、时变、强约束、大滞后工业过程的控制提供了一个很好的解决方法。

- 人工神经网络(Artificial Neural Network,简称 ANN)可以概括的定义为:由大量简单的高度互连的神经元所组成的复杂网络计算系统。它是智能控制技术的主要分支之一,是以现代神经科学研究成果为基础提出的,神经网络反映了人脑功能的一些基本特征,是模拟人工智能的一个很重要的方法。一般形式的神经网络就是对人脑完成特定任务或感兴趣功能的方法进行建模的机器。人工神经网络既可以用硬件实现,也可以用软件实现;既可以看做一种计算模式,也可以看做一种认知模式。因此,从本质上讲,人工神经网络、并行分布处理、神经计算机是同一概念。在控制领域,神经网络扮演着一个极其重要的角色,随着神经网络理论研究的不断成熟与完善,神经网络已经用于控制领域的多个方面,如过程控制、生产控制、模式识别、决策支持等。

- 预测控制,即模型预测控制,是以各种不同的预测模型为基础,采用在线滚动优化指标和反馈自校正策略,力求有效地克服受控对象的不确定性、迟滞和时变等因素的动态影响,从而达到预期的控制目标—— 参考轨迹输入,并使系统具有良好的鲁棒性和稳定性。因此,预测控制的系统组成大致包括:参考轨迹、预测模型、滚动优化、在线校正等四个部分。

- 神经网络具有函数逼近能力、自学习能力、复杂分类功能、联想记忆功能、快速优化计算能力,以及高度并行分布信息存贮方式带来的强鲁棒性和容错性等优点。将神经网络与模型预测控制相结合,为解决复杂工业过程的控制,提供了强有力的工具。

- 从本质上讲,神经网络预测控制还是预测控制,属于智能型预测控制的范畴,它将神经网络技术与预测控制相结合,弥补了传统预测控制算法精度不高、仅适用于线性系统、缺乏自学习和自组织功能、鲁棒性不强的缺陷。它可以处理非线性、多目标、约束条件等异常情况。

② LSTM 预测流量

(A)什么是 LSTM ?

- LSTM 全称 Long Short-Term Memory,中文译义“长短期记忆”,是一种循环网络,值得注意的是 Long Short-Term Memory 中的 - 是放在 Short 与 Term 中间的,相比较于 Simple RNN,LSTM 在长的时间序列中有着更好的表现。

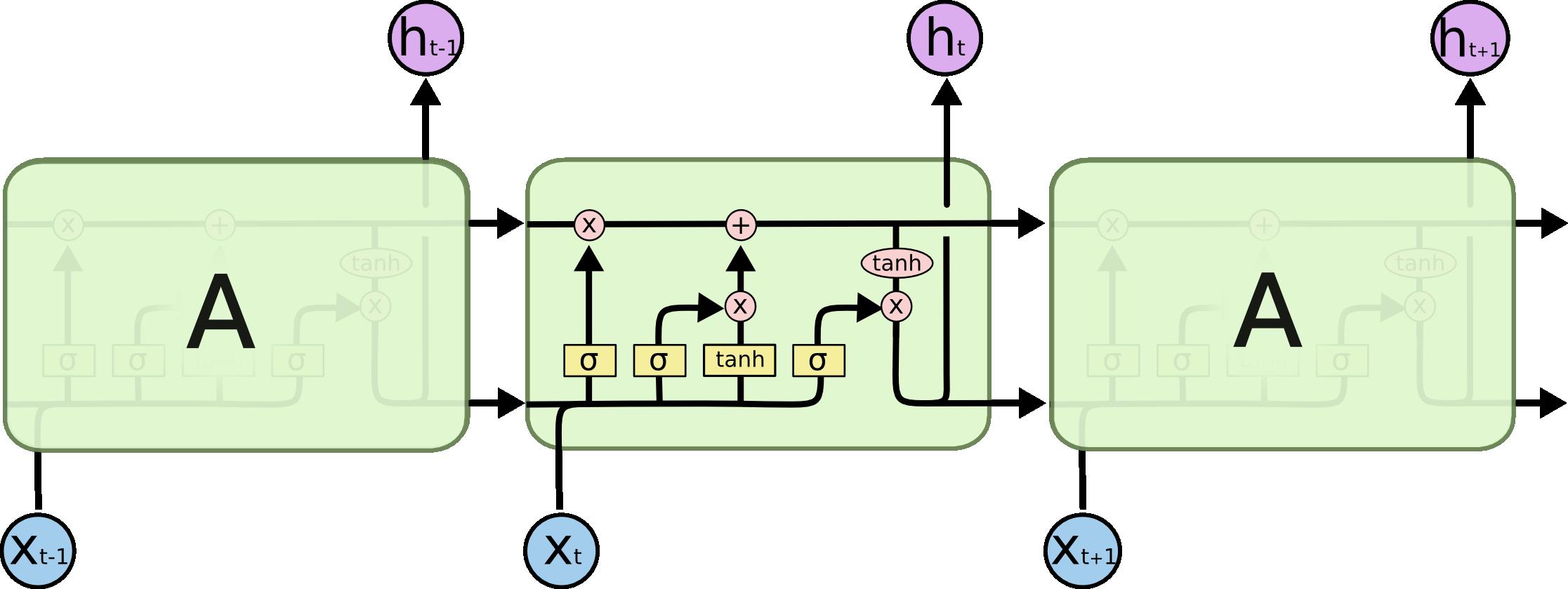

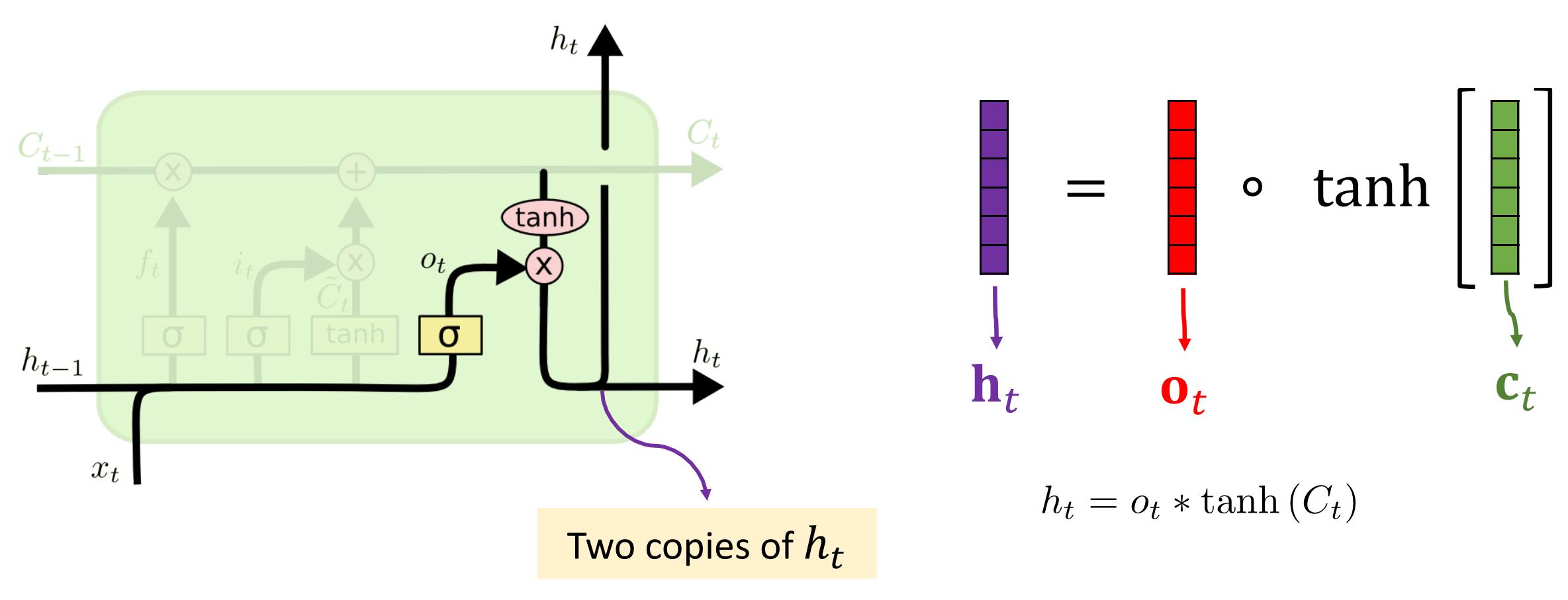

- LSTM 的结构示意图如下所示,被重复的单元称之为细胞(Cell),也就是图中绿色的框:

- 结构图中所出现的符号:

-

- Neural Network Layer:代表的是神经网络,中间的 𝜎 或者 𝑡𝑎𝑛ℎ 代表的是其激活函数;

-

- Pointwise Operation:表示逐点操作;

-

- Concatenate:表示将两个矩阵连接起来。

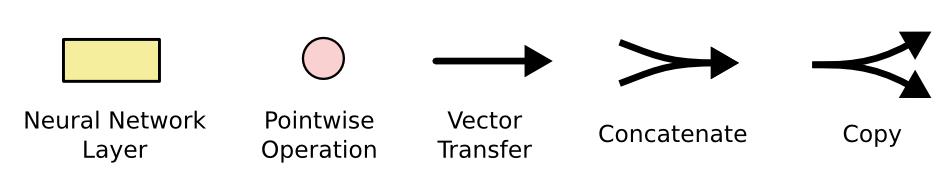

- Celle State 是 LSTM 最关键的部分,它类似一条传输带,贯穿 LSTM 整个部分(可以形象地理解为主要矛盾)。例如:当我们分析一部小说主题的时候,肯定不会一个字一个字地分析,我们会抓住主要矛盾,分析小说中的主要情节矛盾,然后判断一部小说的主题。

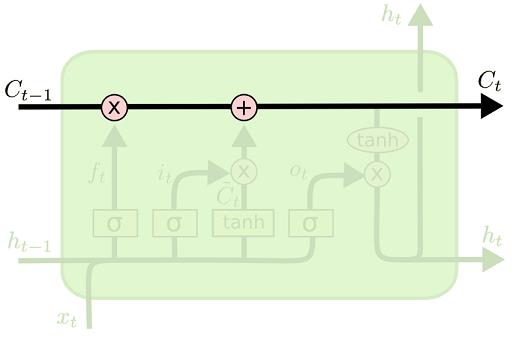

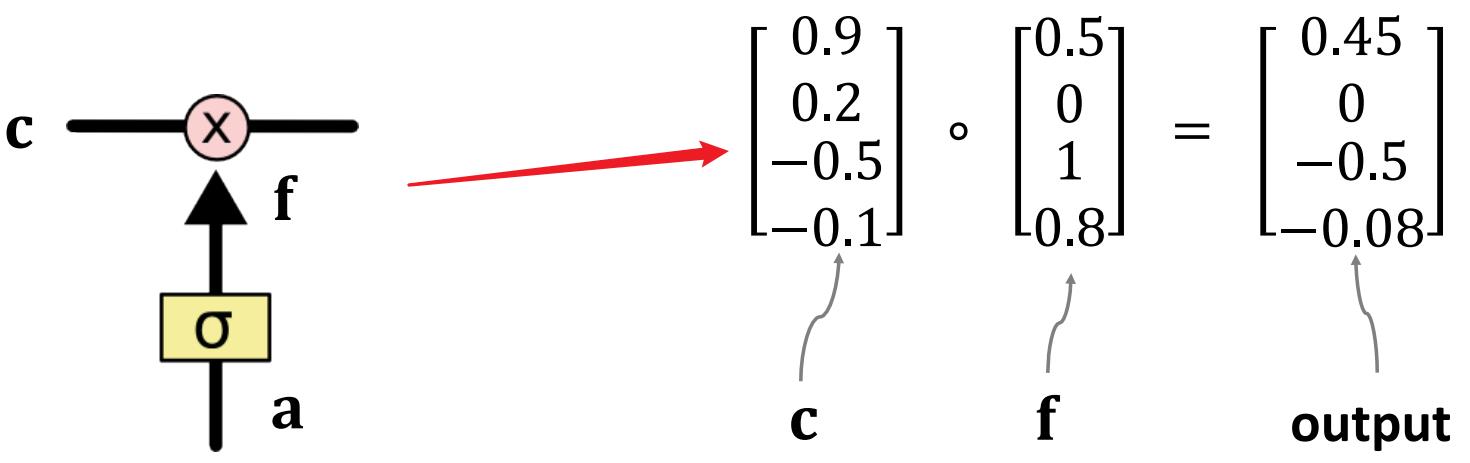

- 在 LSTM 中有三种门,门的作用很简单,就是让 information 选择性通过,门的结构如下所示:

- 在这种情况下,当一个数据 𝑐 通过一个门 𝑓 的时候(𝑓 中的每一个数都位于0∼1之间),𝑓 会对数据 𝑐 进行选择,可以让它全部通过(图中的−0.5∗1=−0.5),也可以让它完全不通过(图中的0.2∗0=0),当然也可以让它部分的通过。

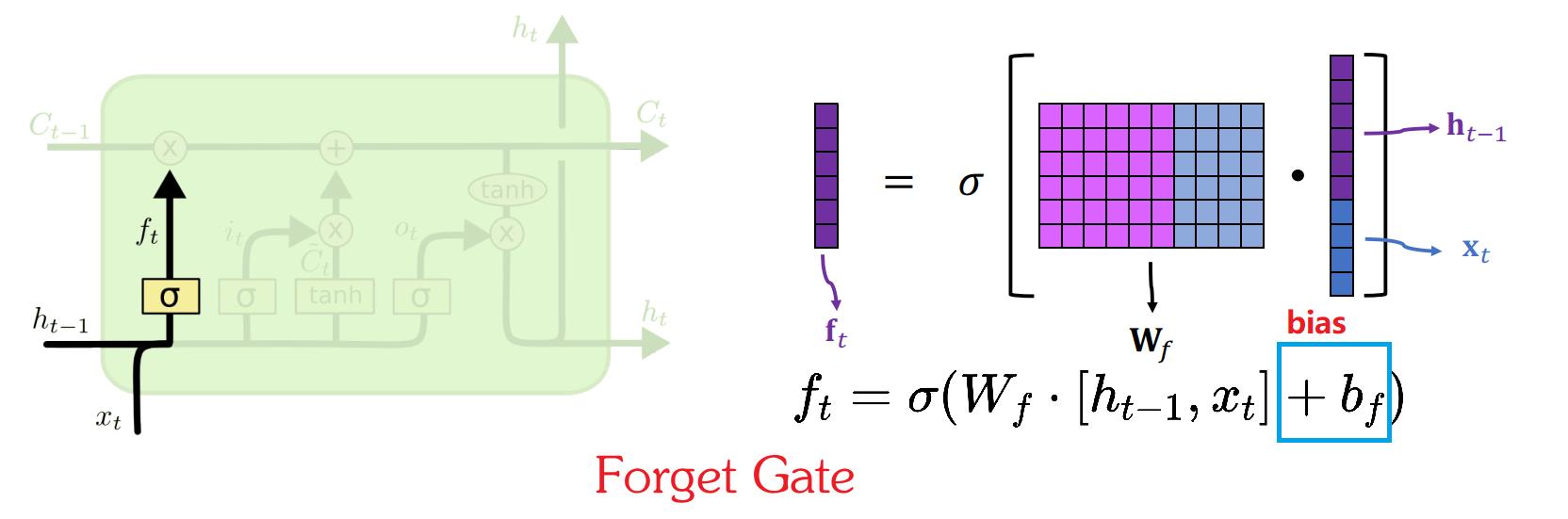

- 遗忘门构成如下所示 𝑓𝑡=𝜎(𝑊𝑓⋅[ℎ𝑡−1,𝑥𝑡]+𝑏𝑓),𝑓𝑡 中的每一个值都介于 0∼1 之间,其中 𝑊𝑓 和 𝑏𝑓 是 LSTM 在训练的时候,通过反向传播进行学习的,遗忘门的作用很简单,那就是控制 𝐶 𝑡−1 中哪一些数据应该被“遗忘”:

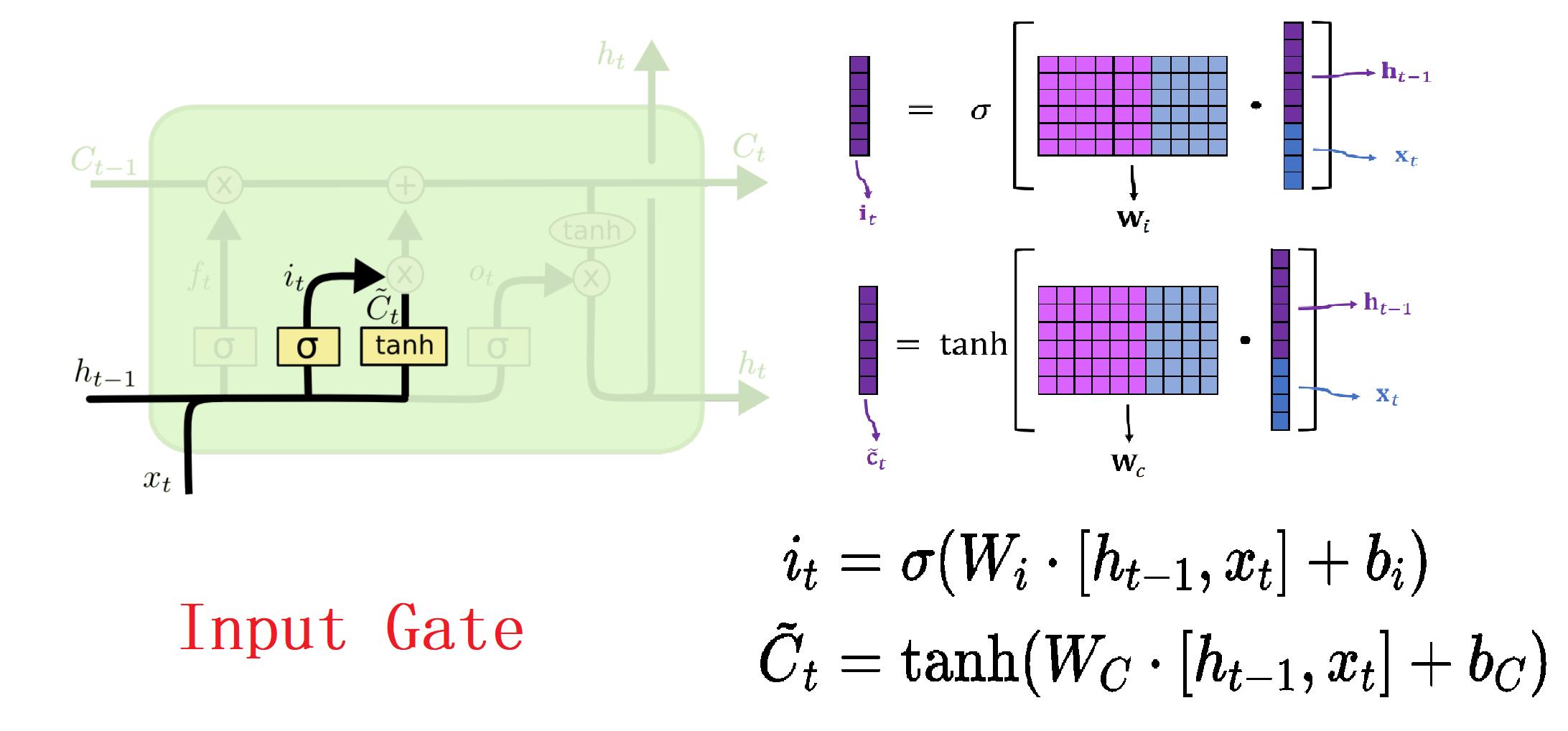

- 如下所示,图中的 𝑖𝑡 表示输入门,𝐶̃𝑡 表示待加入 Cell State 的数据,𝑖𝑡 中的每一个值都介于 0∼1 之间,而 𝐶̃𝑡 的值介于 −1∼1 之间,其中 𝑊𝑖,𝑊𝑐,𝑏𝑖,𝑏𝑐 是通过反向传播进行学习更新的,输入门的作用就是控制 𝐶̃𝑡 中哪一些数据能够加入到 Cell State 中:

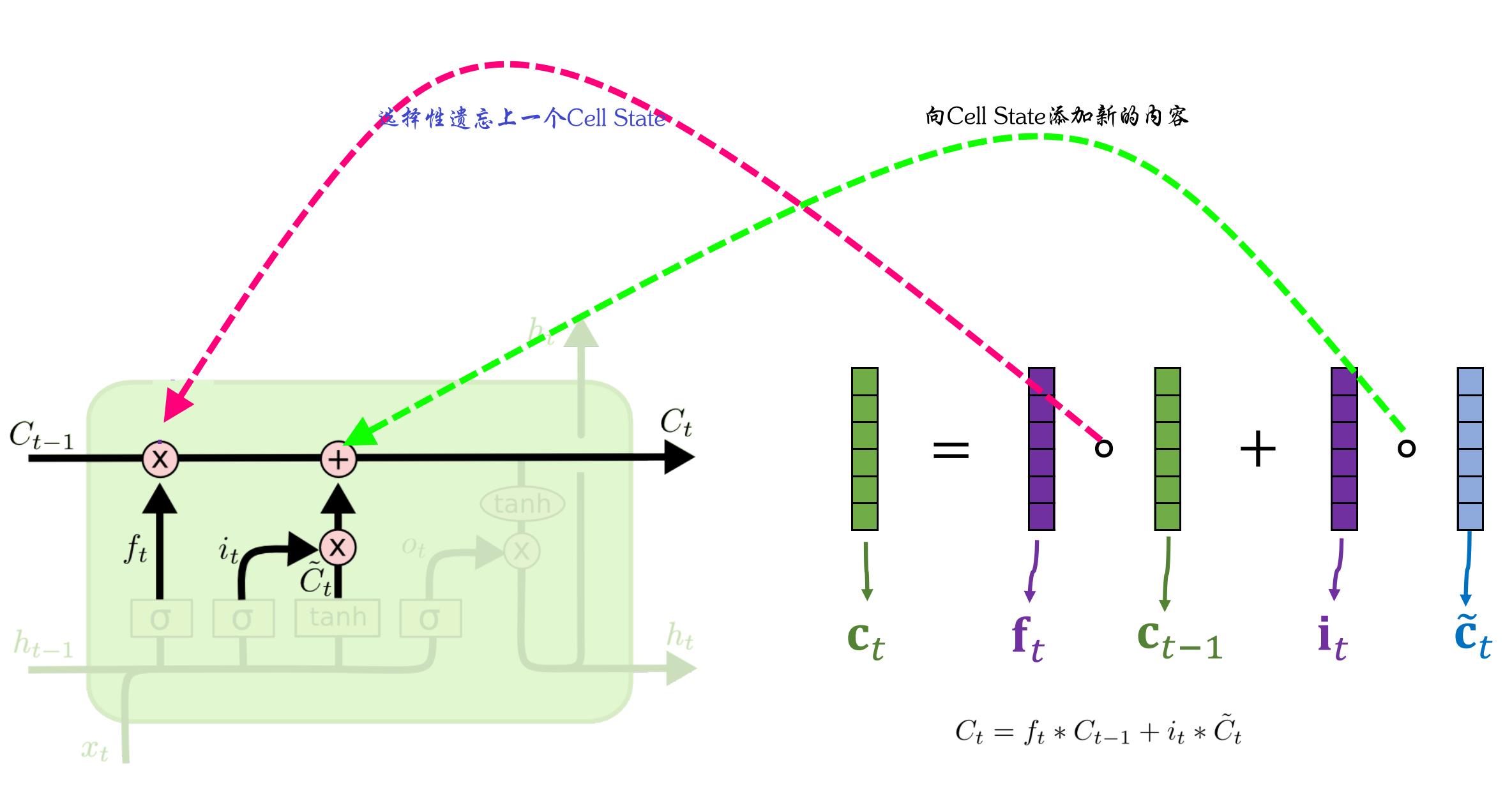

- Cell State 的更新需要遗忘门和输入门的同时作用,遗忘门作用于上一个状态𝐶 𝑡−1,输入门作用于当前输入𝐶̃𝑡 = tanh(𝑊𝐶⋅[ℎ𝑡−1,𝑥𝑡]+𝑏𝑐),这样当被遗忘门处理后的 𝐶 𝑡−1 加上新的输入 𝐶̃𝑡,就组成新的 𝐶𝑡,完成一次 Cell State 的更新。

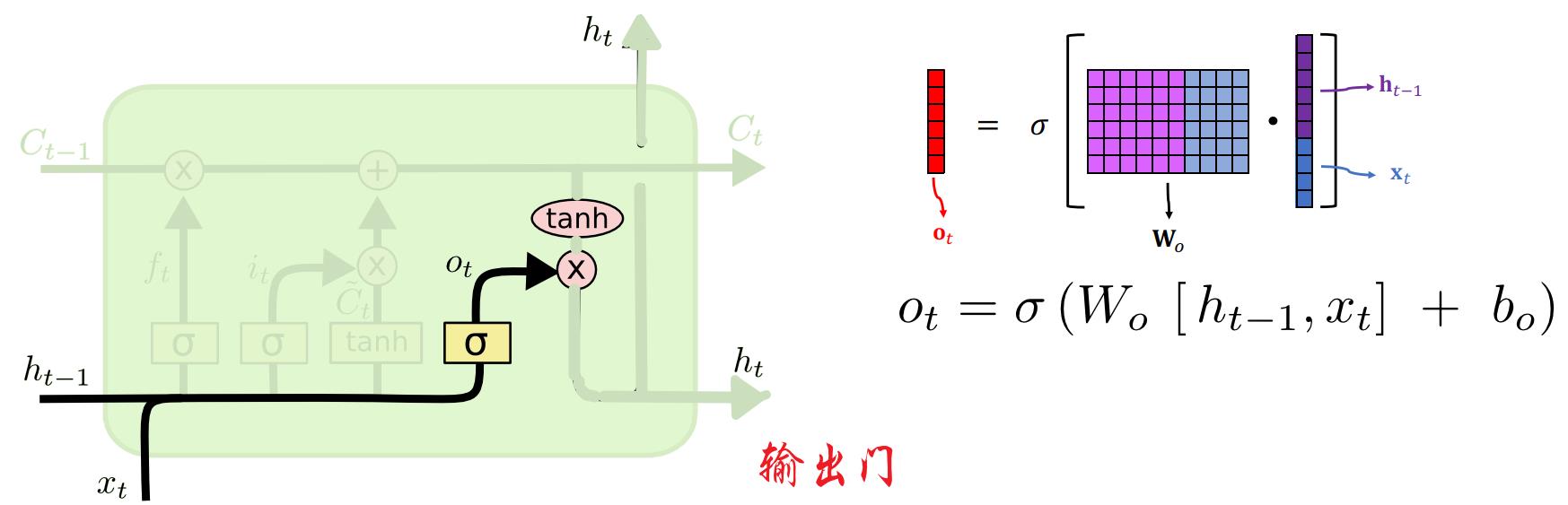

- 输出门的结构如下所示,𝑂𝑡 中的每一个值都介于 0∼1 之间,其中 𝑊𝑜 和 𝑏𝑜 是 LSTM 在训练的时候,通过反向传播进行学习的,输出门的作用实际上就是通过控制 𝐶𝑡 以达到控制 ℎ𝑡 的目的:

- 输出的示意图如下所示,𝑡𝑎𝑛ℎ(𝐶𝑡) 中的每一个值都位于 −1∼+1 之间,输出门 𝑂𝑡 通过控制 𝐶𝑡 的 information,来产生输出 ℎ𝑡,ℎ𝑡 会被赋值为两份,一份作为下个 layer 的 ℎ𝑡,一份用于 LSTM 在时序 𝑡 时刻的输出:

(B)LSTM 预测网络流量

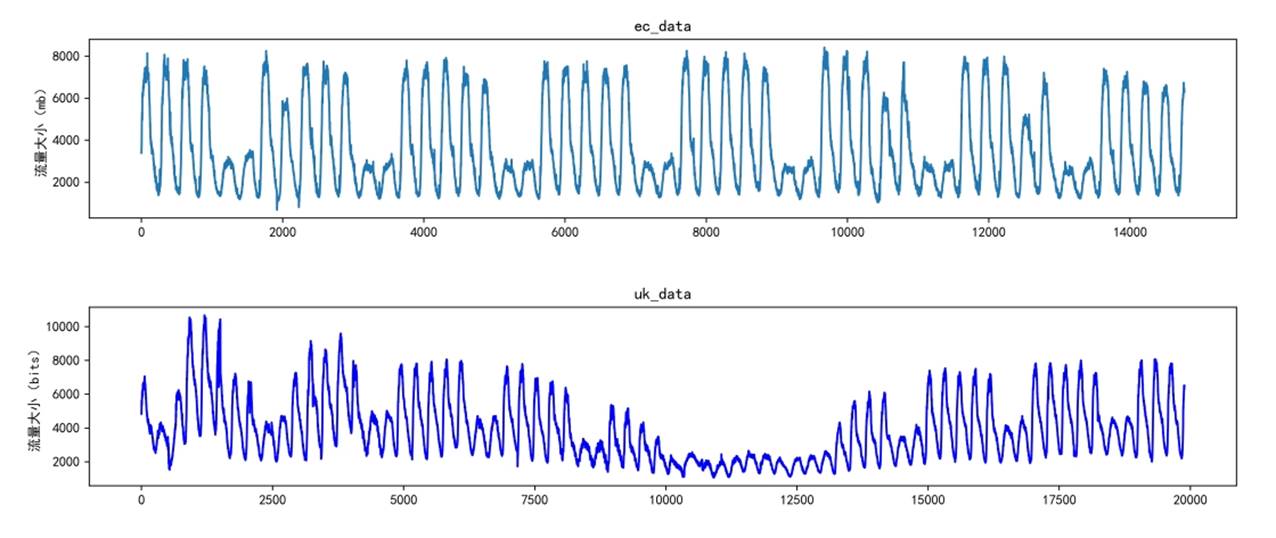

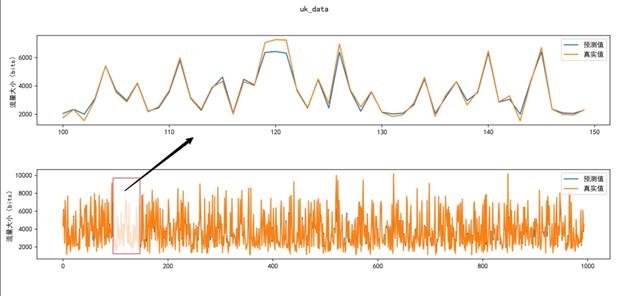

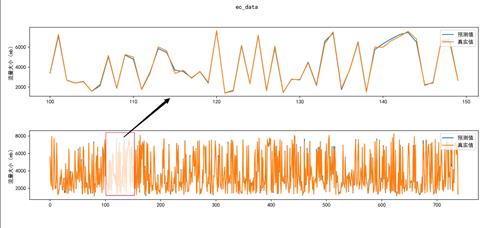

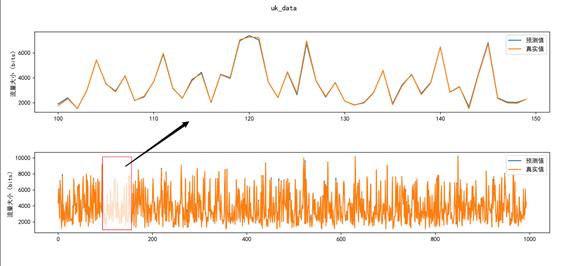

- 如下所示,ec_data 统计了从 2005 年 7 月 6 号至 2005 年 7 月 28 号共计 14772 组网络流量数据(来自欧洲 11 个城市的 ISP 互联网流量(用 ec_data 表示)和英国学术网流量(用 uk_data 表示)),uk_data 统计从 2004 年 11 月 19 号至 2005 年 1 月 27 号共计 19888 组网络数据,ec_data 和 uk_data 都是以 5 分钟为间隔进行采样得到的数据,由图中可以看出,ec_data 和 uk_data 具有很强的周期性以及规律性,因此可以大胆的搏一搏单车变摩托:LSTM 在预测的时候能够有着比较好的结果:

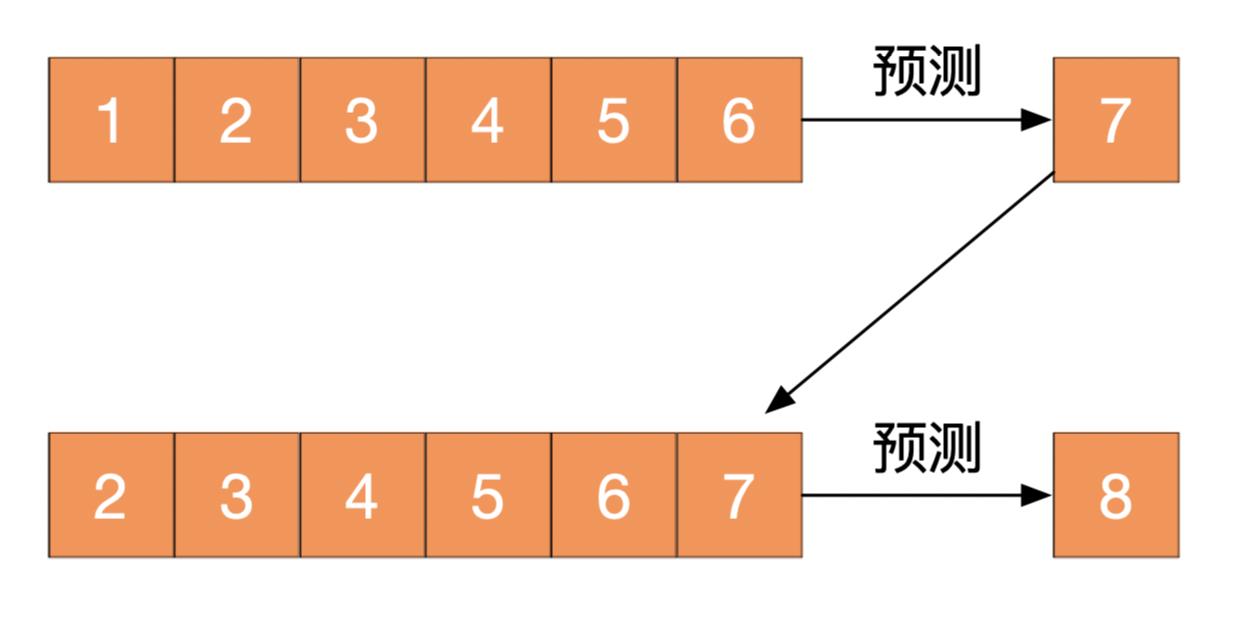

- 通过前 10 个序列去预测后面 𝑁 个序列的网络流量值,如下所示:

- 流量预测的目的是使用前 𝐾 个序列去预测后面 𝑁 个序列(本文 𝐾=10,𝑁=1),从机器学习训练的角度去看,前 𝐾 个序列为 𝑋,后面 𝑁 个序列则为 𝑌,因此需要从网络流量数据中构建数据集。通过上面的操作,就可以将网络流量序列变成 X_Data 和 Y_Data,部分代码如下:

# all_data 即为数据集,sequence_len即为K

sequence_len = 10

X = []

Y = []

for i in range(len(all_data)-sequence_len):

X.append(all_data[i:i+sequence_len])

Y.append(all_data[i+sequence_len])

X = np.array(X)

Y = np.array(Y)

- SVR 使用 sklearn 提供的默认参数,默认参数设置如下:

| 超参数 | 取值 |

|---|---|

| kernel | rbf |

| gamma | scale |

| tol | 0.001 |

| C | 1.0 |

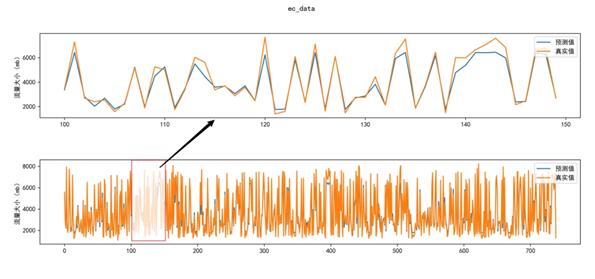

- 预测结果图如下图所示:

-

- ec_data:MAPE=0.095:

-

- uk_data:MAPE=0.084:

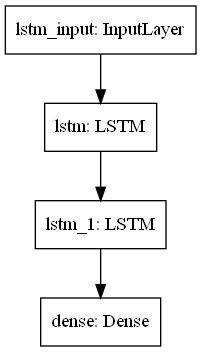

- LSTM 的模型结构如下图所示,是一个很简单的双层 LSTM 网络,并没有加入一些特殊的结构:

- 预测结果:

-

- ec_data:MAPE=0.040:

-

- uk_data:MAPE=0.035:

③ LSTM 智能处理流量

- 如果基站只有一个载波(如同公路只有一条车道),无论预测流量是大是小,都不能关闭载波,关闭则无法正常工作;

- 如果基站是 VIP 基站,特殊情况下也不会被关闭载波。如华为在珠穆朗玛峰搭建的 5G 基站,它们不仅是一种信号的广度和强度,基站的信号更多代表生命等重要的意义,就会被定位 VIP 基站,即使被预测流量很小,它的载波也不会被关闭;

- 普通基站,只有一条载波的时候,不会被关闭,需要保证正常的工作运行;如果有多个载波,在特定的情况下,如果被预测流量很小,则会关闭部分载波。

四、手执三尺青锋,方能缚住 AI 数据苍龙?

① 业务分析,构建合理的业务模型

- 容量规划是通过计算满足一定话务需求的无线资源数目,进而计算出所需要的载波配置、基站数目。容量估算的三要素:话务模型、无线资源、资源占用方式。也就是说容量估算是在一定的话务模型下,按照一定的资源占有方式,求取无线资源占有数量的过程,以满足一定的容量能力指标。

- 5G 业务三大场景分别是增强型移动带宽 eMBB、大规模的机器通信业务 mMTC、超可靠低时延通信业务 uRLLC,各场景业务特征、覆盖场景、用户行为等相较于 4G 发生了很大的变化。根据 5G 协议制订的进度,现阶段 R15 标准主要针对于 eMBB 增强型移动带宽业务,R16 版本标准会包含 mMTC 大规模的机器通信业务、uRLLC 超可靠低时延通信业务场景,但是容量规划的原理依然未发生较大的变化。

- 通过模型分析和需求分析得到用户预测、业务模型和资源分析,用户预测和业务模型可以得到业务的总需求,通过资源分析得到单基站能力。再结合业务总需求和单基站能力得到网络建设基站需求数。

- 5G 容量规划主要是完成两部分的核算:业务总需求和单基站能力。业务总需求为规划区域内用户的总业务需求(总吞吐量、总连接用户数、总激活用户数等)。单基站能力为单基站所能提供的容量(吞吐量、连接用户数、激活用户数)。基站总需求数为总业务需求与单基站能力相除的最大数量。同时考虑到实际网络中的话务分布不均衡等因素,需要对相应的结构进行修正。

- 业务模型是在对用户使用网络可提供的各种业务的频率、时长、承载速率进行统计的基础.上得出的业务量模型。5G 网络承载的业务类型相较于 4G 更多,需要根据各网络承载的业务模型进行增减,同时,业务模型与各运营商的业务发展策略及网络建设情况、用户的使用习惯、用户的终端成熟情况等有很大的关系,需要根据实际情况进行科学的统计、调整。

- 5GeMBB 典型业务有视频通话及 VR 业务,在进行 5G 覆盖和容量规划是需要确定网络边缘速率或承载速率。VoLTE 视频通话业务为上下行对称业务、上下行速率要求一致,在规划是主要满足上行业务需求;高清视频及VR业务为非对称业务,下行速率远高于上行速率,在规划是需要满足下行业务需求情况。

- 随着视频高清度的提高、VR/AR 及裸眼 3D 技术的要求,对网络速率的要求快速增加,对网络整体容量提出了更高的要求,根据网络实际用户需求情况调整容量规划指标。

② AI 开发过程中,哪个最耗时间?

(A)数据成本

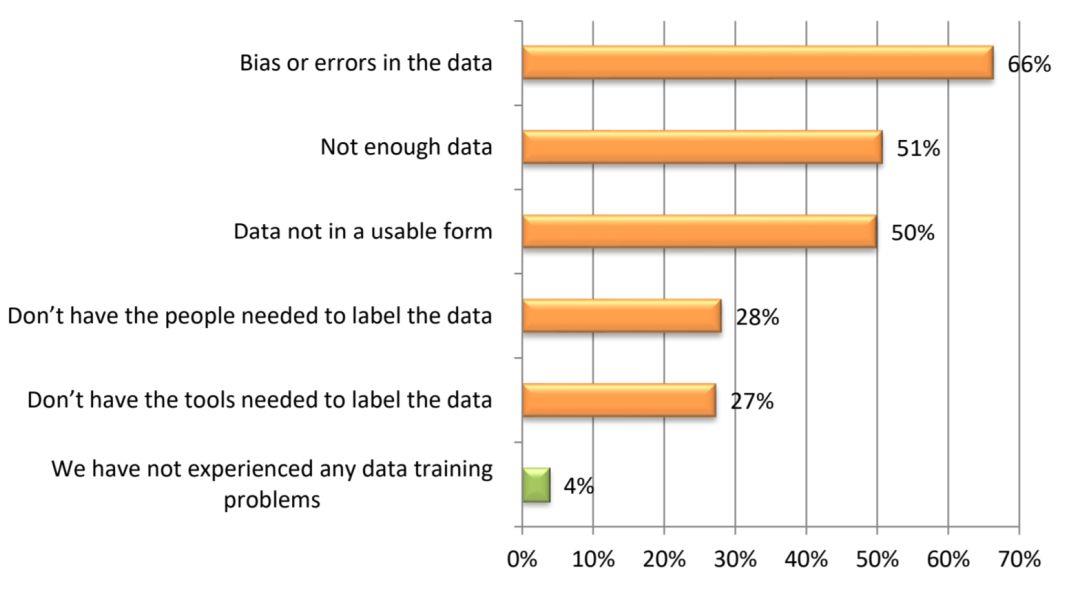

- 与数据相关的机器学习成本主要表现在数据集方面,包括数据集的获得、数据的标注等,Dimensional Research 代表 Alegion 所做的一项最新研究表明,所有组织中的 96% 都遇到与训练数据质量和数量相关的问题,同一项研究表明,大多数项目需要超过 100,000 个数据样本才能表现良好:

- 如果还没有数据,可以假设能够在大约一个小时内收集 5–10 个样本并对它们进行标注。利用 亚马逊的 Mechanical Turk 之类的服务来实验整个过程,生成 100,000 个样本数据集的话,花费大约为 70,000 美元。

- 如果已经收集了大量数据,则可以使用 Scale 之类的服务来对其进行标注。在这种情况下,获得 100,000 个带有标签的数据样本,则可能需要花费 8,000 到 80,000 美元的费用,具体的需要取决于标注的复杂程度。

- 此外,检查和校正数据样本与生成和注释数据样本一样耗时,Dimensional Research 研究报告中提到,66%的公司在其数据集中遇到偏差和错误问题。有些公司选择采用完整的内部方法(自己做所有标注),也有一些公司会选择外包和内部混合使用。第二种常见的情况是将大部分工作外包,然后由个别人员负责验证和清理。外包 10 万个数据样本的初始成本可能会增加大约 2500 至 5,000 美元。

(B)算法成本

- Dimensional Research 报告指出,大多数企业 AI 团队的成员不足 10 名,假设每个技术团队有 5 名成员,其中 3 个是外包,在这种配置下,团队可能足以并行处理两个项目,平均每 1.5 个月研究一个项目。基于此的成本是 2 名员工(2 x 5,000 美元),3 名自由职业者(3 x 3,000 美元),每月的总成本是 19,000 美元。如果团队可以同时处理两个项目,并且研究时间为 1.5 个月,则意味着该阶段的成本约为每个项目 14,250 美元。

(C)算力成本

- 与算力相关的机器学习成本主要表现在基础架构、集成、维护以及各种处理器的功耗方面。生产成本包括基础架构成本(云计算,数据存储),集成成本(数据管道开发,API 开发,文档)和维护成本。

- 其中,云计算的支出取决于部署算法的复杂性。如果模型不是很深,并且是在低维表格数据上进行训练,则将获得 4 个虚拟 CPU 运行在 1 到 3 个节点上的服务,每月费用为 100 到 300 美元,即每年 1200 到 3600 美元。另一方面,对于无延迟的深度学习推理,价格从 10,000 美元到 30,000 美元不等。

- 集成可能比较棘手,在大多数情况下,只需要将 API 端点放在云中并记录下来,供系统的其余部分使用即可,准备要使用的机器学习模型并编写 API 脚手架最多需要 20 到 30 个开发小时,其中包括测试,成本约为 1,500 美元,加上修改系统的其余部分以使用新 API 所需的成本。稳定的数据管道将花费更多的时间,大概需要 80 个小时左右。

③ 运用“NAIE 云服务”提升数据准备效率,缩短数据准备时间

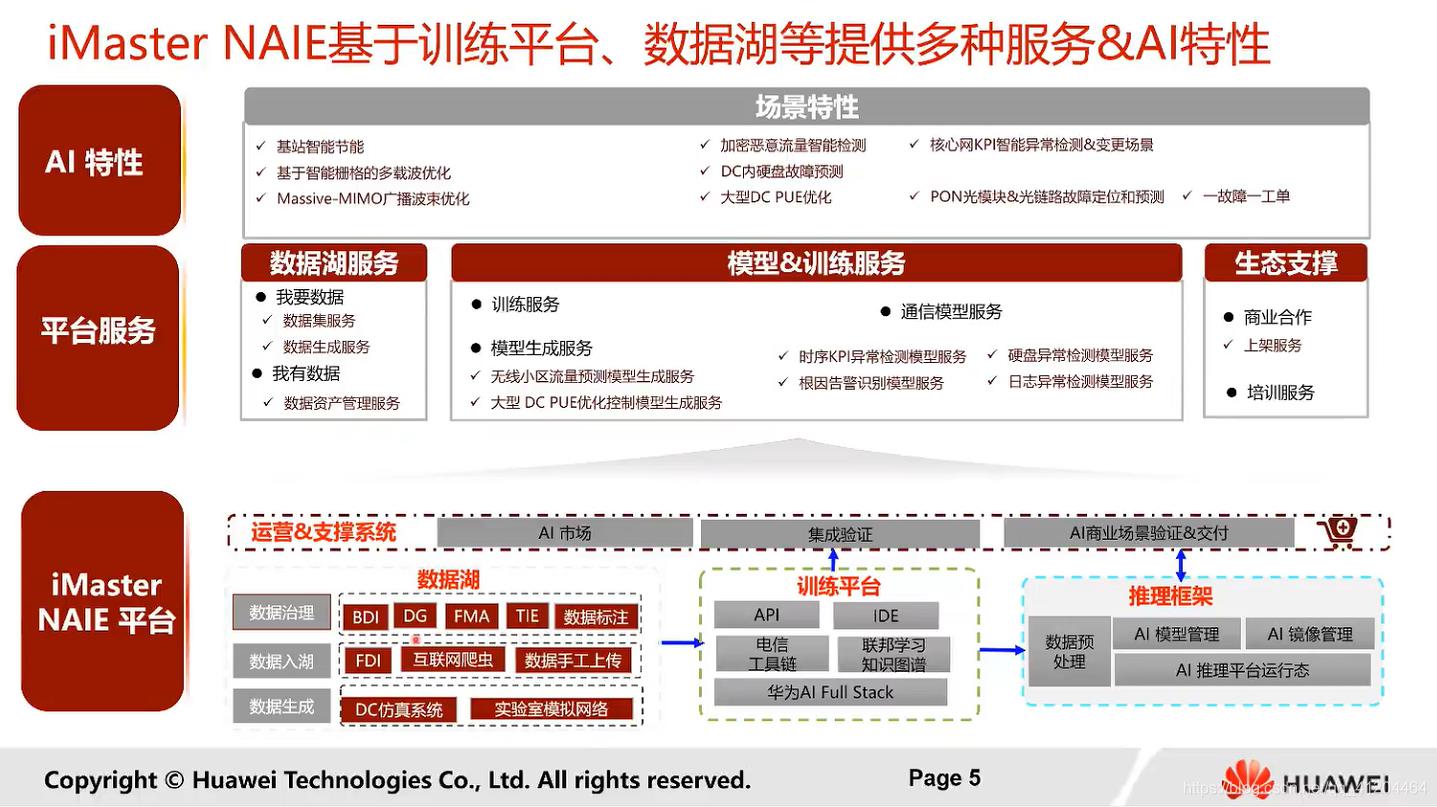

- NAIE 云服务定位和架构:

- 网络 AI 模型开发:

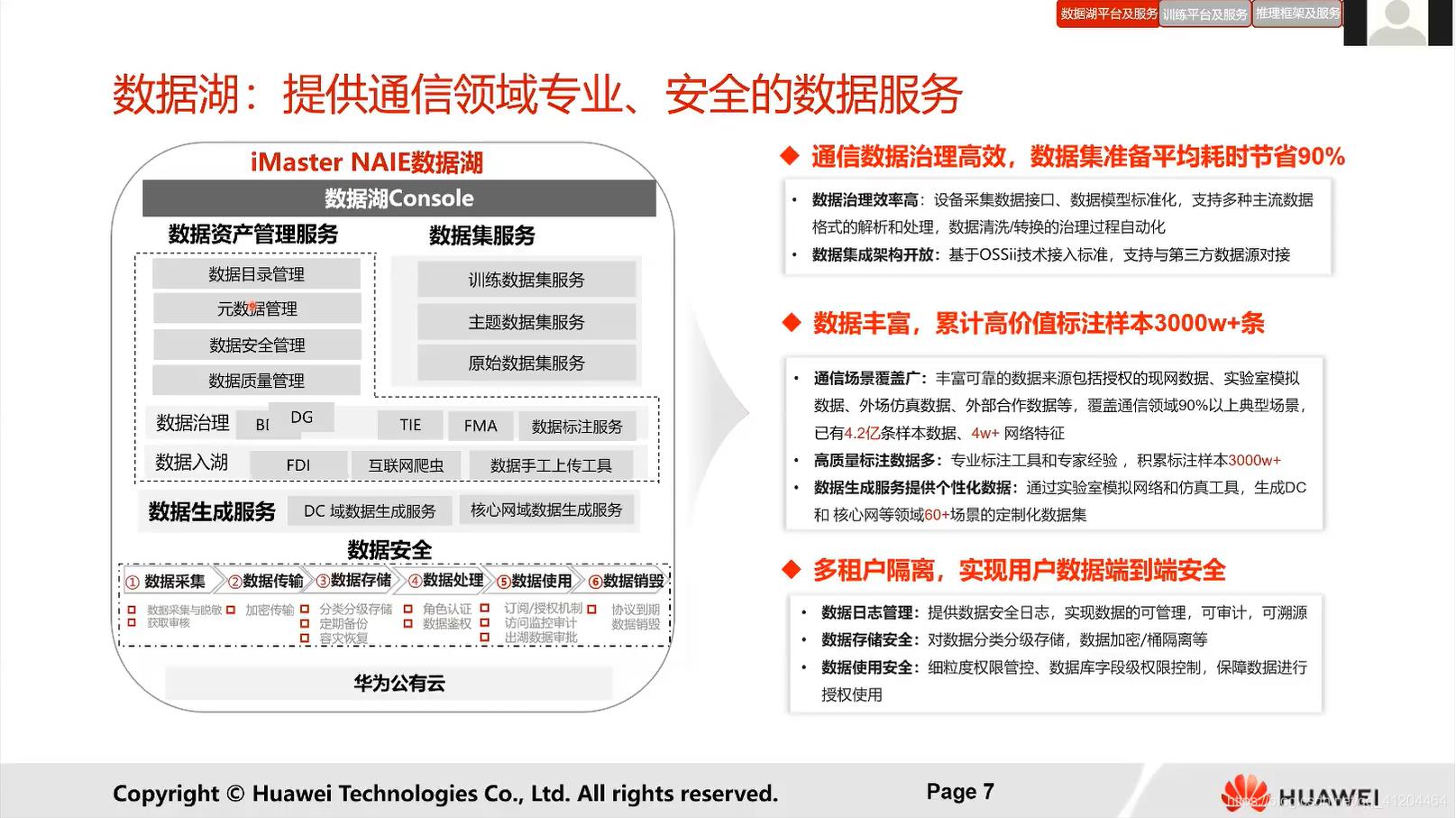

- 数据湖:

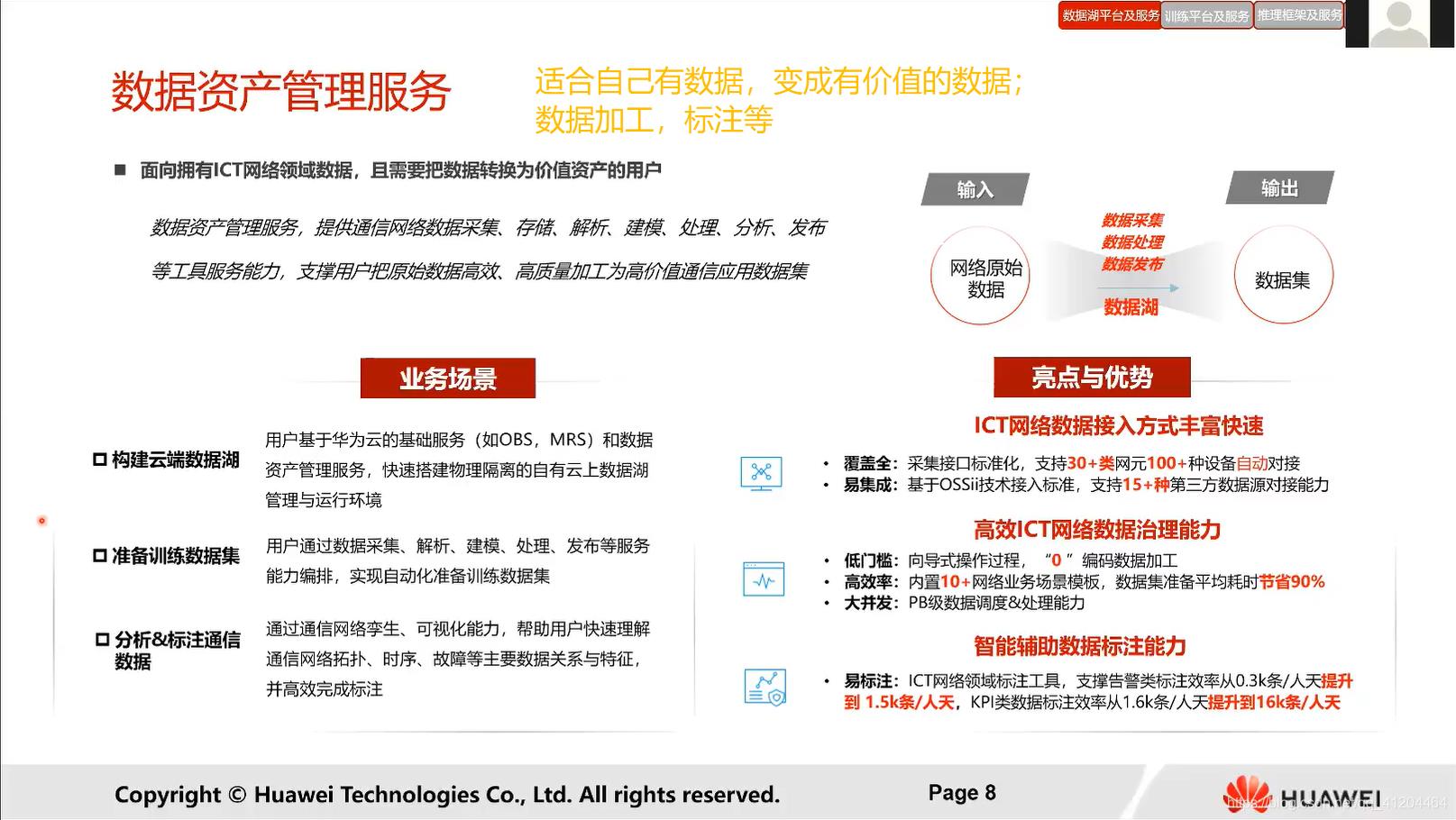

- 数据资产管理服务:

- 数据集服务:

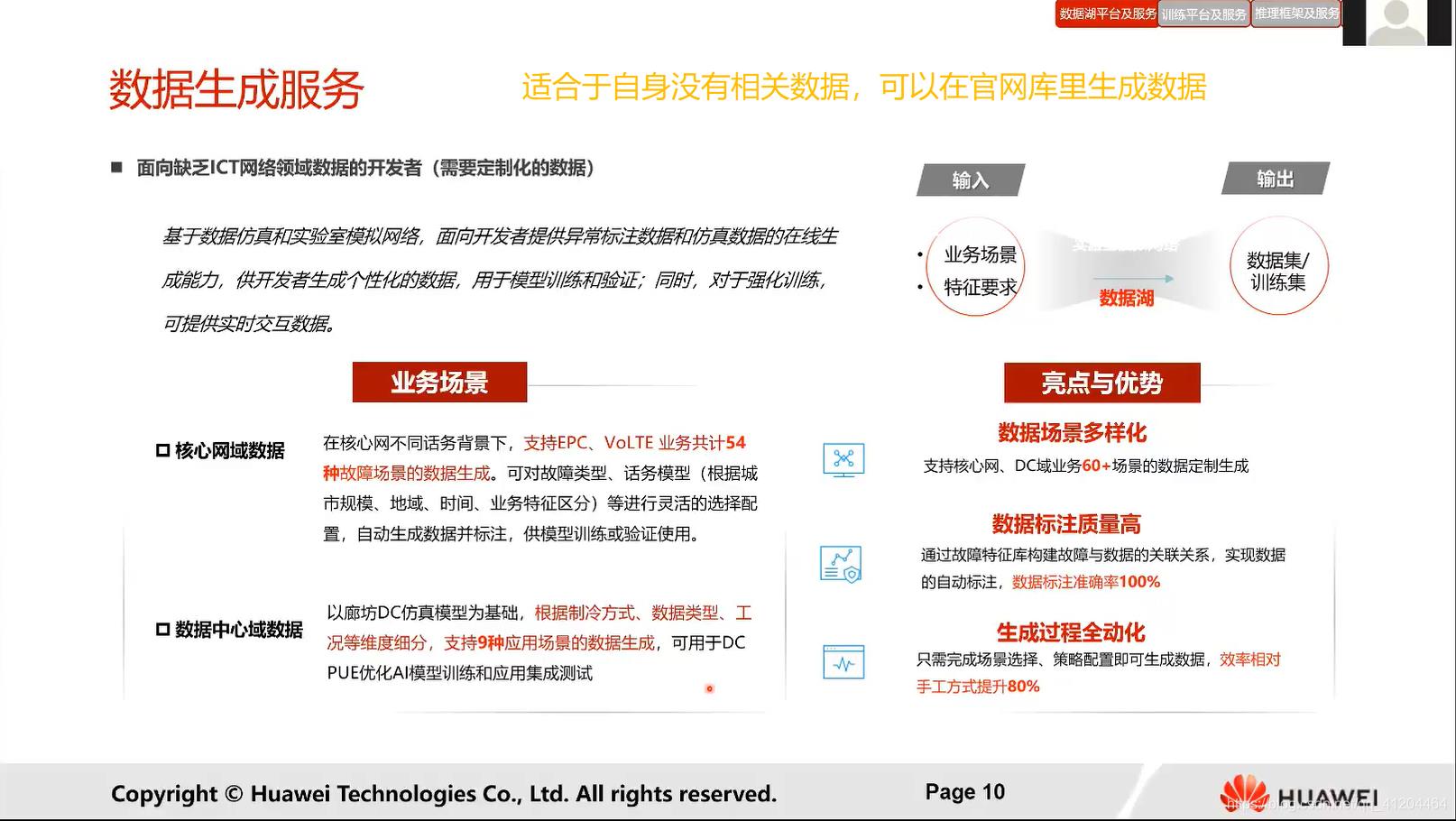

- 数据生成服务:

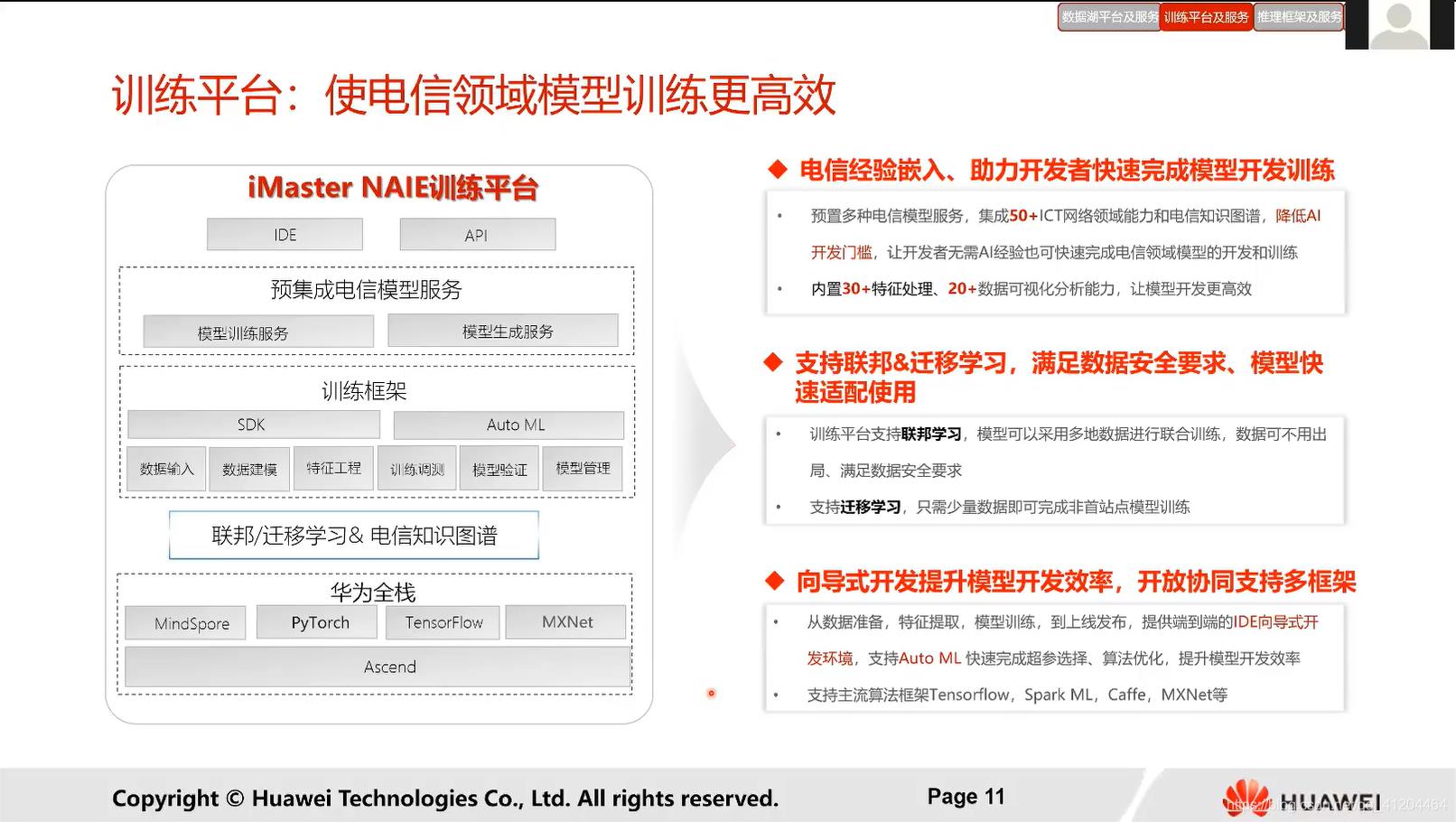

- 训练平台:

- 训练服务:

- 模型生成服务:

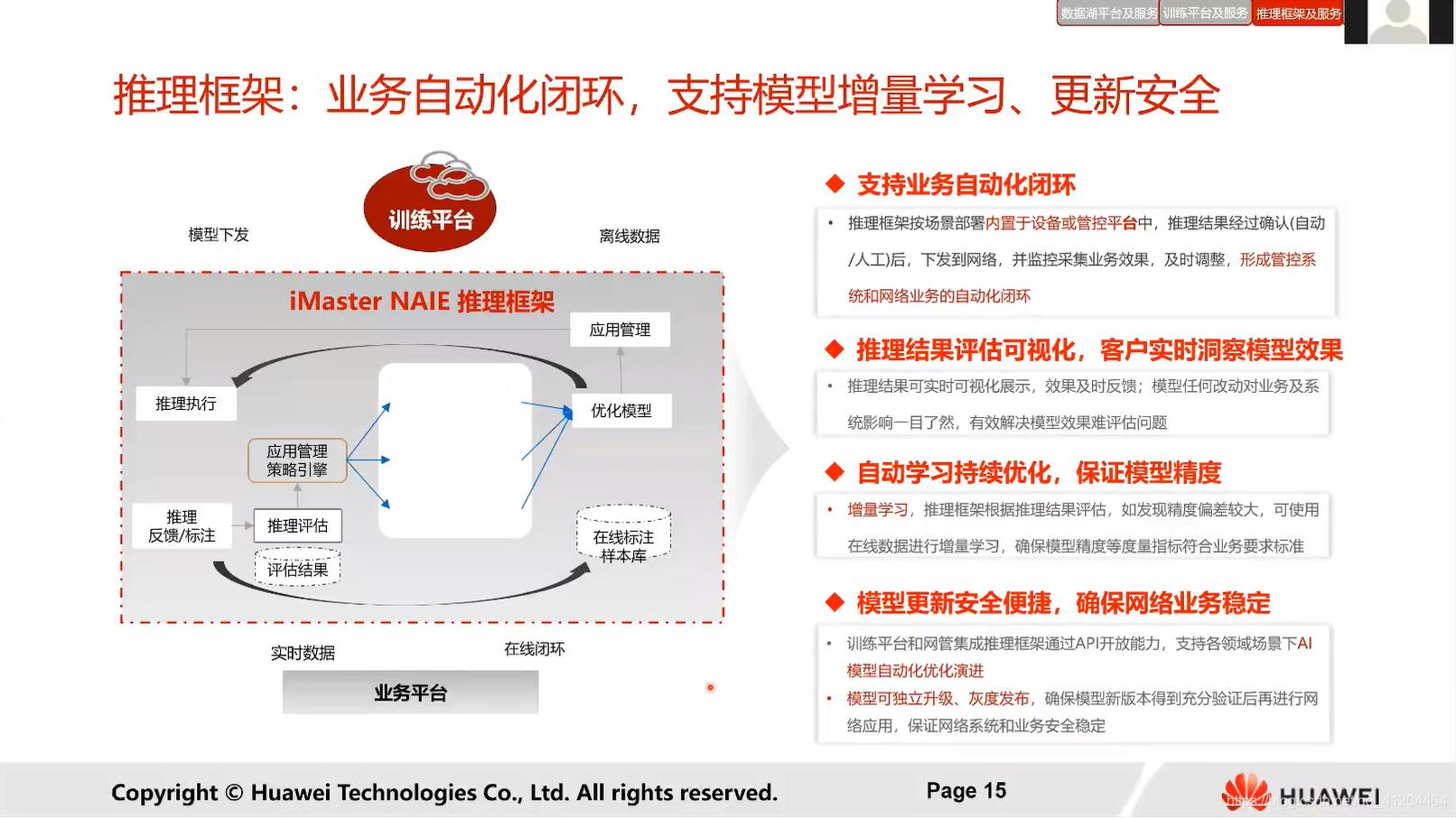

- 推理框架:

- 通信模型服务:

以上是关于人工智能之华为云5G基站有AI,智能处理流量“潮汐”的主要内容,如果未能解决你的问题,请参考以下文章