Hadoop本地运行模式之Grep案例WordCount案例

Posted 爱上口袋的天空

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Hadoop本地运行模式之Grep案例WordCount案例相关的知识,希望对你有一定的参考价值。

1、官方Grep案例

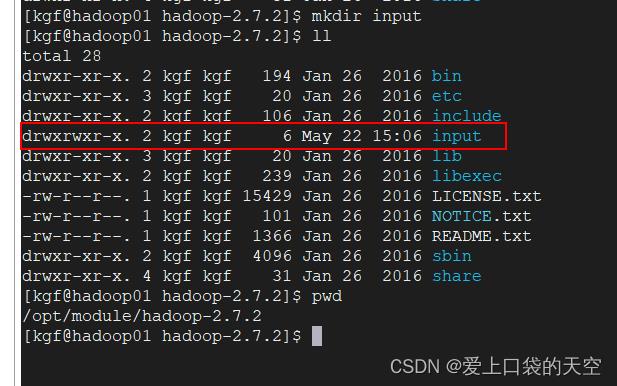

1.1、创建在hadoop-2.7.2文件下面创建一个input文件夹

1.2、将Hadoop的xml配置文件复制到input目录下

[kgf@hadoop01 hadoop-2.7.2]$ cp etc/hadoop/*.xml input/ [kgf@hadoop01 hadoop-2.7.2]$ ll input/ total 48 -rw-r--r--. 1 kgf kgf 4436 May 22 15:07 capacity-scheduler.xml -rw-r--r--. 1 kgf kgf 774 May 22 15:07 core-site.xml -rw-r--r--. 1 kgf kgf 9683 May 22 15:07 hadoop-policy.xml -rw-r--r--. 1 kgf kgf 775 May 22 15:07 hdfs-site.xml -rw-r--r--. 1 kgf kgf 620 May 22 15:07 httpfs-site.xml -rw-r--r--. 1 kgf kgf 3518 May 22 15:07 kms-acls.xml -rw-r--r--. 1 kgf kgf 5511 May 22 15:07 kms-site.xml -rw-r--r--. 1 kgf kgf 690 May 22 15:07 yarn-site.xml [kgf@hadoop01 hadoop-2.7.2]$1.3、执行share目录下的MapReduce程序

[kgf@hadoop01 hadoop-2.7.2]$ bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.2.jar grep input output 'dfs[a-z.]+'1.4、查看输出结果

[kgf@hadoop01 hadoop-2.7.2]$ cat output/* 1 dfsadmin [kgf@hadoop01 hadoop-2.7.2]$

2、WordCount案例

2.1、创建在hadoop-2.7.2文件下面创建一个wcinput文件夹

[kgf@hadoop01 hadoop-2.7.2]$ mkdir wcinput [kgf@hadoop01 hadoop-2.7.2]$ ll total 28 drwxr-xr-x. 2 kgf kgf 194 Jan 26 2016 bin drwxr-xr-x. 3 kgf kgf 20 Jan 26 2016 etc drwxr-xr-x. 2 kgf kgf 106 Jan 26 2016 include drwxrwxr-x. 2 kgf kgf 187 May 22 15:07 input drwxr-xr-x. 3 kgf kgf 20 Jan 26 2016 lib drwxr-xr-x. 2 kgf kgf 239 Jan 26 2016 libexec -rw-r--r--. 1 kgf kgf 15429 Jan 26 2016 LICENSE.txt -rw-r--r--. 1 kgf kgf 101 Jan 26 2016 NOTICE.txt drwxrwxr-x. 2 kgf kgf 88 May 22 15:08 output -rw-r--r--. 1 kgf kgf 1366 Jan 26 2016 README.txt drwxr-xr-x. 2 kgf kgf 4096 Jan 26 2016 sbin drwxr-xr-x. 4 kgf kgf 31 Jan 26 2016 share drwxrwxr-x. 2 kgf kgf 6 May 22 15:12 wcinput [kgf@hadoop01 hadoop-2.7.2]$2.2、在wcinput文件下创建一个wc.input文件

[kgf@hadoop01 hadoop-2.7.2]$ cd wcinput [kgf@hadoop01 wcinput]$ touch wc.input [kgf@hadoop01 wcinput]$ ll total 0 -rw-rw-r--. 1 kgf kgf 0 May 22 15:13 wc.input [kgf@hadoop01 wcinput]$2.3、编辑wc.input文件

[kgf@hadoop01 wcinput]$ vi wc.input在文件中输入如下内容

hadoop yarn hadoop mapreduce atguigu atguigu2.4、执行程序

[kgf@hadoop01 hadoop-2.7.2]$ pwd /opt/module/hadoop-2.7.2 [kgf@hadoop01 hadoop-2.7.2]$ hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.2.jar wordcount wcinput wcoutput2.5、查看结果

[kgf@hadoop01 hadoop-2.7.2]$ ll wcoutput/ total 4 -rw-r--r--. 1 kgf kgf 38 May 22 15:15 part-r-00000 -rw-r--r--. 1 kgf kgf 0 May 22 15:15 _SUCCESS [kgf@hadoop01 hadoop-2.7.2]$ cat wcoutput/part-r-00000 atguigu 2 hadoop 2 mapreduce 1 yarn 1 [kgf@hadoop01 hadoop-2.7.2]$

以上是关于Hadoop本地运行模式之Grep案例WordCount案例的主要内容,如果未能解决你的问题,请参考以下文章