安装local模式的saprk

Posted wyju

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了安装local模式的saprk相关的知识,希望对你有一定的参考价值。

安装

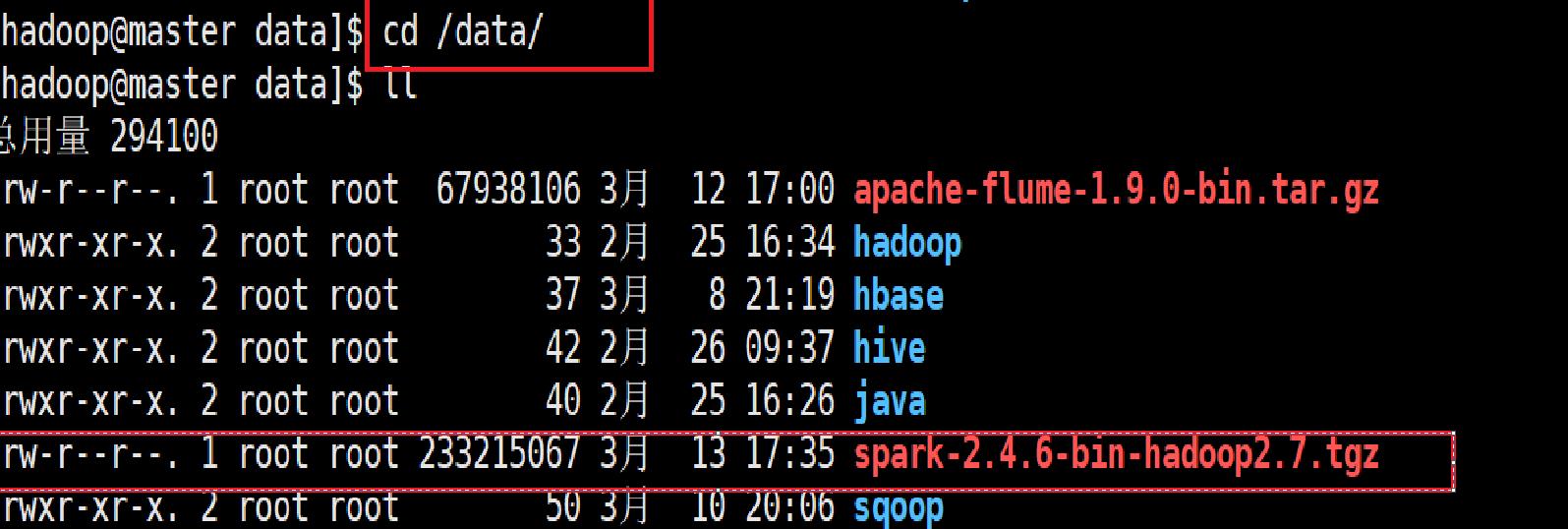

1.上传Spark压缩包

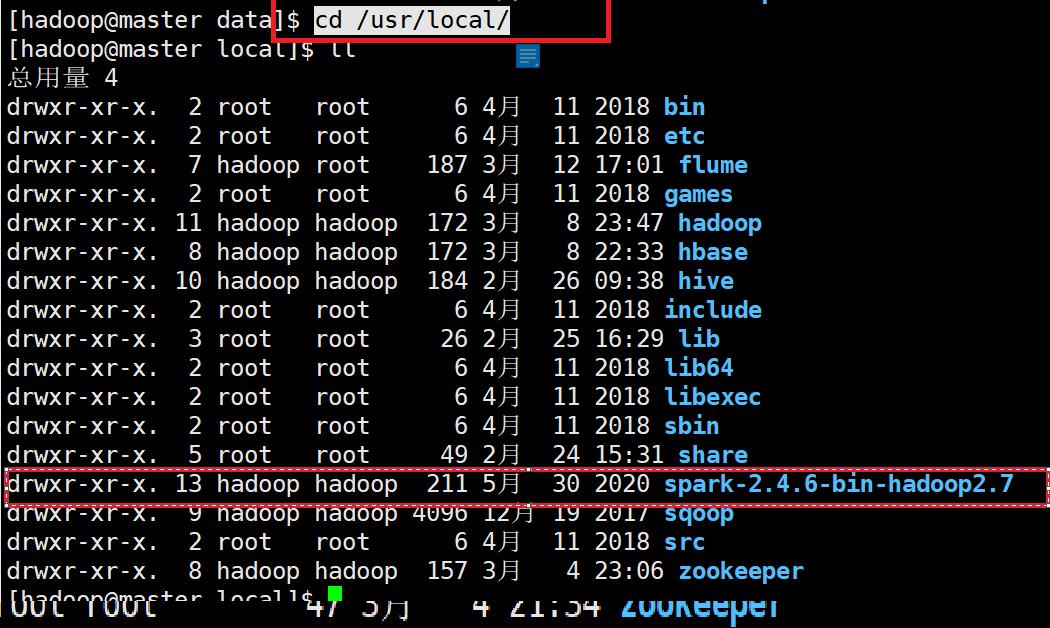

2.解压缩Spark到/usr/local目录

sudo tar -zxvf spark-2.4.6-bin-hadoop2.7.tgz -C /usr/local

cd /usr/local/

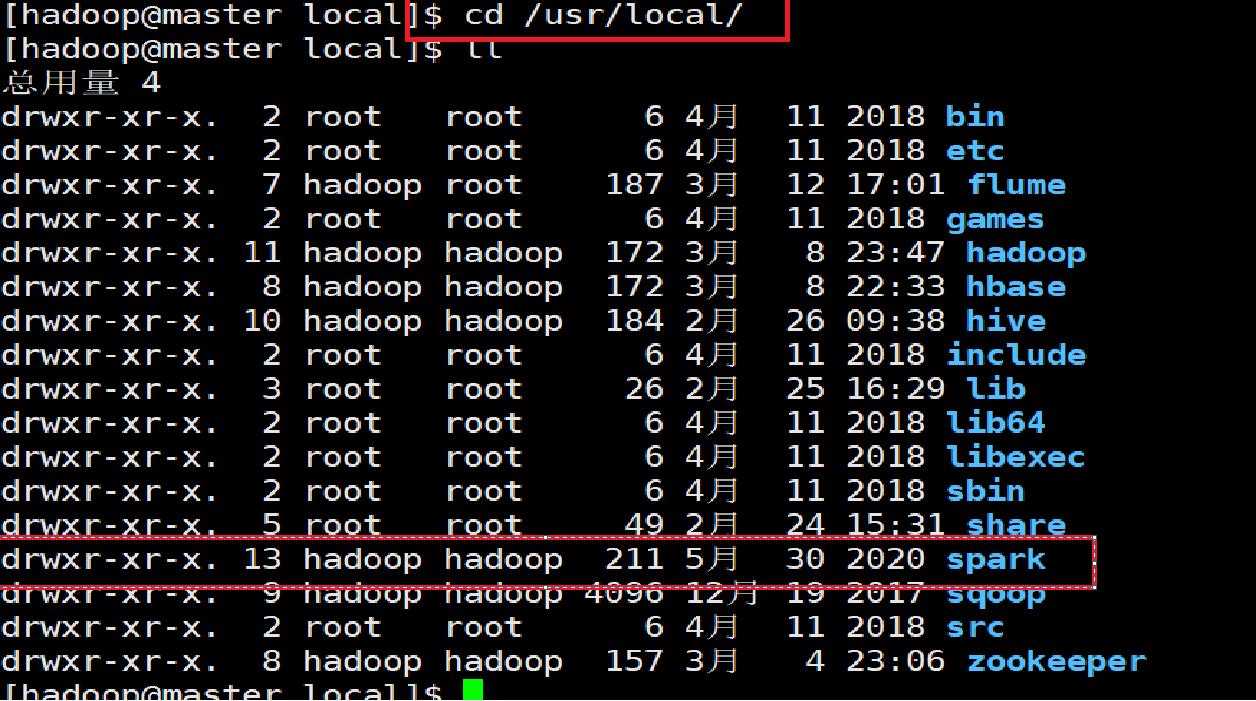

3.重命名为spark,使用以下命令:

sudo mv /usr/local/spark-2.4.6-bin-hadoop2.7/ /usr/local/spark

4.授权当前用户hadoop拥有spark目录的所有者权限,使用以下命令:

sudo chown -R hadoop /usr/local/spark

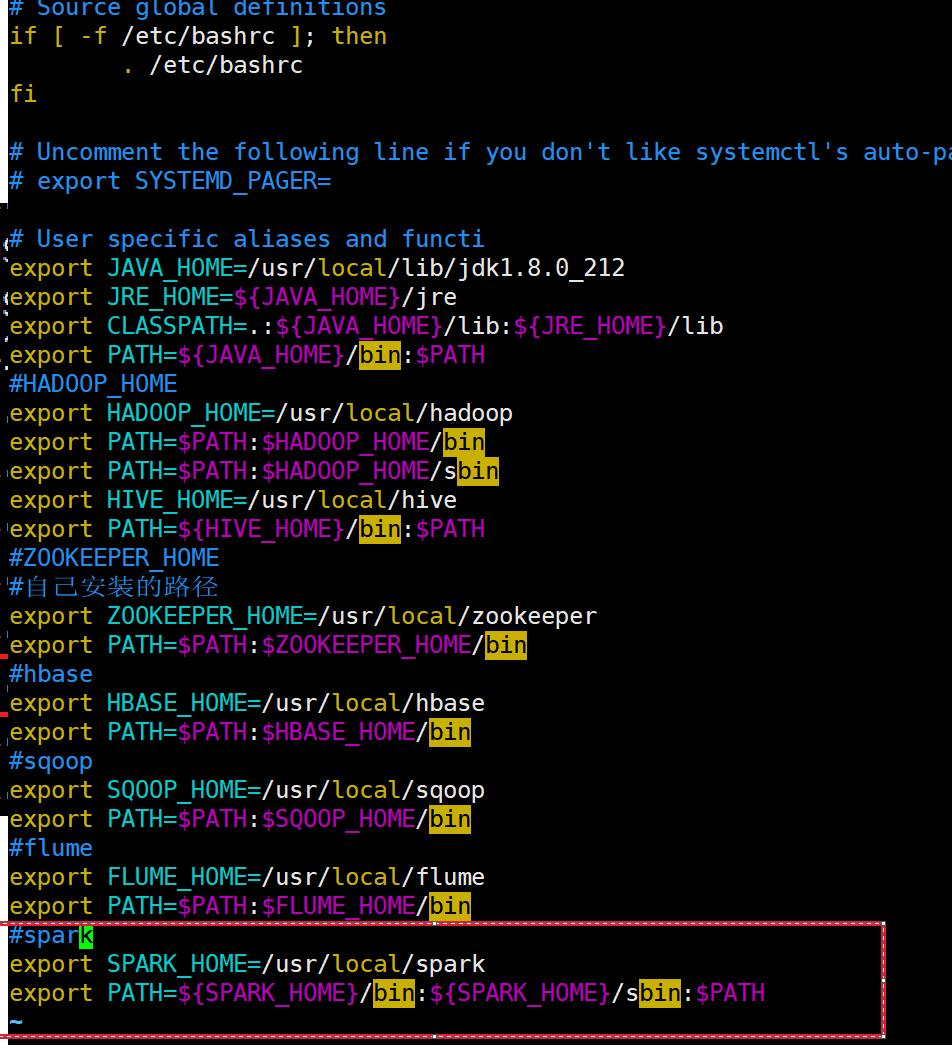

5.编辑环境变量,使用以下命令:

sudo vim /home/hadoop/.bashrc

6.设置环境变量SPARK_HOME,并更新环境变量PATH,内容如下:

export SPARK_HOME=/usr/local/spark

export PATH=$SPARK_HOME/bin:$SPARK_HOME/sbin:$PATH

7.刷新环境变量,使用以下命令:

source /home/hadoop/.bashrc

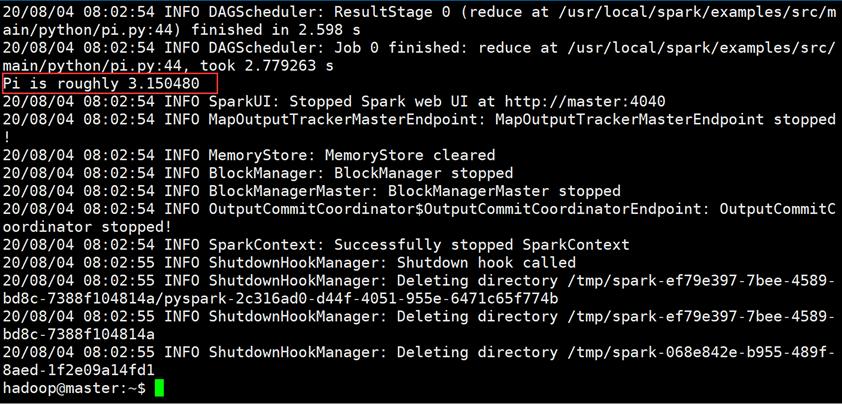

测试

spark-submit \\

--master local[5] \\

/usr/local/spark/examples/src/main/python/pi.py 10

安装成功后,进入以下链接安装standalone模式

https://blog.csdn.net/weixin_45955039/article/details/123463253

以上是关于安装local模式的saprk的主要内容,如果未能解决你的问题,请参考以下文章