Hadoop安装并配置环境变量(测试版)

Posted pier~呀

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Hadoop安装并配置环境变量(测试版)相关的知识,希望对你有一定的参考价值。

Hadoop安装并配置环境变量

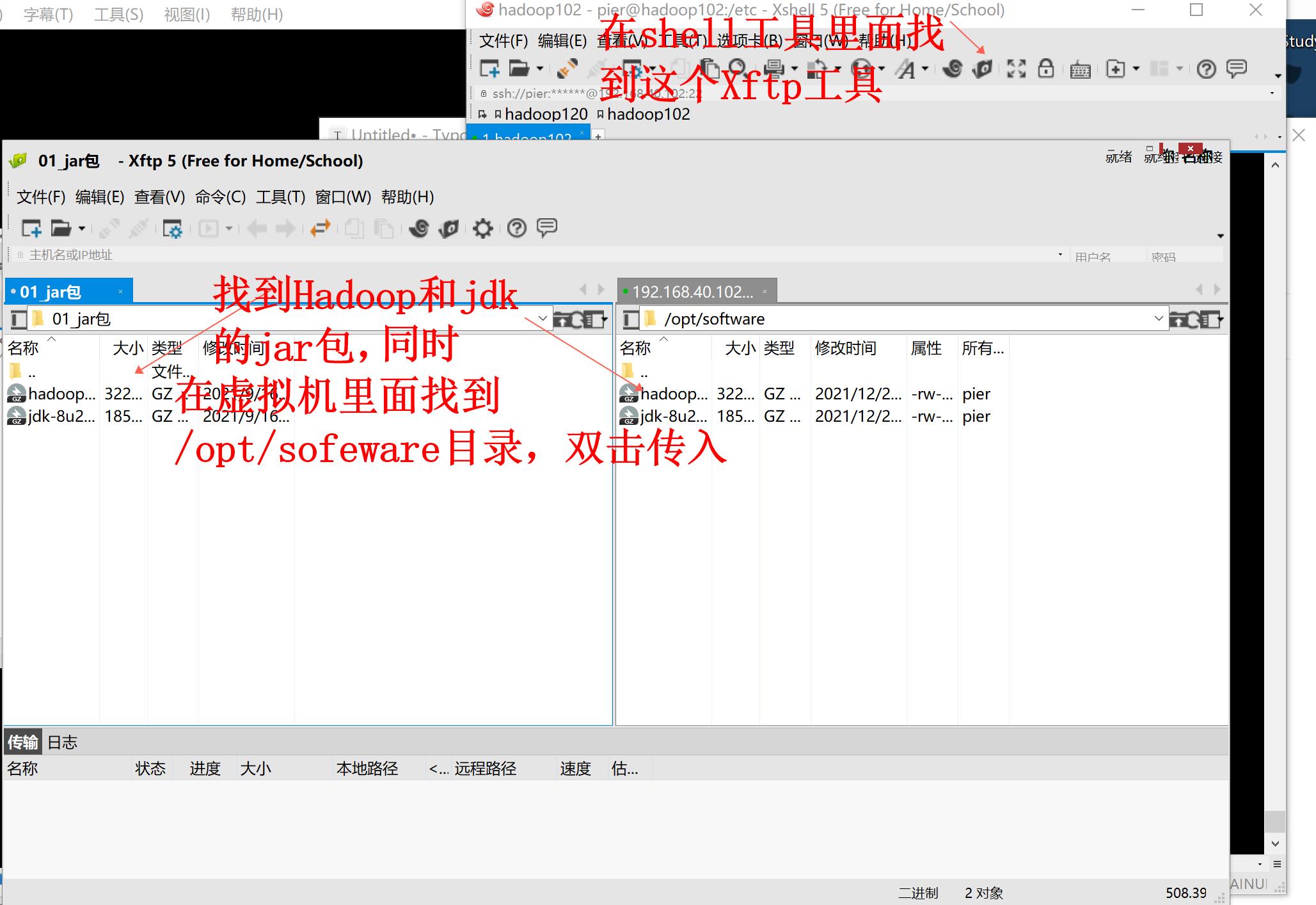

资料说明

jdk包下载链接:https://pan.baidu.com/s/16betSGfm5KsQm9OqnckBUA

提取码:7xfk

(jdk下载官方原版的要💴,有金的小伙伴可以去官网下载。官网地址:https://www.oracle.com/java/technologies/downloads/)

Hadoop官网下载:https://archive.apache.org/dist/hadoop/common/hadoop-3.1.3/](https://archive.apache.org/dist/hadoop/common/hadoop-2.7.2/)

安装jdk

使用tar工具解压安装

#这是进入software目录下解压安装的两种方法,主要就是目录写法不一样

[pier@hadoop102 software]$ tar -zvxf jdk-8u212-linux-x64.tar.gz -C /opt/module/

[pier@hadoop102 software]$ tar -zvxf jdk-8u212-linux-x64.tar.gz -C ../module/

解压完成后我们可以去jdk目录看一下

[pier@hadoop102 jdk1.8.0_212]$ pwd

/opt/module/jdk1.8.0_212

解压安装成功了,在Windows里面,我们会干嘛呢?

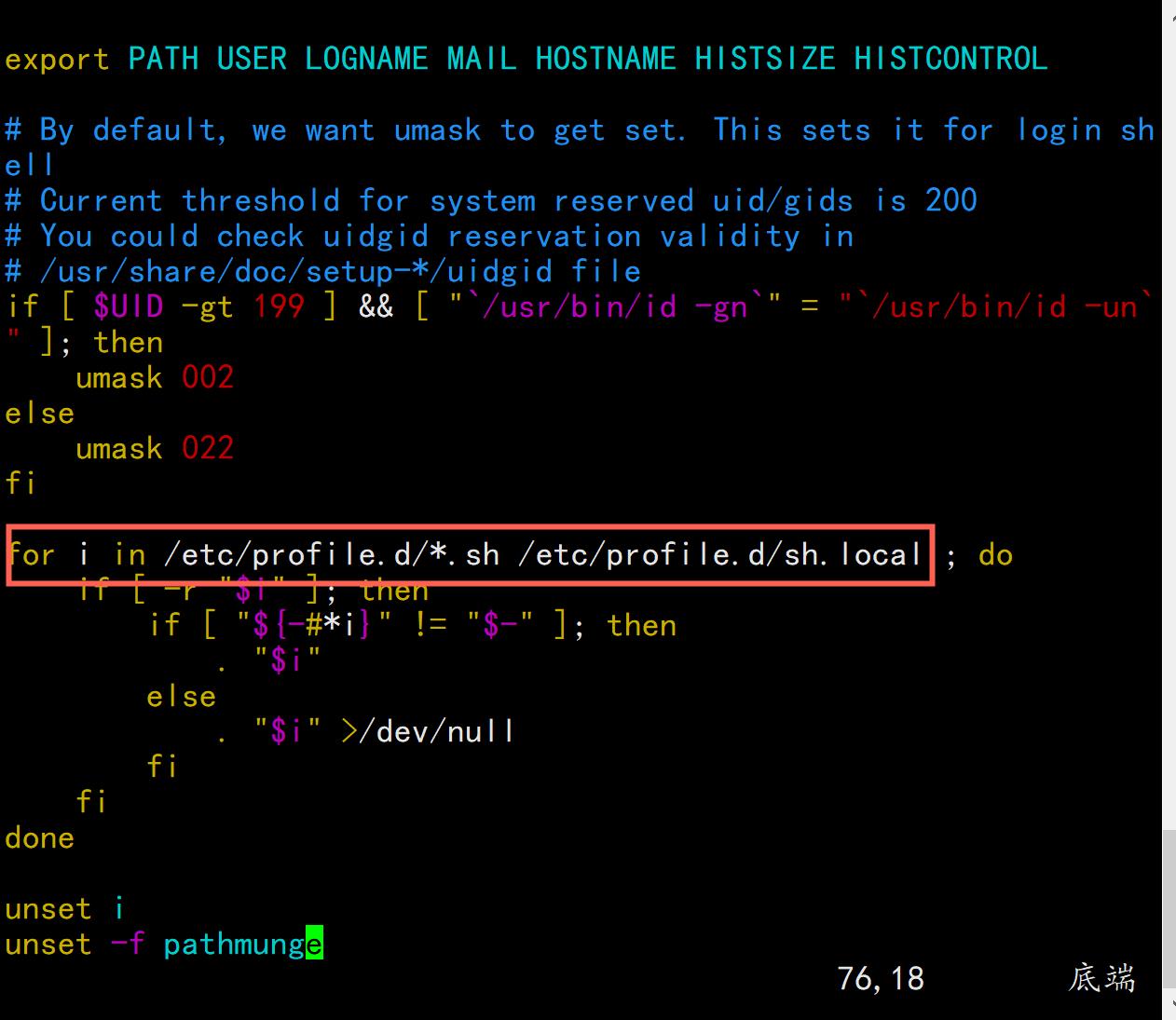

配置环境变量呀!!!我们所熟知的都是sudo vim /etc/profile 我们一起打开会看到下面这一段注释:

# System wide environment and startup programs, for login setup

# Functions and aliases go in /etc/bashrc

# It's NOT a good idea to change this file unless you know what you

# are doing. It's much better to create a custom.sh shell script in

# /etc/profile.d/ to make custom changes to your environment, as this

# will prevent the need for merging in future updates.

我们使用goole翻译一下

# 系统范围的环境和启动程序,用于登录设置

# 函数和别名在 /etc/bashrc 中

# 除非你知道你的意思,否则改变这个文件不是一个好主意

# 是做。 在中创建 custom.sh shell 脚本要好得多

# /etc/profile.d/ 对您的环境进行自定义更改,如下所示

# 将防止在未来更新中合并的需要。

简单来说,就是不希望你在这里面直接去写配置文件,那么我们能怎们做呢?就是去在/etc/profile.d 下面去新写一个.sh文件,可是我们生效怎们办呢?别急,继续往下看。

我们看不到其他的代码,没关系,能认识for吧,这个for就是让我们读取时,去读取/etc/profile.d下面的所有.sh文件,所以,我们在编写时,只需要在指定的文件夹下面创建一个.sh文件即可。下面我们一起来试试吧

[pier@hadoop102 ~]# cd /etc/profile.d/

[pier@hadoop102 profile.d]# touch my_env.sh

[pier@hadoop102 profile.d]# vim my_env.sh

Java的环境变量配置

#JAVA_HOME

export JAVA_HOME=/opt/module/jdk1.8.0_212

export PATH=$PATH:$JAVA_HOME/bin

:wq

环境变量生效并测试

[pier@hadoop102 profile.d]# source /etc/profile

[pier@hadoop102 profile.d]# java -version

java version "1.8.0_212"

Java(TM) SE Runtime Environment (build 1.8.0_212-b10)

Java HotSpot(TM) 64-Bit Server VM (build 25.212-b10, mixed mode)

一般问题小提示

这个地方一般不会出问题,唯一有可能的是你的某个变量名打错了,如果确认无误后,生效,若还是不行,可能是自动生效失败,重启一下虚拟机即可。

重启命令

sudo reboot

安装Hadoop

返回software并解压Hadoop

[pier@hadoop102 profile.d]$ cd /opt/software/

[pier@hadoop102 software]$ tar -zvxf hadoop-3.1.3.tar.gz -C /opt/module/

认识Hadoop

这里不会有小伙伴问我为啥要先认识它呀,直接盘它呀,先弄服了再让它认识我就行了呀,,嗯别装13。。。知其然要知其所以然

我们先来认识一下目录结构

进入Hadoop目录下

[pier@hadoop102 ~]$ cd /opt/module/hadoop-3.1.3

认识目录

-

bin目录:存放对Hadoop相关服务(HDFS,YARN)进行操作的脚本

-

etc目录:Hadoop的配置文件目录,存放Hadoop的配置文件

-

include目录:对外提供的编程库头文件(具体动态库和静态库在lib目录中),这些头文件均是用C++定义的,通常用于C++程序访问HDFS或者编写MapReduce程序。

-

lib目录:存放Hadoop的本地库(对数据进行压缩解压缩功能)

-

sbin目录:存放启动或停止Hadoop相关服务的脚本

-

share目录:存放Hadoop的依赖jar包、文档、和官方案例

修改配置文件

[pier@hadoop102 ~]$ vim /etc/profile.d/my_env.sh

#HADOOP_HOME

export HADOOP_HOME=/opt/module/hadoop-3.1.3

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

检测Hadoop是否安装成功

[pier@hadoop102 ~]$ hadoop version

Hadoop 3.1.3

Source code repository https://gitbox.apache.org/repos/asf/hadoop.git -r ba631c436b806728f8ec2f54ab1e289526c90579

Compiled by ztang on 2019-09-12T02:47Z

Compiled with protoc 2.5.0

From source with checksum ec785077c385118ac91aadde5ec9799

This command was run using /opt/module/hadoop-3.1.3/share/hadoop/common/hadoop-common-3.1.3.jar

这里只要出现Hadoop 版本号,即安装成功。

卷一卷:这段时间有点懈怠,还没从元旦的放松缓过来,接下来肯定勤更的,下一版发集群的搭建。

以上是关于Hadoop安装并配置环境变量(测试版)的主要内容,如果未能解决你的问题,请参考以下文章