论文笔记:PYRAFORMER: LOW-COMPLEXITY PYRAMIDAL ATTENTION FOR LONG-RANGE TIME SERIES MODELING AND FORECAST

Posted UQI-LIUWJ

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了论文笔记:PYRAFORMER: LOW-COMPLEXITY PYRAMIDAL ATTENTION FOR LONG-RANGE TIME SERIES MODELING AND FORECAST相关的知识,希望对你有一定的参考价值。

1 Intro

- 长时间序列预测问题

- 长时间序列会有两个挑战

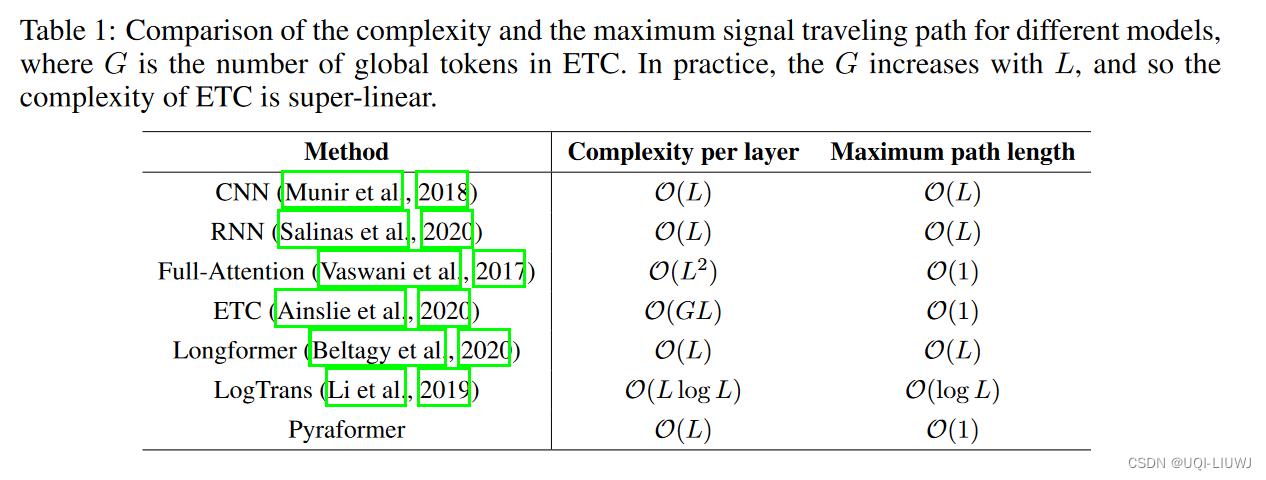

- 时间和空间复杂度

- 越小越好

- Xt和

同时被考虑,需要几步(多少个迭代)【论文中称之为‘longest signal traversing path】

同时被考虑,需要几步(多少个迭代)【论文中称之为‘longest signal traversing path】

- 越小越好

- 时间和空间复杂度

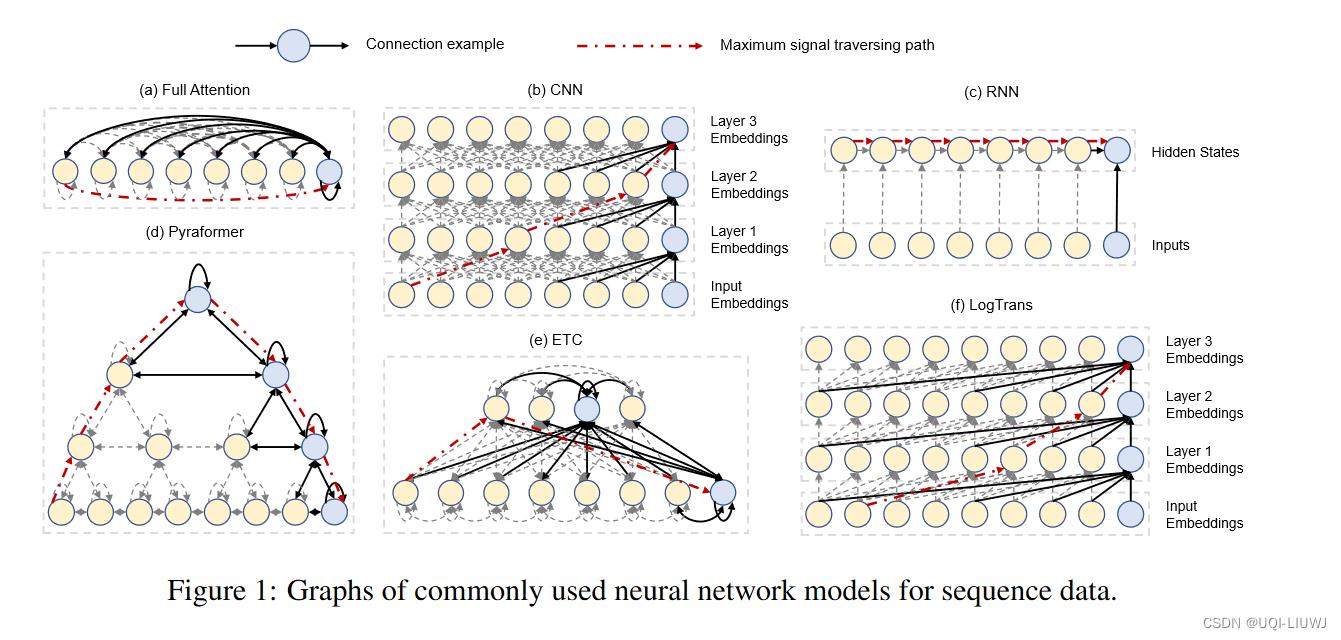

- CNN和RNN

- 复杂度低O(L)

- longest signal traversing path 为O(L)【RNN是一个时间片一个时间片地迭代过去】

- ——>很难学到很远的两个时间片之间的依赖关系

- Transformer

- longest signal traversing path 为O(1)

- 但是复杂度为O(L^2)

- ——>不能处理特别长的时间序列

- 长时间序列会有两个挑战

- 这篇论文提出了一个金字塔结构的Transformer(PyraFormer,pyramid attention based Transformer)

- 可以很好地捕获时间序列的长期依赖性(同时捕获不同尺度的时间依赖性),同时有很低的时间和空间复杂度

- Paraformer中点之间的连边 可以分成 尺度间连接(inter-scale connection)和尺度内连接(intra-scale connection)

- 不同尺度比如 daily、monthly、weekly等

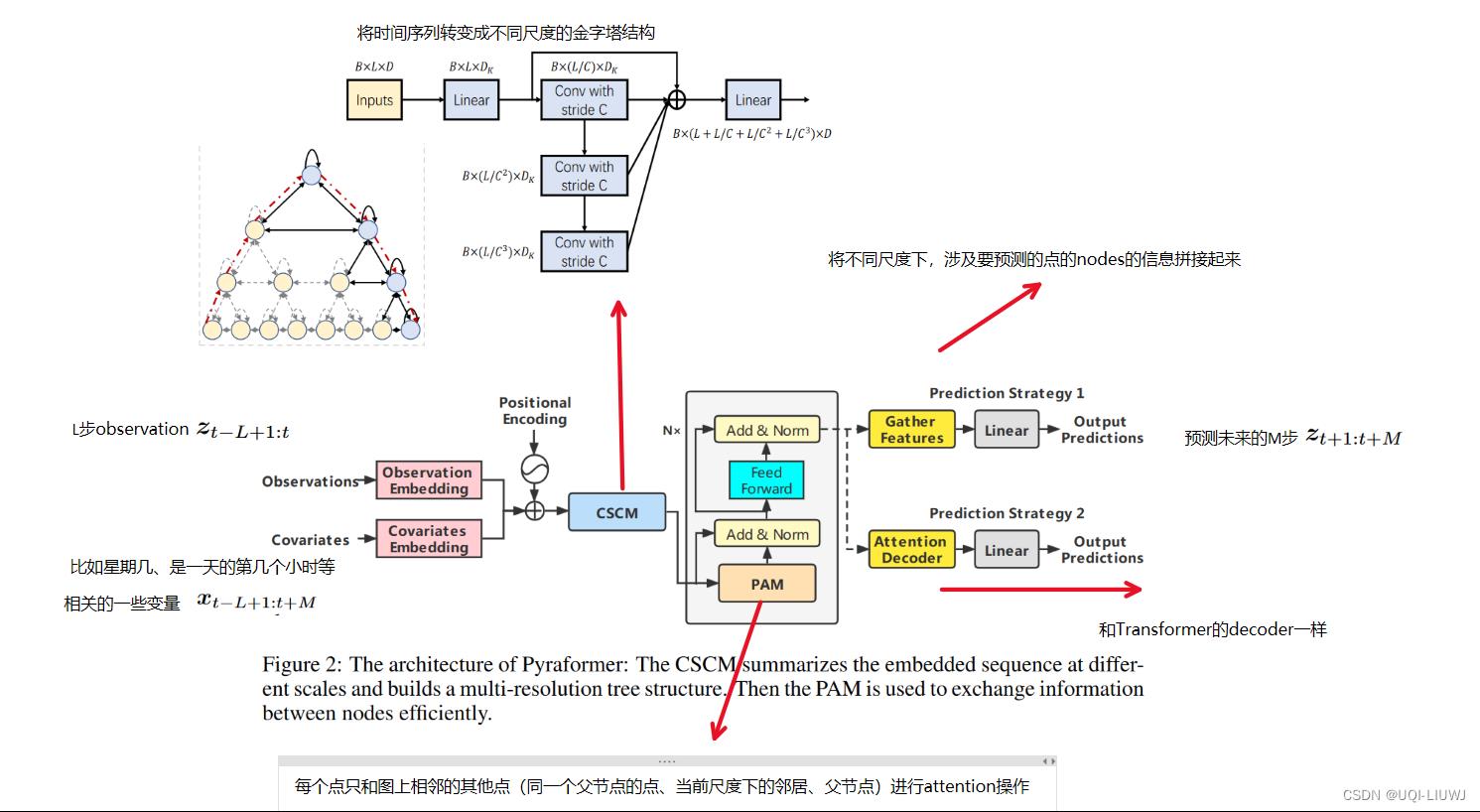

2 模型

2.1 金字塔attention结构 (PAM)

- 在CV领域,已经证明了多分辨率结构在建模长期依赖关系中是有效的

- 论文用一个C叉树来建模时间序列,其中连边可以分成尺度间连接(inter-scale connection)和尺度内连接(intra-scale connection)

- 首先,论文界定了在金字塔结构中,每个点的“邻居”

表示尺度s的第l个点的邻居

表示尺度s的第l个点的邻居

- A就是这个点同尺度的邻居

- C表示子节点(下一尺度的点)

- P表示父节点(上一尺度的点)

- 此时尺度s的第l个点的attention为:

- 论文通过理论证明了PAM的复杂度是O(AL)

2.2 COARSER-SCALE CONSTRUCTION MODULE (CSCM)

通过卷积操作,将时间序列变换成不同尺度的金字塔形式

2.3 预测模块

-

单步时间序列预测

-

在历史观测序列

之后接一个0,然后送入embedding

之后接一个0,然后送入embedding -

当序列被PAM encode之后,拼接金字塔结构中、所有最后一个feature(补的这个0)参与的点,然后将拼接的结果送入全连接层,以进行预测

-

-

多部时间序列预测

-

第一种方法和单步类似,只不过预测L步,就在

后补L个0

后补L个0 -

第二种方法类似于Transformer

-

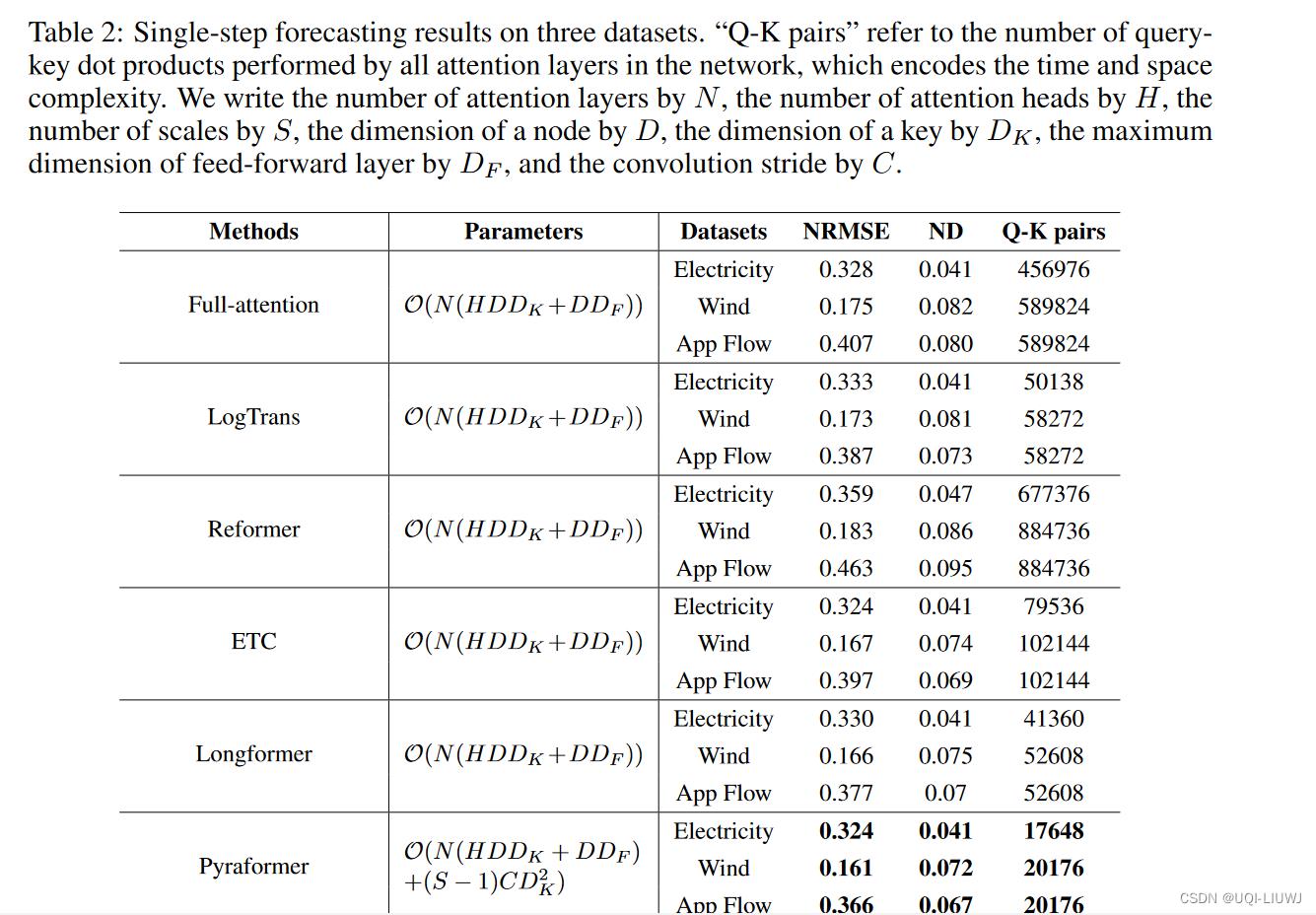

3 实验

以上是关于论文笔记:PYRAFORMER: LOW-COMPLEXITY PYRAMIDAL ATTENTION FOR LONG-RANGE TIME SERIES MODELING AND FORECAST的主要内容,如果未能解决你的问题,请参考以下文章