Time Will Tell:New Outlooks and A Baseline for Temporal Multi-View 3D Object Detection——论文笔记

Posted m_buddy

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了Time Will Tell:New Outlooks and A Baseline for Temporal Multi-View 3D Object Detection——论文笔记相关的知识,希望对你有一定的参考价值。

参考代码:SOLOFusion

1. 概述

介绍:汽车的驾驶过程是时变的,则对该场景的处理方法最好也应该具有时间维度引入。这篇文章提出现有BEV感知算法中时序信息信息存在特征粒度较粗(特征图尺寸小)和使用到的时序信息较少(使用到的帧数少) 的问题,同时观察到距离车体不同距离下对时序信息的敏感程度是不一样的,距离越远越则需要多帧信息,但是也需要考虑实际机器的资源是有限的。对于上述问题文章提出了分别在高分辨率(在图像特征空间构建cost volume)和低分辨率(在BEV特征空间构建cost volume)分别进行时序信息融合,并且两者相互补全。需要指出在高分辨率下是参考MVSNet的方法去构建cost volume,而低分辨率也是需要对特征进行对齐操作的,这样也需要知道对应帧间位姿关系。

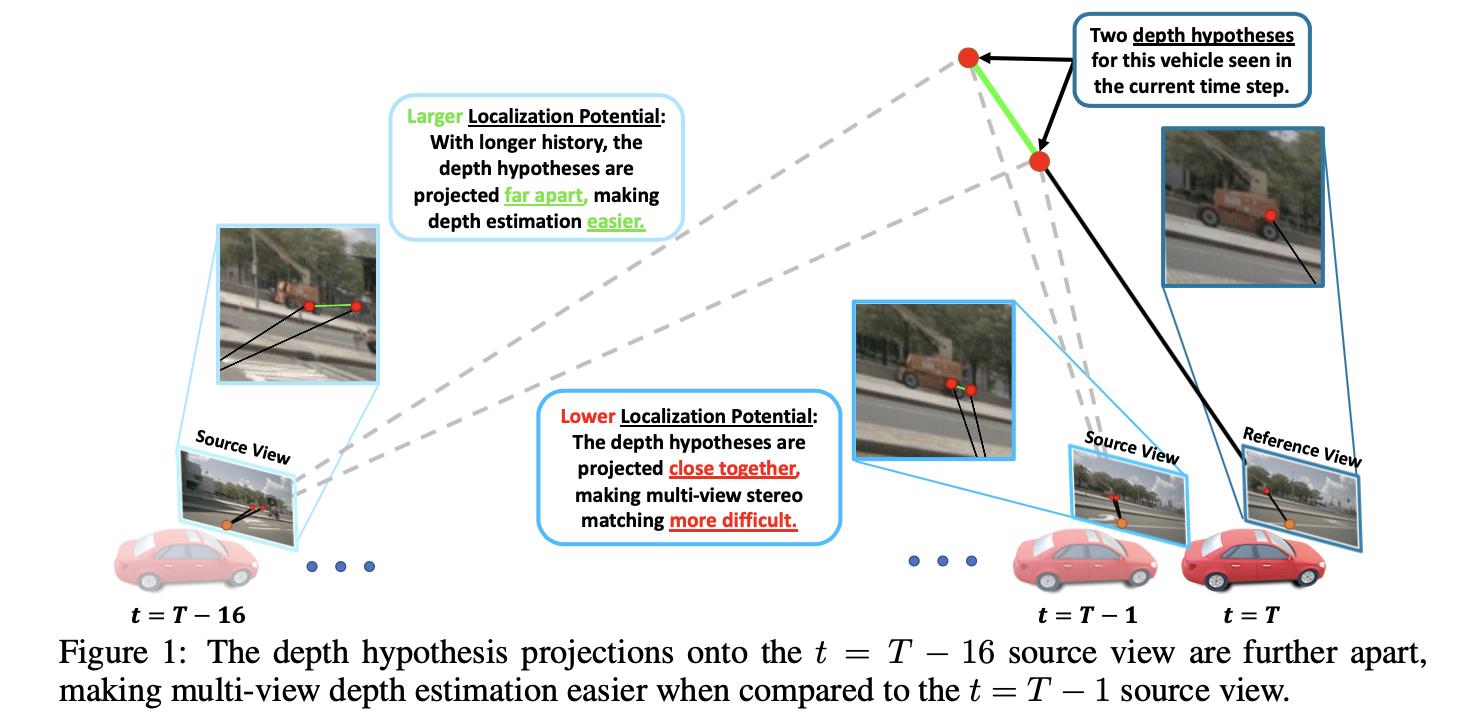

使用图像进行深度估计过程中,自然是希望对应像素的偏差足够大,这样才能够明显区分并表征出来。对应到时序数据中也是希望所使用的视频段跨度大一些,这样在图像中呈现的差异也变大了,如下图所示,这样才能保证localization potential(文中用其表征多视图下深度估计的难易程度)

时序数据数量带来的影响:

将

t

−

1

t-1

t−1帧中的点

a

a

a通过相机内外参数和到

t

t

t帧的位姿变换

[

R

∣

t

]

[R|t]

[R∣t]映射到对应的

b

b

b点,这个映射关系自然可以写出。不过文中更加关注的是在点

b

b

b下深度的变化率(文中将其称之为localization potential,或者叫做该点上相对深度的变化率):

L

o

c

a

l

i

z

a

t

i

o

n

P

o

t

e

n

t

i

a

l

=

∣

∂

x

b

∂

d

a

∣

=

f

t

ˉ

c

o

s

(

α

)

∣

s

i

n

(

α

−

(

θ

+

β

)

)

∣

(

d

a

c

o

s

(

α

−

θ

)

+

t

z

c

o

s

(

α

)

)

2

Localization\\ Potential=|\\frac\\partial x_b\\partial d_a|=\\fracf\\bartcos(\\alpha)|sin(\\alpha-(\\theta+\\beta))|(d_acos(\\alpha-\\theta)+t_zcos(\\alpha))^2

Localization Potential=∣∂da∂xb∣=(dacos(α−θ)+tzcos(α))2ftˉcos(α)∣sin(α−(θ+β))∣

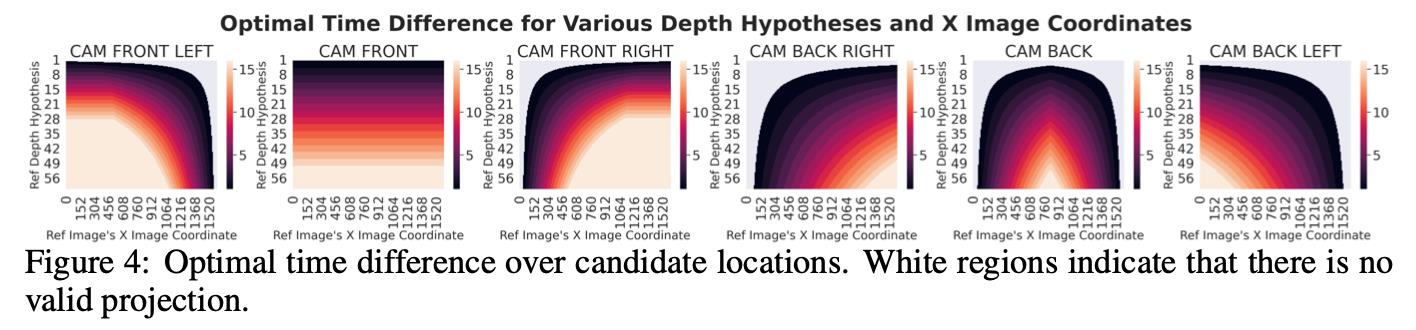

则参考上述公式,对于距离远的点其localization potential自然需要分子更大,则也就需要更多的时间帧进行累积。下图中也可以看出对于远处的深度感知也需要更多帧的数据参与其中:

特征图分辨率带来的影响:

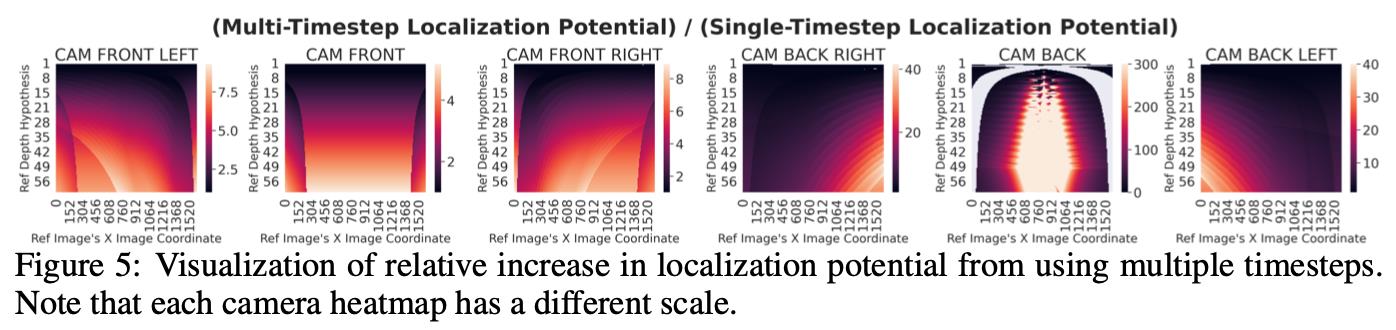

除了上述提到更多时序数据会带来积极正向效果之外,特征图的大小其实也是一个重要的因素,一个自然道理便是分辨率越大对远处能表达的信息也就越多,则在提高分辨率条件下需要的时序数据量会减少。对此从文中给出的分析图也能得出类似的结论:

不过需要指出的是特征图分辨率和时序数据量它们俩是一个互补的关系,需要根据实际资源允许情况折中选择。同时对应的实验也证明了更好的深度表达(对应下图中使用更多帧的信息)是有利于目标的检测的:

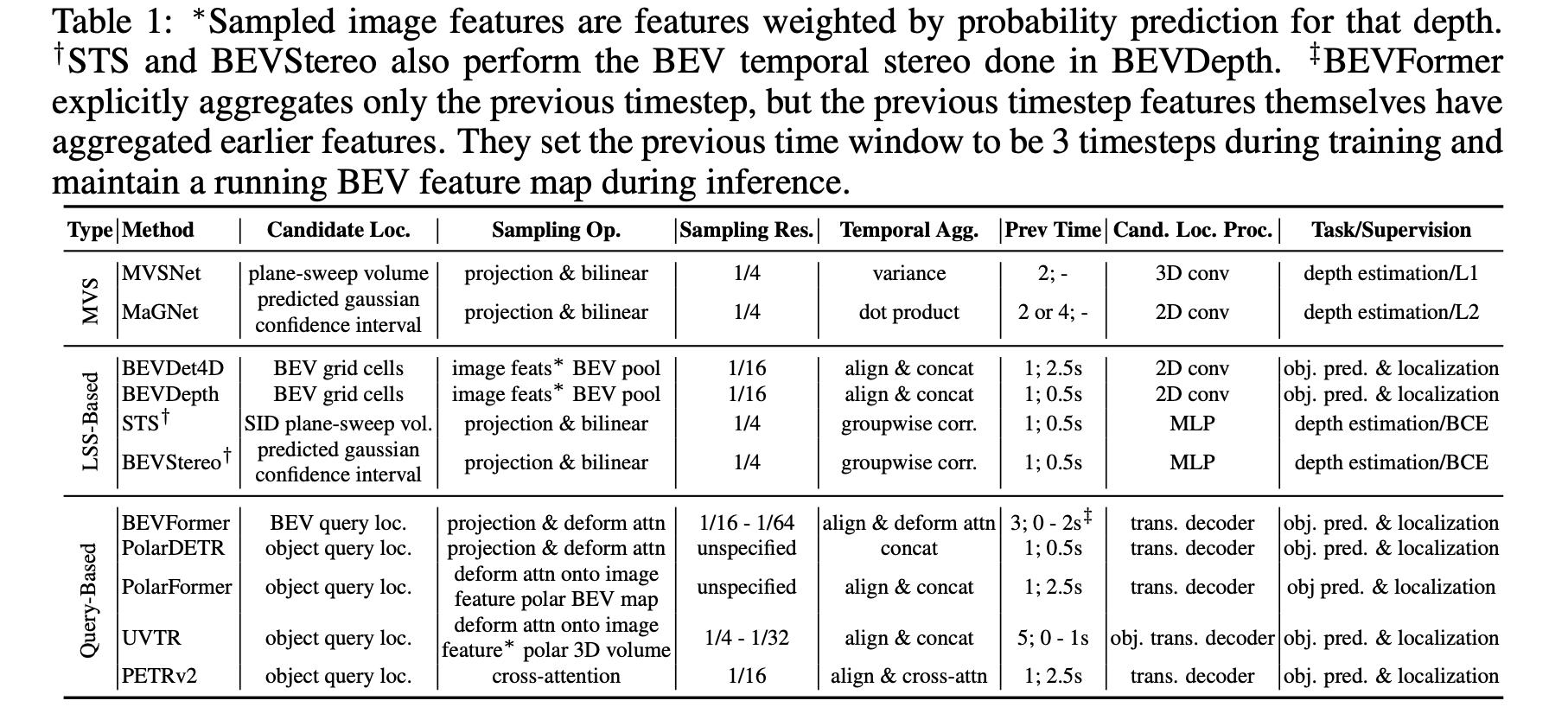

与其它时序融合方法的对比:

文中将时序特征融合的策略与其它一些方法在采样方式、采样分辨率、特征关联方式等维度进行分析,得到下表(下图中可以看出还是由较多的方法需要位姿进行align这个步骤):

2. 方法设计

2.1 整体pipeline

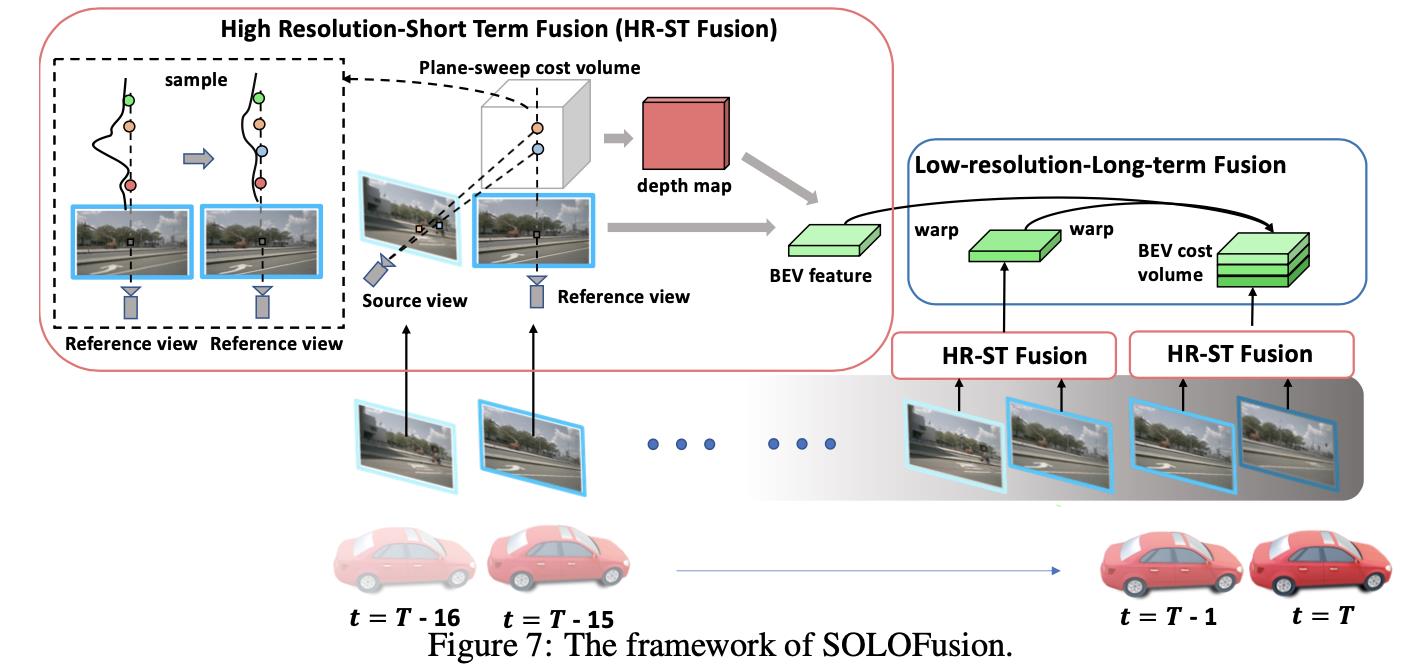

文章方法的整体pipeline见下图所示:

从上图中可以看到对于时序特征的融合可以被划分为两个部分:

- 1)高分辨率短时间融合:这部分是在backbone特征输出上使用类似MVSNet的算法输出在当前reference图上更加准确的深度估计结果。

- 2)低分辨率长时间融合:这部分是在BEV特征(分辨率较低)使用位姿信息warp之后构建cost volume,从而得到reference帧的BEV特征。

2.2 高分辨率和低分辨率下的时序融合

高分辨率下的时序融合:

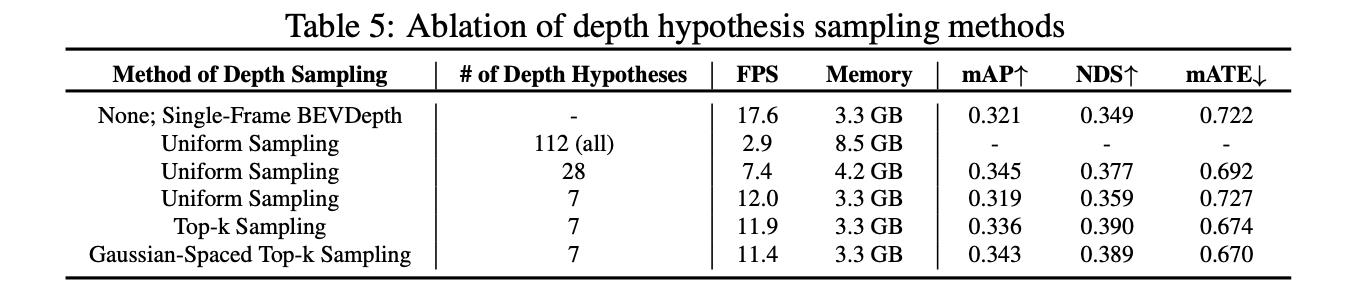

这部分采用的是backbone输出stride=4的特征图作为MVSNet的输入,进而得到高分辨下的深度估计结果,这里使用的帧数量会对应减少。此外,这里的深度bins不是采用的均匀分布采样而是采用Gaussian-Spaced Top-k Sampling,这样能带来更好的性能。将其与其它一些采样方法进行比较,见下表:

低分辨率下的时序融合:

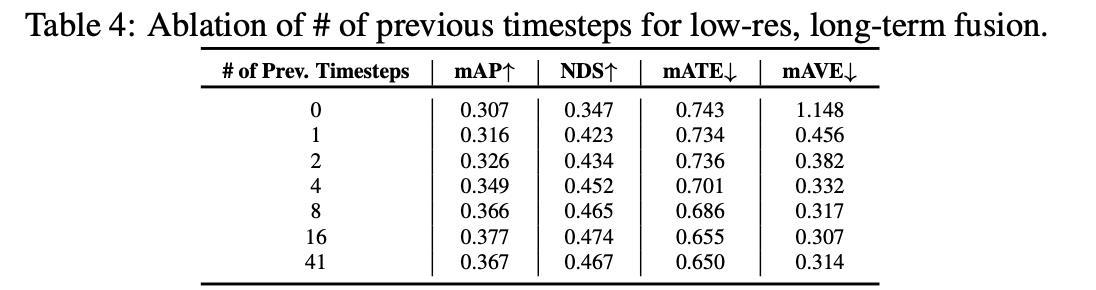

这部分融合主要使用BEV特征,因而其特征图分辨率较低。则按照文章之前的分析就需要更多的视频帧作为输入用以弥补在远处的信息表达。在构建多帧cost volume的过程中会使用pose信息去warp source中的特征到当前reference下。比较帧数多少对性能的影响见下表:

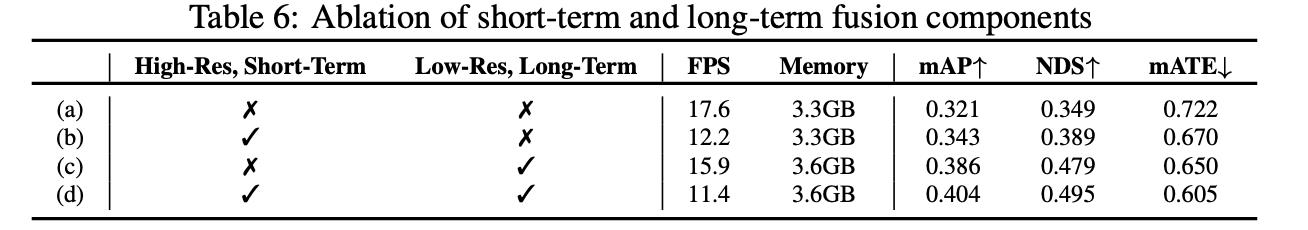

高低分辨率下对应融合策略对整体网络性能带来的影响:

3. 实验结果

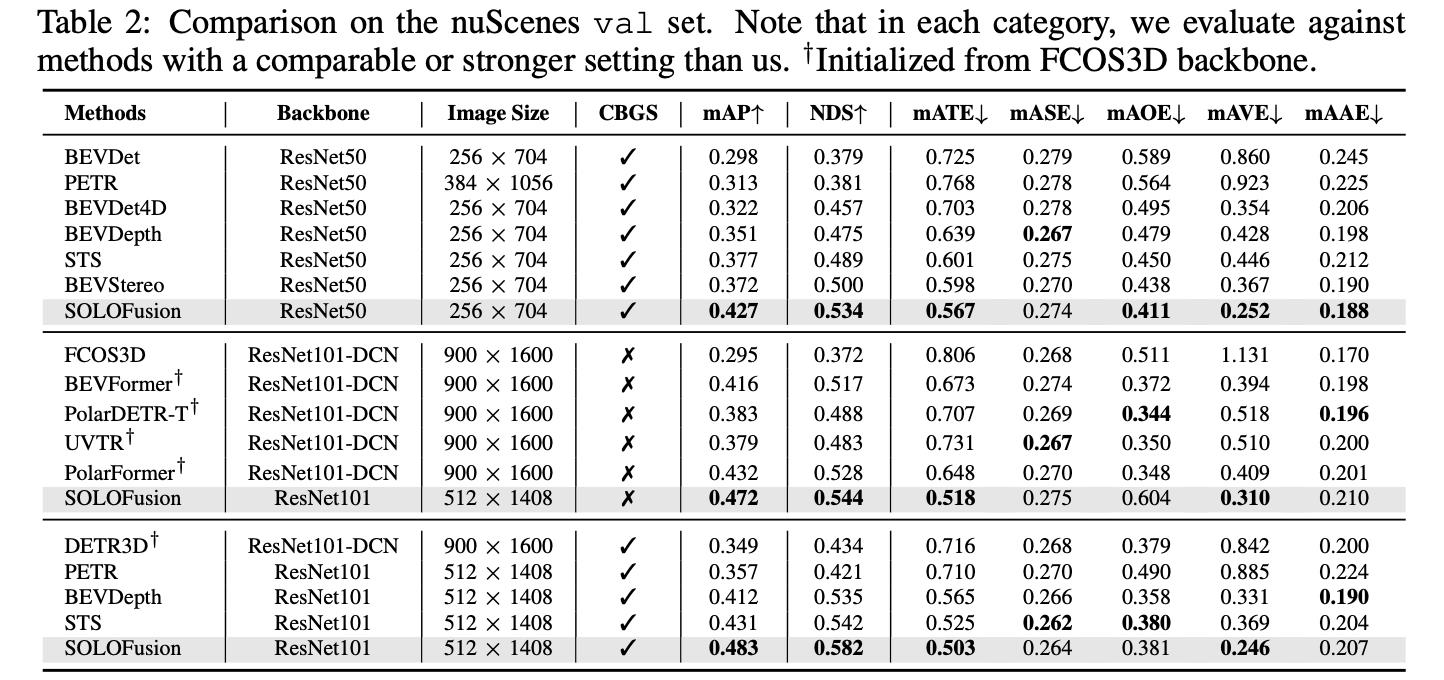

NuScenes val上的性能比较

NuScenes test上的性能比较:

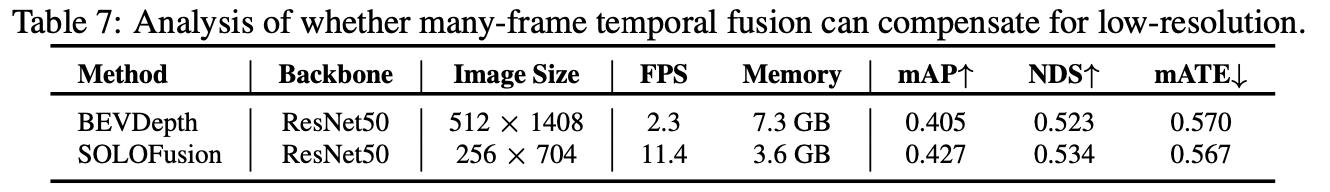

其与BEVDepth的比较(更小图像分辨率下能获得更好性能):

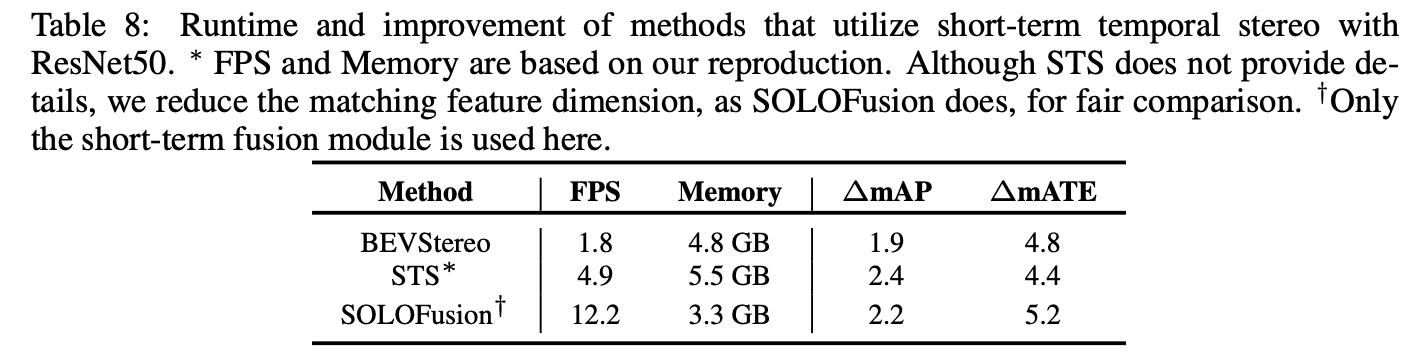

与较少数据帧方法的对比(更多数据帧能带来更好性能表现):

以上是关于Time Will Tell:New Outlooks and A Baseline for Temporal Multi-View 3D Object Detection——论文笔记的主要内容,如果未能解决你的问题,请参考以下文章