简单搞定Shuffle机制运行原理

Posted

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了简单搞定Shuffle机制运行原理相关的知识,希望对你有一定的参考价值。

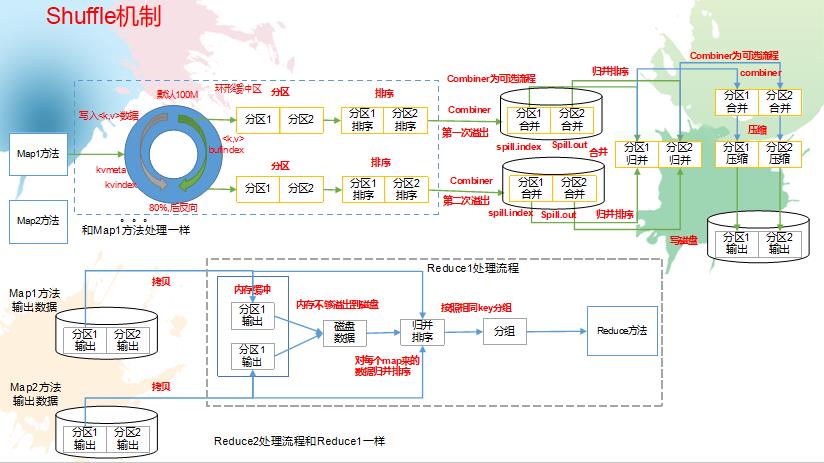

参考技术A 概述1)mapreduce中,map阶段处理的数据如何传递给reduce阶段,是mapreduce框架中最关键的一个流程,这个流程就叫shuffle;

2)shuffle: 洗牌、发牌(核心机制:数据分区、排序、缓存);

3)具体来说:就是将maptask输出的处理结果数据,分发给reducetask,并在分发的过程中,对数据按key进行了分区和排序。

2.4.2 Shuffle 结构

Shuffle缓存流程:

shuffle是MR处理流程中的一个过程,它的每一个处理步骤是分散在各个map task和reduce task节点上完成的。

2.4.3 partition分区

如果reduceTask的数量> getPartition的结果数,则会多产生几个空的输出文件part-r-000xx;

如果1

如果reduceTask的数量=1,则不管mapTask端输出多少个分区文件,最终结果都交给这一个reduceTask,最终也就只会产生一个结果文件 part-r-00000;

例如:假设自定义分区数为5,则

(1)job.setNumReduceTasks(1);会正常运行,只不过会产生一个输出文件

(2)job.setNumReduceTasks(2);会报错

(3)job.setNumReduceTasks(6);大于5,程序会正常运行,会产生空文件

2.4.5 Shuffle 运行机制

2)流程详解

上面的流程是整个mapreduce最全工作流程,但是shuffle过程只是从第7步开始到第16步结束,具体shuffle过程详解,如下:

1)maptask收集我们的map()方法输出的kv对,放到内存缓冲区中

2)从内存缓冲区不断溢出本地磁盘文件,可能会溢出多个文件

3)多个溢出文件会被合并成大的溢出文件

4)在溢出过程中,及合并的过程中,都要调用partitoner进行分组和针对key进行排序

5)reducetask根据自己的分区号,去各个maptask机器上取相应的结果分区数据

6)reducetask会取到同一个分区的来自不同maptask的结果文件,reducetask会将这些文件再进行合并(归并排序)

7)合并成大文件后,shuffle的过程也就结束了,后面进入reducetask的逻辑运算过程(从文件中取出一个一个的键值对group,调用用户自定义的reduce()方法)

3)注意

Shuffle中的缓冲区大小会影响到mapreduce程序的执行效率,原则上说,缓冲区越大,磁盘io的次数越少,执行速度就越快。

缓冲区的大小可以通过参数调整,参数:io.sort.mb 默认100M

2.4.6 Combiner 合并

1)combiner是MR程序中Mapper和Reducer之外的一种组件

2)combiner组件的父类就是Reducer

3)combiner和reducer的区别在于运行的位置:

Combiner是在每一个maptask所在的节点运行

Reducer是接收全局所有Mapper的输出结果;

4)combiner的意义就是对每一个maptask的输出进行局部汇总,以减小网络传输量

6)combiner能够应用的前提是不能影响最终的业务逻辑,而且,combiner的输出kv应该跟reducer的输入kv类型要对应起来

Mapper

大数据之Hadoop(MapReduce):Shuffle机制

1.Mapreduce Shuffle机制

Map方法之后,Reduce方法之前的数据处理过程称之为Shuffle。

2.工作原理图

具体 shuffle 过程详解, 如下:

map-shuffle 阶段

1) maptask 收集我们的 map()方法输出的 kv 对,放到内存环形缓冲区中

2) 当大于阈值80%时,会从内存缓冲区不断溢出本地磁盘文件,可能会溢出多个文件,这一过程叫溢写阶段(spill)

3) 多个溢出文件会被合并成大的溢出文件(merge)

4) 在溢出过程中,及合并的过程中,都要调用 partitioner 进行分区和针对 key 进行排序(partition 和sort)

shuffle-reduce阶段

5) reducetask 根据自己的分区号,去各个 maptask 机器上取相应的结果分区数据,这个叫Copy过程,简单地拉取数据;

6) reducetask 会取到同一个分区的来自不同 maptask 的结果文件, reducetask 会将这些文件再进行合并(归并排序)(merge)

7) 合并成大文件后, shuffle 的过程也就结束了,后面进入 reducetask 的逻辑运算过程(从文件中取出一个一个的键值对 group,调用用户自定义的 reduce()方法)

以上是关于简单搞定Shuffle机制运行原理的主要内容,如果未能解决你的问题,请参考以下文章