机器学习——支持向量机:线性可分支持向量机到非线性支持向量机

Posted Lyndon_zheng

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了机器学习——支持向量机:线性可分支持向量机到非线性支持向量机相关的知识,希望对你有一定的参考价值。

线性可分支持向量机

回顾

前面总结了线性可分支持向量机,知道了支持向量机的最终目的就是通过“间隔最大化” 得到最优分类器,能够使最难区分的样本点得到最大的分类确信度,而这些难区分的样本就是支持向量。

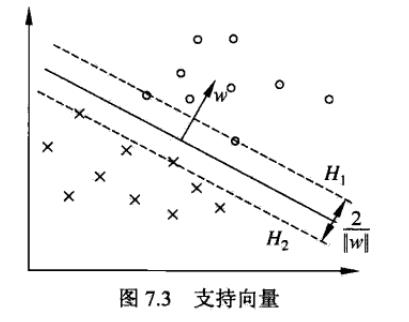

还是如下图所示,超平面

H1

和

H2

支撑着中间的决策边界,且到达决策边界的距离相等,都是最大几何间隔。而这两个超平面

H1

和

H2

必定会有一些样本点,不然中间的间隔还可以继续扩大,得到的就不是最大间隔了。这些在超平面

H1

和

H2

的样本点就是支持向量,从直观上我们也可看出,这些支持向量是离决策边界最近的点,也就是最难被分类的样本。

优化

上一节中我们介绍了得到上述线性可分支持向量机的方法,即最优化以下目标函数:

观察可知,这是一个明显的 凸二次规划问题。将其作为原始问题,应用 拉格朗日对偶性,通过求解对偶问题得到原始问题的最优解。这样求解有两个好处:一方面是对偶问题往往更容易求解(优化效率高);二是自然引入了核函数,进而能够推广到非线性分类问题。首先,通过上式我们可以定义拉格朗日函数为:

L(w,b,α)=12||w||2−∑i=1Nαi[yi(wT⋅xi+b)−1]

其中,拉格朗日乘子 αi≥0 ,现在我们令:

θp(w)=maxαi≥0L(w,b,α)

则 θp(w) 就是与原目标函数等同的优化问题。之所以可以这么等同,是因为如果出现 yi(wT⋅xi+b)<1 则 θp(w)=∞ (只需要令 αi=∞ ),此时没有最小解。而当所有约束条件都满足时,即 yi(wT⋅xi+b)≥1,i=1,2,…,N ,则 θp(w)=12||w||2 ,也就是我们最初要优化的目标函数。因此,我们现在的目标函数可以改写为:

minwθp(w)=minwmaxαi≥0L(w,b,α)

我们令 p∗