01=K-近邻算法(附完整代码)

Posted 伤心兮

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了01=K-近邻算法(附完整代码)相关的知识,希望对你有一定的参考价值。

一、概述

K-近邻算法是机器学习中最简单的算法,其核心是采用测量不同特征值之间的距离来进行分类,通俗来说就是距离待分类最近的K个点来决定该分类的类别。

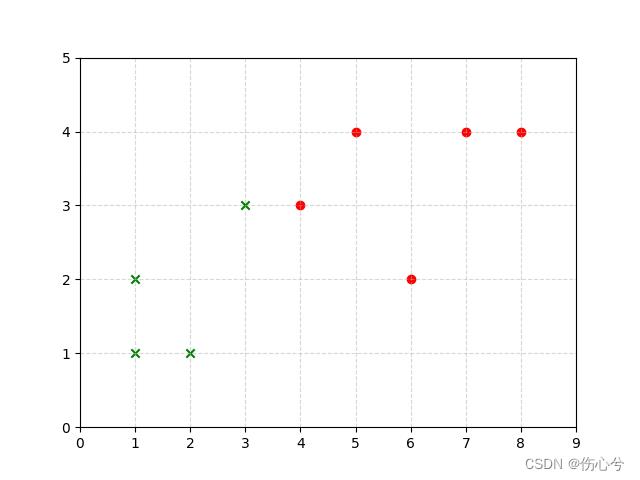

如图所示,求当前蓝色属于哪一类,当K=1时,该类别就是class_1;当K=3时,该类别就是class_2。

二、算法公式

K-近邻算法一般使用的欧式距离, 对应的多个特征的公式为:

D

i

s

t

a

n

c

e

=

∑

i

=

1

n

(

x

i

−

y

i

)

2

Distance=\\sqrt\\sum_i=1^n(x_i-y_i)^2

Distance=i=1∑n(xi−yi)2

- 注意:这里边 x 1 , x 2 … … x n x_1,x_2……x_n x1,x2……xn都属于待分类的特征值。

举例说明:有四个特征,例如未知类别的特征为(1,3,5,2),已知class_1的特征值(7,6,9,4),class_2的特征值为(2,4,6,4),则未知类别与已知类别之间的距离分别为:

未知类别与class_1:

D

1

=

(

7

−

1

)

2

+

(

6

−

3

)

2

+

(

9

−

5

)

2

+

(

4

−

2

)

2

=

8.06

D_1=\\sqrt(7-1)^2 + (6-3)^2 + (9-5)^2+ (4-2)^2=8.06

D1=(7−1)2+(6−3)2+(9−5)2+(4−2)2=8.06

未知类别与class_2:

D

2

=

(

2

−

1

)

2

+

(

4

−

3

)

2

+

(

6

−

5

)

2

+

(

4

−

2

)

2

=

2.64

D_2=\\sqrt(2-1)^2 + (4-3)^2 + (6-5)^2+ (4-2)^2=2.64

D2=(2−1)2+(4−3)2+(6−5)2+(4−2)2=2.64

那么就可以把未知类别x分类为class_2。

三、算法实现

3.1 使用自己的方法

import matplotlib.pyplot as plt

import numpy as np

from math import sqrt

from collections import Counter

def knn_classify(k, x_train_total, y_train_total, x_test):

"""

This function is myself KNN

Parameters

----------

:param k: 选取与当前点距离最小的k个点

:param x_train_total:已知数据特征值

:param y_train_total:已知数据目标值

:param x_test:未知数据特征值

:return:未知数据目标

"""

distances = [sqrt(np.sum((x_train - x_test)**2)) for x_train in X_train] # 计算距离

nearest = np.argsort(distances) # 返回从小到大最大值索引

y_top = [y_train_total[i] for i in nearest[:k]] # 取出距离最短对应的目标

votes = Counter(y_top) # 对数组内的元素进行频数统计

return votes.most_common(1)[0][0] # 取出出现次数最多的目标值

if __name__ == '__main__':

# 1.构建数据

raw_data_X = [[1.0, 1.0],

[1.0, 2.0],

[2.0, 1.0],

[3.0, 3.0],

[5.0, 4.0],

[6.0, 2.0],

[7.0, 4.0],

[8.0, 4.0]

]

raw_data_y = [1, 1, 1, 1, 2, 2, 2, 2]

X_train = np.array(raw_data_X)

y_train = np.array(raw_data_y)

x_test = np.array([4, 3])

# 2.计算欧式距离

result = knn_classify(1, X_train, y_train, x_test)

print(result)

# 3.画图

plt.scatter(X_train[y_train == 1, 0], X_train[y_train == 1, 1], marker='x', color='g')

plt.scatter(X_train[y_train == 2, 0], X_train[y_train == 2, 1], marker='o', color='r')

plt.scatter(x_test[0], x_test[1], marker=('x' if result == 1 else 'o'), color=('g' if result == 1 else'r'))

plt.grid(True, linestyle="--", alpha=0.5)

plt.axis([0, 9, 0, 5])

plt.show()

3.2 使用sklearn

from sklearn.neighbors import KNeighborsClassifier

import numpy as np

import matplotlib.pyplot as plt

def main():

# 1.构建数据

raw_data_X = [[1.0, 1.0],

[1.0, 2.0],

[2.0, 1.0],

[3.0, 3.0],

[5.0, 4.0],

[6.0, 2.0],

[7.0, 4.0],

[8.0, 4.0]

]

raw_data_y = [1, 1, 1, 1, 2, 2, 2, 2]

X_train = np.array(raw_data_X)

y_train = np.array(raw_data_y)

x_test = np.array([4, 3])

# 2.构建Knn实例

Knn_Classifier = KNeighborsClassifier(n_neighbors=1)

# 3.拟合

Knn_Classifier.fit(X_train, y_train)

# 4.预测,传入

predict = Knn_Classifier.predict(x_test.reshape(1, -1))

print(predict[0])

# 5.画图

plt.scatter(X_train[y_train == 1, 0], X_train[y_train == 1, 1], marker='x', color='g')

plt.scatter(X_train[y_train == 2, 0], X_train[y_train == 2, 1], marker='o', color='r')

plt.scatter(x_test[0], x_test[1], marker=('x' if predict[0] == 1 else 'o'), color=('g' if predict[0] == 1 else'r'))

plt.grid(True, linestyle="--", alpha=0.5)

plt.axis([0, 9, 0, 5])

plt.show()

if __name__ == '__main__':

main()

四、结果

K=1时(注意(4,3)这个点):

K=3时(注意(4,3)这个点):

以上是关于01=K-近邻算法(附完整代码)的主要内容,如果未能解决你的问题,请参考以下文章