ELK日志系统设计方案-Filebeat日志收集推送Kafka

Posted niaonao

tags:

篇首语:本文由小常识网(cha138.com)小编为大家整理,主要介绍了ELK日志系统设计方案-Filebeat日志收集推送Kafka相关的知识,希望对你有一定的参考价值。

ELK 日志系统的常见解决方案:

通常的产品或项目部署至服务器,运行服务后会生成日志文件。

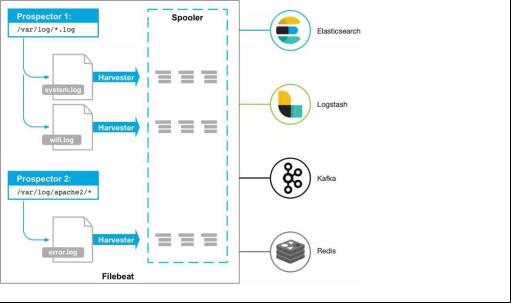

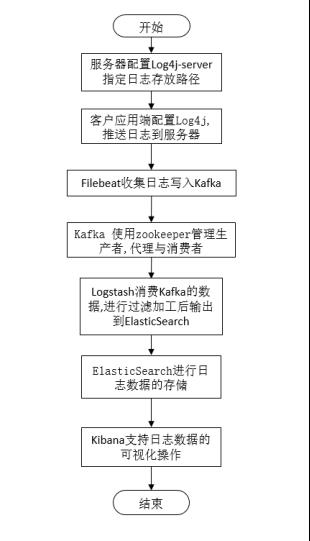

通过 Filebeat 监控相关文件夹,当有新日志产生,就读取新日志,将日志输送到 Kafka 中。经由 Logstash 消费 Kafka 生产的数据,进行加工过滤后输出到 ElasticSearch 进行日志数据的存储与全文检索。使用 Kibana 对日志数据进行可视化操作。

1. 软件安装

- 官方产品下载

服务器安装以下 Linux 版本的应用

Log4j, Filebeat, Zookeeper, Kafka, Logstash, ElasticSearch, Kibana. - 路径规划

安装包路径/opt/install

安装程序路径/opt/elkf

服务器日志存放路径/opt/elkf/root-log-folder

2. 服务器管理

服务器地址192.168.200.83:22, ElasticSearch 应用需要使用非 root 用户启动,此处创建非 root 管理员.

| 管理员 | 密码 | root用户 | 登录权限 |

|---|---|---|---|

| root | Southinfo@best1 | Y | Y |

| niaonao | Southinfo@best1 | N | Y |

| admin | Southinfo@best1 | N | N |

3. 单点日志系统设计

- 服务器配置 Log4j-server 指定日志存放路径 /opt/elkf/root-log-folder,开放服务端口可接收客户端应用日志. 客户应用端完成 Log4j 配置,可推送日志到服务器.

- Filebeat 从指定日志文件路径 /opt/elkf/root-log-folder 收集日志信息,可处理后将数据推送给 Kafka;

- Kafka 数据缓存通过批量操作将日志输出到 Logstash. Kafka 使用 zookeeper 完成协调生产者,消费者与代理. Logstash 消费 Kafka 的数据,进行过滤加工后输出到 ElasticSearch. ElasticSearch 进行日志数据的存储. Kibana 检索 ElasticSearch 存储的日志到可视化页面,可视化页面支持对日志数据更加方便的操作.

参考文章

ELK日志系统设计方案-Filebeat日志收集推送Kafka

ELK日志系统设计方案-Log4j日志直推Kafka

ELK日志系统设计方案-集群扩展

ELK日志系统部署实现

Powered By niaonao

以上是关于ELK日志系统设计方案-Filebeat日志收集推送Kafka的主要内容,如果未能解决你的问题,请参考以下文章